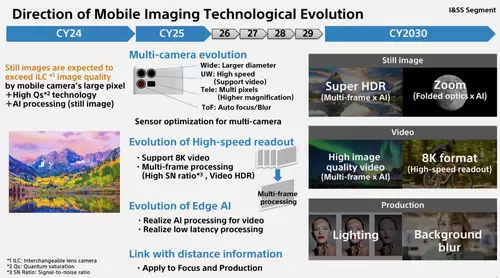

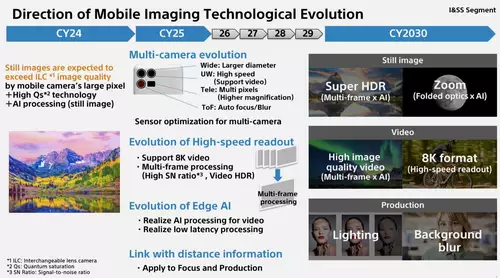

Eine vieldiskutierte Seite aus einer internen Firmenpräsentation von Sony machte vor einigen Tagen im Internet von sich reden. Grund für das große Interesse war die darin getroffene Aussage von von Terushi Shimizu (CEO von Sony Semiconductor Solutions), dass Smartphone-Kameras ab dem Jahr 2024 die Bildqualität von Wechselobjektivkameras übertreffen werden.

Bislang gilt als "Common Sense", dass die relativ großen Sensel eines DSLM/DSLR-Sensors rein physikalisch mehr Licht einfangen können und somit immer eine höhere Dynamik aufzeichnen können als die verhältnismäßig kleinen Sensel bei einem Smartphone.

Doch (nicht nur) Sony glaubt, dass dieser Common Sense in naher Zukunft seine universelle Gültigkeit verlieren könnte. Das zugehörige Slide zeigt dabei alle Ideen auf, aufgrund derer sich diese These tatsächlich bewahrheiten könnte.

Die grundsätzliche Daumenregel "Größere Senselfläche" = "Mehr Dynamik" gilt nämlich nur, wenn alle anderen Parameter des Sensors bzw. der Kamera gleich bleiben. Doch an manchen Parametern lässt sich gerade aufgrund einer kleinen Senselgröße noch einiges drehen.

Zwar wurden die Aussage von Terushi Shimizu primär für zukünftige Standbilder gedeutet, jedoch geht das Slide definitiv auch explizit auf Videotechnologien ein. Werfen wir also einmal einen Blick auf die zwei wichtigsten Punkte der Präsentation:

Multiframe-Processing mit Highspeed Readout

Was wir immer schon länger als kommende Zukunftstechnologie erwartet haben, benennt Sony nun mit einem konkreten Namen: "Multiframe Processing" liest man hier im Zusammenhang mit "Highspeed Readout". Dies soll in Zukunft für HDR-Video mit einer hohen S/N-Ratio genutzt werden können.

Hinter diesen neuen Buzzwords verbirgt sich eine sehr interessante Theorie: Wenn man den gleichen Sensel sehr kurz hintereinander mit unterschiedlichen Belichtungszeiten auslesen kann, lässt sich damit theoretisch die Dynamik in den Lichtern um einige Blendenstufen erhöhen. Also ein ähnliches Prinzip, wie es Panasonic mit dem neuen Dynamic Boost Mode der GH6 bereits vorgemacht hat.

Konkret und stark vereinfacht könnte man beispielsweise bei einer typischen Belichtungszeit von 1/48 Sekunde noch eine sehr kurze Belichtung von 1/768s dazusamplen, und hätte mit der zweiten Belichtung rund vier Blendenstufen mehr Licht eingefangen, die zusätzliche Messwerte für Sensel liefern könnte, die bei der ersten längeren Belichtung gesättigt (also überbelichtet) waren. Die sehr kurze Belichtungszeit dürfte kaum für Bewegungsartefakte sorgen, wenn diese wirklich unmittelbar im Anschluss an die 1/48 Sekunde erfolgen kann.

Ein Sensor, der diese Auslesetechnik beherrscht, könnte sehr leicht zusätzliche Dynamik in den Lichtern gewinnen. Und laut Sony scheint man eben diesen Weg mit Multiframe-Processing in Smartphones beschreiten zu wollen.