[UPDATE:]Wie wir schon in unserem Test des LG 31MU97-B 4K-Monitors angekündigt haben, wollten wir uns auch einmal einen durchgehenden 10 Bit-Workflow in der Praxis ansehen. Wir hatten hierfür den LG 31MU97-B zusammen mit einer Nvidia Quadro K5200 auserwählt, stießen dabei jedoch auf Probleme. Genauer gesagt, bekamen wir immer nur eine 8 Bit Vorschau zu Gesicht, egal, was wir auch probierten.

Wir versprachen, ja an der Sache dran zu bleiben und haben nun einen Samsung U28D590D in die Redaktion geholt. Dieser ist einer der günstigsten 4K-Monitore überhaupt, der ebenfalls mit 1 Milliarde Farben wirbt (was in Technikerdeutsch 10/30 Bit bedeutet). Und siehe da, mit den unten beschriebenen Einstellungen, konnten wir an einer Nvidia Quadro K5200 klar einen Unterschied zwischen 8 Bit und 10 Bit erkennen. Somit müssen wir den schwarzen Peter definitiv dem LG 31MU97-B zuschieben. Bei uns konnte dieser Monitor jedenfalls keine 10 Bit darstellen, obwohl er es laut Datenblatt können sollte. Für alle die sich aber dennoch für das richtige Vorgehen interessieren, hier weiterhin der alte Artikel zum 10 Bit Workflow...

Ohne eine professionelle Nvidia Quadro/AMD FirePro Grafikkarte kann man das 10 Bit Feature vom Desktop aus gar nicht nutzen. Die Verbindung zum Monitor muss ebenso 10 Bit-fähig sein (z.B. DisplayPort 1.2), wie auch der Monitor: Dieser muss nicht nur ein echtes 10 Bit-Panel besitzen, sondern dessen Signalelektronik muss dieses auch mit echten 10 Bit ansprechen können.

Mit der Kombination aus Nvidia Quadro K5200 und LG 31MU97-B verbunden über das mitgelieferte “True 4K” Display-Port-Kabel fühlten wir uns auf dem Papier gut gerüstet, da alle Anforderungen für eine durchgehende 10 Bit Verarbeitung damit offensichtlich erfüllt sind.

Zusätzlich müssen auch die Desktop-Applikationen selbst bei der 10 Bit Vorschau-Wiedergabe mitspielen. Da der Windows Desktop (genauso wie auch der Apple Desktop) per se nicht 10 Bit-fähig ist, gelingt die Wiedergabe nur mit einem Trick:

Bei Nvidia (und auch bei AMD) müssen die Programme für die Videovorschau ein so genanntes OpenGL-Surface nutzen. Dies ist ein spezieller Display-Renderpuffer der GPU, in dem die Grafikkarte unter Umgehung des Windows Desktops direkt auf einzelne Pixel zugreifen kann. Pixel innerhalb eines OpenGL-Surfaces können schon seit längerem auch 10 Bit/pro Farbkanal darstellen. Genau genommen sogar noch mehr, denn in OpenGL werden alle Farben als Gleitkommawerte zwischen 0 und 1 gespeichert und dargestellt. Alleine der Display-Treiber entscheidet ob er zur Darstellung die Gleitkomma-Werte nach 8 Bit, 10 Bit oder sonst was rendert.

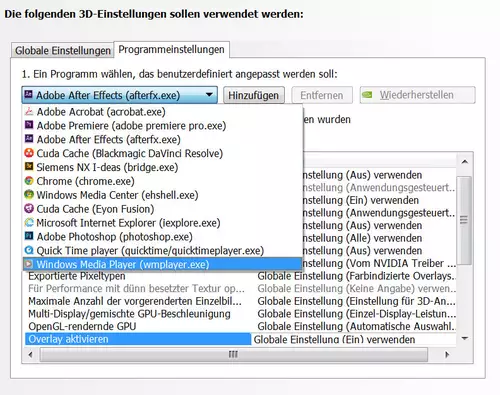

Unter Windows können u.a. Photoshop, Premiere Pro CS, After Effects und Resolve ihre Bildvorschau über ein OpenGL-Surface darstellen. In den Quadro-Treibern kann man nun einzelnen Anwendungen (oder gleich allen) die Anweisung erteilen, das OpenGL-Surface mit 30 Bit (also 3 x 10 Bit/Farbkanal) darzustellen.

Alternativ kann man dieses Verhalten auch einzelnen Applikationen zuweisen. Diese liefern im Treiber somit auch gleich einen Hinweis darauf, ob sie ein OpenGL-Surface zur Vorschau nutzen können...

Die hier gezeigten Optionen stehen übrigens in den normalen GeForce-Treibern unter Windows nicht zur Verfügung. Interessanterweise unter Linux aber wieder schon, aber das ist wohl ein anderes Thema.

Damit die Einblendung des OpenGL-Surfaces in den Desktop sicher funktioniert stellen die Treiber auch noch die Windows Aero-Effekte ab (u.a. für die Desktop-Display-Transparenz). Vorsichtshalber hatten wir diese aber sowieso schon vorher deaktiviert, da wir gelesen hatten, dass bei AMD-Karten die automatische Abschaltung teilweise nicht funktioniert. Nvidia soll laut User-Angaben auf jeden Fall auch selbständig und zuverlässig Aero für die 10 Bit Wiedergabe deaktivieren. Aber wie gesagt, sicherheitshalber haben wir das gleich selbst übernommen.

Wie testet man 10 Bit?

Nachdem Hardware und Treiber sehnsüchtig warteten, stellte sich natürlich die Frage, wie man eine 10 Bit-Wiedergabe überhaupt von einem normalen 8 Bit Monitor unterscheiden kann? Die Antwort: Fast gar nicht, da die 8 Bit eigentlich grundsätzlich ausreichen um praktisch jeden denkbaren Verlauf ohne sichtbare Treppen darzustellen.

Es gibt jedoch einen kleinen Bereich zwischen RGB (64,64,64) und RGB (96,96,96) der aufgrund der typischen Monitor-Gamma-Einstellungen zwischen 2.2. und 2.4 zu leichter Posterisation neigt.

Wenn man in 8 Bit einen Farbverlauf zwischen diesen beiden Werten erzeugt, bekommt man auf 99,9 Prozent aller PC- und Mac-Monitore leichte Posterization-Streifen zu sehen. Die 8 Bit Streifen sollten ungefähr so aussehen:

Erstellt man nun den gleichen Verlauf in einem 16 Bit/Farbkanal-Farbraum so sollten diese Streifen auf einem 10 Bit Monitor nicht mehr sichtbar sein. Soweit die Theorie anhand der auch viele Anwender weltweit die 10 Bit-Fähigkeiten ihres Workflows testen.

Der Lohn der Mühe

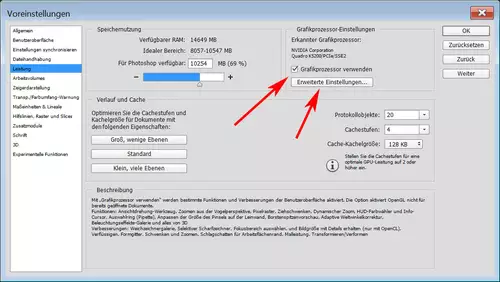

Als erstes wollten wir einmal in Photoshop CC 2014 64 Bit sehen, wie sich die 10 Bit-Einstellungen in der Praxis auswirken. Hierfür muss man Photoshop selbst auch noch für die 10 Bit Wiedergabe fit machen. In den Voreinsellungen muss man den erkannten Grafikprozessor zuerst aktivieren:

In den erweiterten Einstellungen lässt sich anschließend die 30 Bit-Anzeige ebenfalls anschalten:

Doch leider blieben trotz all dieser Voreinstellungen in Photoshop die 8 Bit Linien der Posterasation bestehen. Auch wenn wir den Rechner neu starteten und die Grafik komplett neu im 16 Bit Modus erstellten änderte das nichts an der offensichtlichen 8 Bit Darstellung. Andere Anwender im Netz behaupten jedoch, dass dieser Test bei 10 Bit immer zuverlässig funktioniert, wenn man alle hier dargestellten Hinweise beachtet. Bei uns jedoch offensichtlich nicht.

Im weiteren Verlauf unseres Tests erging es uns auch in After Effects, Premiere Pro oder Resolve nicht besser. Immer die 8 Bit-Stufen, egal ob wir die Verläufe intern erstellten oder als 16 Bit TIFF/PSD importierten. Gerade After Effects bietet eine sehr exakte Kontrolle darüber, ob man sein Projekt direkt in 8, 16 oder 32 Bit anlegt und auch die synthetischen Verlaufseffekte sind in After Effects explizit für die höheren Farbtiefen geeignet.

Nachdem wir wirklich alle erdenklichen Parameter durchprobiert hatten, gaben wir schließlich entnervt auf. Eine Anfrage bei LG, ob denn der Monitor irgendwo anzeigen könnte, ob er sich gerade im 8 Bit oder 10 Bit Modus befindet wurde leider ebenso verneint, wie eine Anfrage bei Nvidia, ob man denn irgendwo mit einem Tool prüfen könnte, ob die Verbindung zum Monitor aktuell mit 8 Bit oder mit 10 Bit pro Kanal "steht".

Nach unserem aktuellen Kenntnisstand sehen wir keine Schrauben mehr an denen wir noch drehen können. Entweder ist unsere Testmethode faul. Jedoch finden sich im Netz einige User, die behaupten, hiermit ihren 10 Bit Workflow hinbekommen zu haben. Oder der Hund liegt in einem anderen Detail begraben. Wer nun der schuldige ist (Monitor oder Grafikkarte) können wir aktuell nicht sagen. Alles was wir sehen können, ist dass ein Glied unseres Workflows offensichtlich nicht 10 Bit fähig ist. Wir wollen selber noch weiter am Thema dranbleiben, haben aber schon viel Zeit investiert und gerade warten eine Menge andere Tests, weshalb wir an dieser Stelle erst einmal das Projekt "On Hold" setzen.

Wir freuen uns aber über sachdienliche Hinweise im Forum, falls einer unserer Leser eine Idee haben sollte, wo hier der 8 Bit Hase im 10 Bit Pfeffer begraben liegt. Dann könnten wir auch an dieser Stelle weiterschreiben.

[UPDATE:] Mittlerweile haben den selben Aufbau mit einem Samsung U28D590D 4K-Monitor ausprobiert und können dort einen klaren Unterschied zwischen 8 und 10 Bit sehen. In unserem Fall können wir also nun bestätigen, dass der LG 31MU97-B bei uns keine 10 Bit Wiedergabe ermöglichte, sondern immer im 8 Bit Modus blieb.

Die grundsätzliche Frage, ob man 10 Bit Wiedergabe denn überhaupt braucht steht jedoch noch auf einem anderen Blatt. Denn unserer Meinung nach sind 8 Bit als Master-Vorschau in der Regel schlauer, weil dies ja auch in 99 Prozent aller Fälle das Zielmedium der Massen darstellt (Fernsehen, Internet, DVD/BluRay). Zur Nachbearbeitung sind 10 Bit gegenüber 8 Bit jedoch definitiv äußerst vorteilhaft. Und warum das so ist, werden wir euch bald in einem eigenen Artikel darlegen.