Schon seit letzten Sommer arbeitet Google an einem Auto-Dubbing für YouTube-Videos. Nun wurde die KI-basierte, automatische Synchronisierung für hunderttausende von Kanälen im YouTube-Partnerprogramm freigeschaltet. Vornehmlich Creators, die informative oder lehrreiche Videos produzieren, wurden bei diesem ersten, großen Roll-out berücksichtigt - das Feature soll aber nach und nach auch für andere Arten von Videos angeboten werden.

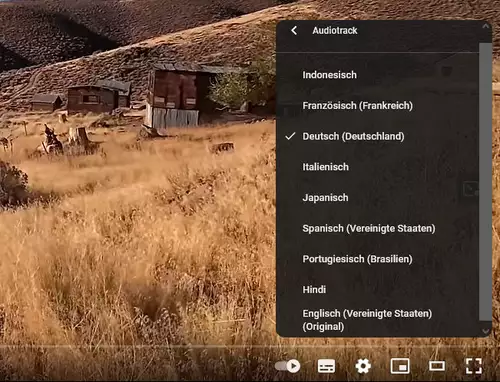

Dies bedeutet, dass man ab jetzt weniger Untertitel zu sehen bekommen und dafür häufiger auf z.B. deutschsprachige Tonspuren stoßen wird. Unterstützt werden aktuell neun Sprachen, neben Englisch sind dies Französisch, Deutsch, Hindi, Indonesisch, Italienisch, Japanisch, Portugiesisch und Spanisch. Ist die Originalsprache eines Videos Englisch, werden für alle diese Sprachen eine synchronisierte Version erstellt, andersherum jedoch nur eine einzige, nämlich eine englische. Wird also ein Video auf deutsch veröffentlicht, ist es alternativ auch auf englisch zu hören.

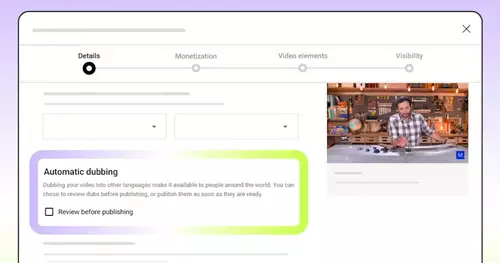

Die automatische Synchronisierung ist standardmäßig aktiviert, wenn ein Kanal über das Feature verfügt, läßt sich aber jederzeit im YouTube Studio am Desktop deaktivieren. Auch können synchronisierte Fassungen eines eigenen Videos vorab geprüft werden.

// Top-News auf einen Blick:

- Graphite - kostenloser Grafik-Editor von Photoshop bis Motion

- Affinity Photo, Designer und Publisher ab sofort in einer kostenlosen App

- DJI Neo 2 bringt Rundum-Hinderniserkennung samt LiDAR

- Künftige Xbox Next: Vollwertiger Windows-PC mit Potenzial für Videobearbeitung

- LG UltraFine 40U990A-W - 40 5K2K Monitor mit Thunderbolt 5

Auf YouTube sind Videos mit diesen automatisch erstellten Audiotracks in der Videobeschreibung mit "Automatisch synchronisiert" gekennzeichnet. Zuschauer können in den Videoeinstellungen jederzeit zum ursprünglichen Audiotrack oder zu einer anderen verfügbaren Sprache wechseln.

Die synchronisierten Audiotracks werden automatisch erzeugt - KI-Algorithmen erkennen und transkribieren die Originaldialoge, übersetzen sie und geben sie mit synthetischer Stimme neu aus. Dies gelingt nicht bei allen Videos gleich gut; aufgrund etwa von Aussprachefehlern, Akzenten, Dialekten oder Hintergrundgeräuschen im Originalvideo können sich Fehler einschleichen. Zu Problemen kann es auch bei der Übersetzung von Eigennamen, Redewendungen und Jargon kommen. Auch kann die für die Synchronisierung verwendete Stimme im Vergleich zur Originalstimme versetzt zu hören sein.

Dafür, dass die Synchrontracks künstlich erstellt sind, klingen sie sehr gut, allerdings wird die Betonung und der Duktus der Originalstimme nicht richtig berücksichtigt. Dies soll sich perspektivisch noch ändern, damit die alternativen Sprachfassungen vom Hörerlebnis näher an der Urfassung liegt ("Expressive Speech").