Nachdem Open AI ja gerade mit Dall-E 3 die KI-News beherrscht, holt Meta zum nächsten Streich in der Liga der generativen Diffusions-Modelle aus. Zwar wurde "Emu" noch nicht offiziell angekündigt, jedoch gibt es bereits ein eingereichtes Paper, welches in der Szene nun große Neugier weckt.

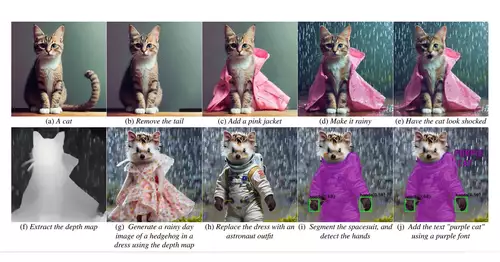

Das Paper führt mit Emu letztlich zwei sehr interessante Neuigkeiten ins Feld. Erstens fand Meta bei der Architektur, dass eine Erhöhung der Kanäle im Autoencoder von 4 auf 16 die Rekonstruktion feiner Details signifikant erhöhte. Kleine Schriften bleiben hiermit beispielsweise deutlich lesbar.

Die wichtigste neue Erkenntnis durch Emu ist laut Meta jedoch, dass ein überwachtes Feintuning mit einem Satz überraschend kleiner, aber extrem visuell ansprechender Bilder die Generierungs-Qualität erheblich verbessern kann.

// Top-News auf einen Blick:

- Affinity Photo, Designer und Publisher ab sofort in einer kostenlosen App

- DJI Neo 2 bringt Rundum-Hinderniserkennung samt LiDAR

- Künftige Xbox Next: Vollwertiger Windows-PC mit Potenzial für Videobearbeitung

- LG UltraFine 40U990A-W - 40 5K2K Monitor mit Thunderbolt 5

- Neue Firmware für Panasonic LUMIX S5 II, S5 IIX, S9, GH7 und G9 II

Nun bleibt es natürlich spannend, was Meta letztlich mit seinem Modell anfangen wird. Das letzte große Sprachmodell (LLMs) von Meta (LLama) fand schnell seinen Weg in die Hände der Open Source Gemeinde - was nun natürlich auch entsprechende Erwartungen gegenüber Emu aufkommen lässt. Ein paar Tage müssen wir uns allerdings wohl noch gedulden, bis Meta hier seine konkreten Pläne verlautbaren wird.