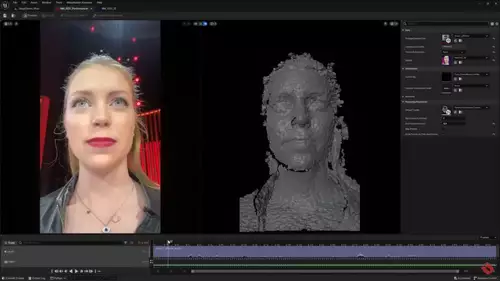

Organic Motion, Hersteller von professioneller Motion Capturing Technik, testet die Verwendung von Microsofts Kinect System zum einfachen Motion Capturing in Echtzeit. Das bisher von Organic Motion entwickelte markerlose System beruht auf der Verwendung von bis zu 14 S/W in verschiedenen Winkeln angeordneten Kameras um die Bewegungen von Schauspielern im Raum mit einer Auflösung bis auf die Fingerbewegungen zu erkennen und auf animierte Modelle zu übertragen.

Microsofts Kinect System, das auf einer einzigen Kamera beruht, die zusätzlich zu Bildern auch Entfernungsinformationen zu jedem Pixel liefert, kann diese Anordnung wesentlich vereinfachen: unter Zuhilfenahme der Bilder von nur 3 zusätzlichen Webcams kann ein ganzer Köper (inklusive der von der Kinect Kamera nicht sichtbaren Stellen) in 3D rekonstruiert werden - und auch noch auf den sonst notwendigen retroreflektierenden Spezialhintergrund verzichtet werden. Das schon ganz ansehnlichre Ergebnis kann im folgenden Video bestaunt werden.

Der nächste logische Schritt ist die Verwendung von 2 Kinect Kameras (was auch von anderen Projekten schon getestet wird), um auf die zusätzlichen Webcams ganz zu verzichten um das System weiter zu vereinfachen und auch in einer billigeren (allerdings auch weniger zeit- und raumauflösenden als das Orginalsystem) Version anbieten zu können. Die Möglichkeite für ein präzises und erschwingliches Echtzeit Motion Capturing System wären gewaltig.

// Top-News auf einen Blick:

- Sony Alpha 7 V ist da: 33MP Partially Stacked Sensor, 4K 60p ohne Crop und 16 Stops

- ByteDance Vidi2 produziert selbstständig fertige Videos aus Rohmaterial

- Blackmagic DaVinci Resolve 20.3 bringt Support für 32K-Workflows und mehr

- Bis zu 1.000 Euro sparen: Cashbacks auf Kameras von Sony, Nikon, Canon und Panasonic

- Sony und slashCam verlosen eine FX2 Cinema Line Kamera

- DJI Neo 2: Verbesserte Mini-Drohne für Solo-Creator und Einsteiger

Passend dazu: John Underkoffler, der das Gesten-Interface für Minority Report entworfen (oder besser visioniert) und damit der Entwicklung solcher Interfaces einen großen Schub verpasst hat, spricht in einem sehr interessanten TED Talk über die Zukunft des User Interfaces zwischen Mensch und Maschine. Er zeigt einige schöne Beispiele für eine Gestensteuerung, die eine wesentlich intuitivere Interaktion mit dem PC als per Tastatur oder Maus möglich macht (ab 11:11 auch was ganz Videoschnitt-spezifisches).