Im Bereich Motion-/Performance Capturing tut sich zur Zeit richtig viel - die neueste Meldung kommt von Epic Games. Für ihren MetaHuman Creator, mit dem sich fotorealistische, digitale Menschenfiguren erstellen lassen, wurden neue Möglichkeiten vorgestellt, die den Animationsprozeß deutlich beschleunigen und vereinfachen. Profitieren sollen vom neuen MetaHuman Animator nicht nur Entwickler von Computerspielen oder Hollywoodstudios, sondern ebenso auch Indie-Produzenten und Hobbyanwender.

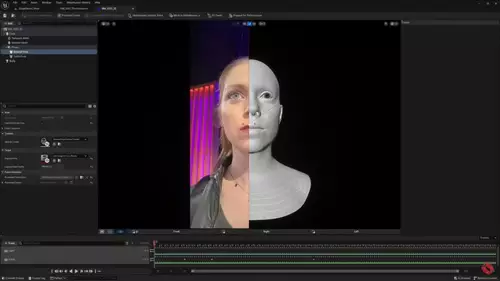

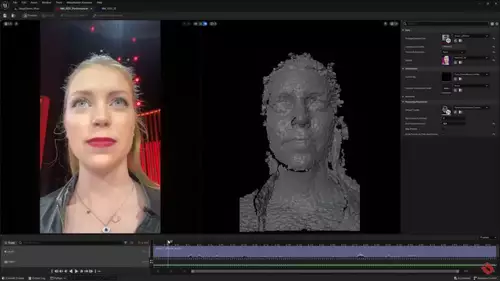

Mit einer einfachen iPhone-Kamera - also ohne 3D-Setup oder Marker - läßt sich demnächst innerhalb weniger Minuten ein Gesichts-Capturing durchführen und auf einen geriggten "MetaHuman" übertragen; für letzteres braucht man natürlich auch ausreichend potente Hardware. Wer möchte kann auch weiterhin eine Helmkamera verwenden und eventuell noch genauere Resultate erzielen. Folgende Präsentation zeigt, wie gut dies funktioniert - auch feine Nuancen der Mimik werden gut übertragen, auch wenn natürlich noch erkannbar ist, dass es sich um eine Animation handelt.

Damit das System die Mimik möglichst originalgetreu auf einen beliebigen Avatar anwenden kann, muss zunächst das zu trackende Gesicht analysiert werden. Zunächst wird für dieses ein MetaHuman Charakter angelegt, mit standardisiertem Rig und Mesh - benötigt wird nur eine kurze aufgenommen Sequenz. Mithilfe dieses Charakters lassen sich dann die Positionsveränderungen des Rigs während der getrackten Performance erkennen und auf den Zielcharakter übertragen.

// Top-News auf einen Blick:

- Blackmagic Resolve Studio für 236,81 bei Teltec - und weitere Angebote

- Bis zu 1.000 Euro sparen: Cashbacks auf Kameras von Sony, Nikon, Canon und Panasonic

- Ausgewählte Angebote - DJI Mavic 4 Pro, Canon R5 C, Sachtler aktiv12T...

- Die besten Black Friday Deals für Sony und Canon DSLMs und Objektive

- Blackmagic bietet bis zu 30% Rabatt auf seine 6K Kameras

- Große Übersicht - Black Friday Deals 2025 für Foto+Video - Kameras, Objektive, Zubehör usw.

Die neuen Funktionen von MetaHuman Animator werden Teil des MetaHuman Plugins für die Unreal Engine sein, das (wie die Engine selbst) kostenlos heruntergeladen werden kann. Es wird jedoch erst in einigen Monaten öffentlich zugänglich sein.

MetaHuman Animator funktioniert mit einem iPhone 11 oder höher, benötig wird außerdem die kostenlose Live Link Face App für iOS, die mit einigen zusätzlichen Aufnahmemodi zur Unterstützung dieses Workflows aktualisiert wird.

Auch für ein einfaches Motion Capturing reicht seit kurzem übrigens ein iPhone aus, oder genauer gesagt müssen es zwei Phones sein. Die passende App Move.ai wurde erst letzte Woche vorgestellt - sie unterstützt unter anderem auch die Unreal Engine.