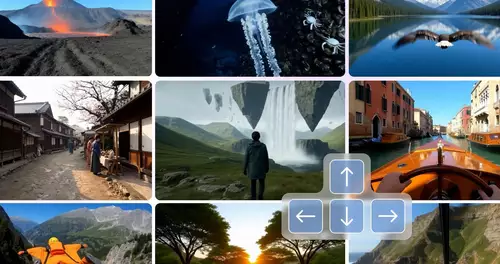

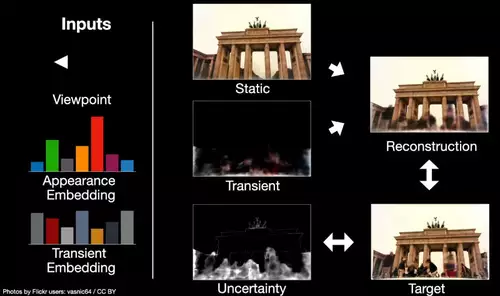

Der neue Algorithmus eines Teams von Google-Forschern schafft Erstaunliches: er erstellt mithilfe eines neuronalen Netzwerks aus mehreren Photos einer Szenerie ein 3D-Modell. Neue Bilder der Szene werden daraufhin aus weiteren, vorher nicht vorhandenen Perspektiven synthetisiert und können dann per virtuellen Kamerafahrten erkundet werden. Demonstriert wird das sehr schön im folgenden Clip unter anderem am Beispiel des Brandenburger Tors und des Fontana di Trevi:

Virtuelle Kamerafahrt:

Herausforderungen für den auf Neural Radiance Fields (NeRF) basierenden Algorithmus sind dabei die extrem unterschiedlichen Licht- und Wetterverhältnisse der verschiedenen Photos sowie andere dynamische Unterschiede zwischen den Aufnahmesituationen, wenn zum Beispiel Bildelemente wie etwa Autos, Menschen oder Schilder die Sicht auf andere Bildteile versperren. Davon muss abstrahiert werden, um ein 3D-Modell der statischen Objekte samt der herrschenden Lichtverhältnisse einer Szene zu erhalten.

Dieses ermöglicht sowohl Kameraschwenks als auch Zoomfahrten. Zusätzlich erlaubt das Modell es, den Look der neuen virtuellen Ansichten zu verändern, um zum Beispiel die besonderen Beleuchtungsverhältnisse einer bestimmten Lichtsituation (Mittags, Nachts mit Scheinwerfern,...) zu simulieren.

// Top-News auf einen Blick:

- Neue Gerüchte: Nvidia soll die GPU-Produktion 2026 um 30–40% runterfahren

- Adobe Firefly bekommt Upscaling per Topaz, Editing per Prompt und mehr

- Leak: Samsungs plant SATA-Aus - Kommt der Preisschock auch bei SSDs?

- Kompaktkameras wieder im Trend - trotz Smartphones

- Von Mickey Mouse bis Darth Vader - Disney lizenziert seine Figuren an OpenAIs Sora

- Verstehen Video-KIs die Welt? Physik-IQ enthüllt Grenzen der Modelle

Das Training mittels 8 GPUs einer Szene mit mehreren hundert Photos dauerte ungefähr 2 Tage. Das Schöne an der neuen Methode ist, daß dazu beliebige (User-)Photos aus dem Netz verwendet werden können, welche von den verschiedensten Touristen mit ganz unterschiedlichen Kameras geschossen wurden.

Der folgende "2 Minute Papoers"-Clip demonstriert sehr schön die großen Fortschritte, welche die neue Methode innerhalb nur weniger Monate gegenüber dem Vorgängermodell erreicht hat:

Wir erinnern uns an einen noch sehr viel älteren Vorläufer von 2007, Microsofts Photosynth, welches mittels einer ganze anderen Methode als NeRF-W aus Photos 3D-Modell der Photos im Raum, erzeugen konnte.