Die neueste 2018er Version unserer Tipps für den Zusammenbau des besten PCs für die FullHD/4K/6K Videobearbeitung findet sich hier!

Wie schon in ersten Teil des Artikels erwähnt können viele Schnittprogramme die Grafikkarte zur Effektberechnung nutzen. Wer dabei wie viel Leistung benötigt ist jedoch recht unterschiedlich. Am beeindruckensten geht dabei Adobes Premiere zu Werke. Hier reicht in der Regel schon eine günstige Mittelklasse-Karte aus, um zahlreiche Effekte hintereinander auf einen Videoclip anzuwenden und in Echtzeit wiederzugeben. Auch Sonys Vegas 13 kann die GPU gut nutzen, allerdings bricht das Programm bei der Kombination mehrerer GPU-Effekte schneller ein, während Premiere auch durch viele Effekte fast nicht in die Knie zu zwingen ist. (Die neuen Lumetri-Effekte scheinen allerdings nicht mehr so effektiv programmiert zu sein.) Edius hat dagegen praktisch keine GPU-Effekte zu bieten (nur GPU-Übergänge) und gerät daher bei der Kombination mehrerer 4K-Effekte schnell ins Stocken.

DaVinci Resolve kann sogar mehrere GPUs im System ans Limit bringen. Der Grund liegt darin, dass das Programm ohne Vorberechnungen auch echte Optical Flow-Effekte auf der GPU in Echtzeit darstellen kann. Dazu gehören u.a. Slow-Motion-Berechnungen, zwei Denoiser sowie das nachträgliche Einrechnen von Motion Blur.

Premiere, Vegas, Final Cut Pro und Edius müssen solche Effekte (sofern überhaupt vorhanden) immer erst vorrendern, während DaVinci Resolve immer versucht diese in Echtzeit zu errechnen. Selbst drei Top-GPUs können in diesem Fall dann für 4K in Echtzeit noch wenig zu wenig sein.

Wenn man eine neue Grafikkarte kauft, sollte man darauf achten, dass diese mindestens 4GB eigenen Speicher besitzt. Der Aufpreis ist in der Regel nicht mehr der Rede wert und nach unserer Erfahrung kann man in Premiere, Vegas und Edius diesen Speicher auch mit extremen Effektorgien kaum zum Überlaufen bringen. Einzig unter Resolve haben wir mit 4GB GPU Speicher schon Speicherüberläufe erlebt und zwar wenn man das GPU-Debayering und sowie viele Optical Flow-Effekte mit OFX-Plugins kombiniert. Um für diesen seltenen Fall gewappnet zu sein, kann man auch zu Karten mit 6-8GB greifen. Für die kostenlose Lite-Version spielt GPU-RAM übrigens fast gar keine Rolle, da es hier keine Optical-Flow-Algorithmen gibt. Und mit “normalen” Nodes kann man es praktisch nie schaffen, bei 4K 4GB zum Überlaufen zu bringen.

Mehrere GPUs

Apropos mehrere GPUs. Beim Abspielen von der Timeline unterstützt nach unserem aktuellen Kenntnisstand nur Resolve den Einsatz mehrerer GPUs. Kombiniert man mehrere Karten so addiert sich hier die Leistung fast. Was sich allerdings nicht addiert ist der Speicher. Eine schnelle GPU mit 4GB Speicher zeigt also die gleiche Performance wie zwei halb so schnelle Karten mit 4GB. Übrigens müssen die eingebauten GPUs nicht zwingend aus der gleichen Serie stammen, jedoch sollten (und können) Hersteller (also AMD/ATI oder Nvidia) nicht gemixt werden. Sobald jedoch nur eine der Karten zu wenig Speicher hat funktionieren die speicherhungrigen Optical Flow Algorithmen nicht mehr. Außerdem ist es für Resolve leichter, die Leistung effektiv zu verteilen wenn es identische GPUs vorfindet.

Und auch wenn es preislich manchmal interessanter erscheint zwei schwächere Karten statt einer starken zu kaufen, raten wir deutlich lieber zu einer schnellen GPU. Einmal profitieren davon alle Applikationen (nicht nur Resolve). Außerdem gibt es OFX-Plugin-Effekte (u.a. für Resolve und Vegas), die nur eine GPU nutzen können. Und nicht zuletzt werden bei einer einzigen GPU weniger PCIe-Lanes und Gehäuseplatz im System verbraucht. Durch weniger Hardware ist das System dann weniger komplex und in der Folge nicht so fehleranfällig. Der Hinweis, dass man für DaVinci Resolve eine eigene Grafikkarte zur Oberflächendarstellung vorhalten sollte, scheint uns in diesem Zusammenhang kaum noch relevant, besonders wenn die PCI-Steckplätze knapp sind. Denn bei unseren Tests beschleunigte eine zusätzliche GUI-GPU die Effekte immer nur noch marginal. Deutlich mehr Leistung erhält man durch Voll-Ausbau der freien PCI-Slots mit möglichst potenten Karten, von denen dann die potenteste das GUI darstellt UND mitrechnet.

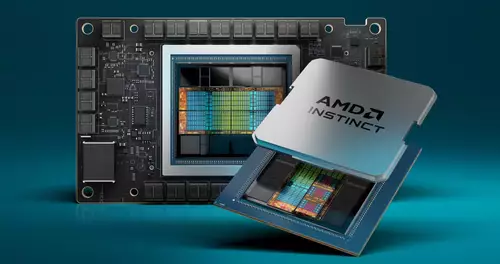

AMD, Intel oder Nvidia?

Eine weitere schwierige Frage ist Wahl des GPU-Herstellers. Nvidia bedient diesen Markt bereits am längsten und stellte mit seiner CUDA-Schnittstelle lange den professionellen de Facto Standard dar. Sowohl unter Adobe Premiere als auch unter DaVinci Resolve wirken die Nvidia CPUs am solidesten unterstützt. Allerdings sind die Nvidia Karten auch deutlich teurer als vergleichbare AMD-Modelle, die in der Regel auch noch spürbar schneller rechnen können. In der Vergangenheit galten die AMD-Modelle allerdings als nicht ganz so stabil. Dafür unterstützt AMD mit OpenCL einen offenen Standard, der sich sowohl bei Adobe als auch bei Resolve mittlerweile als praktisch gleichwertig durchgesetzt hat. Sonys Vegas setzte schon seit jeher einzig und allein auf OpenCL. Mittlerweile unterstützt auch Nvidia diesen neuen Standard, allerdings immer noch etwas halbherzig. Schließlich will man ja weiterhin die Hersteller zu CUDA überreden, das es nur für Nvidia-Karten gibt. Für OpenCL spricht allerdings, dass sogar Intel dies unterstützt. Sowohl Premiere als auch Vegas laufen daher neuerdings auch mit den integrierten GPUs in aktuellen Consumer Core i7-Prozessoren. Diese Intel GPUs kommen in der Leistung nicht an dezidierte Grafikkarten heran, können allerdings auf dem Laptop für eine ganz passable Beschleunigung sorgen. Sogar Resolve versperrt sich seit Version 12 nicht mehr den Intel Prozessoren...

Vorschau über GPU oder dezidiert?

Ein weiteres wichtiges Thema ist noch die Videovorschau. Denn sowohl Premiere als auch Vegas ermöglichen es, einen zweiten Videoausgang der Grafikkarte dazu zu nutzen, um eine Videovorschau anzuzeigen. DaVinci Resolve dagegen zwingt den Anwender hierfür eine spezielle Videoschnittkarte anzuschaffen. Für 4K-Ausgabe kostet das günstigste Modell ca. 200 Euro (Intensity Pro 4K), das jedoch bei unserem Test erschreckend laut war. Vorteil einer solchen Lösung ist dabei, dass diese Blackmagic-Karten auch eine echte 10 Bit Ausgabe ermöglichen. Alternativ kann man hierfür auch zu teuren Nvidia Quadro oder AMD FirePro-Modellen greifen, jedoch ist hier der Ausgabe Erfolg nicht immer garantiert und wir hatten hier schon mit diversen Fallstricken zu kämpfen. Wem eine 8 Bit Ausgabe reicht der kann sich unter Premiere oder Vegas auch die Investition für eine dezidierte Schnittkarte sparen, wenn die Grafikkarte mit brauchbaren Ausgängen bestückt ist. Man sollte sich dabei allerdings bewusst sein, dass die Übertragung zum Monitor dann in RGB und nicht in YUV mit teilweise nicht frei wählbaren Bildwiederholraten erfolgt, was Schnitt-Puristen in der Regel doch zu einer dezidierten Vorschaukarte treibt.

Ob die Anschlüsse für einen selbst “brauchbar” sind, definiert sich in diesem Fall nach den eigenen Ansprüchen. Eine Grafikkarte mit SDI-Ausgängen kostet meist weitaus mehr als eine dezidierte Lösung plus eigene Grafikkarte. Dagegen dürfte es vielen Anwendern auch genügen, wenn das Hauptdisplay mit 1920 x 1200 Pixeln bei 60Hz über HDMI angesteuert wird, und der 4K-Vorschaumonitor über den 60Hz-Displayport-Anschluss läuft. Wenn man in erster Linie für das Internet produziert, dürfte eine mögliche 8 Bit sRGB-Vorschau mit 60Hz sogar viel mehr der Zielgruppe entsprechen als eine 10 Bit REC709 YUV-Vorschau auf einem Broadcast-Referenzmonitor. Mit etwas Recherche lassen sich so günstige Grafikkarten-Lösungen finden, die dann natürlich auch von den Videoapplikationen unterstützt werden müssen. Besonders sticht in dieser Disziplin Vegas hervor, das die meisten Einstellmöglichkeiten für die Einrichtung des Vorschaumonitors bietet. Premiere offeriert hier schon weniger Optionen. EDIUS und Resolve machen ohne separate Preview-Karte gar keinen Spaß.

Und am Mac?

Bei Apples Mac Rechnern hat man seit dem letzten MacPro eigentlich kaum noch eine freie Auswahl bei den Komponenten. Grafikkarten und Prozessoren sind nur sehr eingeschränkt als Build-To-Order Optionen erhältlich, also direkt beim Kauf. Ein nachträgliche Änderung der Grafikkarte oder des Prozessors ist meistens gar nicht möglich. Dennoch gelten viele Ratschläge für 4K-Bearbeitung genauso:

Beim iMac den größten (4-) Core i7 mit Hyperthreading wählen und beim MacPro lieber gleich mit mindestens 6 Kernen einsteigen. Auch bei den GPU-Optionen immer lieber die größte Option mit möglichst viel Speicher wählen, besonders wenn man auch DaVinci Resolve einsetzen will.

Apples eigenes Schnittprogramm Final Cut Pro X setzt ebenfalls auf die CPU zum decodieren und übergibt dann bei den meisten Effekten an die GPU. Optical Flow-Algorithmen müssen immer vorgerendert werden, für die typischen Effekte wie maskierte Farbkorrektur oder Weichzeichner reichen die großen GPU-Optionen in der Regel gut aus. Leider werden im iMac nur Notebook GPUs mit relativ wenig GPU RAM verbaut, was die Leistungsfähigkeit gegenüber PC-Lösungen etwas einschränkt. Für den 4K Editing und Resolve Einsatz ist eigentlich nur das BTO Flagschiff (AMD Radeon R9 M295X mit 4 GB GDDR5 Arbeitsspeicher) interessant, das mit ca. 3,5 TFlops und 256 Bit-Speicherinterface als PCI-Karte rund 200 kosten würde. Im neuen Mac Pro finden sich dagegen potentere DUAL GPU Optionen bis zu 7 TFlops und 2 x 6GB, die allerdings auch spürbare Mehrkosten nach sich ziehen.

Apples eigenes Schnittprogramm Final Cut Pro X setzt ebenfalls auf die CPU zum decodieren und übergibt dann bei den meisten Effekten an die GPU. Optical Flow-Algorithmen müssen immer vorgerendert werden, für die typischen Effekte wie maskierte Farbkorrektur oder Weichzeichner reichen die großen GPU-Optionen in der Regel gut aus. Leider werden im iMac nur Notebook GPUs mit relativ wenig GPU RAM verbaut, was die Leistungsfähigkeit gegenüber PC-Lösungen etwas einschränkt. Für den 4K Editing und Resolve Einsatz ist eigentlich nur das BTO Flagschiff (AMD Radeon R9 M295X mit 4 GB GDDR5 Arbeitsspeicher) interessant, das mit ca. 3,5 TFlops und 256 Bit-Speicherinterface als PCI-Karte rund 200 kosten würde. Im neuen Mac Pro finden sich dagegen potentere DUAL GPU Optionen bis zu 7 TFlops und 2 x 6GB, die allerdings auch spürbare Mehrkosten nach sich ziehen.