Wir schreiben zwar gerade erst das Jahr 2024, jedoch gibt es bereits heute einen ziemlich klaren Ausblick darauf, in welche Richtung sich Rechner zur Videobearbeitung in den nächsten 24 Monaten entwickeln werden. Beziehungsweise, weshalb die Videobearbeitung in der Cloud wahrscheinlich schon bald die Norm sein wird.

Investment-Motor Künstliche Intelligenz

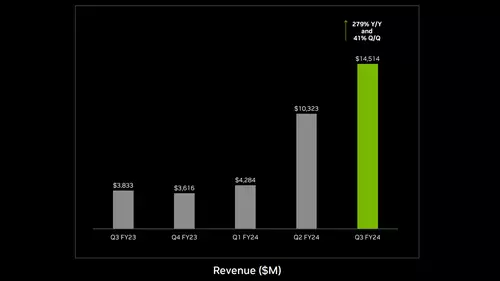

Größter Motor hinter der kommenden Entwicklung ist ein weiteres mal die Künstliche Intelligenz (KI): Wer sich hier in den letzten Monaten etwas mit den technischen und finanziellen Hintergründen der großen KI-Unternehmen befasst hat, weiß, dass diese in den nächsten Jahren dreistellige Milliardenbeträge in den Ausbau ihrer KI-Rechenzentren investieren wollen und sehr wahrscheinlich auch werden. Marktführer Nvidia will nach aktuellen Branchen-Schätzungen alleine schon in diesem Jahr (2024) sogenannte KI-Beschleuniger für mindestens 60 Milliarden Dollar ausliefern - und dies ist nur eine aktuelle Schätzung, die im Jahresverlauf erfahrungsgemäß noch einmal nach oben revidiert wird. Lisa Su (CEO von AMD) erwartet sogar, dass der Markt der KI-Beschleuniger bis 2027 auf ein Volumen von 400 Milliarden anwachsen wird! Das wäre das Fünffache des gesamten, weltweiten Servermarktes vom letzten Jahr!

Kurz gesagt: Für KI-Anwendungen wird in den nächsten Jahren eine Menge frische Rechenleistung installiert. Eine fast unvorstellbare Menge! Wer die technischen Hintergründe hierzu etwas verfolgt (oder aufmerksam slashCAM gelesen) hat, weiß, dass diese Rechenleistung nicht mehr wie in den letzten Jahrzehnten von CPUs, sondern vermehrt von GPUs erbracht wird. GPUs können universelle Programme nicht sonderlich gut ausführen, dafür aber gleiche Rechenschritte besonders effektiv "parallelisieren." Wenn man milliardenfach die gleichen Rechenschritte mit immer neuen Daten ausführen muss (wie beispielsweise bei Pixeln in einem Video), rechnen diese GPUs weitaus schneller und effizienter als CPUs.

Alles GPU oder was?

Mit dem "G" in GPU (Graphics Processing Unit) haben diese Beschleuniger eigentlich gar nichts mehr am Hut, sondern tragen ihren Namen nur noch deswegen, weil diese von den Grafikkarten-Chips abstammen, die ebensolche Berechnungen schon seit Jahrzehnten beschleunigen. In der KI werden diese GPUs dagegen heute für die Berechnung großer Vektoren genutzt, aber in Video-Applikationen wie Resolve oder Premiere beschleunigen sie auch nach wie vor die Pixelberechnung.

Nun sind die Rechenbeschleuniger in den KI-Rechenzentren zwar ein bisschen anders "zusammengeschaltet", aber im Grunde haben sie das meiste immer noch mit den klassischen GPUs gemeinsam. Das Wichtigste für den Hinterkopf ist dabei: Beide lassen sich von einem Programm nahezu identisch ansprechen. So kann ein großer Nvidia-Server mit 256 GPUs für eine Applikation genauso über CUDA angesprochen werden, wie eine einzelne GPU in einem Schnitt-PC. Ähnliches gilt auch (noch mit leichten Einschränkungen) für AMD GPUs.

Der Stand der GPU-Technik

Wagen wir nun einmal einen kleinen Exkurs zum aktuellen Stand der Technik einer Workstation. Die dort verbauten CPUs sind für die Videobearbeitung mittlerweile fast zu vernachlässigen und übernehmen fast nur noch die Daten-Steuerungsaufgaben. Die besten GPUs bieten hingegen einen Speicherdurchsatz von rund 1.000 GB/s und ca. 80 TFLOPS FP32 Rechenleistung. FP32 ist übrigens das übliche Datenformat, in dem Video-Effekte unter Resolve oder Premiere GPU-beschleunigt werden.

Tatsächlich korreliert die Geschwindigkeit der meisten GPU-Video-Effekte stärker mit dem Speicherdurchsatz als mit der FP32 Rechenleistung, was bedeutet, dass meistens eher die Speicheranbindung also die Rechenleistung der limitierende Faktor bei der Video-Effekt-Beschleunigung ist.

Was kann eine KI-Server GPU?

Sehen wir uns nun einmal die Daten eines aktuellen KI-Beschleunigers an, der momentan unter KI-Experten heiß gehandelt wird: AMDs MI300X. Dieser besitzt rund fünfmal mehr Datendurchsatz (5,3 TB/s) sowie 160 (Peak-)TFLOPS FP32. Und dieser Beschleuniger könnte prinzipiell auch als PCIe-Karte ausgeliefert und in einem normalen PC verbaut werden.

Noch spannender ist allerdings der MI300A, welcher gleichzeitig ein paar CPU-Kerne integriert, die über Unified Memory mit den GPU-Kernen verfügen. Dieser Beschleuniger ähnelt damit eigentlich einem M2-Ultra Chip von Apple, nur eben "on steroids".

Zum Vergleich, das aktuell beste Mac Studio-Modell - der Apple M2 Ultra im Vollausbau - bietet eine 24‑Core CPU, sowie eine 76‑Core GPU mit maximal 28 FP32 TFLOPS mit maximal 192 GB RAM Unified Memory bei 800 GB/s Speicherdurchsatz (und das alles für schlappe 8.000 Euro).

Der AMD MI300A Beschleuniger bietet dagegen: Ebenfalls 24 CPU-Kerne, aber in der GPU 122 FP32 TFLOPS an 128 GB HBM3 Unified Memory mit 5,3 TB/s Speicherdurchsatz. Dies entspricht also mindestens der fünffachen theoretischen Resolve-GPU-Leistung gegenüber einem Mac Ultra Studio.

Als Workstation denkbar?

Gerüchten zufolge kostet aktuell ein AMD MI300A Beschleuniger im Einkauf für ein Rechenzentrum ca. 20.000 Euro. Könnte man diesen "einfach" als Workstation verpacken, wäre dies für Hochleistungs- Anwender ein verlockendes Angebot. Vergleicht man dies mit den Preisen für Workstations, die beispielsweise SGI vor 30 Jahren veranschlagte, so könnte man sogar von einem Workstation Schnäppchen sprechen.

Auf einem solchen System sollten die meisten Effekte typischer Video-Applikationen immer in voller Qualität einfach in Echtzeit laufen können. Und auch für die sicher kommenden, generativen KI-Echtzeit-Anwendungen wäre man mit so einem System unterm Schreibtisch ebenfalls nicht schlecht gerüstet.

Kurz gesagt, die Technologie wäre eigentlich schon da, es müsste nur ein Hersteller einen Markt für solche Workstations sehen. Doch natürlich haben gar nicht mehr so viele potentielle Käufer die Auftragslage, um eine 25.000 Euro Workstation (mit allem Drum und Dran) zu refinanzieren.

Workstation on Demand mieten statt kaufen - in der Cloud

Doch genau hier kommt nun die Cloud ins Spiel: Schon heute lässt sich beispielsweise eine Nvidia H100 (die aktuell für ein Rechenzentrum mindestens 30.000 Euro kostet) schon für 3 Euro pro Stunde "mieten" - also in der Cloud in einer virtuellen Umgebung beliebig nutzen. Sollten die zukünftig zugebauten GPU-Instanzen nicht noch überlaufener sein als heute schon, dann darf man PI-mal-Daumen rechnen, dass man in naher Zukunft eine MI300A Instanz (bzw. eine vergleichbare Leistung) wahrscheinlich sehr bald für 2 Dollar/Stunde finden wird.

Wer beim Schnitt nur gelegentlich Echtzeiteffekte benötigt, könnte sich diese Leitung On-Demand in der Cloud einfach hinzubuchen. In der Praxis ist dies allerdings noch mit einigem Know-How verbunden, weshalb dieser Weg heute nur sehr IT-affinen Anwendern offensteht. Man muss allerdings kein Hellseher sein, um zu ahnen, dass hier die meisten Hersteller ein entsprechendes Geschäft wittern.

Keine technischen Hürden

Wer einmal gesehen hat, wie reaktiv Game-Streaming heutzutage funktioniert, dürfte kaum Zweifel haben, dass das Streaming einer Videobearbeitungs-Anwendung bei schnellem Internet problemlos funktionieren kann. Sind die Files einmal in der Cloud, ist der Unterschied zwischen Cloud- und Desktop-Schnittsystem schon heute kaum noch zu bemerken.

Und auch als Applikations-Anbieter wie Blackmagic oder Adobe muss man nicht einmal notgedrungen in eigene Serverstrukturen investieren. Alle großen Cloudanbieter rüsten gerade ihre Rechenzentren mit GPU-Massen von Nvidia und AMD hoch. Man stelle sich Resolve oder Premiere nun einfach in der Cloud vor - mit einer zusätzlichen Option, nur bei konkretem Bedarf für vielleicht 3 Dollar/Stunde auf Alles-In-Echtzeit "hochzuschalten". Blackmagic und Adobe verdienen dabei dann einfach am zusätzlichen Share von der GPU-Leistung, die von Amazon, Google, Microsoft und Co. für die Applikation für 2 Dollar/Stunde berechnet wird.

Zukunftsmusik? Heute vielleicht noch, aber nicht mehr lange. Besonders, wenn noch mehr KI-basierte Effekte in die Programme einziehen, ist eine andere Entwicklung sogar kaum noch vorstellbar. Denn die kommenden KI-Effekte müssen ja sowieso in der Cloud berechnet werden. Und gegen deren Performance-Anforderungen sind die heute aktuellen GPU-Effekte ohnehin Kinkerlitzchen...