Zusammen mit der University of California in Santa Barbara hat Apple ein eigenes KI-Modell entwickelt, das offenbar ein Sprach- und ein Diffusionsmodell kombiniert, um einfache Bildmanipulationen für jedermann zu ermöglichen.

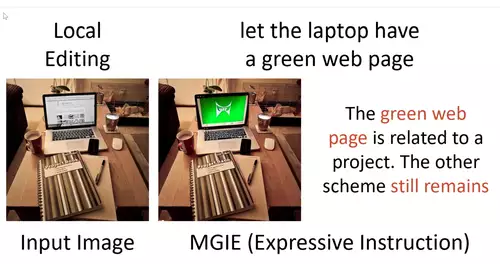

Das auf den Namen MGIE getaufte Modell steht letztlich für Multimodal Large Language Model Guided Image Editing - übersetzt also eine durch ein Sprachmodell geführte Bildbearbeitung. In der Praxis wird die Eingabeaufforderung in eine präzisere Anweisung für das Netzwerk umgewandelt, die dann mittels eines Diffusionsmodells das Eingabebild entsprechend verändert.

Das zugehörige Paper ist hier zu finden und neben einem GitHub Repository gibt es auch eine Demo-Webseite zum herumspielen, die auf Hugging Face gehostet wird.

MGIE ist nicht das erste Projekt dieser Art und mit etwas Know-How kann man auch leicht Stable Diffusion oder Adobes Firefly zur Lösung solcher Aufgaben einsetzen. Es bleibt jedoch abzuwarten, welche Qualität der Output von MGIE haben wird. Das Paper selbst sieht jedenfalls Photoshop-ähnliche Aufgaben als Einsatzzweck.

// Top-News auf einen Blick:

- Neue Gerüchte: Nvidia soll die GPU-Produktion 2026 um 30–40% runterfahren

- Adobe Firefly bekommt Upscaling per Topaz, Editing per Prompt und mehr

- Leak: Samsungs plant SATA-Aus - Kommt der Preisschock auch bei SSDs?

- Kompaktkameras wieder im Trend - trotz Smartphones

- Von Mickey Mouse bis Darth Vader - Disney lizenziert seine Figuren an OpenAIs Sora

- Verstehen Video-KIs die Welt? Physik-IQ enthüllt Grenzen der Modelle

Und auch wenn andere Seiten das vielleicht anders sehen, glauben wir auch, dass es grundsätzlich eher ein schlechtes Zeichen ist, wenn Apple den Code für so ein Tool frei gibt. Denn dann ist es eher unwahrscheinlich, dass es seinen Weg in ein kommendes Produkt findet.

Aber natürlich soll man den Tag nicht vor dem Abend loben. Wir werden sicherlich auch versuchen, uns ein konkreteres Bild von MGIE zu machen - sobald der derzeitige Ansturm auf die HuggingFace-Demoseite etwas abgeflaut ist.