Newsmeldung von slashCAM:Die NAB 2016 liegt hinter uns und neue Produkte & Workflows in 2016 vor uns. Evolution statt Revolution war das Motto auf der NAB in diesem Jahr: Keine Kamera-Knaller (von den etablierten Herstellern) – dafür war die Rede von Problemlösungen, Softwareupdates, Workflows und vor allem: HDR - trotzdem oder genau deswegen stehen wir vor einem Jahr voller Umbrüche im Bewegtbild-Kamera Bereich.

Hier geht es zum slashCAM Artikel:

Essays: Post NAB 2016: Dynamikumfang, 10-Bit Displays, HDR und Dual Gain

Antwort von dienstag_01:

Jetzt, wo wir gerade so glücklich sind mit unseren Bildern zwischen dunklem und hellem Grau... ;)

Antwort von rob:

Hi dienstag_01,

ja - das ist hart ;-)

Aber ganz ehrlich: Persönlich können mich TV-Hersteller mit immer höheren Auflösungen nur noch schwer zum Kauf locken - mein Wohnzimmer ist leider keine Fabrikhalle - mit einem sichtbar größeren Dynamikumfang würde ich mich auf "Homeland 1-5" allerdings nochmal neu freuen ...

Viele Grüße

Rob

Antwort von leonhard dy kabrio:

Hallo Rob!

Schöner Artikel. ja DYNAMIK, und DYNAMIK und FETT DYNAMIK. Je mehr Reserve wir

haben/ Hätten, je mehr wir davon später haben. Und es wäre halt schön wenn alle Hersteller bis runter zum Display in einer Linie stehen würden, es wäre so schön wenn 10 bit die unterste Kante wäre. Und solches nicht immer etwas grindig versteckt, oder mit herzlich netten Subcodecs ( und wortschwulenten Marketingbegriffen " situationselastisch" die 8 komma5 Bit erklären, die wenn wir sie dann fertig sehen in 10 bit uns den Jesus vorstellen müssen, wen der leere Tisch voll mit Fisch :)

Yes, yes, yes DYNAMIKUMFANG.

Ich hab ein Wohnzimmer in Fabrikhallengröße ( wh kannst deine Wohnung da rein stellen) was egal ist, ich habe aber nicht so einen " Sonnenröstspigeel" mit 9 qm2 und im Nebenzimmer ein Kleinatomkraftwerk.. ne. Auch net. Und ich gehe lieber ins Kino!

Wenn ich nicht mehr gehen kann, habe ich dieses Ding. Wird total andere Technik sein!

2017::

-mehr Dynamik

-diese in der ganzen Kette, bis zum Endverbraucher

( ich seh schon die gsoffenen RTL Sofa-perverslinge "... määääääääär TinamiG")

- 10 bit iNTERN RECORDING, zumindest die üblichen Codecs..

-Produktpflege nicht Body-body-body-body..

-und das ganze Ding! ( ja sie bekommen ihr uptade nach dem Erscheinen des Nachfolgers, und nein die Hotline weiß nicht, was sie wollen ????)

Schönen gesunden Sommeranbruch ..:) LDK

Antwort von Tiefflieger:

Danke für die gute Beschreibung SlashCAM und aus meiner Konsumentensicht ist die Bruttopixelbetrachtung nicht so wichtig. Solange man kein Fliegengitter oder nur Motionblur-Brei sieht.

Wenn ich aktuelle TV Qualität in 720p oder 1080i skaliert zu 4K sehe, so sind bei SFDRS seit Anfang Jahr Fortschritte sichtbar.

- Heisst Interviews mit einer Person in Portraits haben Tiefe, Farbe mit Kontrast.

- Landschaftsaufnahmen und Tierfilme in hoher Qualität sehen ansprechend aus.

Mängel

- Aber Sportaufnahmen sind wegen Motion-Blur nicht hoch auflösend. Im Eishockey ist der Puk nicht immer gut zu sehen, wie Real auf der Tribüne.

- Wenn ich einen Hochauflösenden Notebook vor mir habe und im Hintergrund ein Beitrag oder Film im Fernsehen läuft ist beim kurzen Hochschauen zum 4K-TV die fehlende" Bilddetailauflösung deutlich sichtbar.

Ich wünsche mir

- Bilddetails in strukturierten Farben, hohem Kontrast von schwarz bis weiss (Bildtiefe) in "natürlich" kräftigen Farben (bei real Film und TV Szenen).

- Hohe Bewegungsauflösung um Details in Bewegung zu sehen (TV Sport). Film bei Bedarf da interessantes aus ethischen, intim-und Trick-Gründen nicht im Detail gezeigt wird.

(Film im Einzelbildschritt kann sehr interessant sein ;-)

- Landschaftsaufnahmen und Totale vertragen gut 8K. Ebenso im Sport wenn im Bewegtbild die Tribüne mit im Bild ist.

- Portrait oder Nahaufnahmen von Personen ist Geschmacksache (720p reicht)

Vielleicht braucht es in Zukunft nur noch "digital" Bildinhaltlich Beschreibende Formate und nicht mehr fest gerenderte Auflösungen und Farbspektren (LUT-Beschreibung). So wird bedarfsgerecht Bandbreite gespart, bzw. was einem ein Beitrag wert ist.

(Inhaltlich beschreibend gilt für Bild und Ton <- Virtualisierung bis hin zu 360 Grad)

Gruss Tiefflieger

Antwort von Peppermintpost:

ich hätte da mal ne frage. ich hab hier 2 bilder. einmal rec709 und einmal slog-3. quizzfrage: welches bild hat mehr dynamik?

(das ist übrigens mit ursa gedreht, schon beeindruckend wie geil blackmagic den black sun bug gefixed hat, aber das nur am rande)

Antwort von ruessel:

welches bild hat mehr dynamik?

Genau, beide Bilder haben die selbe Dynamik (Blendenumfang), warum sollte REC709 (in 8Bit) nicht HDR tauglich sein? Nur wegen der in REC709 weniger enthaltenen Helligkeitszwischenabstufungen?

Interessant wird evtl. der neue HDMI 2.1 Standard. Gerüchten zufolge soll der Anschluss die Vorteile von HDR noch besser herausarbeiten: HDMI 2.0 überträgt Metadaten für HDR noch statisch. Eine Einstellung für HDR etwa wird über den gesamten Film gelegt. Bei HDMI 2.1 jede Szene individuell - wie das dann ausschaut kann ich mir im Moment noch gar nicht vorstellen.

Meinen persönlichen "HDR" Effekt habe ich in den 70er Jahren im Kino erlebt. Bei UNHEIMLICHE BEGEGNUNG DER DRITTEN ART ist der Anfang 60 Sekunden schwarz (mit kleiner Schrift) und dann wird das Bild plötzlich komplett weiß, die Lampe des Kinoprojektor strahlte wie die Sonne - man war für wenige Sekunden komplett geblendet. Was für ein Anfang......

Antwort von dienstag_01:

Genau, beide Bilder haben die selbe Dynamik (Blendenumfang),

Ah, alles klar. Und nachts ist kälter als draussen ;)

Antwort von Peppermintpost:

wow, das ist das gleiche? in einem bild hab ich eine dynamik von 0-100 und in dem zweiten eine von 35-80.

ja gut wenn das alles das gleiche ist dann ist ja sowieso keine weitere diskussion nötig. aber bei so einer klaren a oder b frage gehen die meisten sowieso schon auf tauchstation. ist auch besser so.

Antwort von dienstag_01:

Is ne Kopfsache ;)

Antwort von ruessel:

dynamik von 0-100 und in dem zweiten eine von 35-80

ich meinte, wenn ich "HDR" Material aus der MiniURSA4.6 auf REC709 so bringe, das Schwarz auch auf 0 bzw 16 steht und der hellste Punkt auf 255 bzw. 235 bringe, müsste auf einem HDR TV der Sonnenaufgang genauso eine dynamik haben, oder? Nur es wird wohl banding geben.

Antwort von wolfgang:

Ich vermute man muss zwischen dem Dynamikumfang des Materials unterscheiden, und dem was ein Panel dann auch darstellen kann. Üblicherweise wird gesagt dass unsere bisherigen Panele nur einen Dyamikumfang von 5-6 Blenden darstellen können, während HDR-Panele eben entsprechend mehr können. Das würde bedeuten dass man auf einem herkömlichen Panel zwar das Bild ebenso sieht, dass aber etwa einiges in Schwarz oder Weiß abgesoffen sein kann weil man es auf dem herkömmlichen Panel gar nicht mehr erkennen kann.

Wenn das so sein sollte, dann dürfte eine Beurteilung von hier eingestellten Testbildern derzeit noch kaum möglich sein - den wer hier liest schon im Forum bereits mit einem HDR-Schirm? Vermutlich noch keiner.

Man wird also abwarten müssen bis derartige Panele tatsächlich vorhanden sind - und erst damit läßt sich das Material bezüglich HDR wirklich an Schnittplätzen wie an Präsentationsplätzen beurteilen.

Antwort von Axel:

Man wird also abwarten müssen bis derartige Panele tatsächlich vorhanden sind ...

Ohne jetzt alles verfolgt zu haben: hab kürzlich im Blödmarkt schon etliche Fernseher stehen sehen, die mit HDR warben und wo der Demo-Content auch echt echt aussah, so tiefstes Schwarz und blendende Lichter. Die "DVD"-Sektion (fällt es jemandem auf? Der Platz wird kleiner. Für CDs sowieso, aber auch DVDs und BDs werden weniger) hatte eine winzige Untersektion mit, schlagmichtot, 30 Titeln in UHD und/oder HDR. Im Vorbeigehen zur Kenntnis genommen, daher "ohne Gewähr".

Ab wann man das wirklich vergleichen kann?

Möglicherweise gilt für Dynamik etwas Ähnliches wie für Auflösung, und sie ist besser aufwärts skalierbar als abwärts. Soll heißen, vielleicht sieht ein rec_601 Film auf einem Dolby-HDR-TV besser aus als eine HDR-UHD-BD auf einem 10 Jahre alten LCD-Panel. Das würde ich nämlich vermuten.

Antwort von ruessel:

Das würde bedeuten dass man auf einem herkömlichen Panel zwar das Bild ebenso sieht, dass aber etwa einiges in Schwarz oder Weiß abgesoffen sein kann weil man es auf dem herkömmlichen Panel gar nicht mehr erkennen kann.

Ich erkläre mir das so, wenn ein HDR Signal auf einen normalen TV trifft, dann ist Schwarz und der hellste Pixel des HDR Streams auch der dunkelste/hellste Pixel auf dem TV. Nur es fehlen die vielen differenzierten Zwischenstufen (gröber in der Helligkeit) und natürlich ist der hellste Punkt nicht so strahlend wie auf einem HDR Panel, aber warum sollte da was im Bild absaufen oder ausbrechen?

Antwort von wolfgang:

Das würde bedeuten dass man auf einem herkömlichen Panel zwar das Bild ebenso sieht, dass aber etwa einiges in Schwarz oder Weiß abgesoffen sein kann weil man es auf dem herkömmlichen Panel gar nicht mehr erkennen kann.

Ich erkläre mir das so, wenn ein HDR Signal auf einen normalen TV trifft, dann ist Schwarz und der hellste Pixel des HDR Streams auch der dunkelste/hellste Pixel auf dem TV. Nur es fehlen die vielen differenzierten Zwischenstufen (gröber in der Helligkeit) und natürlich ist der hellste Punkt nicht so strahlend wie auf einem HDR Panel, aber warum sollte da was im Bild absaufen oder ausbrechen?

Ja es werden halt nur Zwischenstufen in dem Mitteltönen dargestellt. Das geht auch noch halbwegs solange das Material nicht in markanten Bildteilen besonders viel Information in den Hochtönen oder Tiefen hat.

Viele der heute bestehenden rec 709 Panele stellen ja dem alten legal Bereich nur Luminanzwerte zwischen 16..235 dar. Moderne UHD und HDR Panele können aber mit 10bit meist den vollen Lumninanzumfang 0..1024 darstellen. Auf so einem Sichtgerät wird man als feine Abstufungen im Bereich unter 64 und über 940 noch differenziert erkennen können, was ja der Sinn von HDR wäre. Nur bei der Betrachtung auf den rec 709 Panelen geht das nicht, da ist halt alles unter 64 schwarz und alles über 940 weiß und damit geclippt.

Das Material clippt dir also auf älteren Panelen je nach Bildinhalten wenn man es etwa im full range für neuere Panele geschnitten hat. Das ist dann wieder mal eine Entscheidung die man am Schnittplatz fällen muss - und gerade aktuelle NLEs wie auch Resolve bieten ja beide Möglichkeiten an. Nur wählt man eben den klassischen sendesicheren Bereich und ein modernes UHD-HDR-Panel kann 0..1024 dartellen, dann schränkt diese Schnittweise den Dynamikumfang in moderner Sichtgeräte eventuell erst wieder ein. Was dem HDR-Grundgedanken entgegen gesetzt ist.

Von diesen Aspekten her bin ich gespannt wie sich das weiter entwickeln wird. Normen werden wohl was vorsehen - aber was Geräte wirklich dann können ist ja oft eine andere Frage.

Antwort von Peppermintpost:

ich finde es sehr erstaunlich, wir nehmen in x-log auf um unsere dynamik schon bei der aufnahme zu verringern, dann wird das in der post wieder auseinander gezerrt damit wir auch schön wenig farbauflösung im mitteltonbereich haben, also genau da wo die musik spielt, jetzt kaufen wir uns noch einen fernseher dazu der das noch weiter verzerrt, weil unser bild ja noch nicht scheisse genug aussieht. ist klar.

ist hier evtl schon mal dem einen oder anderen aufgefallen, das wenn ich mit einer lampe auf eine schwarze fläche leuchte, die fläche dann nicht dunkeler wird? also egal wie hell so ein hdr fernseher auch werden kann, das schwarz bleibt genau da wo es ist, da ändert sich nichts. nur die highlights werden heller, sonst passiert da garnichts.

einen hdr fernseher bekommt man ganz umsonst, man muss nur abends im wohnzimmer mal das licht ausmachen, und schon gehen die schwärzen weiter runter, man erhöht also die dynamik range.

ich hab ja keine ahnung was ihr so für fernseher zu hause stehen habt, aber wenn ich auf meiner konsumer schrabbel kiste im dunkeln einen film sehe, und da ist ein umschnitt von einer dunkelen zu einer hellen szene, dann muss ich die augen zusammenkneifen, weil die dynamik range die meine augen können schon geringer ist. was ist also der witz an hdr fernsehen, das dann in zukunft bei so einem umschnitt direkt die netzhäute geschädigt werden und man für die nächsten 10min nur noch helle punkte sieht?

ja, ich glaub das brauch ich jetzt nicht, aber für alle anderen, empfehle ich, auf auf in den media markt bevor alle vergriffen sind.

ist immer wieder faszinierend mit welchem schwachsinn man menschen verarschen kann.

Antwort von wolfgang:

Aber dass man x-log Material normalisieren muss, das ist dir schon bekannt?

Mal jenseits vom Rundumschlag auf irgendwelche Märkte oder Fernsehhersteller...

... und wenn du das nicht brauchst, dann wirst wohl eh nicht kaufen.

Antwort von Peppermintpost:

...wir nehmen in x-log auf um unsere dynamik schon bei der aufnahme zu verringern, dann wird das in der post wieder auseinander gezerrt damit wir auch schön wenig farbauflösung im mitteltonbereich haben...

was du "normalisieren" nennst nenne ich "verzerren", egal auf welches wort wir uns einigen, mathematisch ist es nur eine multiplikation der luma werte, sonst nichts, und bei einer multiplikation von z.b. faktor 2 verdopplele ich natürlich die spreizung oder dynamik zwischen min und max, allerdings veringere ich gleichzeitig auch die farbauflösung auf die hälfte, das scheinen aber (fast) alle ausser acht zu lassen.

wenn sich zwei menschen unterhalten und auf dem tisch steht eine kerze, dann interessiert mich nicht wie fein die flamme abgestuft ist, aber die abstufung der hauttöne interessiert mich durchaus. ist aber natürlich geschmacksache, jedenfalls hilft dann hdr tv eine noch besser aufgelöste kerze zu sehen und noch weniger gesichter, bravo.

Antwort von wolfgang:

was du "normalisieren" nennst nenne ich "verzerren", egal auf welches wort wir uns einigen, mathematisch ist es nur eine multiplikation der luma werte, sonst nichts

Nur das ist inhaltlich eben falsch weils eben keine Multiplikation mit einer fixen Konstanten ist sondern eine Transformation in einen andere Gammakurve.

Und es tut mir auch leid wenn du meinst mit mir eine Normenklaturdiskussioon führen zu wollen. Darauf habe ich ehrlich gesagt keinen sonderlichen Bock. Wir haben eben in unserer Sprache auch Fachbegriffe, und selbst wenn man die aus irgendeinem Grund "verzerrt" wahrnimmt dann landet man halt doch bei falschen Dingen wie dieses Beispiel gerade zeigt.

wenn sich zwei menschen unterhalten und auf dem tisch steht eine kerze, dann interessiert mich nicht wie fein die flamme abgestuft ist, aber die abstufung der hauttöne interessiert mich durchaus. ist aber natürlich geschmacksache, jedenfalls hilft dann hdr tv eine noch besser aufgelöste kerze zu sehen und noch weniger gesichter, bravo.

Gerade eine x-log Aunahme stellt Hauttöne nach erfolger Normalisierung deutlich besser dar als die meisten Aufnahmen direkt zu rec.709. Das ist auch keine Geschmacksfrage sondern das ist real an dem Material beobachtbar. Man muss es nur beobachten wollen... ;)

Antwort von Peppermintpost:

das y=2x eine lineare funktion ist, das ist mir auch klar, es ist nur etwas leichter nachzuvollziehen als y=wurzel x was einer gamma kurve näher kommt, sich aber leider keiner mehr vorstellen kann.

wie x-log aber gerade in den mitteltönen vorteile gegenüber rec709 hat ist mir schleierhaft bei halber dynamik bei der aufzeichnung wovon dann der grösste teil auch noch in den highlights versenkt wird. muss sich wohl um magie handeln oder kannst du technisch erklären wie das genau laufen soll?

bei z.b. c-log wie das kodak vor über 20 jahren eingeführt hat, da war das so das auflösung in den highlights und den schatten geopfert wurde um mehr information im mitteltonbereich abspeichern zu können. das war zwar mist weil es keiner gerafft hat wie man es benutzen muss, hatte technisch aber vorteile wenn man es richtig gemacht hat. nur die ganzen modernen kamera luts (also z.b. slog2/slog3) machen genau das gegenteil, und genau von denen sprechen wir hier ja und nicht von kodak c-log.

Antwort von Rudolf Max:

Viel wichtiger als 10Bit und solches Zeugs wäre wohl ein Fernsehprogramm, das sich auch anzusehen lohnt...

Für den heutigen zumeist elenden Schrott, den man uns auftischt sind 8Bit schon fast zuviel...

Rudolf

Antwort von WoWu:

@Rudolf

Das darfst Du nicht so verbissen sehen.

Die 10 Bit sind eigentlich zur zum Qualitätserhalt nötig, denn bei der grauen Soße, die oft sowieso nur noch die Hälfte des Dynamikbereiches nutzt, braucht man schon 10 Bit, um nicht noch schlechter zu werden.

Auch die 4000 Nits sind nötig, um aus dem grauen Zeugs mit höherer Leuchtdichte wenigstens für Weiß wieder die bekannten 400 Nits zu machen.

Was in den Produktionen heutzutage versemmelt wird, wird dann eben über neue Technik kompensiert.

Antwort von Rudolf Max:

Hey Wolfgang,

Ich habe da eher an den inhaltlichen Schrott gedacht, weniger an die technische Qualität...

Schrott in 8Bit ist Schrott...

Schrott in 10Bit bleibt immer noch Schrott...

Anders gesagt: Lieber guten Inhalt in 8Bit, als Schrott in 10Bit...

Aber eben, die "Qualitätsfraktion" sieht das anders...

Rudolf

Antwort von WoWu:

Das hab ich schon so verstanden, aber ohne die technischen Neuerungen hätten wir dann schlechte Inhalte und eine noch schlechtere Bildqualität.

Man könnte natürlich konstatieren "passt doch".

Da würde ich Dir dann auch Recht geben ... aber wo blieben dann die ganzen Hypes, ohne die die meisten ja nicht mehr leben können.

Aber mal allen Ernstes.

Der Schritt zu höheren Bildqualitäten ist immernoch besser, als nur zu größeren Bildwänden, ohne höheren bildlichen Inhalt.

Und wenn die höheren Leuchtdichten dann auch die graue Soße wieder ausbügeln, ist doch alles ok.

Antwort von Uwe:

...

Ja es werden halt nur Zwischenstufen in dem Mitteltönen dargestellt. Das geht auch noch halbwegs solange das Material nicht in markanten Bildteilen besonders viel Information in den Hochtönen oder Tiefen hat.

...

Genau - viele der neueren HDR-Produktionen von Netflix & Co. wurden z.B. mit der Sony PMW-F55 gedreht, die einen Dynamikumfang von ca. 14 Blendenstufen hat. Dann wird in der post noch bisschen was raus geholt und für HDR gemastert. Da würden bisherige TV"s (256 Helligkeitsstufen) schlapp machen. Ein HDR-TV mit seinen mind. 1000 Helligkeitsstufen eben nicht.....

Antwort von WoWu:

Dann wird in der post noch bisschen was raus geholt

Erklär mal, wie Du aus FullWelll, also unterschiedliche Lichtwerte eine identischen Übertragungswert angenommen haben, wieder die unterschiedlichen Lichtwerte daraus errechnest.

schlapp machen

Was genau meinst Du mit "schlapp" ?

1000 Helligkeitsstufen

sind damit 1000 NITs gemeint ?

wie x-log aber gerade in den mitteltönen vorteile gegenüber rec709 hat ist mir schleierhaft bei halber dynamik bei der aufzeichnung wovon dann der grösste teil auch noch in den highlights versenkt wird.

Das geht Dir nicht allein so.

Mir ist der Vorteil dessen, mindestens 2 Bit an Dynamik völlig ungenutzt zu lassen, auch noch nicht klar.

Antwort von wolfgang:

Also was mir unverständlich ist das ist viel mehr der Umstand, dass die gleichmässigere Verteilung der Luminanzwerte start auf die 6 Blendenstufe auf 12-15 (je nach Kamera halt) nicht als der Vorteil verstanden werden dürfte, der das einfach ist. Material welches man dann in der Postpro entsprechend entwickeln kann (aber auch muss). Und sogar bei den Mitteltönen hat man dann eben mehr Abstufungen zur Verfügung, auch wenn man dort auch bisher gut leben hat können. Nur gehts um den gesamten Umfang - darum heisst der Punkt ja DynamikUMFANG. Eigentlich völlig trivial. Und dass man halt erst die passenden Sichtgeräte braucht liegt auch auf der Hand. Das wird dann die Zeit wo ich persönlich langsam meine alte HD-Darstellungskette in Pension schicken werde. Das dies Handlung und Inhalt nicht ersetzen kann liegt auch auf der Hand - aber das ist halt so.

Antwort von WoWu:

Ja, das wäre alles prima, würde man durch so ein re-mapping auch den gesamt zur Verfügung stehenden Wertebereich benutzen, wie es ARRI, ja beispielsweise tut.

Dann ist ein re-mapping durchaus sinnvoll, wobei es dabei bleibt, dass die unteren 1 bis 2 Bits ohnehin nicht nutzbar sind, weil sie verrauscht sind.

Damit hätte man schon mal 1-2 Bit weniger.

Aber ich gebe Dir Recht, man kann solche Wertebereich natürlich mit andern Werten füllen, verliert den Vorteil aber wieder, wenn man dann Grauwerte in der Post ins Schwarz zieht, sofern man keine grauen Bilder erzeugen möchte.

Das alles erklärt aber noch nicht den Vorteil einer Übertragungskurve, die von Haus aus den Wertebereich nur sehr eingeengt nutzt und ganze Wertebereich unbelegt lässt.

Das hat nämlich mit Re-Mapping so gut wie nichts mehr zu tun und was den Dynamikumfang angeht, den erkaufst Du Dir mit gröberen Abstufungen und damit Banding. .... Völlig ohne Not, denn würde man den gesamten Wertebereich nutzen, wären die Abstufungen bei identischem Umfang kleiner und Banding geringer.Und dass man halt erst die passenden Sichtgeräte braucht liegt auch auf der Hand.

Das ist das, was ich oben geschrieben habe ... Da macht der Fernseher dann aus GRAU mehr Lichtemission, damit es wieder genauso hell aussieht, wie auf den alten CRTs.

Antwort von wolfgang:

Man wird ja nicht nur das Rauschen verstärken sondern bei x-log eher Überbelichten. Also in einem Bereich der Kurve arbeiten wo man auch sinnvolle Werte aufzeichnen kann. Wenn das nicht möglich ist wie bei massivem lowlight dann heißt es eh entweder nicht mit x-log sondern besser gleich nach rec709 zu schießen, oder sogar mal Licht setzen zu müssen. Und dass Panele halt erst mal das darstellen können müssen was hier diskutiert wird ist auch klar. Sonst wird man halt die Dinge nicht mal sehen können.

Antwort von WoWu:

Man wird ja nicht nur das Rauschen verstärken sondern bei x-log eher Überbelichten. Also in einem Bereich der Kurve arbeiten wo man auch sinnvolle Werte aufzeichnen kann.

Überbelichtung heisst, dass der Sensor für jedes weitere Photon, das ihn erreicht, denselben Wert generiert, wie für das letzte Photon im Rahmen der korrekten Belichtung, also bis FullWell.

Dabei ist es dann völlig egal, ob dieser Wert in der Übertragungsfunktion in der Mitte liegt, oder am oberen oder unteren Ende, weil die Überbelichtung, auch bei LOG Funktionen immer zu diesem einen, maximalen Wert vom sensor her führt.

Daraus ist dann kein weiterer, exakter Wert mehr zu ermitteln.

FullWell ist FullWell, völlig egal, welche Übertragungsfunktion dahinter liegt.

Wer bei LOG überbelichtet bekommst nur statt Weiss ... Grau und erst wieder Weiss, wenn er das Grau in der Post auf Weiss spreizt, nur mit dem Unterschied, dass die Abstufungen kleiner sind und er jede Menge Banding hat.

Also nochmal die Frage:

Welchen praktischen Nährwert hat eine Übertragungsfunktion, die fast die Hälfte der Übertragungswerte mit Nullen füllt ?

Antwort von wolfgang:

Doch nicht so überbelichtet dass man ins clipping kommt. Und warum die Hälfte der Werte mit Nullen gefühlt sein sollen? Das ist doch gar nicht der Punkt. Sondern die vergleichmäßigte Zahl der Luminanzwerte pro Blendenstufen ist der relevanter Punkt.

Antwort von Peppermintpost:

deswegen habe ich oben rec709 vs slog-3 incl waveform gepostet, damit man das mal vor augen hat. hier nochmal slog3. wie man sieht ist in den oberen 20% keine information (was wowu mit null info bezeichnet hat) und es ist keine info in den unteren 35% also findet die farbinfo gerade mal in 45% der zur verfügung stehenden farbauflösung statt.

würde man von einer linearen korrektur ausgehen (was sie natürlich nicht ist, das ist mir auch klar) dann halbiert sich die farbauflösung. in der praxis is es noch schlimmer, weil in slog3 die infos in den highlights stärker vertreten sind. d.h. das es im so wichtigen mitteltonbereich weniger als die halbe farbauflösung hat.

kann ja gut sein das wowu und ich das alles noch nicht richtig begriffen haben, dann wäre ich für eine aufklärung des sachverhalts sehr dankbar.

Antwort von domain:

Ich habe das auch nicht begriffen.

Denn grundsätzlich kann slog-3 doch nur für das Mapping vom maximalen Dynamikumfang des Sensors gedacht sein.

Wenn der aber nicht vorliegt, dann wird nach deiner Aussage doch relativ häufig nur ca. 50% des zur Verfügung stehenden Bitbereiches ausgenützt.

Was soll das?

Antwort von Funless:

Ihr versteht das Allesamt nicht. Mit x-log aufzunehmen ist ganz einfach cooler!

Jede weitere Diskussion darüber ist ...

irrelevant!

Antwort von Peppermintpost:

Ihr versteht das Allesamt nicht. Mit x-log aufzunehmen ist ganz einfach cooler!

Jede weitere Diskussion darüber ist ...

irrelevant!

ich fahre nicht mit dem skateboard zum set, trage keine fake rolex, und hab auch meine hose nicht in den knien hängen, ich bin also nicht cool, darf ich dann weiter rec709 drehen?

Antwort von dienstag_01:

Für einen Hochzeitsfilmer (schwarzer Anzug, weisses Kleid) sind die verlorenen Mitten vielleicht ein guter Kompromiss gegenüber vollkommen ausbrechenden Schwarz- und Weisswerten. Keine Ahnung, keine Erfahrung, denk ich mir so.

Edit: Ausbrechen ist vielleicht der falsche Begriff, ein paar mehr Abstufungen in der Luminanz trifft es wahrscheinlich besser.

Antwort von Peppermintpost:

Für einen Hochzeitsfilmer (schwarzer Anzug, weisses Kleid) sind die verlorenen Mitten vielleicht ein guter Kompromiss gegenüber vollkommen ausbrechenden Schwarz- und Weisswerten. Keine Ahnung, keine Erfahrung, denk ich mir so.

kenne mich mit hochzeitsfilmen nicht aus, kann ich mir nur theoretisch vorstellen, und in dem fall den du beschreibst, ja kann gut sein.

ich sage auch nicht x-log ist grundsätzlich mist. es gibt dafür mit sicherheit spezialanwendungen wo das sinn macht. dein beispiel kann so eins sein. der klassiker ist ja immer der innenraum schuss mit dem fenster und draussen brennt sie sonne. da spielt x-log auch seine stärken aus. ich sage nur, eine spezialanwendung rechtfertigt nicht, das grundsätzlich zu benutzen und als dogma zu deklarieren.

ein ferrari kann auch einige dinge besser als ein golf, aber zum einkaufen, um die kinder zur schule zu bringen oder im stau auf dem weg zur arbeit ist ein golf besser. auf der rennstrecke sitze ich lieber im ferrari, ich bin aber nur 5 tage im jahr auf der rennstrecke, die anderen 360 tage will ich nur von a nach b. wenn man das bei x-log im kopf behält, und dann auch noch lernt wie man es korrekt benutzt, dann ist gegen x-log nichts einzuwenden.

Antwort von dienstag_01:

Ich hatte ja meinen Beitrag nochmal editiert: Ausbrechen ist, glaube ich, der falsche Terminus. So stellen sich das viele vor. Aber das Limit setzt der Sensor, nicht die Kurve.

Antwort von WoWu:

Doch nicht so überbelichtet dass man ins clipping kommt. Und warum die Hälfte der Werte mit Nullen gefühlt sein sollen? Das ist doch gar nicht der Punkt. Sondern die vergleichmäßigte Zahl der Luminanzwerte pro Blendenstufen ist der relevanter Punkt.

Wo fängt denn bei Dir Überbelichtung an und wo hört sie auf ?

Du verwechselst Belichtung mit der Lage des Wisspunktes und was die Memge der Abstufungen pro Blendet betrifft.

Natürlich sind die direkt abhängig von der Gesamtmenge der zur Verfügung stehenden Werte denn wenn die gesamte Blendenzahl über nur die Hälfte der Werte verteilt wird, hat zwangsläufig auch nur jede Einzelblende halb so viel Werte.

Ansonsten erklär doch mal genau, wovon Du sprichst und vor allem erklär doch mal, was das Ungenutzt lassen von Übertragungswerten für Vorteile haben soll.

Antwort von Peppermintpost:

klar, das hat wowu ja gerade und auch schon in 1000 anderen beträgen geschrieben, überbelichtet ist überbelichtet, da hilft dann auch x-log nichts mehr. wenn es so belichtet ist das das ganze kleid nur noch eine weisse fläche ist, dann hat man halt verlohren, egal mit welcher kurve es geschrieben wird.

Antwort von rideck:

@ Peppermintpost & Wowu

Was ist denn jetzt die Essenz euerer Diskussion? Ihr habt beide einen Plan, den würde ich sehr gerne verstehen ;) Warum ist X-Log in so vielen Kameras vertreten? Haben sich die Ingenieure da unzureichend Gedanken gemacht? Wir reden ja nicht von C-Log mit 8 Bit, sondern den 10-Bit Varianten, sowie S-Log oder V-Log. Wenn ich in Log richtig belichte, hatte ich bisher immer das Gefühl in der Post noch Spielraum zu haben und nicht andersherum dass ich etwas verschenke?

Noch interessanter finde ich die HDR-Lösung die Atomos da angeblich anbietet. Die erfüllt ja in erster Linie keine gängige Norm. Heisst doch auch was ich dort auf den Monitoren sehe, habe ich nicht in der Post, oder gibt es das spezielle LUTs die mir in der Postproduktion den Atoms-HDR-Look bescheren, dazu müsste natürlich die ganze Verarbeitungskette auf 10-Bit optimiert sein.

Antwort von Peppermintpost:

@rideck

c-log war 10bit weil es in dpx geschrieben wurde das damals auf 10bit begrenzt war und es kein fileformat gab das eine höhere bittiefe speichern konnte. aber das war jetzt nur ein kleine ausflug ins cineon zeitalter ;-)

lassen wir mal die diskussion um die kamera ingenieure beiseite, die wissen schon was sie tuen, aber was in eine moderne kamera eingebaut wird und was nicht ist heute eher eine marketing frage als denn eine technische entscheidung. da haben ingenieure oft wenig einfluss.

das gefühl das du in der post hast, mehr möglichkeiten zu haben ist ja nicht falsch. wenn du x-log drehst must du deine farben in der post verbiegen, anders geht es nicht. und wenn du z.b. das weisse kleid der braut farbkorrigierst, dann kannst du dich vom mittelton bereich aus den highlights nähern und entscheiden wo dein weisswert stehen soll. das ist deine chreative freiheit, die du zweifelsfrei mit diesem workflow hast. da du in den highlights auch verhältnissmässig mehr abstufungen abspeicherst als bei rec709 kannst du u.U die highlights im weis auf 100% setzen und dennoch details auf dem rest des kleides herausarbeiten. soweit so gut. aber der rest deines bildes wird darunter leiden. du hast nämlich nicht mehr die gleiche auflösung im mitteltonbereich wie du sie unter rec709 hast, und mMn auch in den schatten. also vermutlich wirst du beim schwarzen anzug nur noch entscheiden können ist der satt schwarz mit null zeichnung, oder noisy wie bolle, gleichzeitig werden deune hauttöne, oder die wiese im hintergrund leiden. aber dennoch, in so einem fall würde man vermutlich versuchen die braut und ihr kleid maximal gut aussehen zu lassen. da gehts ja jetzt nicht darum technisch das richtige zu tuen, sondern aus einem belichtungs extrem ein subjektiv ansprechendes bild zu machen. also würde ich sagen x-log ist keine pflicht, du könntest das mit sehr präziser belichtung vermutlich auch mit rec709 erreichen, aber x-log ist in so einer extrem anwendung sicher kein fehler.

jetzt nimm aber mal eine "normale" licht situation. da ist dein max highlight vermutlich eine lampe die im bild ist, oder eine sonnen reflektion im autolack, oder reflektionen auf einer wasser oberfläche oder so etwas, die highlights können bedenkenlos ausbrennen, tuen sie auf celluloid ja auch. die sind vom bildinhalt ja nicht wichtig. das liebespaar was vor dem see steht und sich küsst, das ist wichtig, die sind evtl etwas zu dunkel gegen die reflektionen auf dem see. d.h. die farbkorrektur findet bei den aller meisten shots im mitteltonbereich statt. und genau da hast du bei x-log die aller grössten probleme, zum einen weil du von deinen 8 oder 10 bit schon 1 bit verschenkt hast ( und 1bit = halbe information, das ist also dramatisch weniger), zum anderen weil fast alle x-log kurven (abgesehen von c-log) ihre auflösung zugunsten der highlights verschieben. also nochmal weniger info im mitteltonbereich haben.

diese gefühlte grössere freiheit in der post bezieht sich lediglich auf die highlights. unser auge ist natürlich deutlich sensitiver auf luma als auf chroma, daher kommen dir deine möglichkeiten dinge zu ändern enorm vor, aber achte auf deine mitteltöne und schatten, und da hast du fast keine möglichkeiten. ausserdem rec709 ist ja an dem idealpunkt schon viel näher dran, du must es also garnicht so extrem verbiegen wie x-log um ein anständiges ergebnis zu bekommen. rec709 kannst du, wenn du möchtest auch extrem verbiegen, das einzige was mit rec709 nicht geht ist die highlights abzusenken, das wird dann einfach grau und sieht unschön aus, alles andere geht problemlos und deutlich besser als mit x-log.

die kodak burschen waren mit ihrem c-log nicht blöd, die haben nämlich genau das gegenteil gemacht was heute läuft, die haben die daten zugunsten des mitteltonbereich verbogen, aber da reden wir von celluloid zu digital transfer und das ist sowieso ein ganz anderer schnack.

Antwort von wolfgang:

@wowu,

muss man hier dauernd auf Grundlagen der Praxis verweisen? Eine Überbelichtung ist kein clipping sondern jede Verschiebung des 18% Graupunktes zu höheren Luminanzwerten hin. Mit jedem waveform Monitor kann man somit beim Dreh durchaus die Lage des Weisspunktes ausreizen. Und danke, ich weiss schon was der Weisspunkt ist. Und dass jede x-log Kurve im unteren Blendenbereich einen geringen Anstieg hat, und man dort pro Blendenwert eben wenige Luminanzwerte hat weisst du ganz genau. Also wozu das erklären? Man schiebt eben den Luminanzbereich entsprechend bis an die Grenze bevor es zum clipping kommt und justiert sich das in der Postpro entsprechend ein. Ausnahme eben sehr dunkle Motive wo man nur noch Rauschen verstärken würde und das wars auch schon. Dass zB vlog etwa bei 128 erst beginnt und in den untersten 4 Blenden erst bis 192 geht heisst ja, dass diesen 4 (!) Blenden nur 64 Werte zur Verfügung stehen, während bei höheren Blenden dann ca 70 Luminanzwerte pro Blende vorhanden sind. Und das ist es auch schon, wer das verstanden hat wird seinen Luminanzbereich so justieren dass er mehrheitlich im Bereich der oberen Blenden aufzeichnet denn dann hat er gleichmäßig viele Luminanzwerte pro Blende für die Postpro verfügbar. Was eben bei rec709 nicht der Fall ist, wo das viel ungleichmässiger verteilt ist. Das sind aber Grundlagen.

Antwort von wolfgang:

Und damit sind wir bei der Argumentation von Pepper. Na klar sitzt viel von dem zu korrigierenden Werten in den Mitteltönern, typischerweise ja bei Personenaufnahmen etwa Haut. Und klar kann man auch mit rec709 eine gute Belichtung hin bekommen. NUR gehts nicht um das, sondern hier im thread um dem Dynamikumfang. Und mit der ungleichmässigen und nicht linearen Zuweisung der Luminanzwerte wird der Spielraum in der Postpro deutlich kleiner, das Bild so hinzustellen dass ich die Mitteltöner gut abbilde UND die Tief wie Hochtöner. Einfach, weil rec709 mit seine kessen 6 Blenden Dynamikumfang bei den Hoch- und Tieftönern eben viel wenige Luminanzwerte zuweist. Na klar macht das primär Sinn ab 10bit. Aber das ist halt so. Wer also eine hohen Dynamikumfang haben will wird die gleichmässige Verteilung der Luminanzwerte auf die Blendenstufen schätzen. Genau deshalb ist ja auch v-log nicht schlecht und auch s-log3 leichter gradebar als s-log2.

Antwort von WoWu:

Und nun zieh mal bei V-LOG von den 256 Werten noch mal 30% ab, denn das geht etwa bei bei V-LOG ungenutzt durch, dann bist du bei V-LOG von ehemals 8 Bit bei 6Bit gelandet.

Ich könnte jetzt mit Deinem eigenen Argument sagen ... natürlich kann man auch mit 6 Bit schöne Biöder machen, aber ich warte immernoch darauf zu erfahren, welcher Vorteil eigentlich darin liegt, so viele Werte ungenutzt zu lassen und dafür lieber die geringe Restmemge so zu spreizen, dass ich dem Banding immer näher komme.

Selbst wenn man sich die HDR geeignete, bzw extra dafür entwickelte 2086 Kurve mal anschaut, wird da kein einziger Wert ungenutzt gelassen, selbst die, im oberen Endbereich reservierten Werte werden genutzt.

Da muss doch irgendwas dran sein, dass man alle verfügbaren Werte auch nutzt und nicht mit Nullen füllt.

Also, wozu soll ein so eingeschränkter Nutzungsbereich gut sein ?

Über das Ummappen von Mitteltönen ist mir schon der Vorteil klar, nur kann man das auch innerhalb des gesamten Wertebereiches machen und muss dafür nicht oben und unten abschneiden.

Antwort von rideck:

Bei V-Log von 8 auf 6 Bit, lieber Wowu, jetzt komme ich nicht mehr mit. Du hast doch bei der Varicam mindestens ein 10-Bit Signal, bei Full-HD je nach Wahl des Codecs sogar 12-Bit 444, wie in aller Welt kommst Du da auf 6-Bit?

LG

Antwort von WoWu:

Ja, aber Wolfgang vergleicht leider auch 10 Bit mit 8 Bit.

Wenn man schon Vergleiche anstellt, sollten wenigstens die Ausgangsbedingungen gleich sein.

Der 8Bit Vergleich soll nur anschaulich machen, was man hinter der LOG Kurve eigentlich noch an Inhalten hat.

Man kann auch sagen, von den 10 Bit bleiben dann auch nur noch bummelig 8Bit übrig.

Nur kann ich mit diesen 8Bit keinen Vergleich mehr anstellen, weil sie bereits gemapped sind.

Mir geht es nach wie vor nur darum zu Verstehen, welchen Vorteil das Weglassen von reichlich Übertragungswerten haben soll.

Antwort von WoWu:

@wowu,

muss man hier dauernd auf Grundlagen der Praxis verweisen? Eine Überbelichtung ist kein clipping sondern jede Verschiebung des 18% Graupunktes zu höheren Luminanzwerten hin. Mit jedem waveform Monitor kann man somit beim Dreh durchaus die Lage des Weisspunktes ausreizen. Und danke, ich weiss schon was der Weisspunkt ist. Und dass jede x-log Kurve im unteren Blendenbereich einen geringen Anstieg hat, und man dort pro Blendenwert eben wenige Luminanzwerte hat weisst du ganz genau. Also wozu das erklären? Man schiebt eben den Luminanzbereich entsprechend bis an die Grenze bevor es zum clipping kommt und justiert sich das in der Postpro entsprechend ein. Ausnahme eben sehr dunkle Motive wo man nur noch Rauschen verstärken würde und das wars auch schon. Dass zB vlog etwa bei 128 erst beginnt und in den untersten 4 Blenden erst bis 192 geht heisst ja, dass diesen 4 (!) Blenden nur 64 Werte zur Verfügung stehen, während bei höheren Blenden dann ca 70 Luminanzwerte pro Blende vorhanden sind. Und das ist es auch schon, wer das verstanden hat wird seinen Luminanzbereich so justieren dass er mehrheitlich im Bereich der oberen Blenden aufzeichnet denn dann hat er gleichmäßig viele Luminanzwerte pro Blende für die Postpro verfügbar. Was eben bei rec709 nicht der Fall ist, wo das viel ungleichmässiger verteilt ist. Das sind aber Grundlagen.

Habe das leider erst jetzt gesehen .. sorry.

Wenn Du den Grauwert verschiebst, sind weiße Bildinhalte sofort geklippt.

Weil das Verhältnis zu weiß 50% zu 100% erhalten bleibt.

Änderst Du nun die Kurve, dann änderst Du dies Verhältnis, reduzierst aber damit die Wertebereiches pro Blende.

Ein Grund mehr, den gesamten Wertebereich zu nutzen und nicht zusätzlich oben schon bei bummelig 800 aufzuhören. (GH4)

Dass sie Varycam bei 896 bzw. 911 aufhört, ist mir schon klar. Mehr läuft bei 2084 sowieso nicht.

Und dass 2084 sowieso ansonsten keinen Wert ungenutzt lässt, ist ja mein Reden ... hier geht es ja auch um die V-Log Kurve, die so mistig ist.

Antwort von Peppermintpost:

da es ja einige menschen hier im forum gibt die meine erklär bilder mögen,

hier mal was zum thema rec709 vs x-log.

bild 4 ist natürlich kein technisches problem im eigendlichen sinne, aber es ist ein problem das sowohl im profi bis zum amateur bereich ständig zu sehen ist,

egal ob opa karl seinen vorgarten filmt, oder hollywood einen blockbuster herstellt. hab ich in jeder produktions grösse schon gesehen und ist mir auch selbst schon passiert. daher finde ich es wichtig.

bild 1 ist gott gegeben, bzw sony und phillips haben das irgendwann in ihrer unendlichen weisheit beschlossen. da können wir also nicht drüber diskutieren.

bild 5 ist einfach mathematik, da gibts glaub ich auch wenig zu zu sagen.

Antwort von wolfgang:

WoWu, seltsamer weise gelingt es aber in der Praxis recht gut Bildmaterial bei der Aufnahme auch so mit einem Waveform Monitor so in Richtung 100% IRE einzustellen, dass es eben noch nicht clippt. Also die Behauptung dass das Material sofort clippen müsse ist so gesehen in der Praxis nicht relevant.

Und mir ist bewußt dass bei v-log l bei 80% IRE Schluss ist. Nur mit 10bit aufgenommen hat man noch immer viel mehr Werte - etwa die 3-fache Menge - als sie die 8bit Aufzeichnung entsprechen würde. Und das lässt sich mit viel Reserve in 8bit wandeln. So gesehen ist es falsch zu meinen dass da bummelige 8bit übrig blieben.

Und natürlich gehe ich von 10bit aus um derzeit 8bit final auszugeben. Noch haben wir eher wenige 10bit Displays, die kommen erst.

Antwort von wolfgang:

Über Bild 1 lässt sich sehr wohl diskutieren. Und zwar ist hier die Frage relevant, ob diese Motivwahl für eine HDR Diskussion sinnvoll ist. Das ist ja ein Motiv welches sich eben locker im Dynamikumfang von rec709 darstellen lässt. Wähle dir mal ein Motiv wo das eben nicht mehr geht. Etwa eine Innenraumaufnahme wo du ohne gesetztes Licht im Rauminneren noch Personen sehen willst und außen Sonnenlicht hast. Und dann mach den Vergleich.

Antwort von rideck:

Nehmt es mir nicht übel, aber ich habe das Gefühl es wird viel geredet aber noch mehr drum herum geredet. Mag auch daran liegen dass ich euch nur bis zu einem gewissen Level folgen kann. Also Wowu, Du meinst dass das Arri Log ein remapping bei allen Werten vornimmt und bei V-Log passiert das nicht? Und Peppermint hat ein S-Log Bild gepostet!

So wo stehen wir jetzt? Laut Peppermint und dir - korrigiert mich wenn ich falsch liege - existieren im oberen und unteren Bereich bei X-Log keine Farbinformationen? ich dachte immer die Werte müssten nur "entzerrt werden"? Ich möchte gerne verstehen was bei Log passiert und freue mich auf eine Erklärung.

Gruß rideck

Antwort von Peppermintpost:

@rideck

schau doch einfach auf das slog bild von mir und auf den waveform monitor. da siehst du es ja. ich hab es ja auch nochmal eingezeichnet. slog3 nutzt weniger als 50% des wertebereiches. punkt. ende. das ist halb so viel information. da kann man jetzt labern wie sich blenden aufteilen und von hölzken auf stöckchen kommen und was auch immer. halbe information ist einfach ein fakt.

du entzerrst das dann in der farbkorrektur. also du skalierst dein bild so, das es wieder den kompl. wertebereich abdeckt. also 0-1 oder schwarz zu weiss oder 0-1024 wie immer du es ausdrücken willst.

bei dieser scalierung entstehen aber verschiedene probleme. die zwei wichtigsten sind.

1. deine farbabstufung wird deutlich grober. ist auch einfach fakt, weil reine mathematik. da gibt es einfach so garnichts zu diskutieren. 2+3=5. wer das diskutieren möchte gehört einfach auf die couch.

2. die kurve zur entzerrung ist nicht linear. also wenn du mit dem offset das schwarz wieder auf schwarz setzt und mit gain deine weisswerte auf weiss setzt. dann ist das eine lineare entzerrung. so funktioniert slog aber nicht. selbst wenn du am gamma drehst bekommst du es nicht hin. du must eine kurve bauen um es korrekt zu entzerren. diese kurve falls sie korrekt ausgewählt oder eingestellt wurde betont dann nochmal massiv die information in den highlights, also eine auflösung in den mitteltönen die sowieso rechnerisch schon nur noch die hälfte ist, geht noch weiter in den keller. das ist aber schon der idealfall. weil meistens wird zu allem überdruss noch die falsche kurve benutzt, bzw linear entzerrt und dann hat das was du da auf deinem monitor siehst sowieso nichts mehr mit dem original zu tuen.

aber alles geschenkt. sagen wir mal halbe information, falsche farben das ist alles nicht von bedeutung. dann must du am ende sowieso wieder zu rec709, weil sonst funktioniert es mit dem monitor garnicht. du machst einfach einen riesen umweg um am ende das gleiche zu bekommen.

also wer sich weigert in rec709 zu arbeiten kommt sowieso nicht weiter, und muss dann zur malerei umsteigen, weil beim fernsehen ALLES und IMMER rec709 ist. gut für computer ist es srgb was aber fast das gleiche ist, zumindest wenn man es mit irgend einem log oder lin vergleicht.

und die neuen monitore wie eingangs beschrieben, zerren die dynamik einfach noch weiter aus einander. kannst du auch in meinen bildern sehen, mehr dynamik bei gleicher farbtiefe = geringere farbauflösung. ist wieder nur mathematik.

Antwort von WoWu:

An den neuen Monitoren würde ich dann gern noch anknüpfen, weil sich die, zuvor durch das Spreizen der Werte in der Postproduktion entstandenen Bandingwerte mit zunehmender Leuchtdichte der (neuen) Monitore umso sichtbarer werden.

Du brauchst also entweder weniger Banding, oder eine höhere Wertedichte, sprich 10 oder 12 Bit, wobei auch nach der neuen EOTF Banding bei 10 Bit noch ebenso sichtbar ist, wie heute in 709.

Ergo ... bei Verwendung des Materials im HDR Bereich ist es umso wichtiger, von vorn herein auf der maximal möglichen Wertemenge in der Übertragung zu setzen und sich nicht künstlich die paar Werte, die man sowieso nur hat, auch noch (ohne Not) zu nehmen, nur weil so eine Kurve angeboten wird.

Wie gesagt. solche Kurven sind Werkzeuge, wie ein Hammer. Mit dem kann man, um bei dem Beispiel zu bleiben, zwar sinnvoll Nägel einschlagen, man kann aber auch leicht mal daneben hauen und sein Werkstück zerdeppern.

Antwort von rideck:

@ Peppermint und WoWu

so kann ich es nachvollziehen wie ihr es erklärt. Aber wie gesagt, bei 12 Bit 444 habe ich doch auch bei einem LOG-Signal mehr Reserve, selbst wenn ein geringer Wertebereich genutzt wird, sonst könnte ich ja gleich bei 8-Bit 420 bleiben.

Wie verhält sich denn jetzt der Unterschied von Arri C-Log zu S-Log und dem V-Log der Panasonic? WoWu da hast Du ja einen Verstoß gemacht, bist aber auch nicht mehr genauer darauf eingegangen.

Laut deiner Beschreibung Peppermint müsste alles was wir an X-Log-Soße vorgesetzt bekommen schlimm aussehen? Warum dann nicht gleich in einem robusten 10-Bit oder 12 Bit Codec ohne Log filmen, was spricht dagegen?

Danke für die interessante Diskussion und die Beispiele.

Antwort von domain:

Gewisse log-Kurven machen natürlich schon Sinn, bei denen ist die Zielsetzung erkennbar.

Aber in den letzten Jahren möchten Marketingfachleute anscheinend einer Modeerscheinung entsprechen:

wenn der Kunde glaubt, dass ein primär möglichst flaches Bild ein hohes Reservepotential hinsichtlich entwickelbarer Dynamik und Farben hat, na dann liefern wir es ihm doch.

Was kümmern uns physikalische Grenzen des Sensors, die eigentlich in dem zur Verfügung stehenden Wertebereich optimal verpackt werden sollten?

Egal, wir tun alles in eine kleine Schachtel, die in der großen mit viel Luft herumwackeln würde, wenn die Zwischenräume nicht mit Luftpolsterfolie (= viele Nullen) ausgepolstert wären :-)

zum Bild

Antwort von WoWu:

@ Peppermint und WoWu

so kann ich es nachvollziehen wie ihr es erklärt. Aber wie gesagt, bei 12 Bit 444 habe ich doch auch bei einem LOG-Signal mehr Reserve, selbst wenn ein geringer Wertebereich genutzt wird, sonst könnte ich ja gleich bei 8-Bit 420 bleiben.

Warum dann nicht gleich in einem robusten 10-Bit oder 12 Bit Codec ohne Log filmen, was spricht dagegen?

Danke für die interessante Diskussion und die Beispiele.

Gegen eine LOG Funktion, ist im Grunde genommen ja nichts einzuwenden, wenn sie denselben Wertebereich überstreicht, wie eine lineare Funktion.

Dann sitzen die unterschiedlichen Werte eben woanders. Wenn das der Scene angepasst ist, kein Problem.

Ich glaube auch, dass speziell V-Log, das eben diesen Werteverlust, speziell bei der GH4 aufweist eigentlich für die GH4 gar nicht geschaffen ist sondern für die Varicam, bei denen dann lediglich die Werte weggelassen werden, die (genau wie bei 709) am oberen und unteren Ende ausgespart sind.

Varicam benutzt eben die Übertragungsfunktion korrekt, was bei der GH4 dann in der Summe zu einem solch hohen Werteverlust führt.

Um die 10 oder besser 12 Bit kommt sowieso keiner mehr herum, der überhaupt im HDR Feld eine Fuß an den Boden kriegen will, weil sich die höhere Leuchtdichte auf das Bandingverhaöten drastisch auswirkt.

Und, wie ich oben schon angeführt, bei 10 Bit immernoch so schlecht, wie heute bei 8Bit. Erst oberhalb von 11Bit stellt sich das Thema nicht mehr.

Antwort von Peppermintpost:

@rideck

ne es sieht natürlich nicht alles schlimm aus. vieles aus dem hobby/semi-pro bereich sieht tatsächlich schlimm aus, und einiges aus dem pro bereich sieht ebenfalls schlimm aus, ja das stimmt, aber natürlich nicht alles. bei allem x-log gebashe meinerseits, es gibt natürlich auch vorteile.

ganz grundsätzlich ist bild reproduktion ja immer eine anhäufung von kompromissen. perfekt ist kein einziges verfahren. alles auch rec709 hat natürlich nachteile und limitierungen. was wolfgang(nicht wowu) z.b. über die blenden aufteilung im schatten bereich geschrieben hat, das stimmt, da hat er keinen unsinn gelabert und das ist definitiv ein manko. also ich will hier wirklich in keinster weise rec709 schön reden und x-log verteufeln. auch wenn es den anschein hat. x-log und da gibt es ja eine menge verschiedene flavours, hat für den einen oder anderen bereich auch durchaus vorteile, und selbst wenn ich es für eine feld-wald-wiesen aufgabe benutze wo die vorteile garnicht gefragt sind, und es korrekt benutze kann das erbegnis auch einwandfrei aussehen. das möchte ich hier nicht in abrede stellen. wenn ich z.b. ein bild wie oben in meiner grafik gepostet mit 10bit s-log3 aufnehme, und dann korrekt entzerre, dann hab ich am ende ein sauberes 8bit rec709, daran ist nichts falsch. das sieht zweifelsfrei gut aus und den unterschied zu einer 10bit farbauflösung werde ich vermutlich auch auf dem besten monitor nicht sehen können.

also mache ich alles richtig, dann sind meine ergebnisse auch ok.

bei feld-wald-wiesen aufnahmen sind sie aber in beiden fällen ok, ob rec709 gedreht oder x-log gedreht.

so jetzt kommen die zwei punkte die für mich wichtig sind. mehr als 90% dessen was so gedreht wird fällt genau in die kathegorie. d.h. der theoretische vorteil einer spezial anwendung kommt garnicht zum tragen. ich generiere in 90% der fälle nur nachteile, ob sichtbar oder nicht. also x-log als standart zu benutzen ist von haus aus schon mal falsch. falsches werkzeug für den einsatz.

zweiter punkt und der ist für mich absolut wesendlich, "user error" ich hab bei rec709 nur sehr wenig möglichkeiten etwas falsch zu machen. wenn mein blendenring bei der aufnahme richtig eingestellt ist, dann hab ich fast die garantie, das auch am ende alles richtig ist. ich sehe bei der aufnahme am monitor ob es richtig belichtet ist, und am ende auf meinem fernseher sieht es dann auch genau so aus. kann ich vernünftig die belichtung messen ist mein ergebniss ok. egal mit welchem hilfsmittel ich das mache, ob mit einem belichtungsmesser, einem histogramm, zebra oder nur mit dem blick auf den monitor, egal. richtig belichtet, bleibt richtig belichtet. ende.

bei x-log ist das aber anders. ich habe bei den nachfolgenden schritten immer die möglichkeit etwas falsch zu machen, und da der umgang mit x-log auch entsprechend kompliziert ist sind die chancen auch sehr hoch das etwas falsch läuft.

die nachteile die also mit x-log entstehen nehme ich nur in kauf, wenn ich am ende auch etwas bekomme was zu mindest in einem teilbereich besser ist. drehe ich etwas wo ich aber selbst theoretisch keinen vorteil generieren kann, dann ist x-log das falsche werkzeug.

ich bin also nicht grundsätzlich gegen x-log, sondern ich bin dagegen x-log als standart tool für jeden einsatz zu deklarieren. weil das einfach kompletter schwachsinn ist. wenn z.b. ein astro filmer sagt ohne x-log brauche ich garnicht anzufangen, das ist mein standart für alles, dann kann das durchaus seine berechtigung haben (keine ahnung, ich kenne mich mit astro nicht aus) aber für normale tv/spielfilm/doku/etc anwendung kann es nicht das standart tool sein.

hier schau mal:

das ist einer meiner lieblingsfilme von meinem lieblings kameramann. die szene könnte man durchaus x-log drehen, dann könnte man im grading evtl noch die wolken draussen sichtbar machen. wäre die szene darurch in irgend einer form besser? ne, zweifelsfrei nicht. und das ist schon genau so ein beispiel wo x-log seine stärken ausspeilen würde.

ich gewinne einfach nichts und handele mir eine menge probleme und mögliche fehlerquellen ein. ich persöhnlich finde es einfach spannender sich einfach nur mal mit einem belichtungsmesser auseinander zu setzen. macht im zweifelsfall die besseren bilder.

Antwort von srone:

ich persöhnlich finde es einfach spannender sich einfach nur mal mit einem belichtungsmesser auseinander zu setzen. macht im zweifelsfall die besseren bilder.

wenn es nur nicht so schwierig wäre, was stelle ich da ein und was kommt da raus? x-log ist doch viel cooler, habe ich gehört. :-)

leute lernt die basics, dann müssten wir hier nullkommanull, sinnlos, im kreis, diskutieren. ;-)

lg

srone

Antwort von wolfgang:

halbe information ist einfach ein fakt.

Du scheinst mit deiner Laberei auch nicht den Punkt der Sache verstehen zu wollen oder zu können: was um Himmels willen soll ein Bild zeigen dessen Dynamikumfang so klein ist dass man weder HDR noch x-log benötigt? Das fragt man sich schon was du mit so einem Beispiel in einer Diskussion, wo es um HDR geht, eigentlich zeigen willst.

Dass rec709 in bestimmten Aufnahmesituationen seinen Vorteil hat ist gar keine Frage - ich sagte bereits im lowlight Bereich, wo jede Art von x-log zur Katastrophe wird. ABER wenn das abzubildende Motiv den höheren Dynamikumfang benötigt, dann ist man halt mit den 6 Blenden von rec709 schnell am Ende. Entweder bildest dann nämlich die Höhen oder die Tiefen ab - und der jeweils andere Teil sauft entweder ins Schwarz ab oder wird geclippt.

Und vielleicht stimmen die 90% für dich - für mich ist das nicht richtig. Ich habe viel mehr Situation wo ich den Dynamikumfang sehr schätzen gelernt habe.

Ich glaube auch, dass speziell V-Log, das eben diesen Werteverlust, speziell bei der GH4 aufweist eigentlich für die GH4 gar nicht geschaffen ist sondern für die Varicam, bei denen dann lediglich die Werte weggelassen werden, die (genau wie bei 709) am oberen und unteren Ende ausgespart sind.

Varicam benutzt eben die Übertragungsfunktion korrekt, was bei der GH4 dann in der Summe zu einem solch hohen Werteverlust führt.

Der "Glaube" ist insofern richtig als v-log l exakt die gleiche Kurve nutzt wie die Varicam. Nur liegt das am Sensor der GH4 der eben nur 12 Blendenstufen kann. Und natürlich benutzt die GH4 die verbaute Übertragungsfunktion korrekt - das geht ja gar nicht anders.

Klar wäre eine Varicam besser - aber bitte dann vergleiche man auch mal die Preise dieser Geräte und was die verbauten Sensoren können.

Ob es für die GH4 Nutzer besser gewesen wäre, wenn Panasonic für die GH4 eine Art v-log2 Kurve zu generiert hätte die den vollen Luminanzbereich abdeckt - na klar wäre das besser gewesen. Aber das haben sie halt nicht getan. Offenbar weil man mit der Varicam kompatibel bleiben wollte, was für die meisten GH4 Anwender ziemlich absurd ist (weil die haben meist keine Varicam, und wer eine Varicam hat nimmt wohl sehr selten eine GH4).

Die Konsequenz ist dass man sich hüten sollte, an das GH4 intern aufgezeichnete 8bit Material hier hohe Erwartungen zu stellen. Nur das ist ja auch allgemein bekannt.

Nur solange das Zielformat 8bit ist, und man mit 10bit aufzeichnet ist dieser Datenverlust unbedeutend weil man mit den über 600 Luminanzwerten der 10bit Auflösung klar über den 235 Werten des 8bit Bereich bleibt. Das sieht man in der Praxis mit der GH4 und Shogun Kombination durchaus - denn man hat eben sehr wohl die 3-Fache Datenmenge verfügbar die man tatsächlich benötigt.

Insofern sind auch hier die Argumente der halben Daten für die derzeitigen Monitore eher absurd. Das wird sich natürlich ändern wenn tatsächlich die UHD-Geräte mit 10bit Panelen am Markt sind und eine Mehrheit beginnt für eine spätere 10bit Präsentation zu drehen. Vorher aber ist das recht irrelevant.

Antwort von Peppermintpost:

Und vielleicht stimmen die 90% für dich - für mich ist das nicht richtig. Ich habe viel mehr Situation wo ich den Dynamikumfang sehr schätzen gelernt habe.

ja klar, das ist ja das argument von allen die nicht richtig belichten können. vor ein paar jahren gab es die möglichkeit von x-log noch garnicht. ich kann beim besten willen nicht sehen was in den letzten jahren besser geworden ist. ich sehe nur eine deutlich angestiegene zahl von farblich vergurkten filmen.

kannst ja mal "most iconic movie scenes" googeln und mir mal ein einziges beispiel zeigen was in hdr besser wäre. bin sehr gespannt.

aber klar, so ein scheiss lässt sich natürlich nicht damit vergleichen wenn jemand die rosen im garten filmt, da braucht es auf jeden fall hdr, x-log, 8k, und einen 192punkt autofocus, sonst geht garnichts. hab ich verstanden.

Antwort von dienstag_01:

Ich habe viel mehr Situation wo ich den Dynamikumfang sehr schätzen gelernt habe.

Wo hat man denn bei log mehr Dynamikumfang?!

Das schreiben doch nur Leute, die nicht im mindesten den Waveform Monitor verstehen. Man bekommt maximal mehr Werte im hellen Bereich, aber nicht mehr Dynamik. Junge, Junge ;)

Antwort von wolfgang:

Junge Junge, wenn du nicht weißt warum die ganze Welt auf der NAB das Thema HDR in den Mittelpunkt gestellt hat, dann ist dir auch nicht zu helfen. Das schreiben doch nur Leute die keinerlei Ahnung von der Sache haben, und schon der falsche Hinweis auf den waveform Monitor zeigt überdeutlich dass du mit x-log offenbar keine Erfahrung hast. Denn nur weil Signale zwischen 0 und 100 IRE sind sagt das eben nichts über die dahinter liegende Übertragungsfunktion aus, und auch nicht wie viele Blendenstufen im Material unter gebracht werden können. Dass es bei rec709 nur 6 Stufen sind hast schon mal gehört?

Und nur weil man die Möglichkeiten von x-log nutzt ist der Rückschluss der dass all diese Leute nicht richtig belichten können oder ja "nur" Rosen im Garten filmen? Aber man kann das ja auf raw Filmer ausdehnen - die nach dieser Logik dann gar nicht mehr belichten können, weil die alles in der Post machen! ;)

Belegen kannst solche abwertende Thesen nicht, das sind alles nur reine Vorurteile und irgendein Bedürfnis/Groll unschuldige Blumenfilmer abwerten zu müssen. Schon interessant.

Antwort von dienstag_01:

Junge Junge, wenn du nicht weißt warum die ganze Welt auf der NAB das Thema HDR in den Mittelpunkt gestellt hat, dann ist dir auch nicht zu helfen.

Und vielleicht stimmen die 90% für dich - für mich ist das nicht richtig. Ich habe viel mehr Situation wo ich den Dynamikumfang sehr schätzen gelernt habe.

Ich bewundere dich, ehrlich. Du scheinst so ne Art Betatester für HDR Bildschirme auf der NAB zu sein. Oder meinst du mit *schätzen gelernt* wirklich schätzen, so Pi mal Daumen ;)

Von Blumen hatte ich übrigens nichts geschrieben, da du aber sowieso alles mit allem vermischst, ist das letztlich auch egal.

Antwort von Uwe:

...

Wo hat man denn bei log mehr Dynamikumfang?!

...

Könnte in diesem Zusammenhang interessant sein zu lesen:

http://blog.abelcine.com/2013/01/18/son ... rcentages/

Antwort von dienstag_01:

Ja, interessant, eine Dynamics Range von 800%.

Ich verstehe es jedenfalls nicht ;)

Antwort von cantsin:

Es geht nicht darum, dass Logfunktionen "mehr" Dynamik realisieren, sondern dass konventionelle Übertragungsfunktionen wie Rec709 den vom Sensor zur Verfügung gestellten Dynamikumfang beschneiden. (Was sich einfach mit jeder Kamera nachprüfen lässt, die sich zwischen Rec709 und Log umschalten lässt und Zebras für Über- und Unterbelichtung anzeigt.)

Antwort von dienstag_01:

sondern dass konventionelle Übertragungsfunktionen wie Rec709 den vom Sensor zur Verfügung gestellten Dynamikumfang beschneiden.

Und warum tun sie das?

Antwort von Uwe:

...

Und warum tun sie das?

Rec709 wurde zu einer Zeit entwickelt in der die Kameras nur ca. 5 Blendenstufen an Dynamikumfang liefern konnten. Damals war es also vollkommen ausreichend...

Dieser Artikel gibt darüber Auskunft:

http://www.provideocoalition.com/alexa_ ... ou_use_it/

Antwort von dienstag_01:

Danke für den Link, schau ich mir mal in Ruhe an.

Die Begründung:

Rec709 wurde zu einer Zeit entwickelt in der die Kameras nur ca. 5 Blendenstufen an Dynamikumfang liefern konnten. Damals war es also vollkommen ausreichend...

halte ich aber erstmal für mehr als fragwürdig, gilt Rec709 doch auch für Content, der von anderen Recording Systems als Digitalcameras nach Broadcast kommt. Analoges Filmmaterial hatte weit mehr Stops.

Es KÖNNTE also mit den Wiedergabegeräten zu tun haben.

Antwort von Peppermintpost:

als 1990 rec709 entwickelt wurde war die arriflex35III aktuell. nachfolger war die arri435. beide kameras können deutlich über 5 blenden. die monitore allerdings nicht.

Antwort von cantsin:

halte ich aber erstmal für mehr als fragwürdig, gilt Rec709 doch auch für Content, der von anderen Recording Systems als Digitalcameras nach Broadcast kommt. Analoges Filmmaterial hatte weit mehr Stops.

Es KÖNNTE also mit den Wiedergabegeräten zu tun haben.

Du musst immer den Unterschied zwischen Aufnahme-Dynamik und Wiedergabe-Dynamik machen. Ich kann ein Motiv mit einem Kontrastumfang von 11 Blenden (vom Baumschatten bis zum strahlenden Himmel) problemlos auf einem Display mit 6 Blenden wiedergeben, ohne dass Schatten absaufen und Spitzlichter ausbrennen, wenn ich den Dynamikumfang in der Post entsprechend komprimiere.

Genauso funktioniert das auch bei Audiosignalen - anders wäre es nie möglich gewesen, eine Orchesteraufnahme von Pianissimo bis Fortissimo auf LP zu pressen oder im Kofferradio zu hören. Dafür braucht man Mikrofone, die die komplette Dynamik aufzeichnen, und eine Abmischung, die die leisen Stellen entsprechend anhebt und die lauten absenkt, so, wie das Tontechniker tagtäglich machen.

Mit Log und Rec709 verhält es sich eben genauso. Rec709 ist die Abmischung. Wenn man es aber als Kamera-Aufnahmeformat hat, ist das wie ein Mikrofon, bei dem pianissimo im Rauschen untergeht und Fortissimo übersteuert.

Antwort von Uwe:

als 1990 rec709 entwickelt wurde war die arriflex35III aktuell. nachfolger war die arri435. beide kameras können deutlich über 5 blenden.

Ich hab"s, wie gesagt, aus diesem Artikel:

The important thing to remember about Rec 709 is that it was created at a time when cameras could deliver only about five stops of dynamic range–so that’s all Rec 709 is designed to hold. And it’s rare to find a modern camera with a true Rec 709 curve in it, because there’s not a single camera out there that only delivers five stops of dynamic range. Instead, manufacturers create curves that look good in a Rec 709 environment, in spite of the fact that the cameras capture more dynamic range than Rec 709 is supposed to hold.

The trick has become cramming 10+ stops of dynamic range into a small five stop "bit bucket" in such a way that it still looks good. As you’ve probably noticed from the image above, Alexa does this by applying quite a strong S-curve to the gamma, stretching out the mid-tones so they are nice and contrasty while compressing the highlights and shadows much the same way film does.

Antwort von Rudolf Max:

@: beide kameras können deutlich über 5 blenden. die monitore allerdings nicht...

Was soll denn das...? Eine analoge Filmkamera, die mit Film geladen wurde, kannte doch keine Belichtungsdynamik... dümmlicherweise heute nur noch als x- Stops bekannt...

Da war damals nur das Filmmaterial dafür zuständig... und die Entwicklung des Films insbesonders...

Aber, aber...

Antwort von Jott:

Du musst immer den Unterschied zwischen Aufnahme-Dynamik und Wiedergabe-Dynamik machen. Ich kann ein Motiv mit einem Kontrastumfang von 11 Blenden (vom Baumschatten bis zum strahlenden Himmel) problemlos auf einem Display mit 6 Blenden wiedergeben, ohne dass Schatten absaufen und Spitzlichter ausbrennen, wenn ich den Dynamikumfang in der Post entsprechend komprimiere.

Genauso funktioniert das auch bei Audiosignalen - anders wäre es nie möglich gewesen, eine Orchesteraufnahme von Pianissimo bis Fortissimo auf LP zu pressen oder im Kofferradio zu hören. Dafür braucht man Mikrofone, die die komplette Dynamik aufzeichnen, und eine Abmischung, die die leisen Stellen entsprechend anhebt und die lauten absenkt, so, wie das Tontechniker tagtäglich machen.

Endlich mal schwurbelfrei erklärt.

Antwort von dienstag_01:

Endlich mal schwurbelfrei erklärt.

Findest du.

Aber eigentlich ist es totaler Quatsch ;)

Die Dynamic eines Orchesters wird durch MEHRERE Mikrofone erfasst, nicht durch eins.

Wir reden hier aber von EINER Kamera.

Und wir reden (eigentlich) davon, wieso Log mehr Dynamic haben soll, als 709 (wo doch der Sensor begrenzt, und nicht die Kurve).

Aber wenn ich den Link oben richtig überflogen habe, kann man im oberen und unteren Bereich noch Lumaunterschiede (Stops) wahrnehmen, die in 709 schon eher zu einem einzelnen Lumawert werden. Deshalb sprechen sie von höherer Dynamic Range. Aber dass man damit irgendwas Helleres aufnehmen könnte (Dynamic Range in der aufgenommenen Szene, wie Cantsin schreibt) ist Unfug. Die wird vom Sensor vorgegeben.

Antwort von cantsin:

Aber eigentlich ist es totaler Quatsch ;)

Die Dynamic eines Orchesters wird durch MEHRERE Mikrofone erfasst, nicht durch eins. Wir reden hier aber von EINER Kamera.

Es ist kein Quatsch, wenn Du mal einfach einen Vergleich als einen Vergleich akzeptieren kannst (und übrigens hatte ich "Mikrofone" geschrieben, im Plural). Übrigens haben auch Kameras wie Blackmagic und Arri Alexa "mehrere Mikrofone" durch Dual Gain-Sensoren, siehe den Titel dieses Threads.

Und wir reden (eigentlich) davon, wieso Log mehr Dynamic haben soll, als 709 (wo doch der Sensor begrenzt, und nicht die Kurve).

Nein, die Dynamik, die bei Dir ankommt, ist eine Kombination dessen, was der Sensor liefert und was die Kurve davon noch übrig lässt.

Aber dass man damit irgendwas Helleres aufnehmen könnte (Dynamic Range in der aufgenommenen Szene, wie Cantsin schreibt) ist Unfug. Die wird vom Sensor vorgegeben.

Das habe ich auch nicht geschrieben. Aber offenbar hat es auch keinen Sinn mit Dir zu diskutieren oder Dir auch irgendwie helfen zu wollen. Mein Güte.

Antwort von dienstag_01:

Aber dass man damit irgendwas Helleres aufnehmen könnte (Dynamic Range in der aufgenommenen Szene, wie Cantsin schreibt) ist Unfug. Die wird vom Sensor vorgegeben.

Das habe ich auch nicht geschrieben.

Doch. Nur so macht dein Audiovergleich und deine Trennung von Aufnahme- und Wiedergabebereich überhaupt Sinn.

Aber du kannst dich natürlich hier erklären.

Interessanter finde ich ja den Arri-Artikel. Wie man sieht, werden bei C-Log und 709 bei 800 ISO jeweils 15 Stops Dynamic Range (Aufnahme) erreicht. Die Wiedergabe zeigt uns aber weniger (bei 709), weil man schon 2, 3 Stops vorher eigentlich nur noch Weiss bzw. Schwarz hat (sieht). Die Stops sind also weniger *getrennt*.

So kann ich das verstehen.

Und so ist es auch ;)

Edit: Mit Log Kurven kann ich die *nicht getrennten* Stops so zuordnen, dass sie sichtbar sind. Macht Sinn. Warum dann aber manche Log Kurve den gesamten Wertebereich gleich mit beschneidet, verstehe wer will (mehrmals wiederholte Frage von WoWu und Peppermintpost)

Antwort von Rudolf Max:

Hallo,

Ich habe nun im Laufe der letzten Tage den ganzen Thread mitgelesen und frage mich, was ich nun an Nutzen davon habe...

Gelernt habe ich zwar einiges, hauptsächlich dies, dass es keine schlaue Antwort gibt und letztlich doch jeder das macht, was ihm persönlich gefällt...

Mein Resumé ist also folgendes: Ich bleibe unbedingt bei meiner momentanen Hardware... und renne nicht schon wieder hinter irgend einer Neuerung her...

Rudolf

Antwort von WoWu:

Da werden mal wieder munter ein paar Dinge durcheinander gewürfelt und Dynamikumfang mit Bilddynamik gleichgesetzt und Artikel nicht richtig gelesen.

Der Artikel sagt nur, dass damals, als REC709 entwickelt wurde, Kameras keinen größeren Dynamikumfang als 5 Blenden hatten und dies zur Mindestanforderung wurde.

In Wirklichkeit wurde 709 bereits 1989 für 9 Blenden ausgelegt, dabei waren 2 Blenden bereits für den damals zugrundeliegenden Störabstand von 50db abgezogen. Nach heutigen Verständnis werden die ja sogar mitgezählt.

Das wären dann 11 Blenden mit Rauschen.

Es hat dann kurz darauf noch einen Appendix gegeben, der die Quantisierung im oberen Bereich ändert und so 2 weitere Blenden innerhalb von Rec709 zulässt.

Wer bei REC 709 von 5 Blenden spricht, verwechselt das mit Film von damals, der durch den Entwicklungsprozess nur auf 6-7 Blenden kam.

Aber durcheinander gewürfelt wird auch immer wieder Dynamik Umfang und Bilddynamik.

Den Dynamikumfang bestimmt der Sensor.

Dabei ist es auch Wurscht, in wieviele Übertragungsschritte das gepackt wird.

Die Bilddynamik hingegen, also wieviele unterschiedliche Grauwerte übertragen werden, wird durch die Übertragungsfunktion beeinflusst.

Wähle ich eine flache Kurve, kann ich quasi beliebig viele Blenden unterbringen, nur verliere ich dabei immer mehr Übertragungsschritte pro Blende.

Das kann ich also nur solange machen, bis ich nur noch Banding habe und jede Blende an der Kante erkenne.

Beschneide ich mir als meine Wertemenge, kriege ich nach wie vor noch dieselbe Anzahl Blenden unter, nur eben mit angehobenen Banding.

WIe Pepper schon sagt, bei Rosen im Garten, fällt das wahrscheinlich nicht auf.

Nur ändert das nichts daran, dass es keinen Grund gibt, Übtragungswerte nicht zu nutzen.

Übrigens wird das Problem bei HDR entsprechend heftiger, denn durch die höhere Leuchtkraft der Displays, wird auch Banding wieder zum Problem.

Ansonsten hat ändert sich am eigentlichen Bild überhaupt nichts, nur dass es mindestens 10 Bit hat.

Wenn man sich mal die die beiden Ünertragungsfunktionem 709(10Bit) und 2086 ansieht, liegen die im Display fast parallel denn das Systemweiss der Kamera führt immer dazu, dass das Display den hellsten Wert einstellt.

Solange Systemweiss der Kamera in beiden Ünertragungsfunktionem denselben Wert (bei 10Bit 940) solange kann der Monitor gar keine andere Leuchtdichte erzeugen.

Der einzige Unterschied in der Produktion besteht darin, dass man jetzt die Spitzenbelichtung auf den obersten Wert legt, also Reflektionen und Spitzlichter, dann im Monitor die Leuchtdichte gegenüber den alten Monitoren höher eingestellt ist sodass ein identischer Bildeindruck entsteht, dafür aber die Spitzlichter brilliant und klar mit hoher Leuchtdichte abstrahlen.

Mehr hat das mit HDR nicht auf sich.

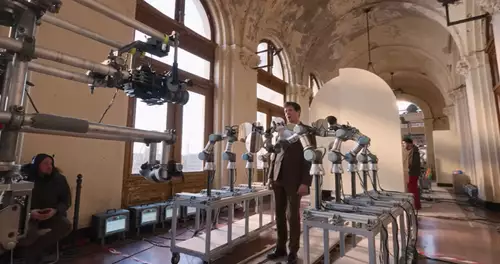

Antwort von Starshine Pictures:

Ich bin gerade dran mir diesen riesigen Artikel zum Thema HDR, Resolve und Grading durch zu lesen. Dieser Colorist hat eigentlich alles aufgeschrieben was es dazu zu sagen gibt. Falls wer tieferes Interesse hat, bitteschön!

http://vanhurkman.com/wordpress/?p=3548

zum Bild

Rechts normales Display mit max. 100 nits, links dagegen das HDR Display mit maximal 4000 nits Helligkeit (Rückprojektionsdisplay von JVC)

zum Bild

Links HDR Display, rechts 709 der selben Szene (oben)

Grüsse, Stephan von Starshine Pictures

Antwort von Skeptiker:

Ich bin gerade dran mir diesen riesigen Artikel zum Thema HDR, Resolve und Grading durch zu lesen. ...

Ich verstehe ja (noch) nichts von der Sache, aber habe ihn vorsichtshalber heruntergeladen - man weiss ja nie ...

Danke! ;-)

Antwort von WoWu:

Hallo Stephan,

danke für den Link aber es sind keine wirklichen Neuigkeiten, zumal auch nirgend zu ersehen ist, ob sein 709 die 10Bit Version war zumal er immer von Broadcast Version gesprochen hat.

Solche Vergleiche hinken dann natürlich schon im Ansatz.

Inhaltlich wesentlich interessanter war der Link im Nachtrag des Artikels, der Aufschluss darüber gibt, wieviele Monitoren welche Energie abstrahlen ...

Das bedeutet letztlich, dass man die ganzen 100 Nits eigentlich schon vergessen kann, weil es kaum mehr Monitore gibt, die nicht mehr als 100 Nits machen.

Berücksichtigt man dann noch die geringe Menge der Bildinhalte, die ohnehin in den Bereichen darüber liegen, wird der Abstand zu Her immer irrelevanten.

Bedenkt man nun, dass LCDs (variieren ).. von ein wenig größer als 709 bis hin zu 90 % des 2020-Farbraums unter Verwendung von Quantenpunkten darstellen und P3 sich ohnehin im Wesentlichen nur in Farben ausserhalb des natürlichen Sichtbereiches unterscheiden ... und davon nur 93 %, dann ist man schnell im Thema der Farbraumconversion und dessen negative Folgen.

Solange für die Geräte nur "größer als 709" gilt und nicht P3 als Minimum oder die "Voll 2020 Compliance" ist das sehr enttäuschend.

Insofern war der verlinkte Artikel nicht weiter erhellend und eigentlich eine Zusammenfassung dessen, was man so mainstream zu lesen bekommt.

Und dass solche Geräte heller sind, als Normalgeräte, dazu braucht man keine Fotos, zumal daraus auch nicht hervorgeht, wie die Bildeinstellungen eigentlich normalisiert wurde.

Ausserdem hat der "Kollege" die Monitore auch noch seitlich fotografiert, wo dann... selbst schon bei einem Monitor der Winkel "in die Suppe spuckt".

Und wenn ich dann noch sehe, dass auf dem "100 Nits TV" die Wolken wesentlich besser durchgezeichnet sind las auf der 4000 NITs Rückprojektion, dann fällt mir dazu schon gar nichts mehr ein.

Das und noch einige andere Kleinigkeiten sind sicher geeignet, keine soliden Erkenntnisse daraus gewinnen zu können.

Das ist immer das Problem solcher Blogtests.

Antwort von rideck:

@ WoWu

Da werden mal wieder munter ein paar Dinge durcheinander gewürfelt und Dynamikumfang mit Bilddynamik gleichgesetzt und Artikel nicht richtig gelesen.

Der Artikel sagt nur, dass damals, als REC709 entwickelt wurde, Kameras keinen größeren Dynamikumfang als 5 Blenden hatten und dies zur Mindestanforderung wurde.

In Wirklichkeit wurde 709 bereits 1989 für 9 Blenden ausgelegt, dabei waren 2 Blenden bereits für den damals zugrundeliegenden Störabstand von 50db abgezogen. Nach heutigen Verständnis werden die ja sogar mitgezählt.

Das wären dann 11 Blenden mit Rauschen.

Es hat dann kurz darauf noch einen Appendix gegeben, der die Quantisierung im oberen Bereich ändert und so 2 weitere Blenden innerhalb von Rec709 zulässt.

Wer bei REC 709 von 5 Blenden spricht, verwechselt das mit Film von damals, der durch den Entwicklungsprozess nur auf 6-7 Blenden kam.

Und wieviele Blenden sind es nun? Genau das meine ich. Ein paar Leute haben hier überdurchschnittliches Wissen in einigen Bereichen, Du zählst sicher auch dazu. Aber warum dann immer alles so ausdrücken dass es deutbar ist, sich bloß nicht festlegen. Ich finde deinen Exkurs sehr interessant, aber dann schreibe doch am Schluß ein Fazit darunter, wieviel Blenden wir nun bei der REC709 nutzen können ;)

Gruß rideck

Antwort von WoWu:

Je nachdem, wie Du zählst.

Wenn Du so wie Marketing zählst, sind es 11 Blenden, aber real sind es 9 Blenden und wenn Deine Kamera einen deutlich besseren Störabstand als 50 dB hat, werden es wieder mehr.

Aber hier legst Du jetzt irgendwie zwei Thresds zusammen, wenn ich das richtig sehe, denn das 709 Proböem stammt doch aus einem andern Thread, wenn ich das richtig sehe ?

Antwort von rideck:

Könnte man meinen ;) ist aber aus diesem Thread, ca. 5 Posts weiter oben. Danke für die Antwort.

Antwort von WoWu:

Jau, tatsächlich... hmm.

Antwort von wolfgang:

...

Wo hat man denn bei log mehr Dynamikumfang?!

...

Könnte in diesem Zusammenhang interessant sein zu lesen:

http://blog.abelcine.com/2013/01/18/son ... rcentages/

Nur ob der Dienstag das gelesen hat und verstehen hat wollen, ist halt die gute Frage. Denn

Es KÖNNTE also mit den Wiedergabegeräten zu tun haben.

das ist nur die halbe Antwort. Ja es hat mit den Wiedergabegeräten zu tun. Aber es hat auch damit zu tun ob ich bei der Aufnahme überhaupt den Dynamikumfang erhalten kann, und ob das auch beim Graden gelingt.

Denn das hier

Ich bin gerade dran mir diesen riesigen Artikel zum Thema HDR, Resolve und Grading durch zu lesen. Dieser Colorist hat eigentlich alles aufgeschrieben was es dazu zu sagen gibt. Falls wer tieferes Interesse hat, bitteschön!

http://vanhurkman.com/wordpress/?p=3548

ist in Wirklichkeit der interessanteste Link der ganzen Diskussion. Vanhurman zeit was sich mit highend Equpiment heute beginnt abzuzeichnen. Natürlich graded der nicht im herkömmlichen Bereich den klassische Waveform-Darstellungen abdecken, sondern weit darüber hinaus. Für HDR-Monitore die es teilweise noch gar nicht am offenen Markt gibt.

Ich kann gut nachvollziehen warum dem Thema so enorm viel Skepsis gegenüber gebracht wird. Denn wer hier hat schon dieses Equipment welches Hurkman hier anführt und welches ihm zur Verfügungsteht? Wir pressen ja wirklich derzeit nur den hohen Dynamikumfang in das was die heutigen Monitore halt so können.

Dazu kommt dass halt einige immer Dinge ablehnen, die so neu und fremd sind dass sie sich bedroht fühlen. Ist ja menschlich.

Antwort von WoWu:

Das kommt mir so ein bisschen vor, wie das, was IASI auch immer sagt, nämlich dass es zukünftig Geräte geben wird, die alles viel besser und jenseits der physikalischen Gesetzmäßigkeiten darstellen werden.

Was wird sich denn Deiner Meinung nach am "Kernbild des Vodeos" ändern.