Wir hatten bereits einen Blick in die Glaskugel gewagt, wohin sich Kameras und damit verbundene Produktionsweise in diesem Jahrzehnt bewegen könnten. Doch eine News, die damit verbundenen Kommentare sowie der kurzfristige Ausfall von einem anderen Artikel ;) haben uns veranlasst, auch mal einen Blick in die Zukunft des Editings und des Compositings zu werfen.

Die Hardware

Tatsächlich sehen wir das gesteigerte Leistungs-Wachstum der x86-CPUs durch den wiedererstarkten Intel Konkurrenten AMD als KEINEN Treiber neuer Videoschnitt-Möglichkeiten. Für die aktuellen Aufgaben bei Schnitt- und die meisten Compositing-Einsätze reichen 8 schnelle CPU-Kerne in der Regel völlig aus. Ob dies X86- oder ARM-Kerne sind, wird in diesem Jahrzehnt für die Videobearbeitung ziemlich egal sein, solange das genutzte Programm auf der gewünschten Plattform läuft.

Die allermeisten Video-Effekte wurden in den letzten Jahren auf die GPU optimiert, weshalb sich hier mit neuer Hardware weitaus mehr Leistungsplus erzielen lassen wird.

Wir gehen zudem stark davon aus, dass viele zukünftige Effekte KI-basiert arbeiten werden. Auch in den nächsten Jahren werden KI-Algorithmen weiterhin auf GPUs deutlich schneller laufen, als auf CPUs.

Bei der KI-Beschleunigung zeichnen sich jedoch in unseren Augen noch zwei weitere Trends für die nächsten Jahre ab:

Es wird eine Form universeller KI-Beschleunigung auch in CPU-Hardware integriert werden. Ähnlich den Tensor-Cores von Nvidia wird man diesen speziellen Matrizen-Multiplizierern von Generation zu Generation mehr Chipfläche gönnen.

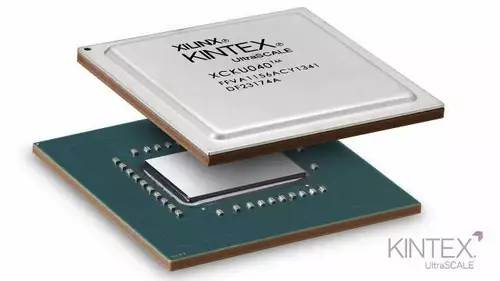

Potente GPUs werden für universelle KI-Aufgaben dennoch weiterhin deutlich leistungsfähiger bleiben. Diese könnten jedoch von sogenannten FPGA-Speziallösungen signifikant übertroffen werden. Bei FPGAs handelt es sich quasi um programmierbare Hardware, die einmal programmierte Effekte oder KI-Modelle noch einmal deutlich effizienter (und damit ggf. auch schneller) abarbeiten kann.

Allerdings gibt es unseres Wissens aktuell keinen Software-Hersteller im Videobereich, der an einem FPGA-Beschleuniger-Board arbeitet. Wir hatten bisher Apple ein wenig in Verdacht, aber um die Afterburner Accelerator Karte für den Mac Pro ist es recht still geblieben. Mehr als beschleunigtes Decoding von ProRes und ProRES RAW ist damit bislang nicht möglich, obwohl in der Karte ein potenter FPGA sitzt.

Ebenfalls unter Generalverdacht für ein FPGA-Beschleuniger Board steht in unseren Augen Blackmagic, die als Hardware-Hersteller vieler Gadgets mit FPGA-Komponenten eine Menge Know-How hierfür im Unternehmen haben.

Grundsätzlich bleibt es jedoch fraglich, ob der Markt überhaupt groß genug ist, um eine solche Lösung zu entwickeln. Aufgrund der geringen Stückzahlen dürften es solche Karten gegenüber GPUs preislich sehr schwer haben. Zudem ist der Entwicklungsaufwand von FPGA IP nicht zu unterschätzen.

Den GPUs selbst steht dagegen in den nächsten Jahren wahrscheinlich noch ein deutlicher Leistungssprung hervor. Patente und Gerüchte von AMD und Nvidia lassen darauf schließen, dass die "Multi-GPU Hurdle" letztlich doch geknackt wird. In den letzten Jahrzehnten fiel es den beiden führenden Herstellern sichtlich schwer, mehrere GPUs parallel in einem Rechner einsetzbar zu machen. Sämtliche bisherigen Versuche wie SLI oder Crossfire sind mittlerweile praktisch wieder komplett von der Bildfläche verschwunden. Nun scheinen AMD und NVIDIA gerüchteweise in den nächsten Generationen jedoch mehrere Dies auf einem Chip einsetzen zu wollen, was dafür spricht, dass hier noch kein Moorsches Ende der GPU-Leistungsstange in Sicht ist. Wir denken daher, dass die Videoeffekt-Beschleunigung der nächsten Jahre weiterhin primär auf GPU-Technologie basieren wird.

Die Software

Wir gehen schwer davon aus, dass wir schon in den nächsten Jahren Anwender-Software zu kaufen (oder mieten) bekommen, die Informationen über die Szenerie eines Clips besser gewinnen und auswerten kann.

Ob aus Bewegungs-Metadaten oder selber mit KI zusammengereimt: Die Software wird explizit Objekte erkennen können, die in einer Szene auftauchen. Das Revolutionäre wird somit in der Objekt-Selektion bestehen. Man wird Objekte einfach mit der Maus auswählen und modifizieren können. Also beispielsweise einen Stuhl aus der Szenerie zu entfernen oder eine Inschrift zu ändern, wird plötzlich ganz intuitiv funktionieren, ohne dass der Anwender irgendwelche Retusche-Fähigkeiten einbringen muss.

Selbiges wird auch mit anderen "Problemen" möglich sein. Also einen Pickel zu entfernen oder die Farbe eines Autos zu ändern wird mit 2-3 intuitiven Klicks zu erledigen sein. Die Farbkorrektur wird wahrscheinlich durch generelle Looks ersetzt. Im Gegensatz zu heutigen Look-LUTs wird diese Farbkorrektur aber objektbasiert arbeiten. Also bewusst bestimmte Farben (wie z.b. Hauttöne) schützen und optimieren können. Oder eben Objekte aus der Korrektur herausnehmen oder hervorheben können.

Alle Automatiken werden zudem grundsätzlich spürbar "intelligenter" arbeiten. Denoising von Bild und Ton wird mit wenigen Klicks erledigt sein. Aber auch Stimmen oder Gesichter werden bald durch Parameter veränderbar und/oder austauschbar werden. Und alles, was heute noch als einzelne KI-Tools bei GitHub zu entdecken ist (z.B. Recolor oder DeepFake-Modelle), sollte bald auch einfach nutzbar bei den Applikations-Herstellern zu finden sein.