Vorhang auf für Omnimotion und TAPIR

Und eben dies könnte sich schon in Kürze ändern. Denn die Cornell University, Google Research sowie UC Berkeley haben die Ergebnisse eines universitären Forschungsprojekts veröffentlicht, welches nichts weniger als einen nahezu perfekten Optical Flow Algorithmus verspricht. Das Paper trägt den vielsagenden Titel: "Tracking Everything Everywhere All at Once" - was man durchaus wörtlich nehmen darf.

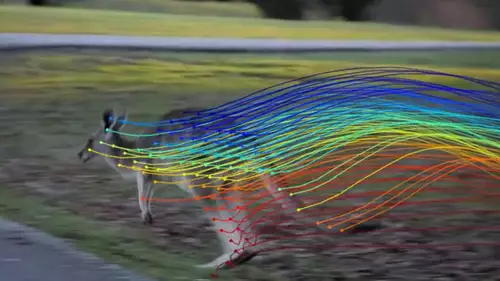

Denn während heute praktisch eingesetzte Optical Flow Algorithmen nur relativ wenige Pixel verfolgen und dies meist nicht einmal über eine längere zeitliche Distanz schaffen, soll Omnimotion ALLE Pixel eines Videos über die volle Länge eines Clips zuverlässig tracken können. Und selbstredend sollen Pixel auch zeitweise das Bild verlassen oder von anderen Objekten verdeckt werden können.

Das klingt erst einmal nach einer großlippigen Ansage, doch die zugehörige Website zeigt erstaunliche Ergebnisse des Omnimotion-Projektes. Man kann sogar an einem Live-Beispiel Clip wirkliche beliebige Punkte in einem Online-Video auswählen und sehen, wie diese exakt im Browser Video getrackt werden.

Außerdem beweist das Projekt guten Forschungsstil, indem es auf der Webseite zugleich Failure Cases anführt, bei denen der Algorithmus versagt hat. Bei den gezeigten Beispielen könnte allerdings ein Mensch wahrscheinlich die kritischen Pixel des Rohmaterials nicht mehr eindeutig verfolgen.

Und kaum ist Omnimotion aus der Forschungswelt ins Licht der Öffentlichkeit getreten, stellte eine weitere Gruppe um Google DeepMind und der Oxford Universität ein neues Tracking Verfahren namens TAPIR vor, welches ebenfalls jeden Punkt eines Videos verfolgen kann. Es ist daher anzunehmen, dass diese Trackingmethoden in Kürze auch in kommerzieller Software Einsatz finden werden.