Gerade kommen mehrere Nachrichten und Gerüchte zusammen, die in Summe auf unerwartete Veränderungen im Markt der Grafikkarten hindeuten. So ist aktuell zu hören, dass Nvidia seine GPU-Produktion stark reduzieren und AMD in der nächsten GPU-Generation keine Chips für High End Grafikkarten entwickeln soll - sondern nur noch für den "Mainstream".

Bremst der KI-Boom die GPU-Produktion?

Die Gründe bei Nvidia werden aktuell von vielen Analysten so gedeutet, dass Nvidia seine gesamten Kapazitäten in den boomenden KI-Markt steckt, wo die Margen deutlich höher sind und die Nachfrage stärker als das Angebot. Außerdem hat Nvidia hier mit CUDA/KI (noch) ein Alleinstellungsmerkmal im Markt, das man natürlich bestmöglich finanziell ausreizen will.

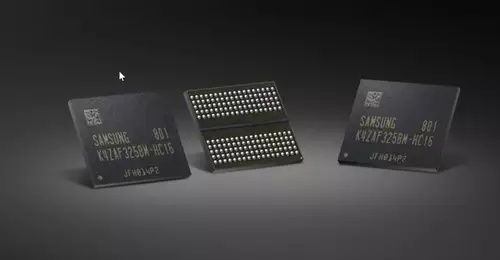

Doch das Argument stimmt in dieser Form nicht, denn die Knappheit ist angeblich vor allem den aktuell sehr knappen Kapazitäten bei TSMCs CoWoS-Packaging geschuldet, weshalb weniger produzierte Gaming CPUs nicht mehr KI-Karten für Nvidias Output bedeuten. Vereinfacht kann man sagen, dass jede GPU, die aktuelle HBM-Ram Bausteine nutzt, gerade extrem nachgefragt und gleichzeitig limitiert ist, weil sie dafür das spezielle CoWoS-Packaging benötigt.

Gaming-Markt schwächelt?

Sehr plausibel ist weiterhin die These, dass sich teure Gaming-Karten nach den letzten Crypto-Hypes einfach nicht mehr in riesigen Stückzahlen verkaufen lassen. Und dass Nvidia mit seinen Topmodellen den Markt nun praktisch ausgereizt hat. Es gibt schlichtweg nicht so viele Gamer, die mindestens 1.600 Euro für das Topmodell einer Gaming-Karte hinlegen können oder wollen. Gaming ist ein Massenmarkt und lebt von seiner weiten Verbreitung.

Den Spiele-Publishern geht es ja den Umständen entsprechend gut, nur dass man mit Xbox und Playstation eben weitaus günstigere Geräte mit sehr großer Verbreitung im Markt vorfindet. Auch deren nächste Konsolen-Generation wird wieder für einen Großteil der Gamer mehr als ausreichend sein. Dies wiederum dürfte wohl auch AMD sehen, für die sich der Markt der High End Grafikkarten sich mangels Masse ebenfalls kaum noch finanziell lohnen dürfte. Was die Plausibilität erhöht, dass AMD sich bei der nächsten GPU-Generation auf den Mainstream fokussieren wird.

Gaming- vs. Compute-Grafikkarten

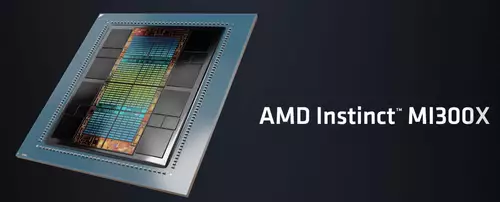

Wie bei Nvidia gab es bei AMD zudem in der aktuellen Generation einen deutlichen Split in der Chipentwicklung. Hochpreisige Server-GPUs mit HBM für KI-Anwendungen und Großrechner (CDNA-Serie, Compute) sowie Grafikkarten-GPUs mit Schwerpunkt Gaming (RDNA-Serie, Gaming). Während früher (auch bei Nvidia) die Gaming- und die Compute-Chips sehr ähnlich waren, entwickeln sich diese nun auseinander. Hier wird sich die Gaming-Spreu vom Compute-Weizen in Zukunft auch finanziell noch deutlicher trennen.

Zudem wird eine kommende RTX5090 wahrscheinlich erstmals an der 2.000 Dollar-Grenze kratzen, sofern sich Nvidias Preisgestaltung der letzten Jahre noch fortsetzen lassen sollte. Es gibt sicherlich Enthusiasten, die auch weiterhin bereit sind, derartige Preise für Gaming-GPUs zu zahlen, jedoch dürfte die Nachfrage mit weiter steigenden Preisen immer geringer werden. Signifikantes Stückzahlen-Wachstum ist bei solchen Preisen kaum noch zu erwarten.

Teure Produktionskosten

Gleichzeitig setzt Nvidia bislang noch immer auf monolithische Chips (quasi Chips "aus einem Guss"), was bereits die Produktion von großen Chips (wie in der RTX 4090) sehr kostspielig macht. Geringe Stückzahlen verteuern aufgrund der hohen und fixen Entwicklungskosten die Produktion zusätzlich. AMD setzt dagegen seine Chips immer öfter aus kleineren Chip-Dies (=Chiplets) zusammen, was die Massenproduktion im Vergleich zu Nvidia unterm Strich günstiger machen könnte. Jedoch (noch?) mit gewissen Leistungseinbußen gegenüber einer monolithischen Lösung.

Stagnation für Content Creators?

Doch was bedeutet dies alles für die Videobearbeitung? Auf jeden Fall werden die Leistungssprünge kommender Grafikkarten nicht mehr so stark ausfallen, wie bei den letzten Generationen üblich. Die heutige Leistung einer RTX 4090 wird jedoch sehr wahrscheinlich noch in den Mainstream herabsteigen und im nächsten Jahr dank GDDR7-Speicher auch mit weniger breiten Speicherbus-Designs zu erzielen sein. Denn extra breite Speicheranbindung ist ebenfalls ein gewichtiger Kostenfaktor bei High End Grafikkarten.

AMD scheint den Gaming-Markt wieder als das anzusehen, was er eigentlich ist - nämlich ein Massenmarkt, den man am besten mit möglichst günstigen Massenprodukten bedient. Neben Spielkonsolen sind hier vor allem Mittelklasse-GPUs für AMD interessant. Darunter versteht die Branche in der Regel PCIe-Karten mit zu 256 Bit Speicheranbindung.

Einsteiger-GPUs versucht AMD dagegen in Zukunft gleich als APU (also in der CPU integriert) zu verkaufen - was Nvidia mangels x86-CPU-Lizenz nicht kontern kann. Das Konsolengeschäft mit Sony und Microsoft ist zudem bereits hundertprozentig in AMDs Händen. Wenn man diese Punkte gesammelt betrachtet, ist es sehr plausibel, dass AMDs stärkste, kommende GPU der nächsten Generation wohl kaum über die Leistung einer RTX4090 hinausgehen wird.

Keine RTX 4090 Ti

Wie Nvidia darauf reagieren könnte, führt uns noch zu einem letzten Gerücht: Angeblich hat Nvidia die RTX 4090 Ti gerade definitiv abgesagt. Bisher wurde immer ein Jahr nach Vorstellung des Topmodels eine weiter verbesserte Ti-Version auf den Markt geworfen - doch in diesem Jahr scheint Nvidia dies nun nicht mehr für notwendig zu halten. An einer nahenden RTX 50x0 Serie kann es übrigens nicht liegen. Nach allgemeiner Gerüchte-Lage ist deren Vorstellung noch mindestens ein Jahr entfernt. Vielmehr dürften die allgemein schwachen GPU-Verkaufszahlen sowie der schon aktuell fehlende Konkurrenzdruck von AMD im High End ein große Rolle bei dieser Entscheidung gespielt haben. Es ist daher auch stark anzunehmen, dass es Nvidia bei einer kommenden RTX 5090 ruhiger angehen wird und kaum die kostspieligen Entwicklungsmuskeln spielen lassen wird - solange man von AMD kein Konkurrenzprodukt im High End erwarten muss.

Mehr Leistung in der Cloud?

Wer als Videobearbeiter mehr Leistung braucht, kann in Zukunft immer noch auf die Cloud ausweichen. Denn hier wird es (auch dank der aktuellen KI-Aufrüstung) theoretisch skalierbare GPU-Leistung bis zum Abwinken geben.

Interessanterweise könnte AMD hierfür sogar die besseren Karten in der Hand haben, denn deren CDNA-Server Beschleuniger wie die kommende MI300 sind noch von Haus aus mit der x86-Architektur kompatibel, auf der auch ohne Modifikation PC-Standardsoftware in der Cloud laufen kann. Nvidia setzt dagegen mit seinen Datacenter-Hopper-Lösungen auf ARMs CPU-Architektur. Nvidias High End Server-Karten werden in der Cloud primär für KI-Training unter CUDA optimiert sein, können aber nicht ohne weiteres gängige Videobearbeitungssoftware wie Resolve ausführen. (Kleinere Cluster von Nvidia wird es jedoch sicherlich auch noch weiterhin mit x86-Architektur-Anbindung geben).

Aber ob aufwendige Videobearbeitung überhaupt in der Cloud mittelfristig ein Zuhause findet, bleibt sowieso ein sehr großes Fragezeichen. Schließlich dürfte es auch in den nächsten Jahren extrem unpraktisch bleiben, ein Petabyte 8K RAW-Daten für ein Filmprojekt in ein entferntes Rechenzentrum hochzuladen - um dort dann in einer Timeline mit komprimierter 8-Bit Echtzeitvorschau zu arbeiten. Denn eine hochauflösende, unkomprimierte und zugleich latenz-arme Vorschau in der Cloud funktioniert bis heute nicht wirklich. Vielleicht wird es jedoch üblich, einzelne Clips für aufwendige Effekte in die Cloud zum Background-Rendering zu schicken.

Bis auf weiteres scheint es jedenfalls praktikabler zu bleiben, die GPU-Rechenleistung unter dem eigenen Tisch zu verstauen. Glücklicherweise reicht für die meisten Projekte ja die Leistung einer aktuellen GPU oft noch gut aus. Zumindest bis die großen generativen KI-Modelle jenseits der 24GB die ersten Videoeffekte übernehmen werden...