Durch Microsofts Kinect ist das so genannte Range Imaging schlagartig populär geworden. Hierbei wird neben der RGB-Information auch für jedes Pixel eine so genannte Z-Information gespeichert. Diese beschreibt die Tiefe des Pixels im Raum, bzw. den Abstand des Pixels zur Kamera. Um diese räumliche Tiefeninformation zu gewinnen gibt es diverse Verfahren, die auch im oben verlinkten Wikipedia-Eintrag angerissen werden.

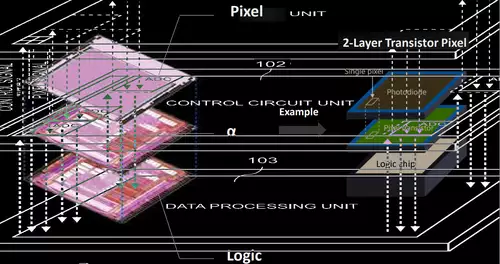

Während Kinect mit strukturierter Beleuchtung arbeitet und über ein projiziertes Muster seinen Z-Puffer füllt, verfolgt der neue Samsung-Sensor die Time-of-Flight-Methode. Hierfür wird tatsächlich wie bei einem Radar die Laufgeschwindigkeit des Lichtes gemessen. Bisher waren für einen Time-of-Flight-Ansatz zwei Sensoren nötig, jedoch kombiniert Samsung nun eben beide Sensortypen auf einem Chip. So gewinnt ein Teil der Pixel RGB-Werte, während andere Z-Werte generieren. Dies dürfte nicht nur für mehr Genauigkeit bei der Z-Bestimmung sorgen, sondern auch weitaus kompaktere Geräte ermöglichen.

// Top-News auf einen Blick:

- Blackmagic Resolve Studio für 236,81 bei Teltec - und weitere Angebote

- Bis zu 1.000 Euro sparen: Cashbacks auf Kameras von Sony, Nikon, Canon und Panasonic

- Ausgewählte Angebote - DJI Mavic 4 Pro, Canon R5 C, Sachtler aktiv12T...

- Die besten Black Friday Deals für Sony und Canon DSLMs und Objektive

- Blackmagic bietet bis zu 30% Rabatt auf seine 6K Kameras

- Große Übersicht - Black Friday Deals 2025 für Foto+Video - Kameras, Objektive, Zubehör usw.

Der Sensor selbst kann mit RGB-Pixeln nur fast-FullHD mit 1,920 x 720 Pixeln liefern, wobei die ausgelesenen Z-Werte sogar nur ein Raster von 480 x 360 Pixel abdecken. Grund ist hierfür unter anderem, dass die Z-Pixel wohl deutlich mehr Fläche für ein zuverlässiges Sampling benötigen.