Damit KI-generierte Videos nicht stumm bleiben, gibt es bereits mehrere Ansätze zur künstlichen (Nach-)Vertonung - wie berichtet arbeitet unter anderem das Google Deepmind-Team an einem Video-to-Audio-System als Ergänzung für seine Video-KI Veo. KI-generierte Soundeffekte findet man beispielsweise bei Elevenlabs.

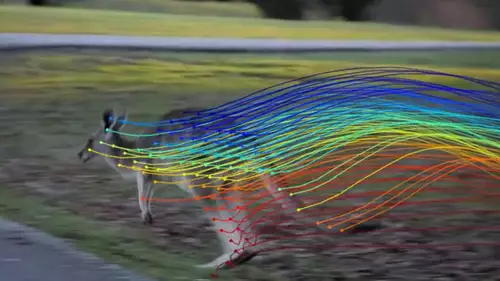

Nun wurde ein weiteres Modell für die videogesteuerte Klangerzeugung vorgestellt, welches einige potente Fähigkeiten verspricht - stundenlanges Gefrickel um SFX-Schnipsel in der Timeline anzupassen, wird damit überflüssig, denn diese Aufgabe übernehmen künftig Algorithmen. MultiFoley unterstützt dabei eine multimodale Herangehensweise und soll sowohl Text, als auch Audio und Video als Vorgabe annehmen. Der gewünschte Foley-Sound zu einem Clip läßt sich folglich einerseits per Textprompt "aus dem Nichts" generieren, andererseits kann auch ein Audiosample als Referenz definiert werden, etwa aus einer Sound-Effekt-Bibliothek, dessen Klangeigenschaften (z.B. Rhythmus und Klangfarbe) übernommen werden soll. Wird ein Video mit teilweise vorhandenem Sound vorgegeben, spinnt MultiFoley die Tonspur entsprechend weiter.

🎥 Introducing MultiFoley, a video-aware audio generation method with multimodal controls! 🔊

— Ziyang Chen (@CzyangChen) November 27, 2024

We can

⌨️Make a typewriter sound like a piano 🎹

🐱Make a cat meow like a lion roars! 🦁

⏱️Perfectly time existing SFX 💥 to a video pic.twitter.com/oAiDKykdZw

Erzeugen lassen sich natürliche Klänge (z.B. rollende Skateboardräder auf einem Untergrund) ebenso wie skurrilere Audiosequenzen (z. B. das Brüllen eines Löwen, das wie das Miauen einer Katze klingt), jeweils synchron zum Bildereignis. Darüberhinaus bietet negatives Prompting die Möglichkeit, unerwünschte Audioelemente auszuschließen.

// Top-News auf einen Blick:

- Leak: Samsungs plant SATA-Aus - Kommt der Preisschock auch bei SSDs?

- Kompaktkameras wieder im Trend - trotz Smartphones

- Von Mickey Mouse bis Darth Vader - Disney lizenziert seine Figuren an OpenAIs Sora

- Verstehen Video-KIs die Welt? Physik-IQ enthüllt Grenzen der Modelle

- CineBias by RED - 9 neue, kostenlose Nikon Bildrezepte

- Datacolor SpyderPro - Überragendes Feature-Upgrade für Videografen

MultiFoley basiert auf Diffusionsmodellen und nutzt für das Training aktuell zwei verschiedene Datensets, VGG-Sound mit 168K Samples für die Video-Text-Ton-Generierung und für die Text-Ton-Generierung Sound-ideas mit 400K Samples. Der Ansatz verknüpft Sprache mit Videohinweisen und entkoppelt die semantischen und zeitlichen Elemente von Videos. Dies ermöglicht kreative Foley-Anwendungen, wie z. B. die Modifizierung eines Vogelgezwitscher-Videos, um es wie eine menschliche Stimme klingen zu lassen, oder die Umwandlung eines Schreibmaschinengeräuschs in Klaviertöne - und dies, während es mit dem Video synchronisiert bleibt.

Eine wesentliche Neuerung des Modells besteht laut der Entwickler darin, dass es sowohl auf Internet-Videodaten mit minderwertigem Ton als auch auf professionellen SFX-Aufnahmen trainiert werden kann, um eine qualitativ hochwertige Tonerzeugung mit voller Bandbreite (48 kHz) zu ermöglichen. So soll MultiFoley mit erfolgreich synchronisierten und qualitativ hochwertigen Klängen andere bestehende Methoden übertreffen. Eine Erzeugung von Musik oder Dialogen (wie bei Googles Video-to-Audio-System) scheint jedoch nicht angestrebt zu werden - der Name ist Programm.

MultiFoley ist ein gemeinsames Projekt von Forschern der amerikanischen Universität Michigan und Adobe. Somit sollte man sich nicht wundern, wenn eine ähnliche Funktionalität über kurz oder lang im Firefly Video-Generator auftauchen sollte; aktuell ist MultiFoley nicht öffentlich zugänglich.