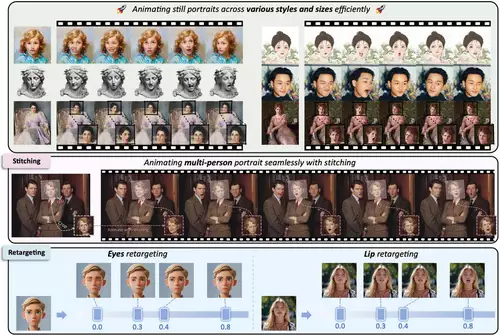

Der neue KI-Algorithmus "LivePortrait" eines chinesischen Forscherteams macht gerade die Runde in den sozialen Netzwerken, denn er ermöglicht es, Bilder und auch Videos von Gesichtern anhand einer Videoaufnahme eines Gesichts beliebig zu animieren. Dies kann man sogar selbst ausprobieren, denn die Forscher haben neben der Studie nicht nur eine interaktive Demo auf Hugginface veröffentlicht, sondern auch - noch besser - den Inferenzcode und die Modelle ihres Projekts unter der freien MIT Lizenz auf GitHub veröffentlicht. Beides ermöglicht es Usern, den Algorithmus schnell und einfach mit eigenen Werken einzusetzen. Die Früchte sind bereits im Netz zu sehen.

LivePortrait überträgt sowohl die Mimik samt Augen und Augenbrauen als auch leichte Bewegungen des Kopfes und auch Lippenbewegungen - letzteres ist natürlich extrem nützlich für die realistische Animation von sprechenden Gesichtern.

Gerade im Zusammenspiel mit KI-Bildern und Videos ermöglicht LivePortrait Filmemachern völlig neue und lange ersehnte Möglichkeiten der Kontrolle: per eigenem Inputvideo kann so der Gesichtsausdruck in einem Bild oder Video exakt kontrolliert werden. Die so animierten Gesichter verleihen KI-Videos ein viel realistischeres Aussehen als bisher. Lustigerweise können so auch die Gesichter von Tieren animiert werden.

Entwickelt wurde der Algorithmus von Forschern des chinesischen Kuaishou Konzerns, der erst vor kurzem sein aufsehenerregendes Video-KI Kling veröffentlicht hatte. Deswegen ist anzunehmen, dass LivePortrait demnächst auch in Kling integriert werden wird.

Die Forscher geben mehrere praktische Ratschläge zum Einsatz eigener Videos zur Gesichtsanimazion. Diese sollten ein Seitenverhältnis von 1:1 (wie z. B. 512x512 oder 256x256 Pixel) aufweisen und es sollte das automatische Zuschneiden mit tels der Option --flag_crop_driving_video aktiviert sein. Zudem sollte das Video vor allem den Kopfbereich zeigen und die Bewegungen der Schulter möglichst minimal sein. Auch wichtig: das erste Bild sollte ein frontales Gesicht mit neutralem Ausdruck darstellen.

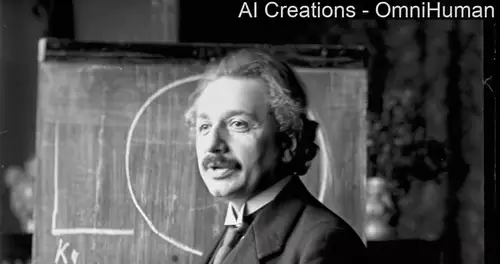

Verschiedene User haben unter anderem auf Twitter schon Demo-Clips mit Hilfe der Fähigkeiten von LivePortait produziert:

// Top-News auf einen Blick:

- Neue Gerüchte: Nvidia soll die GPU-Produktion 2026 um 30–40% runterfahren

- Adobe Firefly bekommt Upscaling per Topaz, Editing per Prompt und mehr

- Leak: Samsungs plant SATA-Aus - Kommt der Preisschock auch bei SSDs?

- Kompaktkameras wieder im Trend - trotz Smartphones

- Von Mickey Mouse bis Darth Vader - Disney lizenziert seine Figuren an OpenAIs Sora

- Verstehen Video-KIs die Welt? Physik-IQ enthüllt Grenzen der Modelle

With LivePortrait you can just perform what you want the character on the screen to do. This clip is using cc0 footage from Pexels, but you can do this with all the AnimateDiff / Gen3 / Luma / Pika etc clips you&ve already made as well! pic.twitter.com/y2fLoC5183

— Purz.xyz (@PurzBeats) July 14, 2024

https://t.co/AmRpo3WMly pic.twitter.com/H5dNvZpvlE

— Seamless (@shiropen2) July 8, 2024

LivePortrait: Efficient Portrait Animation with Stitching and Retargeting Control Jupyter Notebook

— camenduru (@camenduru) July 4, 2024

Thanks to Jianzhu Guo Dingyun Zhang Xiaoqiang Liu Zhizhou Zhong Yuan Zhang Pengfei Wan Di Zhang

jupyter: please try it https://t.co/bHODLsRgCM pic.twitter.com/Q9iFuUnR9i

Michael Corleone sings I will always love you. #liveportrait pic.twitter.com/fdwf9R53Ht

— Honest broker (@JeroenvanH) July 15, 2024

LivePortrait also works on videos! The memes will be glorious pic.twitter.com/IoRXAmL9AO

— Dreaming Tulpa (@dreamingtulpa) July 8, 2024