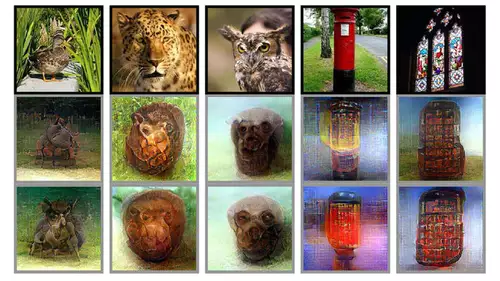

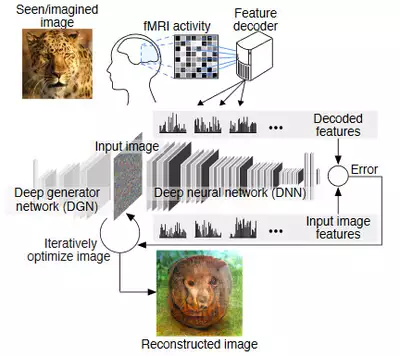

Wissenschaftler der ATR Computational Neuroscience Laboratories und der Kyoto University haben einen Deep Learning basierten Algorithmus entwickelt, welcher in der Lage ist, mittels Messung der Gehirnaktivität eines Menschen grob schemenhafte Bilder dessen zu produzieren, was dieser gerade sieht.

Die Gehirnaktivität wurde mittels eines fMRI (funktionelle Magnetresonanztomographie) ermittelt, welches basierend auf dem Grad der Sauerstoffsättigung im Blut mit hoher räumlicher Auflösung die Aktivität bestimmter Hirnareale messen kann.

Die Besonderheit: das so trainierte neuronale Netzwerk (DNN - Deep Neural Network) kann nicht nur Bilder, welche ein Mensch gerade sieht, halbwegs rekonstruieren, sondern auch Formen, die er sich nur vorstellt. Das DNN bildet durch seine verschiedenen Schichten eine strukturelle Ähnlichkeit mit den hierarchischen Verarbeitungsprozessen der (in diesem Fall visuellen) Sinnesreize im menschlichen Gehirn ab, welche dazu genutzt wird, das rekostruierte Bild dem vorgestellten anzugleichen.

Zur Berechnung des DNN wurde eine Nvidia GTX 1080Ti sowie eine auf machine-learning spezialisierte Tesla K80 GPU genutzt. Trainiert wurde das neuronale Netzwerk anhand von 1000 Photos, welche drei Versuchsteilnehmern, die in einem Magnetresonanztomographen lagen, über einen Zeitraum von 10 Monaten gezeigt wurden.

// Top-News auf einen Blick:

- Sony Alpha 7 V ist da: 33MP Partially Stacked Sensor, 4K 60p ohne Crop und 16 Stops

- ByteDance Vidi2 produziert selbstständig fertige Videos aus Rohmaterial

- Blackmagic DaVinci Resolve 20.3 bringt Support für 32K-Workflows und mehr

- Bis zu 1.000 Euro sparen: Cashbacks auf Kameras von Sony, Nikon, Canon und Panasonic

- Sony und slashCam verlosen eine FX2 Cinema Line Kamera

- DJI Neo 2: Verbesserte Mini-Drohne für Solo-Creator und Einsteiger