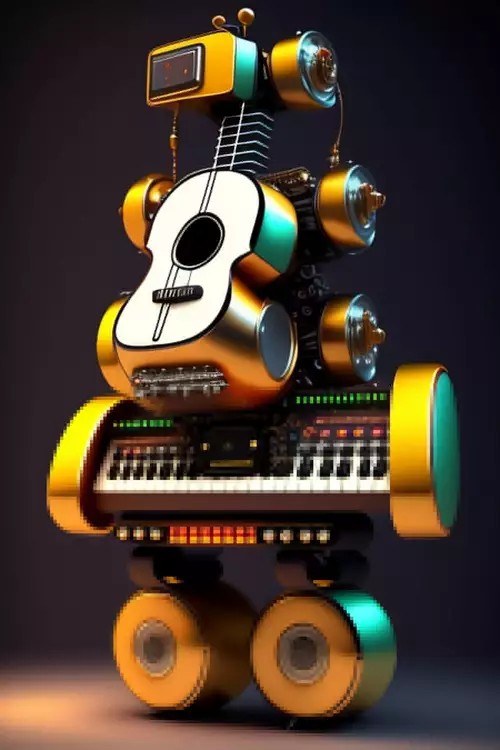

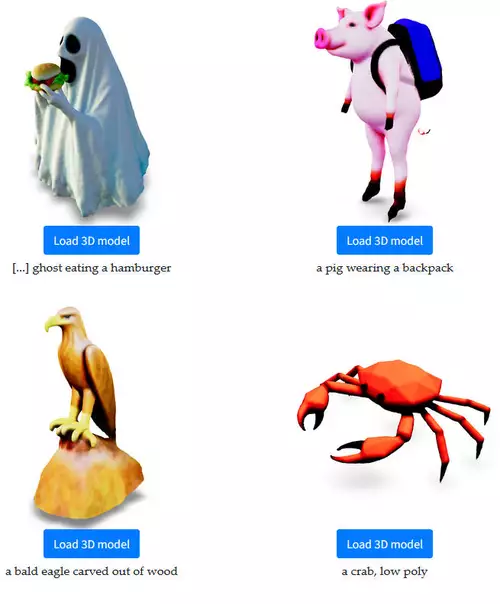

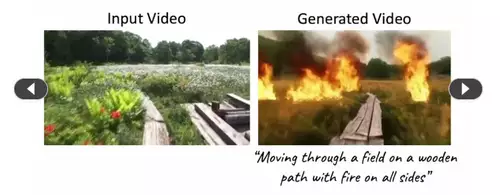

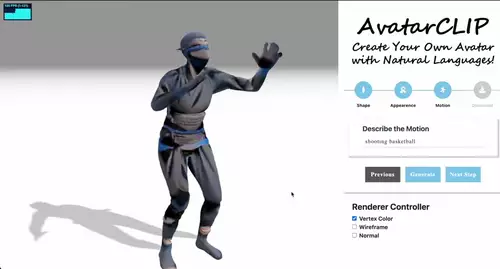

Neue KI Algorithmen revolutionieren gerade die Erschaffung von Bildern, Videos und auch 3D-Modellen und machen die Methoden so einfacher zugänglich als bisher. Die gerade neu vorgestellt KI AvatarCLIP ermöglicht jetzt auch die Erstellung und die Animation von 3D-Avataren nur per Textinput. So erlaubt es AvatarCLIP im Gegensatz zu professioneller Software, die Expertenwissen erfordert, einen 3D-Avatar in einer beliebigen gewünschten Form und Textur zu generieren und dessen Bewegungen dann zu steuern - nur mittels Textkommandos.

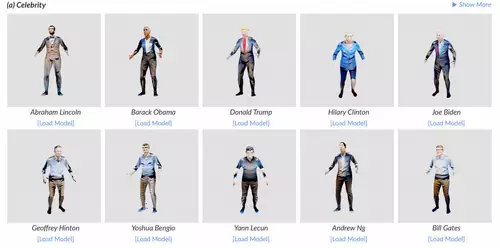

Der Prozess erfolgt in drei Schritten: erst wird nach Textbeschreibung eine grobe Körperform erzeugt (im Clip zum Beispiel "ein sehr dünner Mann"), dann wird das Aussehen (Details des Körpers der sowie Kleidung) definiert ("ein Ninja") und dann schließlich eine Bewegung ("Basketball werfen"). Körper können ebenso basierend auf berühmten Persönlichkeiten ("Barack Obama") wie fiktionalen Charakteren ("Iron Man") oder nach einer allgemeinen Beschreibung (wie etwa "Gärtner" oder "Zauberer") generiert werden. Hier der Code von AvatarCLIP.

In Zukunft: automatisch generierte Animationsfilme?

// Top-News auf einen Blick:

- Blackmagic DaVinci Resolve 20 Beta 2 bringt neue Funktionen und Bugfixes

- Blackmagic Camera for Android 2.1 bringt neue Features

- Neuer superschneller PoX Flash-Speicher könnte DRAM und SSDs ersetzen

- Achtung: Verpixelte Videos können wieder kenntlich gemacht werden

- KI-generierte Fake-Trailer: Wie Hollywood an der Irreführung der Zuschauer ...

- Beleuchtung für Foto und Video lernen mit kostenlosem Tool von Google

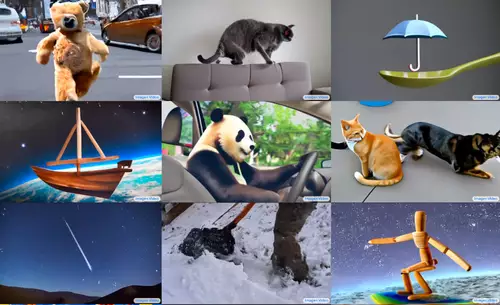

Human Motion Diffusion Model: text-to-motion

Eine weitere neue KI, die ebenfalls interessant ist für User, die mit 3D-Modellen und Animationen arbeiten, ist das Human Motion Diffusion Model (MDM) der Tel Aviv University, welches per "text-to-motion" die Steuerung von Bewegungen von 3D Modellen von Menschen per Texteingabe ermöglicht. Hier der zugehörige Programmcode samt Modellen.