Newsmeldung von slashCAM:

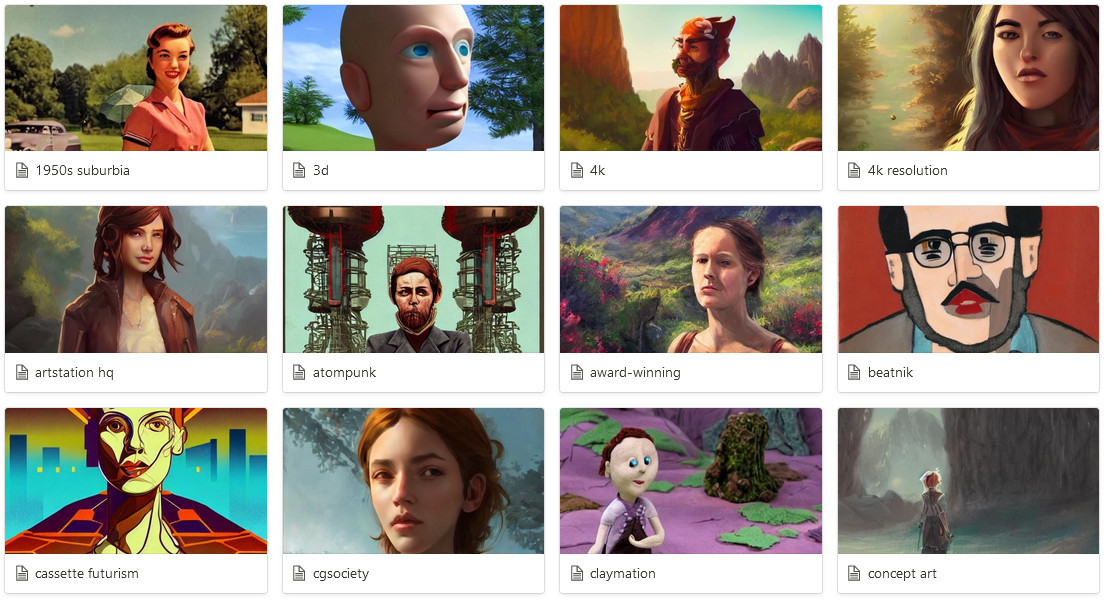

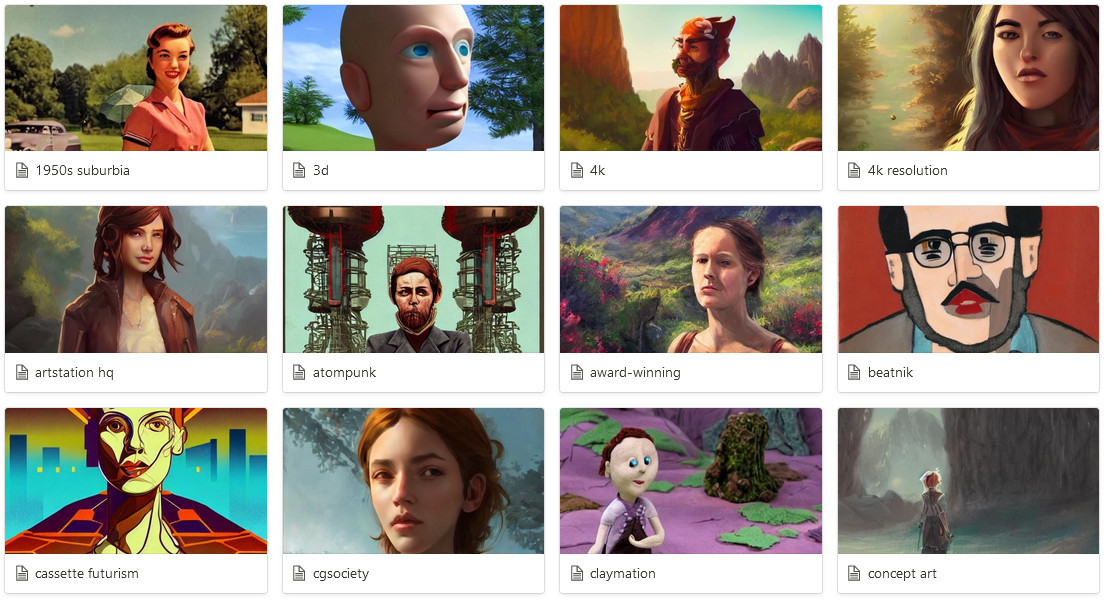

Seit ein paar Tagen ist es endlich soweit: die Text-zu-Bild KI Stable Diffusion wurde veröffentlicht und kann kostenlos auf dem eigenen Computer genutzt werden - damit ist jetzt erstmals die Generierung von Bildern per Textinput auch auf einem relativ normalen PC möglich.

Hier geht es zum slashCAM Artikel:

News: Die Stable Diffusion Revolution: Kostenlose Bildgenerierung per KI jetzt auch auf dem Heim-PC

Antwort von Frank Glencairn:

Teilweise echt beeindruckend, aber anscheinend bin ich noch zu blöd die richtigen Sätze zu formulieren.

4254007269_A__bunny__a_crab_and_a_lobster_on_a_boat__by_hopper.png

Antwort von poki1000:

Wie wärs wenn du nun dieses Boot auf einen See oder in ein Meer setzt - gib dem See oder Meer noch mehr Info mit, zb Arctic Sea - vielleicht bei Sonnenuntergang?

Ich bezieh mich auf den Titel deines Bildes, das scheint ja dein Eingabesatz gewesen zu sein.

Alle im Artikel gezeigten Bilder, beinhalteten in ihrer Beschreibung eine klare Ortsangabe sowie eine Lichtstimmung bzw Zeitangabe.

Anders gesagt, du beschriebst das Was - Wo und Wann fehlt in deiner Bildbeschreibung.

Wobei auch das Wann sehr vielschichtig ist, denken wir in Tageszeiten, Jahreszeiten, Jahrzenten oder gar Jahrhunderten?

je genauer ich das fasse, umso besser habe ich es, in Verbindung mit einem dezidierten Ort, beschrieben.

Antwort von MarcusG:

Es ist einfach schockierend, wie hier Kompetenzen die man als Illustrator jahrelang erwerben muss einfach verfügbar gemacht werden.

In Zukunft wird einfach jeder einen Animationsfilm

oder sogar "Realfilm"produzierenn können, indem er einfach ein Drehbuch schreibt und die KI setzt alles um, die Sets, die Figuren, deren Mimik, Stimmen...das wird ganze Abspänne von Millionen kostenden Crews ersetzen.

Dasselbe gilt auch für Games. Vermutlich wird das alles für Film und Games in der Unreal Engine 7 oder so verfügbar sein.

Was mir an den Bildern auffällt ist wie künstlerisch kompetent hier Dinge wie Komposition, Farbharmonien, cinematischer Haze, scheinbar händische Pinselführung meisterlich Mal nebenbei mit umgesetzt werden. Wie gesagt, das ist schockierend.

Antwort von cantsin:

Die Installationsanleitung scheint nicht mehr zu funkionieren, bzw. die Datei "sd-v1-4.ckpt" scheint offline zu sein. Kennt jemand einen Workaround?

Antwort von medienonkel:

cantsin hat geschrieben:

Die Installationsanleitung scheint nicht mehr zu funkionieren, bzw. die Datei "sd-v1-4.ckpt" scheint offline zu sein. Kennt jemand einen Workaround?

Ich bin auch nur so weit gekommen, dass man bei huggingface nen account erstellen muss.

Dort generiert man sich nen Token und kann dann in anaconda das Modell runterladen. Wie das geht findet sich in den community posts unter dem repo.

Irgendwie landen dann insgesamt 10 GB Daten auf der Platte, die dann erstmal zu nix zu gebrauchen sind. Es wird sich beschwert, dass ein python script fehlt, welches aber im Ordner liegt... das Übliche halt, wenn man mit seinem Halbwissen "mal eben schnell", sowas zum Laufen bringen möchte.

Nach ner Stunde rumorgeln auf der Tastatur hab ich"s dann erstmal aufgegeben, hatte aber da noch nen wichtigen Termin im Hinterkopf und somit wars mir dann auch wurscht.

Zum rumexperimentieren taugen halt dann die colab Geschichten eher was.

Wie im Artikel steht, wird es wohl bald nen installer geben, der einem das Zusammensuchen der ganzen code-Bröckerl erspart.

Zumindest kommt man mit der verlinkten Anleitung direkt nicht weiter.

Antwort von tom:

medienonkel hat geschrieben:

Zum rumexperimentieren taugen halt dann die colab Geschichten eher was.

Wie im Artikel steht, wird es wohl bald nen installer geben, der einem das Zusammensuchen der ganzen code-Bröckerl erspart.

Zumindest kommt man mit der verlinkten Anleitung direkt nicht weiter.

Ja, Colab funktioniert sehr einfach (gut zum Ausprobieren) und die Generierung ist auch schön schnell.

PS

Demnächst wird auch das neuen 1.5 Modell veröffentlicht, welches unter anderem Gesichter und vor allem Körper noch besser (und fehlerfreier) generiert.

Antwort von Frank Glencairn:

MarcusG hat geschrieben:

Es ist einfach schockierend, wie hier Kompetenzen die man als Illustrator jahrelang erwerben muss einfach verfügbar gemacht werden.

Da würde ich mir keine allzu großen Sorgen machen.

Spätestens in dem Moment, in dem der Kunde eine Detailänderung will bist du mit der AI am Ende.

Antwort von cantsin:

"Frank Glencairn" hat geschrieben:

Spätestens in dem Moment, in dem der Kunde eine Detailänderung will bist du mit der AI am Ende.

In der letzten Update-Version von Dall-E nicht mehr. Da kannst Du Teile des Bilds maskieren und mit ggfs. veränderten Prompts neu generieren.

Antwort von markusG:

Antwort von medienonkel:

markusG hat geschrieben:

Naja, irgendwoher müssen ja noch die ganzen Trainingsdaten kommen.

Evtl. erschließt sich da sogar ein neues Betätigungsfeld für Fotografen. Gibt ja genügend Leute, die einfach nur Texturen oder HDRs erstellen.

Interessant ist ja auch, woher die Trainingsdaten, sprich Fotos, stammen und wie da die Rechte geklärt sind.

Im Endeffekt lässt sich das alles gar nicht nachvollziehen.

"Since DALLE is trained on massive datasets scraped straight from the internet without acknowledgment, issues about copyright infringement exist. According to some, “if it is on the internet, it is public domain.” Yet, there are divergent views on this, and it appears that the only way to know for certain is for the subject to be litigated in a court of law."

https://uxdesign.cc/dall-e-the-future-o ... 570e14951c

Das künstliche Ergebnis dürfte ja auch irgendwie einem Urheberrecht unterliegen.

https://www.technollama.co.uk/dall%C2%B ... -copyright

NFTs direkt von der AI?

Ich schmeiß mal die Gelddruckmaschine an...

Antwort von tom:

cantsin hat geschrieben:

"Frank Glencairn" hat geschrieben:

Spätestens in dem Moment, in dem der Kunde eine Detailänderung will bist du mit der AI am Ende.

In der letzten Update-Version von Dall-E nicht mehr. Da kannst Du Teile des Bilds maskieren und mit ggfs. veränderten Prompts neu generieren.

Ja, das geht mit der sogenannten In-Painting Funktion - das geht auch mit Stable Diffusion und ist in die Version mit WebUI schon integriert.

https://github.com/hlky/stable-diffusion-webui

bzw.

https://colab.research.google.com/githu ... ryne.ipynb

Antwort von klusterdegenerierung:

Geht das auch irgendwie für Leute die für Github und codes zu blöd sind?

Ich finde das immer klasse, da wird einem dieses Seite mit 1000 Dateien gelinkt, aber welches es davon ist, oder alle und wie man die ohne weit und breit kein downloadbutton an den start bekommt, scheint ein großes Rätsel zu bleiben. ;-(

Antwort von medienonkel:

klusterdegenerierung hat geschrieben:

Geht das auch irgendwie für Leute die für Github und codes zu blöd sind?

Ich finde das immer klasse, da wird einem dieses Seite mit 1000 Dateien gelinkt, aber welches es davon ist, oder alle und wie man die ohne weit und breit kein downloadbutton an den start bekommt, scheint ein großes Rätsel zu bleiben. ;-(

Noch nicht, dafür kostet"s halt nix ;-)

Bei Github kann man sich die ganze repo/fork gezippt runterladen. Oben rechts über der Dateiliste sollte man das auswählen können.

Irgendwann, vermutlich die nächsten Wochen, wird es dann einen Installer geben, der dir den ganzen Spass incl. zugehörigem git, python usw. sauber in nen Ordner schiebt.

Antwort von medienonkel:

Noch nicht ausprobiert, aber jetzt gibt's scheinbar nen installer!

https://github.com/cmdr2/stable-diffusion-ui

Antwort von Hayos:

medienonkel hat geschrieben:

Noch nicht ausprobiert, aber jetzt gibt's scheinbar nen installer!

https://github.com/cmdr2/stable-diffusion-ui

Danke! Bei mir funktionierts!

Hinweise:

- den Ordner mit den Installationsdateien direkt in den Root der Festplatte legen (sonst meckert er)

- bei mir hat es ein paar Durchläufe gebraucht bis alles installiert/runtergeladen wurde (einfach noch mal auf die Install-Datei klicken)

- 19 GB hatte ich am Ende der Installation...

Ich brauch' weiterhin eine neue Graka :D Aber es klappt auch mit meiner GTX970 4GB VRAM (die ja eigentlich 3,7 GB VRAM sind). Reduzieren der Auflösung (zb. 320x320px statt 512x512px) senkt zwar dramatisch die Rechenzeit pro Bild, aber höhere Auflösungen zeigen "mehr Bild". D.h. zb. bei 320x320px ist man immer etwas close/nah dran, auch wenn man "wide shoot" oder ähnliches eingibt.

/edit: Tipps korrigiert