Die einzelnen Schritte

Als erstes benötigen wir ein Video ohne Kamerabewegung, das von einem Stativ aufgenommen wurde. Alternativ kann man auch (wie in unserem Fall) versuchen, ein aus der Hand aufgenommenes Smartphone-Video vor dem Einsatz mit einem digitalen Tracker/Stabilizer zu stabilisieren.

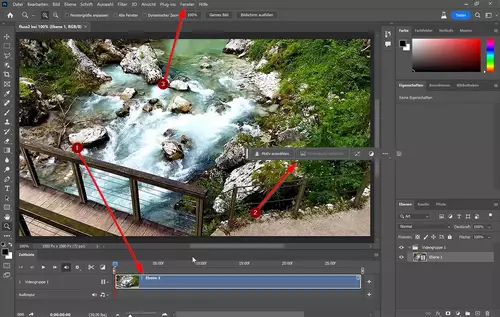

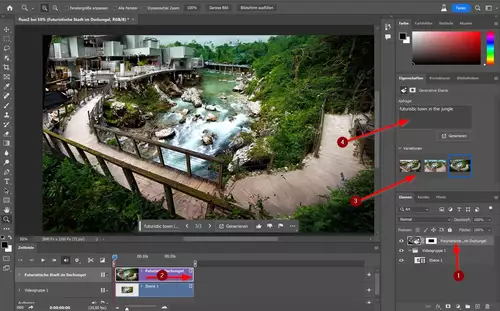

Dieses Video importieren wir in Photoshop als Startprojekt. Anschließend sollten wir eine Zeitleiste (1) sowie eine kontextbezogene Taskleiste (2) sehen. Fehlen diese beiden Elemente, so lassen sich diese im Fenster-Menü (3) aktivieren:

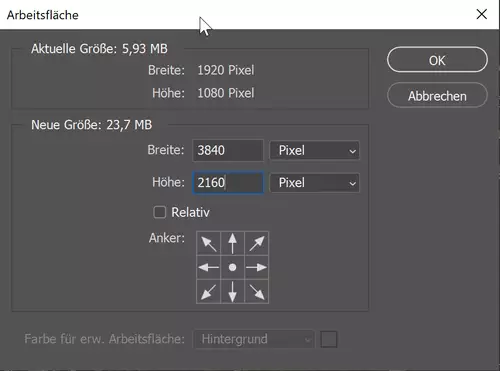

Als nächstes erzeugen wir einen Rahmen um das Bild, in welchem die KI zusätzlichen Bildinhalt "erfinden" soll. Hierfür wählen wir "Bild/Arbeitsfläche..." und geben die Größe für unser finales Projekt ein. Wir wollen für unser Projekt noch eine virtuelle Zoomfahrt realisieren und als finale Ausgabeauflösung FullHD nutzen. Also geben wir eine doppelt so große Arbeitsfläche mit 4K-Auflösung ein:

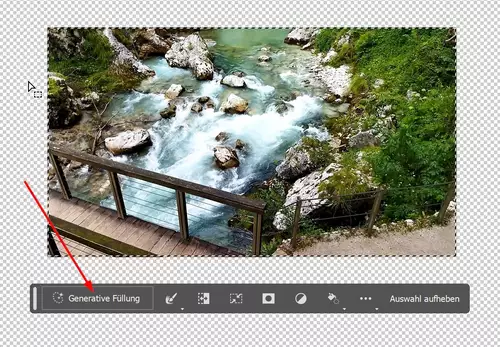

Anschließend wählen wir mit dem Auswahlwerkzeug unser Video aus und kehren unsere Auswahl um, so dass nun die neu hinzugekommene leere Bildfläche selektiert ist. Dann klicken wir in der kontextbezogenen Taskleiste auf "Generative Füllung".

Photoshop fragt uns nun, was wir für Vorstellungen für die "Füllung" haben. Mit diesem Prompt kann man mittlerweile sogar in deutscher Sprache agieren. Wir haben jedoch den subjektiven Eindruck, dass man mit englischen Begriffen meistens bessere Ergebnisse erzielt. Wir haben für unser Beispiel einmal "futuristic town in the jungle" ausprobiert.

Photoshop generiert nun mit seiner KI eine neue Ebene. Diese muss man zur Sichtbarkeit noch über die Videoebene schieben (1) und in der Timeline auf die Videocliplänge anpassen (2). Über das Eigenschaften-Feld lassen sich nun Variationen auswählen (3), löschen, weitere erzeugen und/oder hierfür auch der Prompt verändern (4):

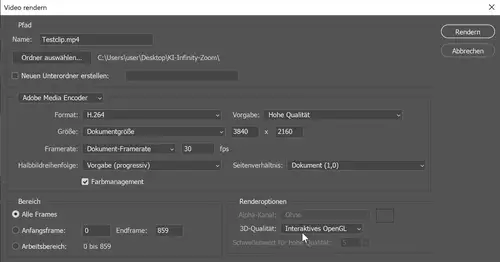

Über "Datei/Exportieren/Video Rendern..." können wir den fertigen Clip in 4K aus Photoshop exportieren: