Nachdem wir ja kürzlich etwas kritisch auf die Zukunft der Kameraentwicklung geblickt haben, stehen wir vielleicht auch etwas in der Beweislast, welche Funktionen in Zukunft von der Computational Videography übernommen werden könnten.

Ein dabei von uns bislang wenig beachtetes Feld ist das Tracking, denn Verbesserungen in diesem Bereich ziehen in der Postproduktion extreme Möglichkeiten synthetischer Optimierungen nach sich. Nicht nur bei der Stabilisierung und der Berechnung von Slow Motions oder nachträglichem Motion Blur - in zweiter Instanz kann Motion Tracking sogar "über Bande" beim Denoising und damit der Dynamik helfen, sofern man damit Objekte zuverlässig erkennen und über die Zeit verfolgen kann.

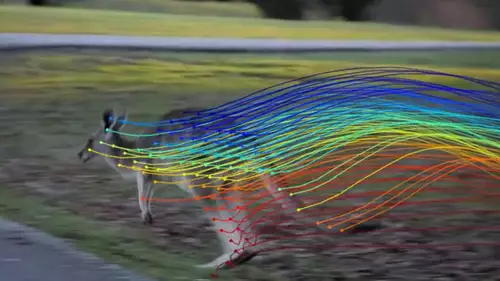

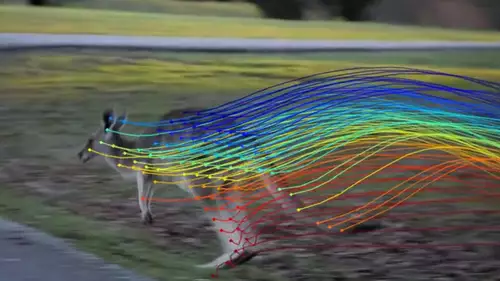

Für die meisten Tracking-Anwendungen sind Optical Flow Algorithmen aktuell der Goldstandard. Hierbei versucht ein Algorithmus einzelne Pixel im Bild zu erfassen und in ihrer Bewegung vorherzusagen. Sogenannte Solver versuchen dann ein komplexes Gleichungssystem für einige Pixel im Bild so zu lösen, dass die Abweichung von der Vorhersage mit den tatsächlich verfolgten Pixeln bestmöglich übereinstimmt.

Hat man so die Bewegung einiger Pixel als Bewegungsvektor gelernt, so kann man leicht Zwischenbilder generieren, weil die Position des Pixels zwischen zwei Bildern durch das gefundene Formel-System interpoliert werden kann.

In der Praxis

In der Praxis funktioniert dies oft auch erstaunlich gut. Gerade synthetische SlowMotion-Bewegungen können bereits ziemlich realistisch gerendert werden, was den Einsatz einer HighSpeed-Kamera in manchen Fällen überflüssig gemacht hat. Bzw. man kann Slow Motion damit sogar nachträglich in Bereichen einsetzen, in denen eine High Speed Kamera nicht zur Verfügung stand.

Pixelpeeper finden bei vielen synthetischen Bewegungen jedoch oft Stellen, die optisch nicht stimmen und gar nicht so selten kommt es bei vielen Optical Flow Anwendungen auch zu deutlich sichtbaren Artefakten, die nicht erst bei genauem Hinsehen offensichtlich werden.

Allerdings weiß man beim Dreh nie, ob man eventuell problematisches Tracking-Material für die Postproduktion erzeugt hat - weshalb man sich bei wichtigen Produktionen lieber nicht auf Optical Flow Algorithmen verlässt. Zumindest solange sie nicht noch zuverlässiger agieren...

Vorhang auf für Omnimotion und TAPIR

Und eben dies könnte sich schon in Kürze ändern. Denn die Cornell University, Google Research sowie UC Berkeley haben die Ergebnisse eines universitären Forschungsprojekts veröffentlicht, welches nichts weniger als einen nahezu perfekten Optical Flow Algorithmus verspricht. Das Paper trägt den vielsagenden Titel: "Tracking Everything Everywhere All at Once" - was man durchaus wörtlich nehmen darf.

Denn während heute praktisch eingesetzte Optical Flow Algorithmen nur relativ wenige Pixel verfolgen und dies meist nicht einmal über eine längere zeitliche Distanz schaffen, soll Omnimotion ALLE Pixel eines Videos über die volle Länge eines Clips zuverlässig tracken können. Und selbstredend sollen Pixel auch zeitweise das Bild verlassen oder von anderen Objekten verdeckt werden können.

Das klingt erst einmal nach einer großlippigen Ansage, doch die zugehörige Website zeigt erstaunliche Ergebnisse des Omnimotion-Projektes. Man kann sogar an einem Live-Beispiel Clip wirkliche beliebige Punkte in einem Online-Video auswählen und sehen, wie diese exakt im Browser Video getrackt werden.

Außerdem beweist das Projekt guten Forschungsstil, indem es auf der Webseite zugleich Failure Cases anführt, bei denen der Algorithmus versagt hat. Bei den gezeigten Beispielen könnte allerdings ein Mensch wahrscheinlich die kritischen Pixel des Rohmaterials nicht mehr eindeutig verfolgen.

Und kaum ist Omnimotion aus der Forschungswelt ins Licht der Öffentlichkeit getreten, stellte eine weitere Gruppe um Google DeepMind und der Oxford Universität ein neues Tracking Verfahren namens TAPIR vor, welches ebenfalls jeden Punkt eines Videos verfolgen kann. Es ist daher anzunehmen, dass diese Trackingmethoden in Kürze auch in kommerzieller Software Einsatz finden werden.

Was bedeutet perfektes Tracking für die Postproduktion?

Tatsächlich liegt im "perfekten Tracking" der Schlüssel zu weiteren qualitätssteigernden Möglichkeiten in der Postproduktion. Kennt man die Position jedes Pixels zu jeder Zeit, so ist dies eine extrem wertvolle Information für die Noise Reduction. Denn an jeder Stelle im Bild weiß der Algorithmus dann, was sich eigentlich an dieser Stelle im Bild befinden sollte - und was bzw. wie viel davon hier genau vom Rauschen überdeckt wird.

Letztlich könnten Omnimotion oder TAPIR die Daten für eine extrem exakte Pointcloud der gefilmten Szene liefern, welche den Rauschanteil jedes Pixels durch sein internes Modell der Szene ziemlich genau bestimmen kann. Dies könnte wiederum in Folge auch ein Relighting weiter qualitativ verbessern, da man von jedem Pixel nun seine Farbe und Helligkeit abzüglich des Rauschens abschätzen kann. Durch das Modell bekommt man als Anwender zudem auch eine sehr gute Schätzung des Z-Puffers, also der Tiefe eines Pixels im Raum, was unter anderem die exakte Berechnung eines synthetischen Bokehs ermöglicht.

Kurz gesagt: Der Computer wird in naher Zukunft jedes Pixel einer Szene sehr viel besser "verstehen" und kann daraufhin die Algorithmen der Postproduktion besser optimieren. Omnimotion und TAPIR sind daher mit Sicherheit ein großer und ausgesprochen relevanter Schritt in der Computational Videography.