Newsmeldung von slashCAM:

<img src="

https://www.slashcam.de/images/texte/16 ... -FRONT.jpg" align=left valign=top border=0 width=130 height=90>Mit dem neuen Firmware-Update beherrscht die Panasonic GH5 nun auch Hybrid Log Gamma (HLG). Warum das spannend werden könnte und was wir dazu schon sagen können lest ihr hier...

Hier geht es zum slashCAM Artikel:

Ratgeber: Hybrid Log Gamma: Erste Eindrücke zum HLG-Format in der Panasonic GH5

Antwort von pmk:

Cool, Vielen Dank für den Tipp!

Ich denke man sollte auch den Lesern zeigen, welche Farbmanagement man in Davinci einstellen soll (Input, Output, Timeline etc...)

Antwort von TheGadgetFilms:

Das ist ja lustig, heute sollte eingentlich mein HLG- Google Tag werden, danke für die tolle Zusammmenfassung!

Antwort von WoWu:

pmk hat geschrieben:

Cool, Vielen Dank für den Tipp!

Ich denke man sollte auch den Lesern zeigen, welche Farbmanagement man in Davinci einstellen soll (Input, Output, Timeline etc...)

Vor Allem sollte man für HLG den entsprechenden Monitor haben, der die Umgebungsbeleuchtung mit berücksichtigt denn HLG legt den Weisspunkt immer auf 50% des Spitzenpegels. Ansonsten sieht man nämlich alles Andere, nur nicht HDR.

Antwort von Silerofilms:

Ich bin in diesem Bereich noch nicht so bewandt. Für mich stellt sich noch immer die essentielle Frage, ist das HLG-Profil nur, wenn man im HLG Bereich mit HLG Geräten arbeitet, oder auch eine Alternative zu den anderen Bildprofilen wie CineD und CineV?

Antwort von blueplanet:

...wie ich es verstanden habe und laut Slashcam-News müssen, wenn man nicht exakt in der "Kette" bleiben will/kann, mindestens zwei Profilwandlungen vollzogen werden, um das Ergebnis am Ende auf einem normalen REC709-Bildschirm/TV wiedergeben zu können bis dahin gehend, dass HLG-File sogar nur direkt aus der Kamera heraus (per HDMI und bereits gewandelt) auf einem handelsüblichen TV betrachtet werden können (wenn dieser nicht auf HLG optimiert ist, REC2020). Insofern ist momentan HLG (wenn die Verarbeitungskette beherrscht wird) eher etwas für die Post bzw. bringt die entsprechenden Reserven. Wer also über die entsprechende Hardware verfügt und den Unterschied zwischen HLG mit 10Bit und V-LOGL mit "9"Bit erkennt, für den es wichtig ist, der kann/sollte darauf zurückgreifen.

Antwort von WoWu:

Das Bildprofil, in dem es hier geht, ist im Grunde genommen nichts Anderes, als eine Variation der Knee Funktion, nur dass ab dem Knickpunkt die Entzerrung nicht linear weiter läuft, sondern einer Funktion folgend.

Benutzt man also die entsprechende Reverse Funktion, kommt in der Post ein entsprechend lineares Bild dabei heraus. (709)

Nutzt man das Signal (so, wie es ist) -mal von Farbraum und 8/10 Bit abgesehen) entspricht es in etwa dem, was im BBC/HLG-HDR Verfahren vorausgesetzt wird, nur dass dabei diverse Funktionen im HDR TV noch mitspielen müssen.

Es wäre also die Bildentzerrung in der Kamera, die, neben der Farbeinstellungen und allen weiteren HDR Parametern, gewählt werden müsste, um auf einem HLG fähigen Endgerät als Eingangssignal gewählt würde.

Das funktioniert aber eben nur auf einem Endgerät, das die interne EOTF so verändert, dass es hinterher auch HDR ist.

Ohne dies Endgerät hat das Ganze nichts mit HDR zu tun sondern ist lediglich eine Variation einer Knee Funktion.

Antwort von DaHo:

Ich bin aktuell auf der Suche nach einem Workflow, der es mir erlaubt Kameraintern für die Post maximal viel „Luft“ für die Bearbeitung herauszuholen.

Da VLog laut euren Tests nicht so wirklich die optimale Lösung darstellt, bin ich daher extrem gespannt wie sich das HLG Profil auch im Vergleich zu CineD etc. verhält.

Mit Resolve lässt sich die HLG Konvertierung ja noch einigermaßen nachvollziehen, da hier zumindest für mich das Farbmanagement logischer aufgebaut ist.

Der Workflow in Premiere scheint mir allerdings weniger nüchtern & technisch.

Habt ihr auch schon Erfahrungen gemacht wie sich das HLG Profil in Premiere wieder auf einen linearen rec.709 konvertieren lässt?

Antwort von WoWu:

Stellt Panasonic dafür keine Reverse Funktion oder eine LUT zur Verfügung ?

Das wäre ja ein schwaches Bild.

Antwort von mash_gh4:

WoWu hat geschrieben:

Stellt Panasonic dafür keine Reverse Funktion oder eine LUT zur Verfügung?

die entsprechende transferfunktion ist doch eh ganz klar spezifiziert und sollte daher in geräte- bzw. herstellerunabhängiger weise in allen endgeräten und videeobearbeitungsprogrammen zur verfügung stehen.(

https://en.wikipedia.org/wiki/Hybrid_Lo ... al_details)

ich persönlich glaube übrigens nicht, dass HLG ein besonder günstiges aufzeichnungsformat für komplexere nachbearbeitung darstellt. mit v-log dürfte man im zusammenhang mit der sauberen wiedergabe bzw. korrekur der farben deutlich bessere resultate erzielen.

Antwort von WoWu:

Kommt immer drauf an, wohin man will.

Meine Erfahrung ist, dass die Knee Funktion (oder so ein Hybrid) die deutlich besseren Ergebnisse bringt (bei deutlich weniger Aufwand), wenn 709 das Ziel ist.

Antwort von Uwe:

mash_gh4 hat geschrieben:

...

ich persönlich glaube übrigens nicht, dass HLG ein besonder günstiges aufzeichnungsformat für komplexere nachbearbeitung darstellt. mit v-log dürfte man im zusammenhang mit der sauberen wiedergabe bzw. korrekur der farben deutlich bessere resultate erzielen.

Genau so sieht's aus!

Antwort von DeeZiD:

mash_gh4 hat geschrieben:

WoWu hat geschrieben:

Stellt Panasonic dafür keine Reverse Funktion oder eine LUT zur Verfügung?

die entsprechende transferfunktion ist doch eh ganz klar spezifiziert und sollte daher in geräte- bzw. herstellerunabhängiger weise in allen endgeräten und videeobearbeitungsprogrammen zur verfügung stehen.(https://en.wikipedia.org/wiki/Hybrid_Lo ... al_details)

ich persönlich glaube übrigens nicht, dass HLG ein besonder günstiges aufzeichnungsformat für komplexere nachbearbeitung darstellt. mit v-log dürfte man im zusammenhang mit der sauberen wiedergabe bzw. korrekur der farben deutlich bessere resultate erzielen.

Das grosse Problem bei V-log bleibt nach wie vor die geringe Ausnutzung des verfuegbaren Farbraums.

In meinen Tests produziert der 6K-Modus (10 Bit, 420, H265) teilweise sichtbares Banding beim Grading, waehrend HLG mit einem fast identischen Grading (Dynamikumfang vergleichbar, aber teils merkwuerdige Farben, nach Colorchecker praktisch identisch mit V-Log) absolut sauber aussieht.

Der 6K Modus ist in sofern interessant, dass dieser endlich keinerlei sichtbare Nachschaerfung mehr anwendet bei -5 Sharpening. Das auf 4k runterskalierte Bild wirkt im Vergleich zum 4K-Material direkt aus der Kamera gar softer. Bin ziemlich angetan.

Antwort von mash_gh4:

DeeZiD hat geschrieben:

Das grosse Problem bei V-log bleibt nach wie vor die geringe Ausnutzung des verfuegbaren Farbraums.

In meinen Tests produziert der 6K-Modus (10 Bit, 420, H265) teilweise sichtbares Banding beim Grading, waehrend HLG mit einem fast identischen Grading (Dynamikumfang vergleichbar, aber teils merkwuerdige Farben, nach Colorchecker praktisch identisch mit V-Log) absolut sauber aussieht.

den color checker kannst du leider in diesem zusammenhang ziemlich vergessen, weil er zu wenig messfelder bietet und nur farben ähnlicher sättigung zeigt. die tatsächlichen probleme mit den farbein bei den meisten panasonic kameraprofilen sind aber viel verzwickter und lassen sich rechnersich leider kaum mehr korrigieren.

DeeZiD hat geschrieben:

Der 6K Modus ist in sofern interessant, dass dieser endlich keinerlei sichtbare Nachschaerfung mehr anwendet bei -5 Sharpening. Das auf 4k runterskalierte Bild wirkt im Vergleich zum 4K-Material direkt aus der Kamera gar softer. Bin ziemlich angetan.

wenn jemand wirklich klar nachweisen könnte, dass es sich dabei tatsächlich um eine nachschärfung im engeren sinn handelt, nicht nur um eine begleiterscheinung der kompresssion, wären wir ja eh schon ein stück weiter, aber auch dann wäre es noch immer ein leichtes, es nachträglich weitestgehend zu eliminieren, wenn es einen stört.

Antwort von Uwe:

Diese Meinung passt auch zum Thema:

https://www.youtube.com/watch?v=-Cw1wqmiUOs&t=300s

Antwort von wolfgang:

WoWu hat geschrieben:

Kommt immer drauf an, wohin man will.

Meine Erfahrung ist, dass die Knee Funktion (oder so ein Hybrid) die deutlich besseren Ergebnisse bringt (bei deutlich weniger Aufwand), wenn 709 das Ziel ist.

Eigentlich braucht man HLG gar nicht nach rec709 zu graden, denn das ist ja auf einem rec709 Sichtgerät ident mit rec709. Das Material clippt halt mehr. So gesehen ein Nullaufwand, wenn man auf die Bildinfos in den oberen Blendenstufen einfach verzichtet.

Es ist trotzdem eher ein klassisches rec709 ähnliches Profil - erweitert im Dynamikumfang, ähnlich zu rec709(800) oder Hypergamma. Heißt - es werden wohl weniger Luminanzwerte in den helleren Blendenstufen zugewiesen als bei einigen log Profilen. Damit holt man vermutlich aus log mit passendem Grading mehr raus - wenn das Ziel eine HDR Darstellung ist.

Antwort von mash_gh4:

wolfgang hat geschrieben:

Es ist trotzdem eher ein klassisches rec709 ähnliches Profil - erweitert im Dynamikumfang, ähnlich zu rec709(800) oder Hypergamma.

naja -- du darst auch nicht übersehen, dass hier normalerweise rec2020 bzw. 2010 farbezugsräume genutzt werden. die sind um so viel umfangreicher als rec709, dass innerhalb des rec709 gamuts maximal die halben werte genutzt werden können -- also auch hier wieder genau jene recht problematischen begeleiterscheinungen auftreten, die wir ja leider auch im zusammenhang mit div. log formaten vielfach diskutiert haben. im übrigen ist ja das HLG material bei der GH5 doch ziemlich hoch komprimiert im vergleich zu anderen aufzeichnungsmöglichkeiten.

Antwort von WoWu:

Man darf die Übertragungsfunktion nicht mit der Wahl der Farbprofile oder der genutzten dynamischen Bandbreite verwechseln.

Das sind unterschiedliche Einstellungen.

Hier geht es aber ausschließlich um die Übertragungsfunktion und bis auf deny Umstand, dass der Weisspunkt tiefer liegt, unterscheidet sich so ein Hybrid nun wirklich nicht wesentlich von 709.

Daher ist für den Anwender zwar die andere Werteaufteilung der oberen Blendenwerte nutzbar aber das Verhalten entspricht deutlich mehr dem, von 709. Nur dass er eben mehr Maketingblenden übertragen kann.

Die Wahl von 8/10 Bit und dem Farbprofil ist davon aber völlig losgelöst, ebenso wie die genutzte Kompression.

Man sollte also die Dinge nicht zu einem Brei vermengen und dann sagen, die Übertragungsfunktion taugt nicht.

Die häufigsten Fehler passieren immernoch hinter der Kamera.

Antwort von mash_gh4:

ich würde dem entgegenhalten, dass es eben

nicht ausreicht, alleine nur die übertragungsfunktion zu betrachten!

die deutlich größeren farbbezugsräume relativen eine höhere genutzte bittiefe ganz massiv und haben leider in der praxis auch hier wieder viel problematischere auswirkung auf die effektive wiedergabe bzw. nachbearbeitbarkeit der farben, als man es auf den ersten blick bzw. unter alleiniger orientierung an offensichtlichen ähnlichkeiten zu vertrauten standards vermuten würde.

Antwort von WoWu:

Also nochmal ...

hier geht es lediglich um die Übertragungsfunktion, also wie ich etwas übertrage und nicht darum, was ich übertrage.

Das ist eine völlig andere Diskussion.

(siehe Überschrift)

Antwort von wolfgang:

mash_gh4 hat geschrieben:

wolfgang hat geschrieben:

Es ist trotzdem eher ein klassisches rec709 ähnliches Profil - erweitert im Dynamikumfang, ähnlich zu rec709(800) oder Hypergamma.

naja -- du darst auch nicht übersehen, dass hier normalerweise rec2020 bzw. 2010 farbezugsräume genutzt werden. die sind um so viel umfangreicher als rec709, dass innerhalb des rec709 gamuts maximal die halben werte genutzt werden können -- also auch hier wieder genau jene recht problematischen begeleiterscheinungen auftreten, die wir ja leider auch im zusammenhang mit div. log formaten vielfach diskutiert haben. im übrigen ist ja das HLG material bei der GH5 doch ziemlich hoch komprimiert im vergleich zu anderen aufzeichnungsmöglichkeiten.

Ja nur ist das eher Theorie. Denn der Umfang, mit dem der GH5 oder auch FS7 Sensor den rec2020 Farbraum tatsächlich abdeckt, ist ja eher beschränkt und nur ein Bruchteil des verfügbaren Farbraums. Und wie sehr die höhere 10bir high profile H.264 Kompression dann beim Graden tatsächlich stört ist die Frage - bzw. was hier der Unterschied zwischen HLG und v log l wäre.

Antwort von mash_gh4:

wolfgang hat geschrieben:

Ja nur ist das eher Theorie. Denn der Umfang, mit dem der GH5 oder auch FS7 Sensor den rec2020 Farbraum tatsächlich abdeckt, ist ja eher beschränkt und nur ein Bruchteil des verfügbaren Farbraums. Und wie sehr die höhere 10bir high profile H.264 Kompression dann beim Graden tatsächlich stört ist die Frage - bzw. was hier der Unterschied zwischen HLG und v log l wäre.

das problem ist weniger dem umstand geschuldet, welcher farbraum tatsächlich abgedeckt wird -- obwohl übliche sensoren, in der tat sehr viele farben erfassen, die sich auf den gebräuchlichen wiedergabegeräten bzw. den dort benutzen übertragungsstandards nicht übertragen lassen --, sondern das eben sehr viele werte, die in rec2020/2100 vorgesehen sind, einfach brach liegen, wenn man nur den rec709 bereich nutzen will.

ich geb dir zwar recht, dass das im konkreten fall nicht wirklich wesentlich dramatischer ausfällt als bei v-log bzw. eben v-gamut als dem darin benutzem farbbebezugssystem, trotzdem sind die realen troubles die man bereits dort bebachten konnte, eben leider nicht nur der schlechten ausnutzung möglicher werte im luma-transfer geschuldet, sondern eben auch genau diesem ineffizienten umgang mit den möglichen übertragungswerten der farbinformation. und da bei HLG bereits ein großer teil der hinzugekommen bittiefe ausschließlich für die highlights reserviert ist, zeigen sich die farbspezifischen abstufungsprobleme hier vermutlich fast so schlimm wie bei 8bit v-log.

aber in wahrheit sollte einem das ohnehin nicht zu viel kopfzerbrechen bereiten, weil die entsprechende aufzeichnungsmöglichkeit ohnehin nicht für das ernsthafte nachbearbeiten und produzieren vorgesehen sein dürfte, sondern ungefähr so primitiv funktioniert bzw. für eine direktes abspielen auf entsprechenden abspielgeräten vorgesehen ist, wie es vor ein paar jahren die 3D aufnahmemöglichkeiten in den GHx kameras waren. auch damit hat vermutlich niemand ernsthaft entsprechende produktionen abgewickelt, trotzdem hat es vermutlich den kunden entsprechender consumer abspielgeräte wenigstens das gefühl vermittelt, dass sie nun plötzlich zumindest prinzipiell in der lage wären, derartiges auch mit ihrem equipment ganz einfach zu bewerkstelligen.

Antwort von WoWu:

„in wahrheit sollte einem das ohnehin nicht zu viel kopfzerbrechen bereiten, weil die entsprechende aufzeichnungsmöglichkeit ohnehin nicht für das ernsthafte nachbearbeiten und produzieren vorgesehen sein dürfte, sondern ungefähr so primitiv funktioniert bzw. für eine direktes abspielen auf entsprechenden abspielgeräten vorgesehen ist, wie es vor ein paar jahren die 3D aufnahmemöglichkeiten in den GHx kameras waren. auch damit hat vermutlich niemand ernsthaft entsprechende produktionen abgewickelt, trotzdem hat es vermutlich den kunden entsprechender consumer abspielgeräte wenigstens das gefühl vermittelt, dass sie nun plötzlich zumindest prinzipiell in der lage wären, derartiges auch mit ihrem equipment ganz einfach zu bewerkstelligen.“

Hääää?

Und ob damit Produktionen abgewickelt wurden .... jede Menge, denn solche „Hyper Funktionen“ gibt es seit den frühen 90er Jahren, nur dass sie damals nicht so „hippe“ Bezeichnungen hatten.

Diese Funktionen wurden bereits 1989 von Sony in die „SMPTE Working Group on High-Definition Electronic Production (WG-HDEP)“ eingebracht und gehören im kommerziellen Bereich seitdem zum Standartrepertuar.

Antwort von wolfgang:

Nicht nur die Sichtgeräte decken heute im besten Fall knappe 100% des DCI P3 Raums ab. Auch die heutigen preiswerteren Sensoren können nicht unbedingt viel mehr.

Nur wird das kaum getestet und publiziert, was die Sensoren hier wirklich können.

Beim Vergleich zwischen HLG und v log l gehts aber auch darum, wie viele Werte pro Stop zugewiesen werden. Und da schauts vermutlich bei den oberen Stops im Fall von HLG eher dürftig aus, was ja ok ist wenn man die Mitteltöner als wichtiger ansieht. Nur das gilt nicht immer.

Antwort von mash_gh4:

wolfgang hat geschrieben:

Nicht nur die Sichtgeräte decken heute im besten Fall knappe 100% des DCI P3 Raums ab. Auch die heutigen preiswerteren Sensoren können nicht unbedingt viel mehr.

das ist leider eine ziemlich komplizierte sache, weil es in wahheit eben nicht einfach reicht die drei entsprechenden eckpunkte bzw. primaries in eine CIE diagramm einzutragen und ein dreick darüber zu zeichnen, sondern unter einbeziehung der tatsächlichen spektralen sensibilität viel kompliziertere betrachtungsweisen notwendig sind.

tatsache bleibt, dass man bei den sensoren bzw. scene referred ausgangsdaten vergleichsweise große farbräum erfasst, die dann aber mittels gamut kompression in die viel kleineren gebräuchlichen display referred formate gepresst werden. meist geschieht das in denkbar vereinfachter und unbefriedigender weise, weshalb es dann auch solche schwierigkeiten gibt, die farben wieder tatsächlich korrekt darzustellen bzw. umzurechnen.

wolfgang hat geschrieben:

Beim Vergleich zwischen HLG und v log l gehts aber auch darum, wie viele Werte pro Stop zugewiesen werden. Und da schauts vermutlich bei den oberen Stops im Fall von HLG eher dürftig aus, was ja ok ist wenn man die Mitteltöner als wichtiger ansieht. Nur das gilt nicht immer.

das mit der guten darstellung der mitteltöne war ja auch schon bei log vs. rec709 immer ein ganz gutes pragmatisches argument, aber wie gesagt, man darf sich leider einfach nicht nur an diesen simplen eindimensionalen kurven des helligkeitsverlaufs orientieren.

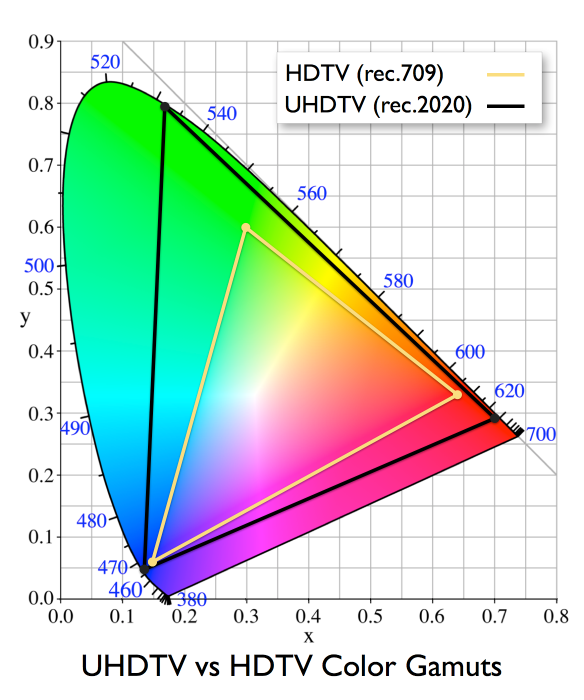

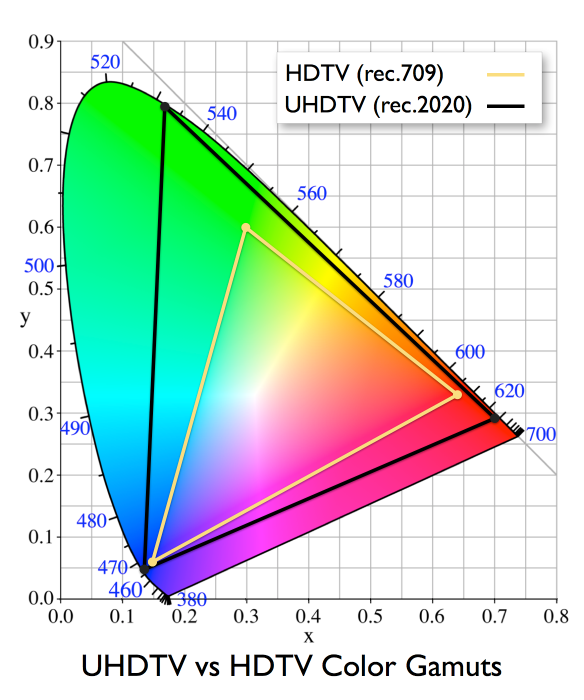

wenn du dir ein diagramm anschaust, wo die beiden hier zur frage stehenden farbräume übereinander gelegt werden:

und du den eckpunkten bzw. primärfarben des größeren farbraums jeweils den maximalwert 1.0 zuordnest, kann innerhalb des kleineren rec709 bereichs eben im grün und rot kanal nur werte genutzt werrden, die deutlich kleiner sind. ein verhältnismäßig großer teil an werten muss also ganz bewusst ausgeklammert bzw. unbenutzt bleiben, wenn man die farben nicht völlig verbiegen will. dass ist war im grunde nicht wesentlich komplizierter nachzuvollziehen als die ungenutzen wertebereiche in der v-log luma übertragungsfunktion, trotzdem bleibt dieser aspekt in der diskussion meist ausgeklammert. in wahrheit sind aber die tatsächlichen probleme beim graden -- das sichtbar werdende von störenden sprüngen bzw. stufen in den farbübergängen beim aufsteilen des kontrasts -- oft viel mehr mit diesem sachverhalt in verbindung zu bringen als mit der bloßen betrachtung der eindimensionalen übertragungsfunktionen bzw. zur verfügung stehendem umfang an übertragungswerten.

Antwort von wolfgang:

Es schaut sich ja keiner nur den Helligkeitsverlauf an, sondern wir reden hier von der tatsächlichen Abdeckung des Farbraums. Und dazu kenne ich natürlich seit langer Zeit die auch von dir gezeigten netten Diagramme des grundsätzlichen Farbraumumfangs, aber ich würde mal gerne echte Messungen sehen was davon die Kameras in der Aufnahme abdecken können.

Denn das könnte weniger sein als viele glauben. Selbst zum FS7 Sensor wird da von Leuten wie Alister Chapman nur gesagt, es sei (nach seiner Einschätzung) in etwa DCI P3 - aber Messplots kenne ich eben keine.

Antwort von mash_gh4:

wolfgang hat geschrieben:

Es schaut sich ja keiner nur den Helligkeitsverlauf an, sondern wir reden hier von der tatsächlichen Abdeckung des Farbraums. Und dazu kenne ich natürlich seit langer Zeit die auch von dir gezeigten netten Diagramme des grundsätzlichen Farbraumumfangs, aber ich würde mal gerne echte Messungen sehen was davon die Kameras in der Aufnahme abdecken können.

Denn das könnte weniger sein als viele glauben. Selbst zum FS7 Sensor wird da von Leuten wie Alister Chapman nur gesagt, es sei (nach seiner Einschätzung) in etwa DCI P3 - aber Messplots kenne ich eben keine.

wie gesagt: ich spreche hier nur über die mögliche/genutzte werteverteilung in den anzeigebezogenen üblichen farbbezugssystemen.

und das tu ich nicht ohne grund, den vereinfachende aussagen, wie die von Alister Chapman, liegen hier leider einfach ganz grundsätzlich daneben. eine erklärungen dafür findest du bspw. hier:

http://www.color-image.com/2012/08/a-di ... lor-gamut/

https://www.rit.edu/cos/colorscience/rc ... q3.php#255

Antwort von wolfgang:

Gut. Wenn also unsere Kameras keinen Color Gamut haben, dann reicht es aus hier die Luminanzverteilung in der Übertragungsfunktion zu betrachten. Und wenn man graden will halte ich log für besser. HLG ist ja dann für die Endausgabe sinnvoll wenn man will.

Antwort von Rick SSon:

Vollkommen egal was man anstellt, der DR der Panasonic bleibt klein.

Das ist ungefähr so als wuerde man via Softwareupdate eine DTS Aufzeichnung vom intenen Mic bekommen. Klingt dann immernoch dünn :D

Antwort von wolfgang:

"Rick SSon" hat geschrieben:

Vollkommen egal was man anstellt, der DR der Panasonic bleibt klein.

Das ist ungefähr so als wuerde man via Softwareupdate eine DTS Aufzeichnung vom intenen Mic bekommen. Klingt dann immernoch dünn :D

Da hast durchaus recht - und es macht einen in der Praxis enormen Unterschied ob man um die 10 oder 14 Blendenstufen hat. Den mit 14 ist man langsam in der Gegend des menschlichen Auges - was heißt das die Kamera bei 14 oder 16 Stufen ähnlich viel aufzeichnet als man selbst vor Ort sieht. 10 sind eben nich zu wenig.

Antwort von Uwe:

"Rick SSon" hat geschrieben:

Vollkommen egal was man anstellt, der DR der Panasonic bleibt klein.

...

Vielleicht nur halb richtig. Der Dynamikumfang der Kamera an sich bleibt natürlich gleich. Bei den "normalen Modi " wahrscheinlich so um die 10 stops und bei V-Log bestenfalls 12. Aber das, was sie bei einem HDR/HLG workflow in der post auf einem HDR-Bildschirm ausgeben kann liegt höher. Die geschätzten 17 stops von den Jungs bei der CRFTSHO halte ich da vielleicht auch ein bisschen für übertrieben, aber 15 müssten es schon sein...

Antwort von WoWu:

Das ist kompletter Käse.

Der Dynamikumfang bleibt gleich. Der wird nämlich durch den Sensor bestimmt (SNR und FullWell).

Damit bleibt auch der Abstand zum Systemweiss unverändert, egal welche Übertragungsfunktion genutzt wird.

Dass ein HDR Fernseher zusätzlich die Hintergrundbeleuchtung abdunkelt und so ein höherer Dynamkeindruck auf Kosten der Nuancierung entsteht, der immer mit „mehr Blenden“ verwechselt wird, ist ein ganz anderes Thema.

Fakt ist, dass, egal welche Übertragungsfunktion genutzt wird, sich der Dynamikumfang der Kamera nicht verändert. Lediglich die Wertemengen pro Blende werden verringert und so entsteht der Anschein einer höheren Dynamik auf Kosten der eingeschränkten Nachbearbeitbarkeit (Marketingblenden).

Antwort von wolfgang:

Also der Dynamikumfang hängt nach allen Meinungen vom Sensor alleine ab. Kann oder übertrifft eine Übertragungsfunktion diesen Wert dann wird der maximal mögliche Dynamikumfang aufgezeichnet.

Und der liegt bei der GH4/5 halt ungefähr bei 10, mehr ist das nicht. Was übrigens der Grund ist dass v log l oben so abgeschnitten ist, da v log für die höherwertigeren Varicam Sensoren ausgelegt ist, die eben ein paar Stops mehr können.

Antwort von Uwe:

Tja Leute, ich will euch da gar nicht widersprechen. Für mich ist aber Fakt, dass ich auf meinem HDR-TV einfach mehr Dynamikumfang sehe als auf meinem "ordinären normalen Nicht HDR-Monitor". Vor allen Dingen in den hellen Bereichen. Da sind feinste helle Wolkenstrukturen nicht zu sehen, die ich aber auf dem HDR-Bildschirm sehe. Genauso saufen Details in den Schattenbereichen ab, wo ich aber beim TV noch Details sehe. Wie dem auch sei, es ist alles noch ziemlich neu und braucht wohl noch etwas Zeit bis man alles genau in der Praxis ausgetestet hat. Ich bin da natürlich auch am Ball, aber eins ist dabei auch klar: ohne einen ordentlichen HDR-Monitor bekommt man doch teilweise unerwartete Ergebnisse - im negativen Sinn. Hoffentlich kann uns da die Industrie bald was in der Preislage so um die 1500,- anbieten. Zum Schluss nochmal ein Auszug aus dem Slashcam Test:

Nachdem das Signal nonlinear in 10 Bit im Glossar erklärt aufgezeichnet wird, kann HLG auf jeden Fall mehr als 10 Blendenstufen speichern. Doch schon die Frage welchen Dynamic Range HLG eigentlich genau umfasst ist nicht einfach zu beantworten. Denn HLG will bei der Wiedergabe seine Signalwerte relativ interpretiert wissen (scene-referred), und nicht absolut wie PQ. Auf einem helleren HLG-Display sind deswegen 100 Prozent Weißpegel dann auch wirklich heller als auf einem dunkleren HLG-Display. Und somit hängt der Dynamikumfang des Signals bei der Wiedergabe vom Display ab.

Wenn HLG auf einem 2.000 Nits Display mit 10 Bit/Pixel wiedergegeben wird, hat es einen Dynamikumfang von 200.000:1 oder 17,6 Stopps. Auf einem 1.000 Nits Display wären es noch über 16 Stops und bei 500 Nits läge man noch über 15 Blendenstufen

Antwort von wolfgang:

Na sicher brauchst ein gutes HDR Display für den Schnitt, das steht außer Diskussion. Und es ist auch unbestritten dass man erst mit einen HDR Display in den oberen aber auch unteren Blendenstufen erkennbare Durchzeichnung bekommt. Und vieles ist heute sicher noch unklar, auch ok.

Wo ich mir nicht so sicher bin an dem slashcam Statement das ist deren Rechnerei mit Blendenstufen. Denn weiss ist und bleibt bei 100 nits, und bei richtig justierten Geräten sind 100nits eben 100nits. Und eine Verdoppelung der nit-Anzahl ist eine Verdoppelung der Helligkeit, und damit ein Blendensprung. Wenn also ein Gerät 1000nits kann, was eh oft genug nicht wahr sein dürfte, aber wenn das so ist dann hast mit 200nits die erste, bei 400nits die zweite, bei 800nits die dritte Blendenstufe über weiss. Es werden also nicht viel mehr als drei Blendenstufen über weiss nach oben sein können, bei OLEDs noch weniger. Und das kannst beim Filmen mit ETTR und einem damit stimmigem Graden halbwegs auffüllen. Das ist aber ok, bei rec709 hattest ja in Summe nur 6 Stufen.

Antwort von Roland Schulz:

Also, der erfassbare Dynamikbereich des Sensors einer Kamera verändert sich durch die nachgeschaltete Übertragungsfunktion nicht (!!), sehr wohl kann aber die Übertragungsfunktion den abbildbaren Dynamikumfang "einer Kamera" vergrößern, nämlich dann wenn bisher verfügbare Standardgammakurven (REC709...) zugunsten von subjektiv "besserer" Wiedergabe bzw. zur übergreifenden Standardisierung den aufgenommenen Kontrastumfang in Richtung höherer Kontrast verbiegen bzw. bescheiden.

Weiter kann ein "Fernsehgerät" eine aufgenommene Szene in einem höheren Dynamikumfang wiedergeben als ihn die Kamera aufgenommen hat bzw. als die Szene an Dynamik überhaupt besessen hat. Es fehlen dann ggf. zwar Zwischenabstufungen, aber spätestens nach der Popularität von LOG Gammakurven sollte den meisten klar sein, dass die "fließende" Abbildung ohne "Abrisse"/gleichmäßigen Abstufungen keine zwingende Vorraussetzung ist.

So kann z.B. ein Sony ZD9 lt. Messung von audiovision einen Schwarzwert von bis zu 0,006cd darstellen ("mich" würde trotzdem mal interessieren wie das gemessen wurde...), im 10% Fenster reicht die Helligkeit dann bis zu 1825cd, entspricht somit einem Kontrastverhältnis von >300.000:1/18 Blenden das selbst in statischen Bildern theoretisch zu erreichen ist weil der Fernseher über fokussiertes Lokal Dimming (~1000 Areas) verfügt.

In Wirklichkeit wird aber selbst dort das visuelle Erlebnis durch interne Reflexionen des Displays, besonders über kurze Objektabstände der Darstellung bzw. durch Reflektionen im Raum und Fremdlicht verringert. Trotzdem liegt der gemessene ANSI Kontrast bei immerhin noch 2150:1 und damit über 11 Blenden!! Bei Spitzlichtdarstellungen wird (~10% Fenster/geringere Gesamtstromaufnahme...) wird deutlich mehr möglich sein und hängt von der Betrachtung der Situation/Prüfverfahren ab.

Weiterhin sollte man langsam mal die klassischen Ansichten über den Haufen werfen die besagen, dass sich der Kontrastumfang eines (Kamera-)Systems (!!) zwischen Rauschen und Sättigung des Sensors erstreckt. Das ist nur theoretisch für die kleinste abbildbare Größe (ein Pixel) über die Auswertezeit (Periodendauer Bildfrequenz) richtig. Praktisch sieht das so aus, dass Rauschunterdrückungssysteme UND Kompressionscodecs ähnliche Pixelbereiche zusammenfassen und/oder bereichsweise mitteln und ggf. sogar über mehrere Frames integrieren, somit statistisch wieder näher an den ursprünglichen Wert kommen und damit den realen Wert trotz vergleichsweise großer Rauschamplitude besser wiedergeben können als es diese zulassen würde.

Mich wundert zudem dass vor gar nicht so langer Zeit noch 6 durch das Auge sichtbare Blenden als Maximum verteidigt wurden, obwohl ein von mir vorgestellter, nachvollziehbarer Versuch deutlich mehr aufzeigte, hier eingangs 14 Blenden dargestellt werden welche plötzlich mit keinem Wort mehr in Frage gestellt werden ;-)! "Fortschritt" halt...

Antwort von TheGadgetFilms:

Was mir zum Verstehen jetzt auch sehr geholfen hat, war dieses Video: https://youtu.be/dvTYhWkBXaU

Eines ist mir aber noch nicht ganz klar, wenn hlg ein deilvery Format ist, kann man dann nicht in Premiere mit "nicht-hlg Footage", die ja auch einen hohen Dynamikumfang hat, ein Projekt erstellen in hlg oder es dann in hlg exportieren zur Darstellung auf einem HDR Monitor in HDR? War das verständlich..?

Antwort von Uwe:

TheGadgetFilms hat geschrieben:

... Eines ist mir aber noch nicht ganz klar, wenn hlg ein deilvery Format ist, kann man dann nicht in Premiere mit "nicht-hlg Footage", die ja auch einen hohen Dynamikumfang hat, ein Projekt erstellen in hlg oder es dann in hlg exportieren zur Darstellung auf einem HDR Monitor in HDR? War das verständlich..?

Das geht mit Davinci Resolve , aber mit PP 2018 noch nicht - wird aber kommen. Was man natürlich machen kann ist in PP schneiden und dann rüber schicken nach DR + als HDR/HLG exportieren. Ob's Sinn macht kann ich derzeit noch nicht sagen. Ich hab z.B. ein älteres Cinelike D-Projekt über Cineform 10bit nach DR geschickt und als HDR rausgerendert. Ich bin mir sicher, dass mind. 80% hier die SDR-Version besser finden würde. Aber ich kann's nicht oft genug wiederholen, es ist alles noch am Anfang... ;-)

Antwort von TheGadgetFilms:

Alles klar, dank dir!

Okay dann lag ich ja gar nicht so falsch.

Ja dieses Mal hab ich schon Bock das von Anfang an zu verstehen, sieht mir zukunftsträchtig aus ;)

Antwort von WoWu:

HLG ist einfach nur eine Übertragungsfunktion.

Es ist zwar die Funktion für ein HDR Verfahren, aber wo Du sie anwendest, bleibt Dir überlassen.

Du kannst auch nach einem linearen Workflow nach HLG entzerren und anschließend darstellen, oder in HLG arbeiten ( dann musst Du nur im Monitoring) linearisieren, weil Du sonst kein anständiges Monitorbild hast.

Du musst Dich nur in Bezug auf den Farbraum entscheiden, oder hinterher wandeln.

Antwort von TheGadgetFilms:

Wäre das denn egal ob vorher oder hinterher?

So spontan würde ich glaube ich direkt alles im Ausgabefarbraum zusammenbasteln

Antwort von WoWu:

Du musst nur bedenken, wenn Du aus einem linearen Kameraweg kommst, dass der Weisswert bei 90% liegt. Wenn Du hinterher auf HDR willst und Du senkst Dir den Weisswert ab dann hast Du oben trotzdem keine Zeichnung mehr im hellen Bereich, weil die Kamera das bereits gestaucht hat.

Du bekommst zwar auch in HDR den maximalen Weisswert angefahren, aber die Nuancen im Weissbereich sind geringer, gegenüber HLG im Aufnahmeverfahren.

Kommst Du hingegen aus einer LOG Bearbeitung (z.B. S-log 2), für die es auch entsprechende reverse Funktionen gibt, sieht das schon wieder ganz anders aus.

Aber grundsätzlich unterscheidet sich HLG nicht so wesentlich von 709 mit einem Knee.

Mir ist auch nicht klar, warum HLG schwerer zu graden sein soll, weil Du in den kritischen Bereichen sowieso linear bist und sich das „schwierige“ Grading lediglich auf den hellen Bereich bezieht.

Antwort von Uwe:

Die Unterschiede sind nicht so groß. Wo viel Farbe ist, sieht man es deutlicher. Hab mal auf die Schnelle 2 kurze Test-Clips bei YT hochgeladen (werden nach 1-2 Tagen wieder gelöscht): der Erste HLG nach Rec709 mit der Leeming-Lut und dem Ausgleich der Lichter in PP; der Zweite aus DR14 nach DNxHR HQX (10bit)...dann mit Hybrid nach H265 für YT. Das ist wirklich ein ganz grober Vergleich und man könnte an einigen Stellen noch "rumdrehen".....

https://www.youtube.com/watch?v=0tdF6AM_Wp0

https://www.youtube.com/watch?v=VinRhkcQiqQ&feature=youtu.be

Antwort von wolfgang:

Es sagt keiner dass es schwer zu graden ist. Es ist eher ungünstigt wenn man hlg graded - da auf die oberen Blendenstufen weniger Werte entfallen alsbeu den log Transferfunktionen.

Antwort von WoWu:

Chapman sagt das in dem Video...

Das einzige Problem zwischen Dem HLG von panasonic und der HLG delivery der BBC sehe ich darin, dass Panasonic den Weisspunkt bei 70% legt und die BBC bei 0,5 Videopegel, also bei der halben MAXFall.

Der Bezug muss bei HDR Grading allerdings berücksichtigt werden.

Antwort von wolfgang:

Nein er sagt dass er HLG nicht zum Graden empfiehlt. Mit MAXFall hat das allerdings rein gar nichts zu tun.

Antwort von WoWu:

Das weiß ich auch. Und wenn er sagt, es sei nicht zum Graden, dann ist das genau, was ich oben gesagt habe.

Was MaxFall betrifft, ist das HLG Material eben nicht 1:1 für HDR geeignet, weil der Weisswert nochmal um 20% abgesenkt werden muss, wenn das Material für HDR übergeben werden soll.

Insofern ist auch das Material aus der Kamera, wenn es direkt in einem HDR TV abgespieltes werden soll, noch gar nicht mit dem Standard konform und führt zu einer falschen Bild.

Antwort von Bruno Peter:

WoWu hat geschrieben:

Was MaxFall betrifft, ist das HLG Material eben nicht 1:1 für HDR geeignet, weil der Weisswert nochmal um 20% abgesenkt werden muss, wenn das Material für HDR übergeben werden soll.

Insofern ist auch das Material aus der Kamera, wenn es direkt in einem HDR TV abgespieltes werden soll, noch gar nicht mit dem Standard konform und führt zu einer falschen Bild.

Genauso verstehe ich es auch!

Antwort von wolfgang:

WoWu hat geschrieben:

Was MaxFall betrifft, ist das HLG Material eben nicht 1:1 für HDR geeignet, weil der Weisswert nochmal um 20% abgesenkt werden muss, wenn das Material für HDR übergeben werden soll.

Insofern ist auch das Material aus der Kamera, wenn es direkt in einem HDR TV abgespieltes werden soll, noch gar nicht mit dem Standard konform und führt zu einer falschen Bild.

MaxFALL ist der maximal zulässige durchschnittliche Helligkeitswerte eines Frames den ein Display kann - und überschreitet ein Bild MaxFALL, dann muss die Helligkeit beim Graden abgesenkt werden. Das stimmt. Es ist eine Begrenzung aus der heutigen Displaytechnologie, da ein Display nur abregeln kann wenn dieser Grenzwert erreicht wird. Daher ist darauf beim Graden zu achten.

Allerdings ist der mittlere Helligkeitswerte eines Frames vom Bildmotiv und dessen aufgezeichneten Helligkeit abhängig, aber nicht von der Transferfunktion. Und damit gilt MaxFALL sowohl für PQ wie für HLG. Anders herum: das ist nicht auf HLG begrenzt sondern gilt generell für HDR und hat nur mit den Displaybegrenzungen zu tun.

Selbstverständlich läßt sich aber HLG Material von einer passenden HLG Kamera direkt in ein HDR Display einspielen ohne eine Luminanzabsenkung zu machen, wenn das Display HLG unterstützt und MaxFALL nicht erreicht wird. Schließlich ist HLG in der BBC Variante in ARIB STD-B67 standardisiert, erlaubt einen Helligkeitsumfang von 0.01 nits bis 5000 nits, und ist im Gegensatz zu PQ ein vollständig definiertes Format, auch Displayseitig.

Es ist daher nicht richtig dass HLG nicht standardisiert sei, grundsätzlich zu falschen Farben führen würde oder dass eine Luminanzabsenkung generell notwendig wäre.

Antwort von WoWu:

Wie schön, dass Du auf das HLG von Panasonic erst gar nicht eingegangen bist sondern nur das Etikett mit einander vergleichst, aber keine Inhalte.

Das ist wie mit 4K ... Hauptsache, es steht drauf.

„HLG defines a nonlinear transfer function in which the lower half of the signal values use a gamma curve and the upper half of the signal values use a logarithmic curve.

where E is the signal normalized by the reference white level and E' is the resultier nonlinear signal

where r is the reference white level and has a signal value of 0.5

where a = 0.17883277, b = 0.28466892, and c = 0.55991073

The signal value is 0.5 for the reference white level while the signal value for 1 has a relative luminance that is 12 times higher than the reference white level. ARIB STD-B67 has a nominal range of 0 to 12. HLG uses a logarithmic curve for the upper half of the signal values due to Weber's law.“

( Formel, auf die sich die Werte beziehen, hab ich hier weggelassen)

Ich stelle also fest, dass der Weisspunkt (ref white) - wie schon erwähnt - bei 50% des maximalen Weisspegels liegt.

Und .. na klar, kannst Du solche Kamerakurven auf jeden Fernseher drücken ... was dann dabei herauskommt ist alles Andere als korrekt.

Der Weisspunkt des Panasonic HLGs liegt aber bei 70%.

Ansonsten hat sich auch Elister Chapmen um 20% geirrt.

Also ... nicht nur aufs Etikett schauen, sondern auch mal danach, was drin ist.

Antwort von wolfgang:

Nur einen Text abzuschreiben macht eine falsche Behauptung nicht richtiger. Und vor allem eine absurde. Denn du sagst dass man HLG Material aus einer HLG Kamera im Weißpunkt absenken muss - und das ist völliger Unsinn. Richtig belichtet ist das HLG Material unmittelbar für die Einspielung in eine HLG Gerät nutzbar. Und von einer richtigen Belichtung geht ja selbst der Kollege Wunderlich aus, nicht wahr?

Es ist richtig dass bei allen Arten von log-Kurven und auch PQ und HLG der Graupunkt und der Weißpunkt tiefer liegen als bei rec709. Nur das ist bekannt und trivial und in der Praxis - mal wieder - völlig irrelevant. Man stellt eben den Graupunkt oder den Weißpunkt dort ein, wo die Transferfunktion das definiert - und hat damit den zusätzlichen Freiraum für die Highlights.

Diese Art von Ablehnung dieser Transferfunktionen ist recht wunderlich.

Antwort von WoWu:

Genau davon spreche ich ... ref. Weiss liegt in der Übertragungsfunktion der HdR Übertragung bei 50% des maximal Weisspegels, wie unschwer aus rec 2100 (und auch der von Dir zitierten Japanischen Standardisierten STD-B67) zu ersehen ist.

Jetzt bemängelst Du Deine eigene Angabe und behauptest, die Daten aus STD-B67 seien falsch.

Du solltest Dir überlegen, was Du sagst und keine Standards anführen, deren Inhalt Du nicht kennst.

Bei der Panasonic HLG liegt ref. Weiß dahingegen bei 70%.

Du solltest den Alister Chapman Link vielleicht auch einmal anschauen, statt hier (irrelevante) Vorträge über Belichtung zu halten und in Deine alte Polemik zu verfallen.

Antwort von mash_gh4:

WoWu hat geschrieben:

ref. Weiss liegt in der Übertragungsfunktion der HdR Übertragung bei 50% des maximal Weisspegels, wie unschwer aus rec 2100 (und auch der von Dir zitierten Japanischen Standardisierten STD-B67) zu ersehen ist.

...

keine Standards anführen, deren Inhalt Du nicht kennst.

Bei der Panasonic HLG liegt ref. Weiß dahingegen bei 70%.

ich glaube, da liegt ein missverständnis deinerseits vor, wenn du panasonic eine derart

gravierende abwweichung von der norm zu unterstellen versuchst.

am ehsten trifft es wohl das ganze einfache erklärung:

"The BBC HLG standard doesn't use a specified reference white point in nits, but instead places it at 75% of the input signal."

hier: https://www.lightillusion.com/uhdtv.html

was anderes erzählt und der chapman auch nicht...

aber, um es noch ein bisserl komplizierter zu machen, hier auch nocheinmal fast der gleiche artikel von steve shaw, wo an genau dieser einer stelle eine änderung vorgenommen wurde:

http://www.murideo.com/news/what-you-ne ... dr-hlg-wcg

wäre interessant zu wissen, woher die unstimmigkeiten stammen? die unterschiede zw. den betreffenden formeln in BT.2100-0 und BT.2100-1 scheinen es nicht zu erklären...

Antwort von WoWu:

Tja, der Standard spricht da eine andere Sprache und legt ihn sehr genau bei 50% unterhalb des Spitzenpegels fest.

https://www.itu.int/dms_pubrec/itu-r/re ... !PDF-E.pdf

Dann bleibt es wohl eine Frage, wem man mehr glaubt, einer Internetveröffentlichung, die dazu auch noch widersprüchlich ist :

„The BBC HLG standard doesn't use a specified reference white point in nits, but instead places it at 0.5 (50%) of the peak luminance.“

oder einem Standard, in dem es sogar in zwei Versionen (BT.2100 / STD B67) identisch mit 50% angegeben ist.

Ich halte mich da eher an den Standard.

Antwort von mash_gh4:

eine interessante praktische umsetzung dieser diskrepanzen findest sich auch in der letzten aktualisierung von LUTCalc (v1.3 vom 1. juni 2017):

"I have also included options with HLG to choose exposure scaling between the standard (90% white target maps to 50% HLG) and the BBC suggested reference (90% white target maps to 73%)."

Antwort von WoWu:

Vielleicht bezieht sich das auf ihre hausinterne Akquisition, zumal die BBC ja auch Hausabneher von Panasonic ist und gern mal ihre eigene Regel aufstellt.

Antwort von Uwe:

Weißpunkt 50%, 70%... Ich schau mir die Original-HLG (HEVC) der GH5 auf dem HDR-Monitor/TV an und alles sieht gut und richtig belichtet aus...

Antwort von WoWu:

Na dann ist ja alles gut ... dann muss man jetzt nur noch den Standard ändern, wenn bei Dir alles stimmt ;-)

Fernsehen ist eben eine Frage des Geschmackes.

Meine Großmutter hatte den Kontrast auch immer am Anschlag und fand, alles sieht gut aus.

Antwort von mash_gh4:

WoWu hat geschrieben:

Vielleicht bezieht sich das auf ihre hausinterne Akquisition, zumal die BBC ja auch Hausabneher von Panasonic ist und gern mal ihre eigene Regel aufstellt.

und nur so am rande: der chapman redet im oben verlinkten video eigentlich gar nicht über panasonic kameras, sonder demenstriert das ganze an hand von sony-gerätschaften und deren HLG umsetzung ;)

aber das die BBC bei der tatsächlichen HLG ausstrahlung andere konventionen nutzt, um die kompatibilität mit rec709 empfangs- bzw darstellungsgeräten besser zu gewährleisten, schließe ich nicht aus. ich hab nur noch immer keine konkreten anhaltspunkte gefunden, wo das näher erklärt werden würde...

Antwort von WoWu:

vermutlich spielt das für Material, dass man der BBC zuliefert auch keine Rolle ... ich denke mal, dass das ihre eigenen Spezifikationen sind, so wie die ARD sich ziemlich zickig mit MXF dateien anstellt.

Aber Fakt bleibt, dass das Panasonic HLG und die HLG Übertragungsfunktion für HDR voneinander abweichen und für Produktionsfirmen, die auch andere Broadcaster bedienen, ist der Standard die Referenz.

Antwort von mash_gh4:

ich glaube, ich hab jetzt endlich eine vernünftige erklärung bzw. fundierung in entsprechenden standards für diese missverständnisse gefunden:

zum Bild

siehe: http://www.itu.int/pub/R-REP-BT.2408-2017/en

aber bzgl. der praktisch relevanz finde ich folgende erklärungen noch viel treffender:

https://www.youtube.com/watch?v=6OWs75BLCAA

Antwort von WoWu:

Jau, alles klar, er sagt auch, dass HLG nicht dem Standard entspricht ...“you’re not longer a standard...“

Er sagt auch klar, dass das BBC Konzept eher eine hauseigene Entwicklung ist.

Das bedeutet für Produktionshäuser, dass sie, sofern sie für HDR10 oder 10+ oder Dolby vision arbeiten, also für alle Systeme, die dem Standard entsprechen, die Korrektur vornehmen müssen.

Alles klar.

HLG ist kein Standard.

Danke für die zusätzliche Info.

Antwort von mash_gh4:

naja -- das interview ist schon ein bisserl älter, aber die verlinkten bt.2408 empfehlungen und referenzwerte sind dafür wirklich ganz aktuell!

ich würde so etwas schon als standard ansehen....

deine diesbezüglichen schwierigkeiten stammen wohl eher daher, dass du alte überkomme konventionen der fensehtechnik einfach auch auf HLG umzulegen versuchst. das geht nur bis zu einem gewissen grad. irgendwann muss man dann immer grundsätzlicher umdenken, wenn man solche entwicklungen vernünftig erfassen will.

Antwort von WoWu:

nee nee keine „alten“ Konventionen .... Standard ist Standard das hat mit Konventionen nichts und mit „ alten“ schon gar nichts zu tun.

Proprietäre Formate werden meistens auch nicht von der Geräteindustrie adaptiert, weil man nicht weiß, ob „morgen“ schon wieder was an solchen pseudo Standards geändert wird.

Und, wie man sieht ... hat sich der Markt bisher eher an HDR10 bzw. + orientiert oder kann Du einen Gerätehersteller, der HLG unterstützt ?

Es ist nun mal so, dass die BBC eher die alten TV Gerät und deren Kompartibilität im Auge hat, als den Blich nach vorn gerichtet und versucht das nun, mit einem proprietären Modell, das alle andern HDR Geräte nur unzulänglich unterstützen, weil die Übertragungsparameter nicht stimmen.

Ich denke, Du liegst falsch, wenn Du sagst, ich erfasse die Entwicklung nicht richtig ... könnte das sein, das Du Dich erst in diesem Thread damit vertraut gemacht hast, was Standard und was nicht ist ?

Oben warst Du nämlich noch ganz anderer Meinung.

Aber es ist doch schön, wenn Du auch etwas dazu gelernt hast.

Antwort von mash_gh4:

ich bin tatsächlich nicht besonders ernsthaft an dieser thematik interessiert. ähnlich wie wie 3d, VR u.ä. geht es völlig an dem vorbei, was mich selbst am filmen interessiert. nur hin und wieder, wenn user hier im forum fragen dazu stellen od. die entsprechende unterstützung in freier software zur debatte steht, mach ich mich dann wieder ein bisserl diesbezgl. schlau...

im gegensatz zu dir würde ich allerdings behaupten, dass mittlerweile praktisch alle bekannteren hersteller HLG unterstützen -- manche gleich direkt, andere via LUTs im log/raw aufbereitungsweg.

aber wie gesagt: auch wenn man von dem zeug nicht besonders viel hält (ganz speziell vom hier zur debatte stehenden consumer-orientierten HLG instant recording), muss man doch zur kenntnis nehmen, dass die dinge nicht ganz so einfach liegen, dass man sie auf diese primitive 0.5-level betrachtung herunterbrechen könnte.

Antwort von WoWu:

Das ist aber der erste Ansatz und der Ausgangspunkt dieses Threads und gerade weil es mehrer bereits 6 unterschiedliche Verfahren gibt, hier (von einigen) aber immer so getan wird, dass HDR=HDR ist, sollte man wenigstens schon wissen, was man mit seiner Übertragungsfunktion eigentlich anfangen kann und welche Ziele man damit erreicht (oder eben nicht).

Antwort von SangOne:

Hallo,

gibt es inzwischen eine LUT die das GH5 HLG in Rec709 wandelt?

Antwort von dnalor:

Ja, z.B. hier: https://www.leeminglutpro.com

Antwort von binto:

Oder für eine neutrale Farbraum-Umwandlung zwischen HLG und Rec709 (beide Richtungen) hier: https://cc-lut.hotglue.me

Antwort von cantsin:

binto hat geschrieben:

Oder für eine neutrale Farbraum-Umwandlung zwischen HLG und Rec709 (beide Richtungen) hier: https://cc-lut.hotglue.me

Dazu würde ich lieber die Farbraum-Konversion in Resolve machen, weil die auch (mit verschiedenen wählbaren Verfahren) den faktisch verwendeten Dynamikumfang korrekt jeweils in den anderen Farbraum mappt, was eine LUT nicht kann bzw. nur mit festen Parametern.

Antwort von roki100:

cantsin hat geschrieben:

binto hat geschrieben:

Oder für eine neutrale Farbraum-Umwandlung zwischen HLG und Rec709 (beide Richtungen) hier: https://cc-lut.hotglue.me

Dazu würde ich lieber die Farbraum-Konversion in Resolve machen, weil die auch (mit verschiedenen wählbaren Verfahren) den faktisch verwendeten Dynamikumfang korrekt jeweils in den anderen Farbraum mappt, was eine LUT nicht kann bzw. nur mit festen Parametern.

Zwingend CST, oder kann man z.B. die passende LUT benutzen und für das andere dann Node "Gamut Mapping" und darin "Tone Mapping Method"?

Antwort von cantsin:

roki100 hat geschrieben:

cantsin hat geschrieben:

Dazu würde ich lieber die Farbraum-Konversion in Resolve machen, weil die auch (mit verschiedenen wählbaren Verfahren) den faktisch verwendeten Dynamikumfang korrekt jeweils in den anderen Farbraum mappt, was eine LUT nicht kann bzw. nur mit festen Parametern.

Zwingend CST, oder kann man z.B. die passende LUT benutzen und für das andere dann Node "Gamut Mapping" und darin "Tone Mapping Method"?

Wenn Du das hinter der LUT machst, ist es schon zu spät, da die LUT ja destruktiv arbeitet...

Antwort von roki100:

Okay, es geht also mit LUT (davor) auch.