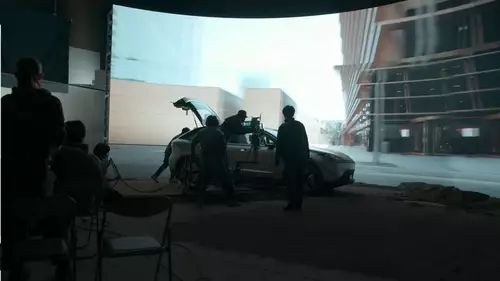

Wie "filmt" es sich an einem virtuellen Motion-Capture-Set, ganz ohne Kamera - in Echtzeit? Dies hat Sony zusammen mit Regisseur Jason Reitman bei einem Proof-of-concept-Projekt, welches kürzlich im Rahmen der Siggraph Konferenz präsentiert wurde, ausprobiert. Reitman arbeitet gerade an einem Ghostbusters-Sequel und so war die Idee, eine Ghostbusters-inspirierte VFX-Szene nicht wie üblich nachträglich in der Post zusammenzubauen, sondern gleich komplett live an einem MoCap-Set zu filmen. Allerdings nur mit einer simulierten Kamera (Vcam), denn die Handlung spielt in einer virtuellen Umgebung, auf einer Game-Engine.

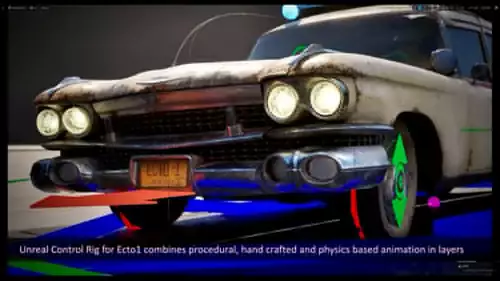

Für die Szene, in der das Stay Puft Marshmallow-Gespenst à la Godzilla durch die Stadt stapft und dann von den Ghostbusters erlegt wird, wurde ein 4km² Großstadt-Sample von Epic Games verwendet mit fotorealistischen Texturen, dynamischem Licht sowie aktivem Verkehr und Passanten. VFX Assets (wie der Ecto-Wagen) aus dem Ghostbusters-Film wurden von Pixomondo in diese Echtzeit-Umgebung eingebunden.

In der virtuellen Stadt fand zunächst ein - natürlich ebenfalls virtuelles - Location Scouting statt, um den "Dreh" anhand der vorbereiteten Stroyboards konkret zu planen. Doch anders als bei der Drehplanung in der echten Welt, erlaubt es eine virtuelle Umgebung, gewünschte Änderungen vorzunehmen, etwa an der Struktur der Straßen, am Sonnenstand usw. Somit hat man beim Storytelling viel größere Freiheiten, die Reitman, der ursprünglich aus einer traditionellen Indie-Ecke kommt (Thank you for Smoking, Juno), offensichtlich sehr genoss.

Auch beim Dreh selbst in einer virtuellen Stadt ist laut Reitman vieles deutlich einfacher umzusetzen, als es etwa on-location in New York wäre - alle Aufnahmen der kurzen Szene waren an einem Tag im Kasten. Schließlich braucht es kein Rigging, keine Ortswechsel, keine Helikopter oder Kräne, kein Warten darauf, dass sich Wolken verziehen. Dennoch würde er "alltägliche" Filmprojekte lieber weiterhin mit echten Schauspielern an realen Sets umsetzen.

// Top-News auf einen Blick:

- Blackmagic DaVinci Resolve 20 Beta 2 bringt neue Funktionen und Bugfixes

- Blackmagic Camera for Android 2.1 bringt neue Features

- Neuer superschneller PoX Flash-Speicher könnte DRAM und SSDs ersetzen

- Achtung: Verpixelte Videos können wieder kenntlich gemacht werden

- KI-generierte Fake-Trailer: Wie Hollywood an der Irreführung der Zuschauer ...

- Beleuchtung für Foto und Video lernen mit kostenlosem Tool von Google

Das Drehen in virtuellen Umgebungen sieht Reitman allerdings grundsätzlich als eine Chance für Independent-Produktionen, Geschichten zu erzählen, die an Orten oder in Zeiten spielen, zu denen man keinen direkten Zugang hat. Für Filme, die beispielsweise glaubhaft im alten Rom spielen sollen, oder in futuristischen Settings, braucht man sehr große Budgets, da die gesamte Ausstattung und die Sets extra produziert werden müssten - nicht so, wenn man mit einer virtuellen Kamera in einer Spieleumgebung dreht.

Der Echtzeit-Aspekt war bei diesem Projekt der entscheidende Punkt - dadurch ließen sich nicht nur umständliche und teure Review-Prozesse abkürzen, da Visual Effects Shots oft zwischen der Regie und dem CGI-Team hin- und hergehen bis ein finales Ergebnis steht. Sondern es waren sogar ungeplante, improvisierte Shots möglich. Da man sich beim Dreh wie an einem echten Ort bewegt, kann man diesen erkunden und dabei auf ungeahnte Perspektiven oder Orte stoßen und diese sofort filmtechnisch verwerten. Der Zufall ist plötzlich wieder ein willkommener Faktor, der beim klassischen Filmen für CGI mit seinen kontrollierten Workflows eher nicht vorhanden ist.

Und das Resultat? Die Bilder sehen natürlich meist nicht sehr echt aus, vor allem wenn Menschen zu sehen sind. Jedoch seien manche Ecto-Einstellungen so realistisch, dass Reitman sie auch in seinem "großen" Film verwenden würde (die Szene ist ab ca. 7:30 in obigem Clip zu sehen).