Frage von g3m1n1:Hi Leute,

Mal ne Frage.

Ich arbeite gerade an einem kleinen Projekt und habe mehrere

Nachtszenen gefilmt. Bei der Farbkorrektur arbeite ich sehr gerne

mit Filmconvert Pro. Um das Ganze dann nachts etwas bläulich zu

bekommen, kann ich entweder die Mitten und Schatten ins Blaue

ziehen oder den Weißabgleich nach unten regeln. Ist das eine

machbare Möglichkeit oder bedenke ich dabei etwas nicht?

Für mich persönlich sieht das toll aus, das Licht verschiebt sich

ins Bläuliche und es wirkt mehr wie Nacht... aber was steckt da

genau dahinter... verhaut mir das andere Farben wie Hauttöne etc?

Kurz gesagt... kann man so arbeiten und sollte man das ?

Antwort von Jott:

Warum denn nicht? Woher die Ängste?

Antwort von g3m1n1:

Ich weiß nicht genau was hinter dem Weißabgleich steckt, nehme aber an,

dass die Farbkurven einfach nur verschoben werden. Wenn dem so ist,

wieso sollte man dann den Weißabgleich überhaupt in der Kamera

einstellen und macht ihn nicht einfach in der Post?

Antwort von g3m1n1:

Hier 2 Beispiele...

Das wärmere hat ne Temperatur von 5100 K und das kühlere

eine von 5600 K.

Antwort von cantsin:

Ich weiß nicht genau was hinter dem Weißabgleich steckt, nehme aber an,

dass die Farbkurven einfach nur verschoben werden. Wenn dem so ist,

wieso sollte man dann den Weißabgleich überhaupt in der Kamera

einstellen und macht ihn nicht einfach in der Post?

Das geht nur verlustfrei, wenn Deine Kamera raw oder 12/14bit 4:2:2 aufzeichnet. Mit den meisten anderen Codes, vor allem bei 8bit, wird nur ein Bruchteil der Farben aufgezeichnet, die der Sensor sieht. Mit der Weissabgleichs-Einstellung filtert man dieses selektive Bruchteil auf dasjenige Farbspektrum, in dem man die meisten Werte erhalten will.

Antwort von g3m1n1:

Ich weiß nicht genau was hinter dem Weißabgleich steckt, nehme aber an,

dass die Farbkurven einfach nur verschoben werden. Wenn dem so ist,

wieso sollte man dann den Weißabgleich überhaupt in der Kamera

einstellen und macht ihn nicht einfach in der Post?

Das geht nur verlustfrei, wenn Deine Kamera raw oder 12/14bit 4:2:2 aufzeichnet. Mit den meisten anderen Codes, vor allem bei 8bit, wird nur ein Bruchteil der Farben aufgezeichnet, die der Sensor sieht. Mit der Weissabgleichs-Einstellung filtert man dieses selektive Bruchteil auf dasjenige Farbspektrum, in dem man die meisten Werte erhalten will.

Danke für die gute Erklärung!

Antwort von ONV:

Ich würde grundsätzlich die Finger von Farbverschiebungen in den Tiefen lassen, wenn man einfach nur eine wärmere oder kühlere Lichtstimmung haben will. Wenn Du ein low-key Bild hast (wie das was Du da gepostet hast) und durch die Bank weg alles was Schwarz ist einen leichten bläulichen Schleier verpasst, dann schreit das in meinen Augen (oder Ohren) immer nach "Fake!!". Ich fahre immer am besten damit nur in den Mitten massive Verschiebungen zu tätigen, Highlights und Tiefen am besten nur dezent anfassen.

Unterm Strich denke ich aber auch, keine Angst mal zu probieren. Kommt natürlich drauf an ob Du damit "nur" ins Web gehst oder ne IMAX-Leinwand bespielen willst, aber solange es für's Auge gut aussieht und Du keine strengen Messwerte zu erfüllen hast, probier' fröhlich rum. :)

Antwort von g3m1n1:

Ich würde grundsätzlich die Finger von Farbverschiebungen in den Tiefen lassen, wenn man einfach nur eine wärmere oder kühlere Lichtstimmung haben will. Wenn Du ein low-key Bild hast (wie das was Du da gepostet hast) und durch die Bank weg alles was Schwarz ist einen leichten bläulichen Schleier verpasst, dann schreit das in meinen Augen (oder Ohren) immer nach "Fake!!". Ich fahre immer am besten damit nur in den Mitten massive Verschiebungen zu tätigen, Highlights und Tiefen am besten nur dezent anfassen.

Unterm Strich denke ich aber auch, keine Angst mal zu probieren. Kommt natürlich drauf an ob Du damit "nur" ins Web gehst oder ne IMAX-Leinwand bespielen willst, aber solange es für's Auge gut aussieht und Du keine strengen Messwerte zu erfüllen hast, probier' fröhlich rum. :)

Wirkt deutlich besser!

Ok, dann versuch ich das mal so. Hätte nicht gedacht, dass der Schwarzwert

dermaßen verändert wird durch den Weißabgleich... aber bei deiner Version

fällt das richtig auf.

Antwort von lossantos:

Hi, ich finde die Frage vom TO sehr interessant.

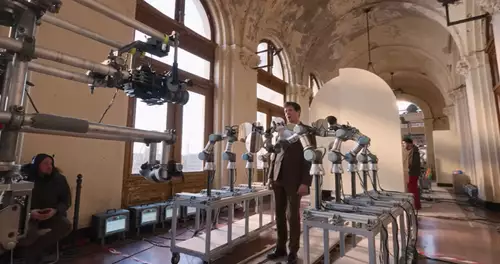

Mal angenommen ich habe eine Low-Key Szene, wie im folgendem Bild.

Kurz Background Info zum Set: Sony a7s + Pix-e Recorder (8Bit) in Slog 2

Muss ich auch hier ganz normal, zum Beispiel mit einer Lastolite White Card, den weißabgleich tätigen?

Und mit der Rückseite des Lastolite Graukarte (18%) Slog 2 richtig Belichten: (Idealwert 32% auf dem Waveform + 1-2 Stops drüber)

Oder wi würdet ihr an solch eine Szene herantreten?

Bin gespannt.

LG

Antwort von WoWu:

Der Weißabgleich wirkt immer auf den erste, rauschärmsten Verstärker im Prozessweg.

Wird die Ballance erst in der Post nachgezogen wirkt sich das schlechter auf den Störabstand aus.

Weil der Sensor aber bei kurzweiligem Licht die schlechteste Quanteffizienz hat, ist Blau der kritische Abgleich.

Es gibt im gesamten Prozess keinen Punkt mehr, der nachträglich (in Bezug auf den Störabstand) gleichwertige Einstellungen zulässt.

Was die LOg Funktion betrifft ... es ist ja nicht eine Übertragungsfunktion sondern drei (für jede Farbe eine), die auch durchaus unterschiedlich voneinander sind, je nachdem, wie die Kameraeigenschaften sind.

Diese drei Funktionen sind darauf abgestimmt, dass der Abgleich in der Kamera geschieht. Wird das erst in der Post gemacht, verschieben sich die Farbverhältnisse in unterschiedlichen Bereich unterschiedlich und ergeben keine homogene Farbdarstellung mehr über unterschiedliche Lichtverhältnisse hinweg.

Antwort von mash_gh4:

Was die LOg Funktion betrifft ... es ist ja nicht eine Übertragungsfunktion sondern drei (für jede Farbe eine), die auch durchaus unterschiedlich voneinander sind, je nachdem, wie die Kameraeigenschaften sind.

Diese drei Funktionen sind darauf abgestimmt, dass der Abgleich in der Kamera geschieht. Wird das erst in der Post gemacht, verschieben sich die Farbverhältnisse in unterschiedlichen Bereich unterschiedlich und ergeben keine homogene Farbdarstellung mehr über unterschiedliche Lichtverhältnisse hinweg.

da würde ich dir wiedersprechen. genau darin liegt ja der sinn der log aufzeichnung, dass man die farben quais in linearer darstellung, wenn auch mit log codierung/komprimierung, auch noch in der nachbearbeitung zur verfügung hat, und daher derartige operationen dort problemlos durchführen kann. mit rec709 material geht das nicht besonders gut, weil ein entsprechendes linearisieren kaum befriediegend möglich ist.

Antwort von WoWu:

Das hat doch miteinander gar nichts zu tun.

Die Kennlinien des Belichtungsindexes laufen ja bereits

vor der Digitalisierung auseinander und sind damit in allen drei Werten auch in der Übertrahungsfunktion unterschiedlich.

Hier geht es ja darum, ob man einen Abgleich der Werte vor oder hinter der Digitalisierung durchführt denn der Weißabgleich geschieht ja in der ersten Signalverstärkung des Sensors.

Sowas kann u.U. auch dazu führen, dass der Peaklevel des Prozessweges erreicht wird, bevor der Sensor überhaupt FullWell erreicht.

Insofern ist es keineswegs egal, an welcher Stelle man den Weißabgleich durchführt.

Antwort von lossantos:

Der Weißabgleich wirkt immer auf den erste, rauschärmsten Verstärker im Prozessweg.

Wird die Ballance erst in der Post nachgezogen wirkt sich das schlechter auf den Störabstand aus.

Weil der Sensor aber bei kurzweiligem Licht die schlechteste Quanteffizienz hat, ist Blau der kritische Abgleich.

Es gibt im gesamten Prozess keinen Punkt mehr, der nachträglich (in Bezug auf den Störabstand) gleichwertige Einstellungen zulässt.

Was die LOg Funktion betrifft ... es ist ja nicht eine Übertragungsfunktion sondern drei (für jede Farbe eine), die auch durchaus unterschiedlich voneinander sind, je nachdem, wie die Kameraeigenschaften sind.

Diese drei Funktionen sind darauf abgestimmt, dass der Abgleich in der Kamera geschieht. Wird das erst in der Post gemacht, verschieben sich die Farbverhältnisse in unterschiedlichen Bereich unterschiedlich und ergeben keine homogene Farbdarstellung mehr über unterschiedliche Lichtverhältnisse hinweg.

danke danke, für die vielen Infos :)

Aber kannst du es etwas laienhafter Ausdrücken? :P

Wie würdest du denn an so eine Situation herangehen? Du weißt du willst Low-key filmen, Was wären den deine Steps zu dem Thema Weißabgleich und Slog2. Falls du mit Slog überhaupt arbeitest, aber wenn du es tun solltest :D

Antwort von WoWu:

Da gibt es nichts Kompliziertes denn sofern Du den Weißabgleich in der Kamera vornimmst, ist der gesamtes Nachfolgeprozess vom Hersteller so abgestimmt, dass alle möglichen Nachteile minimiert sind.

Erst wenn Du in der Kamera keinen WB machst und das hinterher in der Post machen willst, greifst Du in die "Wundertüte".

Daher mach den WB in der Kamera und eine Einfärbung des Videos in der Post.

Das ist auch unabhängig davon, ob Du Lin oder Log arbeitest.

Erst wenn der Abgleich nicht mehr kameraseitig geschieht, wird es komplizierter.

Antwort von lossantos:

Den weißabgleich wollte ich definitiv beim Dreh machen. In ProRes ist der Weißabgleich ja eingebacken.. da hast du fast keine chance die Temp. zu ändern..

Den weißabgleich machst du mit einer White Card?

Und das richtige belichten von Slog 2 mit Graukarte?

Antwort von WoWu:

So würde ich es mache.

Das ist auch unabhängig vom verwendeten Codec, weil es ganz am Anfang der Prozesskette geschieht, da sieht das Signal noch gar keine Datenreduktion.

Aber mit dem Workflow liegst Du richtig.

Antwort von mash_gh4:

Hier geht es ja darum, ob man einen Abgleich der Werte vor oder hinter der Digitalisierung durchführt denn der Weißabgleich geschieht ja in der ersten Signalverstärkung des Sensors.

das ist definitv falsch, sonst würde es ja auch in der nachträglichen aufbereitung von raw fotos nicht funktionieren -- damit sei nicht gesagt, dass deine vorstellung nicht auch umsetzbar wäre, aber in der praxis wird es in gebräuchlichen kameras anders gehandhabt.

Antwort von WoWu:

Na, dann sag doch mal, wie die niedrige Photonenaubeute für kurzweiliges Licht, hinter einem Blaufilter auf das Niveau der Photonenausbeute mit mittel- und langweiliges Licht, bei einer Optimierung des Störabstands gebracht wird, wenn nicht mit dem Belichtungsindex.

Lass mal hören ...

Und hast Du mal den Störabstand der einzelnen Kanäle nachgemessen, wenn im Raw Verfahren ein Blauinhalt nachgezogen wird ?

Schau Dir mal die einzelnen Werte an, wenn das in der Kamera gemacht wird oder in der Post.

Aber wir werden das ja gleich von Dir erfahren, wie die sind ...

Antwort von mash_gh4:

Na, dann sag doch mal, wie die niedrige Photonenaubeute für kurzweiliges Licht, hinter einem Blaufilter auf das Niveau der Photonenausbeute mit mittel- und langweiliges Licht, bei einer Optimierung des Störabstands gebracht wird, wenn nicht mit dem Belichtungsindex.

Lass mal hören ...

Und hast Du mal den Störabstand der einzelnen Kanäle nachgemessen, wenn im Raw Verfahren ein Blauinhalt nachgezogen wird ?

Schau Dir mal die einzelnen Werte an, wenn das in der Kamera gemacht wird oder in der Post.

Aber wir werden das ja gleich von Dir erfahren, wie die sind ...

wie gesagt, ich denken, die orientierts dich hier noch immer viel zu sehr zu sehr an konventionen der analogtechnik.

in heutigen kameras kommen vom sensor bzw. a/d-wandler einfach die raw daten und werden, wenn man es nicht ausserhalb der kamera aufbereiten will, mit entprechenden faktoren für jeden kanal multipliziert. die betreffenden angaben findet man gewöhnlich auch in den metadaten. man kann sie auch in der raw entwicklung heranziehen, wenn man ein ähnliches aussehen erzielen will, wie es die kamera intern generiert hätte.

im zusammenhang mit log ist der weißabgleich wirklich nur insofern sinnvoll, als die werteverteilung im resultierenden file sgünstiger ausfällt als wenn völlig falsche oder unbestimmte faktoren bei dieser multiplikation zur anwendung kommen.

prinzipiell lassen sich im aber enttsprechende saubere korrekturen bei log footage auch relativ leicht nachträglich realisieren. im ACES workflow werden aus diesem grund gewöhnlich nur zwei linearisierungsprofile für die beiden gebräuchlichsten farbtemparaturen genutzt, weil es komplizierter wäre, die jeweiligen weißabgleichsfeinheiten der verschiedenen kameras sauber mathematisch zu beschreiben, statt eine derart triviale operation einfach nachträglich ausgehend von zwei gebräuchlichen settings reinzurechnen. und nach dem es ja in wahrheit auch verschiedene methoden gibt den weißabgleich zu realisieren, kann das ergebnis dabei (ganz ähnlich wie beim externen raw entwicklen) deutlich befriedeigender ausfallen als direkt in der kamera, mit der der dort gebräuchlichen primitiven methode.

Antwort von dienstag_01:

Also, in meiner Schnittsoftware gibt es keinen Regler für den Weissabgleich. Aber ich kann ihn natürlich verändern (Pipette - Curves, HSL, etc.). Warum ist das so? Weil eine Änderung des WA immer eine ganz normale Farbkorrektur ist, mir all deren Verlusten.

Soviel zum Thema WA in der Post.

In RAW läuft das anders. Ich würde aber auch hier sagen: "bedingt" anders ;)

Antwort von WoWu:

wie gesagt, ich denken, die orientierts dich hier noch immer viel zu sehr zu sehr an konventionen der analogtechnik.

Das wundert mich nicht, dass Du das denkst, aber es mag ja Deiner bisherigen Wahrnehmung entgangen sein, dass der Sensor ein analoges Bauteil ist, einschliesslich der ersten Spannungsverstärkung der Pixels, die bei modernen Sensoren noch auf dem Sensor stattfindet.

(Alles, was bei dem Sensor ROT ist, ist analog !!)

Wir reden also über einen analogen Vorgang, in dem der Verstärker eingebunden ist, der mit den geringsten Rauschfaktor das Signal verstärken kann und daher für das Ausgleichen von etwa 60% Quanten-Effizienzdifferenz zwischen Rot und Blau mit dem geringste möglichen Rauschanteil beitragen kann.

Die einzige Ausnahme stellen MOS Sensoren da, die mit unorganischem Filtermaterial aus 4 unterschiedlichen Wellenlängen das Licht in den Pitches bereits so filtern, dass ein ausgeglichenes Wellenbild vorliegt. Das aber auch nur, weil sich dieser Sensortyp dahingehend unterscheidet, dass sich 4 Pixels einen Verstärker teilen und das zu einem andern verfahren zwingt.

Dass man hinterher in der Postproduktion die einzelnen Werte gegeneinander verschieben kann, steht ja gar nicht zur Debatte, nur dass die rauschwerte für Blau dann um rund 18 dB schlechter sind, als bei einem Weissabgleich in der Kamera, weil der Schwankungsfaktor bei 60% liegt und die stochastische Verteilung nur noch mit einem Mittelwert gewichtet werden kann.

Das ist auch genau der Grund, weshalb man sich auch RAW Signale bei einer schlechten ISO Einstellung bereits in der Dynamik einengt denn der Belichtungsindex wirkt im Wesentlichen auf den ersten (analogen) Verstärker im Sensor.

Aber wenn Dir das Rauschen im Blaukanal um bis zu 3 Blenden schlechter egal ist, und auch, dass die Farbkanäle bei einem Weissabgleich in der Post unterschiedlich gespreizt werden, kannst Du solche Einstellungen natürlich auch hinterher machen.

Vielleicht solltest Du aber auch mal in den Kameras schauen, wie die Weissabgleich Automatik dort funktioniert. Denn die wirkt ebenso auf den ersten Verstärker.

Es geht also gar nicht darum, dass man die Farben in der Post nicht mehr in ihrer Lage verschieben kann sondern darum, welchen Störabstand Blau hinterher hat.

Aber es soll ja Leute geben, denen ist das egal.

Den Kameraherstellern aber nicht.

Ausserdem gibt es keine "primitive" Methode in der Kamera, weil dort auch eines der 4 üblichen Verfahren zur Farbbewertung stattfindet und der Prozess alles andere als "primitiv" ist. Oder hast Du Dich noch nie gefragt, warum z.B. Blau nicht bei jeder Kamera gleich aussieht ?

Das liegt daran, dass das Farbfilter (z.B. nach der "von Kries Hypothese", oder "Gray world" (nur als Beispiele)) ins Verhältnis gesetzt wird zur spektralen Reflektionsbeleuchtung. Ist also fester Bestandteil des Weissabgleichs.

Sowas kannst Du in der Post gar nicht mehr beeinflussen, weil Du weder die Informationen über die Farbfilter hast, noch die Algorithmen.

Antwort von mash_gh4:

wie gesagt, ich denken, die orientierts dich hier noch immer viel zu sehr zu sehr an konventionen der analogtechnik.

Das wundert mich nicht, dass Du das denkst, aber es mag ja Deiner bisherigen Wahrnehmung entgangen sein, dass der Sensor ein analoges Bauteil ist, einschliesslich der ersten Spannungsverstärkung der Pixels, die bei modernen Sensoren noch auf dem Sensor stattfindet.

wenn du mich in dem punkt wirklich eines besseren belehren willst, dann zeig mir bitte die entsprechenden steuerbefehle im data sheet eines gebräuchlichen sensors, damit es wirklich was mit der praxis zu tun hat.

Ausserdem gibt es keine "primitive" Methode in der Kamera, weil dort auch eines der 4 üblichen Verfahren zur Farbbewertung stattfindet und der Prozess alles andere als "primitiv" ist. Oder hast Du Dich noch nie gefragt, warum z.B. Blau nicht bei jeder Kamera gleich aussieht?

mit der "primitiven methode" war ganz konkret das R'G'B' scaling in der kamera gemeint, das zwar eine recht einfache, und in wahrheit gar nichts so schlechte, methode des weißabgleichs darstellt (vgl. https://en.wikipedia.org/wiki/Color_balance), trotzdem kann man sie natürlich nicht ohne weiteres mit komplizierten modellen und berechnungsmethoden der chromatischen adaption vergleichen -- speziell dann, wenn auch die spektrale sensibilität der verschiedenfarbigen sensel einbezogen wird, was beim raw entwicklen gegenwärtig wohl als state of the art angesehen werden kann.

siehe dazu:

http://www.ludd.ltu.se/~torger/dcamprof.html

Antwort von WoWu:

Du wirst in keinem RAW Tool einen Algorithmus für Farbinterpretation finden, weil das bereits in der Kamera abgeschlossen ist und Teil des Weissabgleichs denn sämtliche Farbanpssungsfunktionen sind nur in der Kamera vorhanden und setzen auf den unterschiedlichen Wellenlängen in Abhängigkeit vom ISO Setting auf, also in der Verstärkung des Sensors.

Und die ist nun mal analog, auch wenn es Dir nicht passt.

Was die Sensorpixel betrifft, musst Du Dir nur die Wirkungsweise des ISO Settings anschauen, da wirst Du fündig.

Aber vergiss es einfach.

Sei weiter der Meinung, es gäbe keinen anlogen Teil mehr und alles ist digital durch ein paar Kommandozeilen in ffmpeg zu machen.

Aber behaupte bei dem Wissensstand nicht, der Weißabgleich hätte keine Vorteile in der Kamera.

Antwort von domain:

In RAW läuft das anders. Ich würde aber auch hier sagen: "bedingt" anders ;)

Das "bedingt" würde ich auch unterstreichen, denn ein 80B-Filter wäre u.U. auch hier angebracht.

Was habe ich schon alles für Wunderdinge über RAW gehört, das ich allerdings erst seit der D750 etwas näher unter die Lupe genommen habe.

Die Korrekturmöglichkeiten sind zwar größer, aber im Vergleich zum unveränderten aber entwickelten und dann abgespeicherten Tiff-Bild nicht so dramatisch viel besser.

Merkwürdig übrigens: Nef, also Nikon RAW-File z.B. 27 Mb

Das gleichzeitig abgespeicherte Jpegbild 11,3 Mb

Das Tiff-Bild dann aber 69,4 MB (schleierhaft warum auf einmal so groß))

Und mir scheint, dass ich dort die für meinen Bedarf notwendigen Korrekturen fast genauso gut machen kann wie im erstklassigen Capture NX-D von Nikon mit nef.

Antwort von dienstag_01:

Die RAWs bei der D750 sind komprimiert.