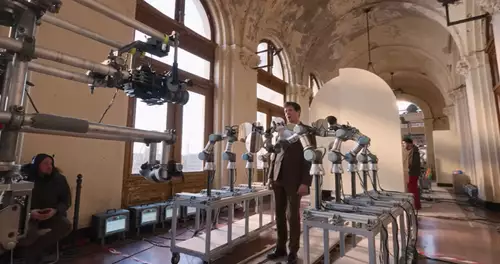

Gut 30% unserer Leser fänden es laut der aktuellen Umfrage spannend, einen Film in 3D zu produzieren, und andere darüberhinaus hätten zumindest versuchsweise daran Interesse. Da kommt es wie gerufen, daß ein junges Team namens "Motion Artwork" gerade einen groß angelegten No-Budget-Selbstversuch auf dem Gebiet gemacht hat, das Resultat online präsentiert und auch noch Lust hat, in einem Interview von ihren Erfahrungen zu berichten.

Der Film "Der Schatten der Gerechtigkeit" entstand sozusagen als Testprojekt, um einen Rahmen für die S3D-Experimente zu haben, bei denen die HV30 und HV20 zum Einsatz kamen -- doch wir wollen nicht vorgreifen:

slashCAM: Wie seid Ihr denn auf die Idee gekommen, Euren Film stereoskopisch zu produzieren?

Motion Artwork: Wir waren schon immer von der S3D Technik begeistert. Als wir im Frühjahr 2009 das IMAX in Berlin besucht haben, kam uns die Idee einen eigenen S3D Film zu produzieren. Nach einiger Recherche und ersten ernüchternden Tests mit zwei Kameras, ließen wir das Projekt erstmal ruhen. Als uns in einem zweiten Anlauf im Sommer erste positive Ergebnisse mit einer Modifikation des 3D Rigs gelangen, machten wir uns daran, das Projekt „S3D Film“ richtig anzugehen.

Ihr habt so ziemlich ohne Budget gedreht. Welche Technik, welches Setup habt Ihr genau verwendet (welche Camcorder, Monitore, 3D Rig)?

Da wir zuvor einige Projekte im 2D Bereich realisiert haben, hatten wir bereits einiges Equipment zur Verfügung. Als Camcorder wurden die HV30 und die HV20 von Canon eingesetzt. Glücklicherweise sind sie baugleich und waren somit gut für einen S3D Dreh zu verwenden. Zur Montage wurde verschiedene Teile unseres Equipment zusammengebastelt. Um den interokularen Abstand der beiden Kameras zu verringern, wurde die HV30 verkehrt herum neben der HV20 montiert. Aufgrund dessen konnten wir die LCD Bildschirme beider Kameras nicht verwenden und waren daher auf einen externen 800x480 Monitor angewiesen. Die Einstellung des Fokus´ der beiden Kameras war problematisch. Der manuelle Fokus war schwer zu synchronisieren, daher mussten wir uns auf den Autofokus verlassen. Sobald die Kameras auf das richtige Objekt fokussiert hatten, wurde der Fokus festgestellt. Ein paar Fokusfehler (u.a. Fokusunterschiede zwischen beiden Kameras) waren am Set jedoch nicht immer auszumachen, fallen in S3D im Nachhinein jedoch wenig auf.

Welchen interokularen Abstand habt Ihr genutzt, war dieser Fix oder wurde er verändert um die Tiefenwirkung zu manipulieren?

Der Abstand der beiden Kameras betrug ca. 7cm. Das entspricht ungefähr unserem Augenabstand. Durch einen Schnellwechsel-Schlitten war es uns möglich die Stereobasis stufenlos zu variieren, was jedoch nie Anwendung fand, da dieser Abstand, gemessen an professionellen S3D Produktionen, immer noch zu groß ist.

Je größer die Projektionsfläche ist, desto größer wird auch die Tiefe. Auf Computerbildschirmen, Fernsehern und kleinen Leinwänden ist unser Film noch angenehm zu schauen, auf einer großen Leinwand wird das Gehirn Probleme haben ein 3D Bild zusammenzusetzen.

Ebenfalls mussten wir auch bei Nahansichten vorsichtig sein. Der interokulare Abstand müsste in der Regel sogar noch weiter verringert werden, je näher die Kameras dem Objekt sind.

Was hat den Dreh am meisten von einem 2D-Dreh unterschieden -- habt Ihr beim Drehen besonders auf etwas geachtet, zB. bezüglich Framing, 3D Wirkung / Staffelung im Raum? Wurde anders Regie geführt als sonst?

Der Ablauf eines 3D Drehs bleibt dem eines 2D Drehs relativ ähnlich. Es muss jedoch mit einem deutlich höherem Zeitaufwand gerechnet werden. Der Aufbau des Kamera Rigs und die Einstellungen nehmen viel Zeit in Anspruch. Ständig muss kontrolliert werden, ob beide Kameras aufnehmen, sie gleich eingestellt (gleicher Weißabgleich, gleicher Fokus, gleiche Belichtungszeit,...) und synchronisiert sind.

Des weiteren mussten wir, wie bereits erwähnt, auf Fokuswechsel verzichten und darauf achten, keine zu nahen Einstellungen zu wählen. Bei größerer Brennweite ist eine geringere Stereobasis erforderlich, daher haben wir auf die Verwendung des Zooms verzichtet.

Außerdem wurden, um die Tiefenwirkung besonders zur Geltung kommen zu lassen, beim Dreh einige Einstellungen zielgerichtet verwendet, die den 3D Effekt ausreizen.

Wie habt Ihr die Kameras synchronisiert?

Die Kameras wurden zunächst mithilfe einer Fernbedienung synchron gestartet. Leider hat diese Synchronisation nie funktioniert und die Aufnahmen waren oft sogar mit mehreren Sekunden versetzt. Eine Synchronisation mit Filmklappe war demnach erforderlich. Jedoch ist die Synchronisation nur framebasiert und einen Zeitversatz innerhalb eines Frames konnten wir nicht korrigieren.

Kommen wir zur Postproduktion – welche Software kam zum Einsatz, und gab es irgendwelche Probleme dabei? Wurde auch die Tiefenwirkung "editiert"?

Die Postproduktion lief hauptsächlich in After Effects und Premiere Pro ab. In After Effects haben wir uns ein Preset geschrieben, das die 3D Daten verarbeiten kann. So war es uns möglich, visuelle Effekte hinzuzufügen, farbliche Unterschiede auszugleichen, Höhen- und Rotationsfehler zu korrigieren, die Konvergenz einzustellen, eine Farbkorrektur vorzunehmen und die zwei Einzelvideos separat herauszurendern. Vorteilhaft war, dass wir die Bearbeitung in After Effects und Premiere auch direkt in S3D auf unseren 3D Monitor (Zalman ZM-M220W) durchführen konnten. Dieser erzeugt den 3D Eindruck durch zeilenweise unterschiedliche Polarisation (eine 3D Polarisationsbrille ist erforderlich), wodurch lediglich ein treiberunabhängiger Interlaced Effekt hinzugefügt werden muss.

Visuelle Effekte waren deutlich schwieriger einzubauen als in 2D, weil jeder Effekt zweimal erstellt und perfekt im 3D Raum integriert werden muss. Besonders Rotoscoping und Retuschierungen waren sehr problematisch.

Der Schnitt verlief hauptsächlich in 2D, jedoch müssen in 3D einige Faktoren zusätzlich beachtet werden. Der Zuschauer muss sich in einem 3D Film bei jeder Einstellung neu orientieren und das Bild in 3D im Gehirn zusammensetzen, daher sollten schnelle Schnitte vermieden werden. Des weiteren ist der Schnitt von einer Einstellung mit positiver Parallaxe auf eine Einstellung mit negativer Parallaxe oft unangenehm für den Betrachter.

Wie wurde das Material in 3D gesichtet (am Set und in der Postpro)?

Am Set hatten wir leider keine Möglichkeit das Material in 3D zu betrachten. Hier mussten wir uns auf eine 2D Vorschau und unsere Erfahrung verlassen. In der Post Pro hatten wir, wie bereits erwähnt, den Zalman 3D Monitor bei der Bearbeitung zur Verfügung. Zur endgültigen Vorschau verwendeten wir den Acer H5360 120Hz Beamer mit Nvidia Shutterbrille auf einer 2,5m breiten Leinwand. Dadurch konnten wir noch einige Feinheiten korrigieren, die auf der größeren Projektionsfläche stärker ins Gewicht fallen.

Für welches Ausgabeformat habt Ihr Euch entschieden und warum?

Wir haben uns auf kein Anzeigeverfahren festgelegt. Der Film wurde im Over-Under Format (1280x1440) veröffentlicht und lässt sich mit einem entsprechenden Player in jedem beliebigen Verfahren anzeigen (Anaglyph, Shutter, Polarisation, etc.). Zusätzlich wurde eine anaglyphe rot-cyan und eine 2D Version, die einige modifizierte Einstellungen beinhaltet, veröffentlicht, um ein größeres Publikum zu erreichen.

Wieviel Mehraufwand hat nach Eurer Schätzung das Produzieren in 3D bedeutet?

Das lässt sich schwer beurteilen. Am Set hatten wir ca. 20% Mehraufwand im Vergleich zu einer 2D Produktion. Der aufwändigste Teil war die Postproduktion, die wahrscheinlich 5 mal mehr Zeit in Anspruch genommen hat.

Für uns fielen die Kosten sehr gering aus, weil wir die Kameras und den 3D Monitor bereits besaßen.

Hat es denn auch Spaß gemacht? Also, würdet Ihr es nochmal machen bzw. unter welchen Umständen?

Natürlich hatten wir, wie bei jedem Film, unsere Höhen und Tiefen. Das Projekt hat uns sehr viel Spaß gemacht und es war besonders interessant dieses neue Stilmittel zu verwenden. Vor allem in der Postproduktion war es jedoch auch des öfteren mal frustrierend und zeitraubend, aber wenn man sich das Resultat ansieht, wurde man schlussendlich doch für seine Arbeit belohnt.

Wir haben im Entstehungsprozess eine Menge gelernt, unter anderem auch S3D nicht als Gimmik zu verstehen. Es ist, wie z.B. die Schärfentiefe, ein neues künsterisches Element, das den Film dabei unterstützen kann, die Story zu erzählen. Genauso wie die Schärfentiefe, Farbe oder Stereo-Sound ist es nicht zwingend notwendig, eröffnet dem Filmemacher aber eine Menge neuer Möglichkeiten.

Unser nächstes Projekt wird allerdings wieder in 2D gedreht. Der Dreh und die Postproduktion sind in 3D einfach noch zu kompliziert und professionelle Kameralösungen zu teuer. Ein Spiegelrig zur flexiblen Einstellung der Stereobasis, eine Möglichkeit beide Kameras genau zu synchronisieren, einen 3D Vorschaumonitor am Set und bessere Software Lösungen wären Vorraussetzung für unsere nächste 3D Produktion. Wer keine Veröffentlichung auf der großen Leinwand und keinen längeren Film plant, kann aber auch schon mit unser verwendeten Technik ein gutes Resultat erzielen.

Abschließend, welche Tips hättet Ihr für jemanden, der auch Low-Cost 3D-Produktion probieren will?

Es ist besonders wichtig einige Tests im Vorfeld durchzuführen. S3D ist mehr als nur zwei nebeneinander gestellte Kameras. Ein weiterer Tipp wäre, in Halbbildern aufzunehmen. Leider haben wir progressiv aufgenommen, was sich im Nachhinein als großer Nachteil herausgestellt hat. Durch Halbbilder können die bereits erwähnten Synchronisationsprobleme innerhalb eines Frames minimiert werden.

Ein wichtiger Tipp noch zur Bearbeitung: Wenn möglich, Scheinfenster Verletzungen vermeiden, da sie den 3D Eindruck leicht zerstören können.

Es wäre außerdem ratsam für jemanden, der ernsthaft einen 3D Film produzieren will, sich einen 3D Monitor anzuschaffen, da die ausschließliche Betrachtung des anaglyphen Materials einige Schwächen aufweist (schlechte Kanaltrennung, verfälschte Farben, auf Dauer unangenehm, etc.).

Vielen Dank an Constantin Maier und die Motion Artwork-Crew.

Wer sich den Film „Der Schatten der Gerechtigkeit“ anschauen möchte, findet diverse 3D/2D-Versionen sowohl im Download als auch online oder auf DVD unter diesem Link