Frage von molch:Ausgehend von einem Subdiskurs, der die Verarbeitung und Aufbereitung des Materials der D5200 behandelt, soll dieser Thread das Thema fortsetzen.

EDIT:

##

Da ja im Slashcam Artikel über die D5200 auf diesen Thread verwiesen wurde, schreibe ich hier eben den neuesten Stand der Dinge:

Die für mich beste FFMPEG Befehlszeile ist:

ffmpeg -i (Inputdatei) -vcodec libx264 -g 1 -acodec copy -vb 100000k -vf "split [T1], hqdn3d=0:0:6:4, [T2] blend=c1_expr='B':c2_expr='B':c0_expr='if(lte(A, 40),B,if(lte(A, 50),((1-((50-A)/10))*A)+((((50-A)/10))*B),A))' [out]; [T1] unsharp=3:3:1.5:3:3:1.5 [T2]" (Outputdatei)

Die weiter unten genannten Probleme mit dem Banding wurden in den neueren FFMPEG Version behoben und die Codierung in Full-Range x264 spart Speicherplatz, denn DNXHD unterstützt nur einen begrenzten Wertebereich und man ist somit gezwungen das 10bit Profil zu benutzen, welches sehr speicherhungrig ist. Qualitativ gibt es in der Praxis, soweit von mir getestet, mit x264 keine Nachteile.

##

Hier ist eine FFMPEG Zeile zum Schärfen:

ffmpeg -i (Inputdatei) -vcodec dnxhd -acodec copy -vb 120000k -vf unsharp=3:3:2:3:3:2 (Outputdatei)

Dies ist ein Befehl, der das Rauschen bei ISO100 mit dem Flaat11 oder einem Gamma Profil ein wenig unterdrückt:

ffmpeg -i (Inputdatei) -vcodec dnxhd -acodec copy -vb 185000k -vf unsharp=3:3:1:3:3:1,format=yuv420p10be,hqdn3d=0:0:4:4 (Outputdatei)

Mit dem 3. und 6. Parameter des Unsharp Filters kontrollierst du die Filterstärke für Luminanz (3) und Chrominanz. Ich werde schauen, dass ich die Tage eine komplexe Filterkette erstelle, die lediglich die dunkleren Bildpartien entrauscht. Dann gibt's auch weniger störende Geisterbilder und man kann den Denoiser Wert etwas anheben.

Und die letzte Frage: (Natalie)

Es war nur der erste Schock ;), das Ergebnis rechtfertigt schon die Dateigröße , außerdem schaue ich auch mal gerne über den Mainstream Teller ..

Wobei es schon zäh ist, sich durch den Code und den Synthax zu wursteln , ich suche verzweifelt nach einer Liste mit den möglichen Output Formaten -

ffmpeg -formats gibt alle Formate aus ;))

Hier einmal der erste Versuch eines Befehls, der nur die Schatten entrauscht und alles andere schärft:

ffmpeg -i (input) -vcodec dnxhd -acodec copy -vb 120000k -vf " split , format=yuv420p10le, hqdn3d=0:0:8:8, blend=all_expr='if(lte(A, 70),B,if(lte(A, 80),((1-((80-A)/10))*A)+((((80-A)/10))*B),A))' ; unsharp=3:3:1.5:3:3:1.5, format=yuv420p10le, hqdn3d=0:0:0:0 " -r 25 (output)

Leider unterstützt der blend Effekt keine 10 Bit. Die Wandlung vor dem HQDN3D Filter ist trotzdem wichtig, da dann auf 8 Bit gedithert wird. DNxHD 185x können wir uns jetzt natürlich kneifen, 120 reicht hier völlig.

Antwort von Natalie:

Super !

Frage:

=Sind die 120Mbit überhaupt nötig in Bezug auf die Dateigröße und die maximalen 24Mbit Quellmaterial, wie würde sich das ganze bei 60Mbit verhalten

=Macht es Sinn bei DXNHD zu bleiben , es soll ja einige Vorteile bieten, ich frage mich inwieweit diese Vorteile bezüglich einer eventuell gleichgrossen MPEG4 Datei sind

/Muss im Endeffekt einfach der Verweis DNXHD in der Befehlskette durch MPEG4 ersetzt werden oder gibt es da noch Parameter die zu beachten sind

*=In der Befehlskette des Denoiser liegt auch der Unsharp Algorythmus. Macht dieser die Nachschärfung überflüssig ? / hat sich ja schon beantwortet , dein Algorythmus ist ja dafür ausgelegt *

=Wäre lieb von Dir eine kleine Legende zu schreiben welche Parameter eine noch sinnvolle Beeinflussung des Vorgangs bieten :) , ich probiere sie gerne aus und philosophire darüber ;)

:))

LG

Antwort von domain:

Eine Nachschärfung im NLE käme für mich gar nicht in Frage. Die Bilder direkt aus der Kamera sollten eigentlich schon den persönlichen Anforderungen entsprechen.

Irgendwie stellt sich nebenbei schon auch die Frage, welchen Einfluss eigentlich Einsensorlösungen und speziell 50i auf die Schärfe haben.

Denn JVC hat mit der GZ-HM1 eine Auflösung und eine Schärfe mit moderater Kantenaufsteilung vorgelegt, die bisher von keinem anderen Camcorder erreicht wurde, auch nicht von den kleinen 3-Chipper 50p Panas. Kann also alles nicht so die Rolle spielen, wie immer wieder hervorgehoben wird.

Eines erscheint mir aber jedenfalls als sicher: DSLRs mit ausgeprägten Tiefpassfiltern sind weder für Videografie noch für Foto wirklich geeignet.

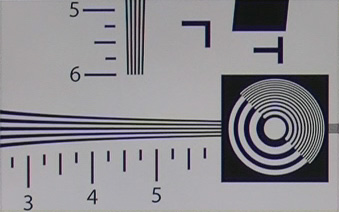

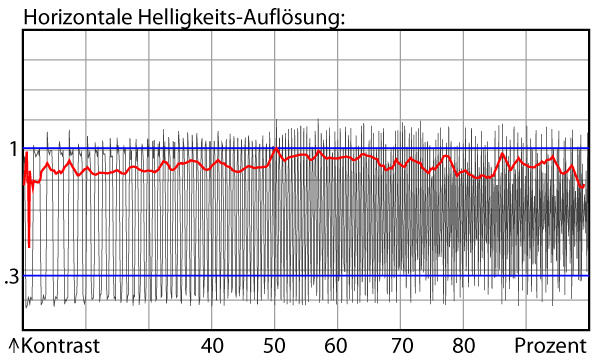

GZ-HM1, ein 1/2,3"-Sensor, 50i:

Antwort von Natalie:

Ich hatte am Wochenende mal unbearbeitets Material zusammengeschnitten und auf BluRay verbannt, dann am 63" Plasma angeschaut. Ich bin mit der Schärfe fast zufrieden, ich finde es potenziert sich wenn der Fokus mal nicht so 100 % sitzt. Aber selbst solche Passagen habe ich mit dem Schärfealgorythmus aus FFMPEG noch verbessern können und sehr zufriedenstellend. Auch das Farbrauschen , daß übrigends bei normalen Sichtabstand nicht auffällt, ist mit dem Algorythmus erheblich verbessert.

habe noch sehr gute Aufnahmen mit der GH2 draufgepackt, Tochter im Sommer im Planschbecken, .. Rein subjektiv ist der Unterschied zum D5200 eher ernüchternd, und nein, ich sitze nicht 1 Meter von einem 63" Fernseher entfernt und bewundere die Plasmazellen... ;-)

Es scheint mir das die Nachbearbeitung genau das Qäuntchen aus dem Material holen kann, im Gegenteil, bei vielen Aufnahmen , gerade Nahaufnahmen kommt der Touch ohne Schärfung sehr gut.

Ich meine, wer mit einem Camcorder filmen möchte kann das ja gerne tun, in den meisten Situationen ist ein Camcorder die einfachere Lösung , mit sehr guten Ergebnissen...

(Ps.: ich kenne niemanden, der sein Material nicht im Programm anpasst, )

Antwort von domain:

Ich denke, auch Tiefflieger wird seine Pana-Videos im NLE bearbeiten. Aber glaubst du wirklich, dass er seine Clips zusätzlich zur ohnehin schon vorhanden Schärfe mit erheblichem Zeitaufwand noch extra nachschärfen wird?

DSLRs, die eine derart nicht vorhandene Schärfe von Haus aus liefern wie die D5200 und andere sind m.E. grenzwertig für Video, alles was Recht ist.

Antwort von cantsin:

habe noch sehr gute Aufnahmen mit der GH2 draufgepackt, Tochter im Sommer im Planschbecken, .. Rein subjektiv ist der Unterschied zum D5200 eher ernüchternd, und nein, ich sitze nicht 1 Meter von einem 63" Fernseher entfernt und bewundere die Plasmazellen... ;-)

Was meinst Du mit "ernüchternd"? Dass da kaum Unterschiede sichtbar sind oder dass doch deutliche Unterschiede sichtbar sind (und welche)?

Antwort von molch:

Natürlich wird das Thema um Ein- und Dreichipper zu sehr pauschalisiert. Der Auflösungsverlust bei einem Chip durch das Debayering ist ein theoretischer Wert, der so nur anzuwenden ist, wenn das Verhältnis der Anzahl physikalischer Pixel zur Auflösung des Endbildes 1:1 ist. Bei einem Sensor mit 10MP kommt es auf die Skalierung/das Binning an und was möglich ist, zeigt der JVC.

Wenn ich mich, aus welchen Gründen auch immer, bewusst für eine DSLR entscheide, in dem Wissen, dass es zur Zeit keine solche Kamera gibt, die ohne Nachschärfung ein gutes Bild liefert, dann ziehe ich es vor, ein Bild mit relativ wenig interner Schärfung zu bekommen, damit ich die Art und den Grad der Nachschärfung in der Postproduktion selber bestimmen kann und nicht auf die schlechten Algorithmen der Kameras angewiesen bin.

Ich glaube, dass der andere D5200 Thread genug Material für diese Grundsatzdiskussion bietet, an der ich mich auch nicht beteiligen möchte, weil die Tatsache, dass sie seit Jahren regressiert, zeigt, dass bereits alle Argumente ausgetauscht und bekannt sind und es letztendlich nach wie vor jedermanns persönliche Entscheidung ist, welches System er bevorzugt. Deshalb wäre es mir sehr lieb, wenn wir bei diesem Thread hier beim Thema bleiben könnten. Wie gesagt, die Diskussion ist im anderen Topic mindestens genauso gut aufgehoben, da sie die Nachschärfung allgemein betrifft. ;)

BTT:

Klar, du kannst natürlich jeden Codec wählen, der dir gut passt. Ich benutze DNxHD, weil es, wie ProRes, ein ressourcenschondender Intraframe Codec ist. Aus diesem Grund sollte die Datenrate bei dem Codec auch nicht zu gering gewählt werden. Die Spezifikation lässt nur noch 36 Mbit zu, und das ist wirklich zu wenig (Sichtbare Blockbildung).

Mit Mpeg4 Encoding in FFMPEG kenne ich mich allerdings nicht gut aus, da müsstest du mal Google bemühen, was 2-Pass und Quantisierung angeht ;)

Dann gehen wir das Ganze mal der Reihe nach durch:

-vcodec definiert den Codec. Als Wert kann ein beliebiger Kürzel aus der Liste, die mit ffmpeg -formats ausgegeben wird, eingetragen werden.

-acodec ist entsprechend der Audiocodec. Hier kopieren wir einfach den Stream.

-vb ist die videobitrate. k steht für Kilobit. m am ende kannst du für eine Angabe in Megabit nutzen.

-Die Filterkette von -vf wird in "" gefasst. Wenn wir mehrere parallele Filterketten haben, werden diese nacheinander Definiert. Getrennt durch ein ;. Die Filter selber werden durch ein Komma separiert und haben die Definition filtername=parameter.

Bei dieser komplexen Filterung starten wir mit einem Split Filter. Dieser Teilt den Stream in Zwei. Der abgetrennte Stream wird mit benannt (Name willkürlich, war ursprünglich copy&paste vom Handbuch) und erstmal links liegen gelassen, denn der erste Stream wird an den nächsten Effekt, den Format Filter, welcher das Pixelformat ändert und ja nur einen Eingang hat, weitergegeben. Anschließend folgt für diesem Stream die Rauschreduktion. Der hqdn3d Filter nimmt 4 ganzzahlige Parameter für die Intensität an: Spatiale Luminanz, spatiale Chrominanz, temporale Luminanz, temporale Chrominanz.

Jetzt machen wir einen kurzen Sprung hinter das ; Zeichen: unsharp sagt, dass wir in der zweiten Filterkette den abgesplitteten Stream als Input für den unsharp filter nehmen. Der unsharp Filter nimmt folgende Parameter an (einfach mal aus dem Handbuch kopiert) luma_msize_x:luma_msize_y:luma_amount:chroma_msize_x:chroma_msize_y:chroma_amount mit Msize ist die Größe der Unschärfematrix pro gemeint. Positive werde für die Intensitäten schärfen das Bild, negative Werde zeichnen Weich. 1.5 bring recht ausgewogene Ergebnisse, 2 wirkt sehr scharf aber bereits etwas überzeichnet, 1 ist relativ Soft. Die Format und hqdn3d Filter in dieser Filterkette sind eigentlich nur Platzhalter, falls man in den Mitten und höhen auch noch ein bisschen rumfiltern möchte.

Das gibt an, dass dies der Output ist. fertig :)

-r 25 ist eigentlich unnötig und stellt nur sicher, dass der Stream am Ende 25 Bilder in der Sekunde hat und somit DNxHD konform ist. Bei der GH2 musste man das so machen, weil sie das 25p Material in einem 50i Kontainer gespeichert hat (gab immer Freude bei der Farbkorrektur, wegen der Streifenbildung durch die separate Encodierung der Halbbilder der Farbebenen. Wenn das in 4:2:2 bearbeitet und das Ergebnis in 4:2:0 ausgegeben wurde, war das nicht schön.).

Ich habe das ganze selber noch nicht wirklich getestet, heute Abend habe ich hoffentlich ein wenig Zeit dafür.

/ Hier sind die Filter aufgelistet:

http://ffmpeg.org/ffmpeg-filters.html

Antwort von Natalie:

@Domain

;-) Ich finde du übertreibst , der LOOk ist für ernsthaften Film sehr brauchbar , NEIN , die Wollmichsau ist diese Kamera nicht , die Quasi bei Neuerscheinung die Hälfte einer GH2 kostet ... Und was kostet es für Zeit eine GH2 in Farbe zu optimieren, jeder Clip anders und total , na dann lieber eine Prozessing Batch und den Rest an den 3 RGB Farbreglern....

aber wer damit keinen vernünftigen Film hinbekommt ist und bleibt ein Pixelpeeper ! 2/3 aller Tatort sind unschärfer und verrauschter, ..

@Cantsin - die Mischung der Bildmaterialien ist durchaus kein Problem, das 5200 Bild ist eben etwas weicher, aber trotzdem HD, es ist sehr ausgewogen und das ohne Nachschärfung in FFMPEG, diese ist echt sehr gut. Es ist eben etwas anderes an seinem Monitor den Kopf auf 50cm nähe an den Monitor zu drücken..

@Molch = Hero ! bin auch gespannt heute abend :-=)

Antwort von Natalie:

hab das eben mal aufgerissen (nicht gerechnet) , wenn ich 45 cm von meinem Monitor mit 50cm Bildbreite sitze, ist das so wie 2 Meter entfernt vor einem 2, 2Meter breiten Bild zu sitzen (nix diagonal, breit)..

Tatsächlich sitze ich aber 4 Meter entfernt vor einem ca 150 breiten Bild

Antwort von rudi:

Hier einmal der erste Versuch eines Befehls, der nur die Schatten entrauscht und alles andere schärft:

ffmpeg -i (input) -vcodec dnxhd -acodec copy -vb 120000k -vf " split , format=yuv420p10le, hqdn3d=0:0:8:8, blend=all_expr='if(lte(A, 70),B,if(lte(A, 80),((1-((80-A)/10))*A)+((((80-A)/10))*B),A))' ; unsharp=3:3:1.5:3:3:1.5, format=yuv420p10le, hqdn3d=0:0:0:0 " -r 25 (output)

Alter Schwede: Das nenn ich ne Kommandozeile:)

Nachdem ich meinen freien Abendstunden auch gerade etwas mit dem D5200 Material herumgespielt habe, vielleicht noch ein paar Cents von mir:

Ich habe in DaVinci mit folgenden Tricks ein paar gute Ergebnisse hinbekommen:

Mit einem Qualifier die dunklen Bereiche maskiert.

Dann nur den Blaukanal vertikal leicht weichgezeichnet.

Damit bekommt man schon die meisten Streifen weg, ohne dass allzuviel Schärfe verloren geht.

Vielleicht kann man das in FFMpeg auch nachbauen. Leider bin kein FFMPEG-Held und meine besten AVISynth Zeiten sind auch vorbei ;(

Antwort von Natalie:

Es funktioniert wirklich gut, habe allerdings nur schnell ein File transcodiert. Die dunklen Bereiche sind noch ruhiger . ( ich kapituliere irgendwie beim Import in Premiere, ich bekomme das File importiert , aber es wird als Audiodatei interpretiert ?)

Antwort von Natalie:

Es funktioniert wirklich gut, habe allerdings nur schnell ein File transcodiert. Die dunklen Bereiche sind noch ruhiger . ( ich kapituliere irgendwie beim Import in Premiere, ich bekomme das File importiert , aber es wird als Audiodatei interpretiert ?)

Die Suche nach einem Mpeg4 Output ist auch schwierig, ich finde allerhand Versionen, aber nur von Leuten die genau damit Probleme und errors haben, ..

Oder mal in der Documentation suchen :))

’-mbd rd -flags +mv4+aic -trellis 2 -cmp 2 -subcmp 2 -g 300 -pass 1/2’, things to try: ’-bf 2’, ’-flags qprd’, ’-flags mv0’, ’-flags skiprd’.

Leider noch ohne Legende ;)

Antwort von molch:

Hmm, die super high quality parameter für h264 mit winff sind:

-crf 15.0 -vcodec libx264 -acodec libvo_aacenc -ar 48000 -ab 192k -coder 1 -flags +loop -cmp +chroma -partitions +parti4x4+partp8x8+partb8x8 -me_method hex -subq 6 -me_range 16 -g 250 -keyint_min 25 -sc_threshold 40 -i_qfactor 0.71 -b_strategy 1 -qcomp 0.6 -qmin 0 -qmax 69 -qdiff 4 -bf 8 -refs 16 -directpred 3 -trellis 2 -flags2 +bpyramid+mixed_refs+wpred+dct8x8+fastpskip -wpredp 2 -rc_lookahead 60 -threads 0

Sollte eine gute Basis sein.

Winff ist übrigends ein gutes FFMPEG GUI, mit der Stapelverarbeitung und das Speichern eigener Profile möglich sind.

http://winff.org/html_new/

Antwort von Natalie:

Ich hab den code jetzt so eingegeben, Space nur zur Abgrenzung, aber ich bekommen die Fehlermeldung "could not find directpred" , Option not found.. Versionsprobleme ? oder mein Synthax

ffmpeg -i D:\FFMPEG\DSC_0112.mov

-crf 15.0 -vcodec libx264 -acodec libvo_aacenc -ar 48000 -ab 192k -coder 1 -flags +loop -cmp +chroma -partitions +parti4x4+partp8x8+partb8x8 -me_method hex -subq 6 -me_range 16 -g 250 -keyint_min 25 -sc_threshold 40 -i_qfactor 0.71 -b_strategy 1 -qcomp 0.6 -qmin 0 -qmax 69 -qdiff 4 -bf 8 -refs 16 -directpred 3 -trellis 2 -flags2 +bpyramid+mixed_refs+wpred+dct8x8+fastpskip -wpredp 2 -rc_lookahead 60 -threads 0

" split , format=yuv420p10le, hqdn3d=0:0:8:8, blend=all_expr='if(lte(A, 70),B,if(lte(A, 80),((1-((80-A)/10))*A)+((((80-A)/10))*B),A))' ; unsharp=3:3:1.5:3:3:1.5, format=yuv420p10le, hqdn3d=0:0:0:0 " -r 25 D:\FFMPEG\DSC_0112d.mov

Antwort von molch:

Hast du das hier schon gelesen?

http://ffmpeg.org/trac/ffmpeg/wiki/x264EncodingGuide

Da wirkt das fast schon unbefriedigend einfach...

Antwort von Natalie:

Die Anleitung hab ich gesucht ... !

Ih kann WinFF noch nicht ausprobieren , aber so wie ich das verstehe sind da Input und Output Formate über die GUI konfigurierbar ,

Antwort von molch:

Quasi. Man kann einfach eigene Befehlszeilen als Presets abspeichern. Dann zieht man seine ganzen Videos rein, wählt das gewünschte Preset, drückt auf Start und lässt die Wunder wirken. Ein Converter halt ;))

Was mir noch nicht gefällt: Der hqdn3d Filter produziert Banding. Ich suche noch nach einer besseren Lösung, aber leider bietet FFMPEG ansonsten noch keine Denoiser.

Antwort von Natalie:

Also es findet sich einiges in Foren zu dem Thema, aber ich kann das nicht hier einordnen ;-), anscheinend gehört der Befehl zu mencoder ??

"However, you can use the new dabanding filter during

playback. -vf gradfun. You can also add gradfun after hqdn3d (-vf

hqdn3d,gradfun) but I'm not sure how much it'll help since encoding

tends to bring back banding artifacts"

"> It's particularly frustrating with animation where the filter causes

> severe banding in areas of one solid color

Reduce the strenght of chroma denoising."

Antwort von Natalie:

Der Hinweis in WinFF nach Änderungen in der Commandozeile unten im Reitet "Apply Changes" zu drücken erspart einem Stundenlanges ausprobieren mit immer dem gleichen File im Output :-) ,

H.264 - wie in der Anleitung zu sehen stellt der Wert hinter CRF die Kompressionsrate ein - in der Anleitung wird von 0 - 51 als Wert gesprochen, der Synthax erfodert aber eine Werteangabe von 1.0 , also anstatt 1 oder 15.0 , anstat 15 ..

Frage:

wie würde eine einfach zu 10 bit Wandlung aussehen, also "(input) 8 auf 10 bit (Output)" bzw, macht das Sinn für die Farbnachbearbeitung den Farbraum auf 10 Bit aufzublasen ?

Antwort von Onkel Danny:

HI,

nein das Aufblasen auf 10bit bringt nicht wirklich was.

Da hier ja nur interpoliert wird.

Warum nennt sich eigentlich ein Kerl Natalie?

greetz

Onkel Danny

Antwort von Natalie:

Hallo Onkel

Wir sind eigentlich 2 , bzw 3 Personen ... , Baum wäre auch gegangen , Strauch weniger, wer unterhält sich schon mit Sträuchern .. Der Name unserer Tochter sollte hier auch nicht stehen, genauso wie unseren richtigen Namen. Es ist auch immer witzig, da räkeln sich 100 Leute mit Pseudonymen ohne zuordbaren Sexus, wenn aber ein Mann hinter einem Frauennamen vermutet wird , birgt das gleich Grund zu den wildesten Diskussionen ;-)

LG

Solveygh & Sebastian & Frida

Antwort von molch:

Molch ist ja auch nicht eindeutig Definiert ;)

Ja, da hier auch keine räumliche Interpolation stattfindet, haben 10 bit prinzipiell keinen Sinn.

Anders sieht das bei DNxHD aus, da die D5200 den kompletten 8-bit Raum schreibt, DNxHD in 8 bit allerdings nur die Werte von 16-235 nutzt. Dies führt zu Banding und die Benutzung des 10 Bit Codecs ist praktisch eine behelfsmäßige Lösung. Wenn ihr einen Codec benutzt, der den vollen yuvj Raum ausfüllt, bekommt ihr natürlich keine Probleme.

// Neue Version:

-vcodec dnxhd -acodec copy -vb 185000k -vf "split , format=yuv420p10le, hqdn3d=0:0:6:6, blend=c1_expr='B':c2_expr='B':c0_expr='if(lte(A, 70),B,if(lte(A, 80),((1-((80-A)/10))*A)+((((80-A)/10))*B),A))' ; unsharp=3:3:1.5:3:3:1.5, format=yuv420p10le " -r 25

Die Farbanteile werden für das ganze Bild entrauscht übernommen. Ist deshalb die bessere Lösung, weil die Übernahme der entrauschten Chrominanz eigentlich an die Luminanz gebunden sein müsste. Das ist in FFMpeg aber leider nicht möglich. Instanzen des format filterswerden gebraucht, weil der Blend Filter komischer Weise jeden 8 bit Farbraum auf sendefähige Farben komprimiert, und indem wir den Stream auf 10 bit konvertieren, überlisten wir ihn quasi.

Antwort von Natalie:

Molche gehören zu der Familie der Schwanzlurche :))

WinFF schmeisst den Fehler ""No such Filter "blend"" raus

Antwort von Angry_C:

Was habt ihr denn für Probleme mit dem D5200 Output? Ich nehme ein Profil mit 0.7 oder 0.8 Gamma, Kontrast etwas raus und Schärfe einen Tick unter Mittelstellung, und ich habe keine Banding- oder Fixed Noise Pattern Effekte, auch nicht bei Unterbelichtung.

Das Ergebnis schlägt in MEINEN AUGEN nach leichtem Nachschärfen im NLE alles andere, was filmende Knipsen so ausgeben.

Antwort von Natalie:

würdest du mal dein Profil bereitstellen :-) ?

Hab den Thread gefunden ..http://www.personal-view.com/talks/disc ... -beta-test

Trotzdem finde ich den Exkurs in FFMPEG sehr spannend und werde auf jedenFall bei Zeit alle Ergebnisse Sammeln

BTW: Hab mal einen Schnelltest am Rechner gemacht, schön Kunstlicht ect., also der optische Eindruck des FLAAT 11p und des Gamma 0.8 sind identisch, auch die Rauschbildung ist gleich (sehr gering muß ich sagen,) farblich gleich,# Den Farbbalanceregler schön nach links , Sättingung und Schärfung bei beiden ganz raus, bei Gamma 0.7 wird es weniger rauschen, aber auch keine Farbe mehr...

Antwort von molch:

Nach meinen Tests gibt das Gamma 0.6 Preset den optimalen Dynamikumfang aus. 0.5 gibt nur noch mehr Rauschen ohne Detailgewinn, 0.7 sowie Flaat11 produzieren in den ganz dunklen Bereichen, wo bei Gamma 0.6 Farben und Details noch klar differenziert werden, nur noch kompressionsblöcke.

So, weiter geht's mit FFMPEG. Es wäre nun praktisch, wenn ihr Programme selber kompilieren könntet...

Es sei angemerkt, dass ich Linux Mint benutze und keine Ahnung habe, wie man auf einem Windows System kompiliert. Hier findet ihr aber Informationen zum Kompilieren von ffmpeg:

http://ffmpeg.org/trac/ffmpeg/wiki/CompilationGuide

Den Fehler des Blend Effekts, dass er den yuvj auf den yuv Farbraum komprimiert, könnt ihr leicht beheben, indem ihr im FFMPEG Quellcode AV_PIX_FMT_YUVJ420P zur Formatliste der query_formats funktion in der Datei libavfilter/vf_blend.c hinzufügt.

Da der hqdn3d Filter durch das starke Banding nicht die gewünschten Ergebnisse liefert, habe ich einen eigenen, simplen temporalen denoiser für das Frei0r framework geschrieben. Frei0r bekommt ihr hier:

http://frei0r.dyne.org/

Ladet den Quellcode herunter, entpackt ihn, dann entpackt meinen angehängten Patch in das Stammverzeichnis des Frei0r Codes und führt im Terminal patch -p0 < denois0r.patch aus. Nun kompiliert und installiert ihr Frei0r.

Anschließend Downloadet ihr den FFMPEG Quellcode (www.ffmpeg.org), modifiziert den Blend Filter wie geschrieben und konfiguriert FFMPEG anschließend wie in der Anleitung beschrieben, aber mit dem Zusatz --enable-frei0r.

Wenn ihr das ganze nun kompiliert und installiert habt, könnt ihr den Frei0r Wrapper von FFMPEG nutzen. Mit -vf frei0r=(filtername):(parameter...) könnt ihr nun Frei0r Effekte verwenden!

Der Denois0r Filter nimmt drei Parameter entgegen: Lumathreshold, Chromathreshold, maximale Luminanz (gibt an, bis zu welcher Helligkeit Pixel gefiltert werden sollen).

Entsprechend sollte der letzte Wert immer dem höchsten Wert in der Überblendungsformel (hier 80) entsprechen.

Die Filterkette

-vf "split , frei0r=denois0r:4:4:80, blend=c1_expr='B':c2_expr='B':c0_expr='if(lte(A, 70),B,if(lte(A, 80),((1-((80-A)/10))*A)+((((80-A)/10))*B),A))' ; unsharp=3:3:1.5:3:3:1.5 "

Sollte eigentlich das beste sein, was man momentan mit FFMPEG für die D5200 tun kann ;)

Antwort von Angry_C:

Ist das Ergebnis denn besser als das von Neat Video?

Vielleicht könntest du ein vorher/nachher Bilder posten?