KIs generieren immer bessere Bilder nach Textbeschreibungen und es war klar, was der nächste Schritt sein würde: das Erstellen von Videos. Jetzt hat Meta AI, die KI Forschungsabteilung von Meta (ehemals Facebook) genau einen solchen Algorithmus vorgestellt. Die "Make-a-Video" getaufte Text-to-Video KI ähnelt den Text-zu-Bild KIs DALL-E 2 und Stable Diffusion, die in den letzten Monaten Furore gemacht haben.

Wie diese hat sie anhand Milliarden von Bildern samt Textbeschreibung gelernt, wie die reale Welt aussieht, aus welchen Objekten sie besteht und wie diese von Menschen beschrieben wird. Zusätzlich dazu allerdings wurde das neuronalen Netzwerk mittels zusätzlicher Schichten für die zeitliche Abfolgen von Bildern noch mit rund 20 Millionen Videos trainiert, um zu lernen wie sich verschiedene Objekte typischerweise bewegen.

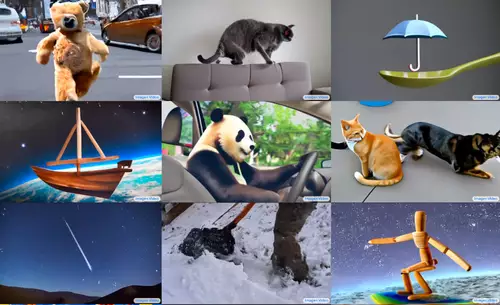

So kann die Make-a-Video KI jetzt nur anhand von Textbeschreibungen beliebige kurze Videoclips erzeugen, wie zum Beispiel "Ein Teddybär malt ein Porträt" oder "Ein flauschiges Babyfaultier mit einer orangefarbenen Strickmütze, das versucht, einen Laptop zu bedienen, wobei sich in seinem Auge ein detailliertem Studiolichtschirm spiegelt". Ähnlich wie bei den bildgenerierenden KIs kann auch hier der Bildstil (realistisch, surreal, abstrakt, stilisiert, ...) beliebig definiert werden.

Erweckt Bilder zum Leben

Als Input kann anstatt eines Textes aber auch ein Einzelbild verwendet werden (analog zur Image-2-Image Methode bei den Bilder KIs), um dieses zu animieren. Werden zwei Bilder (ein Start- und ein Endbild) definiert, generiert der Make-a-Video Algorithmus dann die Zwischenbilder. Alternativ, quasi per Video-2-Video, kann auch ein Video als Input fungieren, von dem Make-a-Video dann Variationen erzeugt.

Meta AI hat zwar die Forschungsarbeit von Make-a-Video veröffentlicht, allerdings nicht den dazugehörigen Code oder das Modell - es dürften aber bald Versuche folgen, einen darauf basierenden Algorithmus nachzubauen.

// Top-News auf einen Blick:

- DJI Mini 5 Pro soll so viel wie die Mini 4 Pro kosten

- Nikon Z6III bekommt u.a. Auto-Capture, USB-Streaming, Vogelmodus

- Blackmagic senkt Preise für URSA Cine 12K und 17k Kits radikal

- Google Gemini 2.5 Flash Image Nano Banana bringt Charakterkonsistenz und Multi-Imag

- Neue Sony FX3 und FX30 Firmware bringt BIG6-Startbildschirm, RAW-Video per HDMI und ...

- Google Pixel 10 Pro (XL) kommt mit Generativer KI direkt in der Kamera

Phenaki KI erstellt sogar noch längere Videos

Wie schnell die Entwicklung gerade voranschreitet beweist auch die Tatsache, daß zeitgleich mit Metas "Make-a-Video" noch ein weiteres Projekt namens Phenaki eines (noch) anonymen Forscherteams erschienen ist, daß nochmal eine deutlich geringere Auflösung aufweist, aber in einem wichtigen Aspekt sogar noch interessanter ist, weil es es die Generierung mehrminütiger Videos erlaubt. So wurde im folgenden Beispiel anhand einer längeren Textbeschreibung ein beeindruckendes 2 Minuten langes Video erzeugt:

Interessant sind die für zur Generierung des Videos verwendeten Prompts (samt Anweisungen für die virtuellen Kamerabewegungen):

"Viel Verkehr in einer futuristischen Stadt. Ein außerirdisches Raumschiff kommt in der futuristischen Stadt an. Die Kamera geht in das Innere des Raumschiffs der Außerirdischen. Die Kamera bewegt sich vorwärts, bis sie einen Astronauten in einem blauen Raum zeigt. Der Astronaut tippt auf der Tastatur. Die Kamera bewegt sich von dem Astronauten weg. Der Astronaut verlässt die Tastatur und geht nach links. Der Astronaut verlässt die Tastatur und geht weg. Die Kamera bewegt sich über den Astronauten hinaus und blickt auf den Bildschirm. Auf dem Bildschirm hinter dem Astronauten sind Fische zu sehen, die im Meer schwimmen. Crash zoomt auf den blauen Fisch. Wir folgen dem blauen Fisch, wie er im dunklen Ozean schwimmt. Die Kamera zeigt durch das Wasser nach oben in den Himmel. Der Ozean und die Küstenlinie einer futuristischen Stadt. Crash-Zoom in Richtung eines futuristischen Wolkenkratzers. Die Kamera zoomt in eines der vielen Fenster. Wir befinden uns in einem Büroraum mit leeren Schreibtischen. Ein Löwe rennt auf den Schreibtischen herum. Die Kamera zoomt auf das Gesicht des Löwen im Inneren des Büros. Zoom auf den Löwen, der einen dunklen Anzug trägt, in einem Büroraum. Der Löwe im Anzug schaut in die Kamera und lächelt. Die Kamera zoomt langsam auf das Äußere des Wolkenkratzers hinaus. Zeitraffer des Sonnenuntergangs in der modernen Stadt"

Hier finden sich noch viele weitere Beispiele von per Phenaki animierten kurzen Clips. Auffällig ist, daß weder die Beispielclips bei Phenaki noch bei Make-a-Video Menschen beinhalten, zu erklären ist das durch die Schwäche der zugrundeliegenden Blidgenerierungs-KIs mit menschlichen Körpern und Gesichtern (ein Clip, auf dem Menschen zu sehen sind ("ein Paar im Regen") demonstriert diese Schwäche eindrucksvoll). Es bleibt zu hoffen, daß der Sourcecode von Phenaki bald veröffentlicht wird, um der KI Community die Weiterentwicklung zu ermöglichen.