Frage von Bas3008:Hallo Leute,

von meiner Überlegung und

diesem Artikel ausgehend, dachte ich mir, ich mache mich auf die Suche nach der besten Möglichkeit, aus "Standard" 4k Material (z.B. 8-Bit 4:2:0 von einer GH4) hochwertiges 1080p (4:4:4 10-Bit) zu konvertieren.

Erstaunlicherweise habe ich nicht allzu viel gefunden.

Ein Thema in einem Forum sah allerdings vielversprechend aus. Dort hat Nutzer

karl, dem ich an dieser Stelle danken möchte, eine sehr interessante

Kommandozeile für den FFmpeg-Konverter geschrieben, die eben besagtes 4k 4:2:0 Material in 1080p ProRes4444 mit 10 Bit Farbtiefe umwandelt.

Das probiere ich gleich mal aus, dachte ich mir. Da ich selbst noch keine 4k-fähige Kamera besitze, habe ich mir von 4ksamples.com ein

Beispielvideo mit ~100mbit/s heruntergeladen und einen 2-sekündigen Abschnitt (ca. bei 44 Sekunden) jeweils mit

Adobe Premiere/Media-Encoder zu 300mbit/s H.264 und der besagten

FFmpeg-Zeile in 1080p Video (~350mbit/s) konvertiert. Und siehe da, ein deutlicher Unterschied!

Das ist aber noch nicht alles: in den Konvertierungs-Optionen selber steht bei den flags "bicubic", was ich aus Photoshop vom Verkleinern/Vergrößern kenne.

Zum Vergleich habe ich anschließend mal einen Screenshot vom 4k-Material in PS verkleinert. (

Bikubisch automatisch und

Bikubisch schärfer lieferten dabei gleiche Resultate)

Das Ergebnis war, dass die Photoshop-Verkleinerungen deutlich schärfer waren als die FFmpeg- / Media-Encoder-Konvertierungen. Nach kurzer

Recherche fand ich heraus, dass Photoshop beim Verkleinern leicht nachschärft.

Anmerkung: FFmpeg bietet zum Skalieren von Videos nicht nur "bicubic" an, sondern verschiedene Algorithmen an, die ich alle mal getestet hab, bei denen man aber keine oder wenn nur minimalste Unterschiede erkennen kann.

Hm. Und jetzt? Eine weitere schnelle

Recherche ergab, dass FFmpeg wohl auch das Nachschärfen beherrscht. Nach ein paar Tests hatte ich dann eine Ergänzung für den die

karl-Parameter, die dem Photoshop-Verkleinern sehr nahe kommen.

Zum Schluss hab ich das ganze noch in eine Windows Batch-Datei geschrieben und Drag-and-Drop-fähig (auch für mehrere Dateien) gemacht.

Hier der Text, der in die Batch-Datei gehört. Wem die Nachschärfung nicht gefällt, kann ",unsharp=3:3:1:3:3:1" gern entfernen/verändern.

@echo off

:again

"C:\Program Files\FFmpeg\ffmpeg.exe" -i "%~1" -filter_complex "extractplanes=y+u+v[y][u][v]; [u] scale=w=iw*2:h=2160:flags=print_info+neighbor+bitexact [us]; [v] scale=w=iw*2:h=2160:flags=print_info+neighbor+bitexact [vs]; [y][us][vs]mergeplanes=0x001020:yuv444p,format=pix_fmts=yuv444p10le,scale=w=iw/2:h=1080:flags=print_info+bicubic+full_chroma_inp+full_chroma_int,unsharp=3:3:1:3:3:1" -sws_dither none -q 0 -quant_mat hq -c:v prores_ks -profile:v 4 -c:a copy -c:s copy -map 0 "%~1_2k_ProRes4444.mov"

shift

if "%~1" == "" goto:finish

goto:again

:finish

pause

Die Screenshots, da sehr groß (verlustfreie PNG), verlinke ich hier:

4k-Screenshot:

Link

4k zu 2k mit Adobe Media Encoder:

Link

4k zu 2k mit FFmpeg:

Link

4k zu 2k mit FFmpeg + Nachschärfung:

Link

Meinungen/Kritik zum Thema sind erwünscht. :)

Viele Grüße,

Bas3008

Antwort von -paleface-:

An für sich ist deine Mühe auf jedenfall zu begrüßen.

Meiner Ansicht bringt das 4k zu 2k 4:4:4 aber leider nichts.

Du wirst dadurch keine bessere Bildqualität oder einen Vorteil in der Postproduktion haben.

Und ich kenne auch keinen wirklich ernst zu nehmendes Beispiel im Internet wo mir jemand das Gegenteil beweisen konnte.

Antwort von Bas3008:

Du wirst dadurch keine bessere Bildqualität oder einen Vorteil in der Postproduktion haben.

Meiner Erfahrung nach hat man beim Grading deutliche Vorteile, wenn das Material ein hohes Chroma Subsampling hat. Oder wenn man mit Blue-/Greenscreen arbeitet ist es sehr von Bedeutung.

Antwort von Silerofilms:

Ich glaube nicht, dass man aus einem 8bit ein 10bit machen kann. Egal wie man es skaliert. Wie soll das gehen?

Antwort von -paleface-:

Meiner Erfahrung nach hat man beim Grading deutliche Vorteile, wenn das Material ein hohes Chroma Subsampling hat. Oder wenn man mit Blue-/Greenscreen arbeitet ist es sehr von Bedeutung.

Dann aber nur wenn du es in 4K Gradest, es zu kleinen Artefakten kommt und du dann beim export einfach in FullHD ausgibst.

Dadurch werden auch die "Fehler" zusammen geschoben und man erkennt sie nicht mehr so stark.

Das selbe beim keyen. Die Kanten die in 4K etwas unsauber zu sein scheinen werden beim export zu HD verwaschen und sind nicht mehr so deutlich sichtbar.

Aber 4K zu HD zu exportieren und dadurch eine sichtliche Verbesserung beim Grading würde ich gerne in ein paar Beispiel Clips/Bilder sehen.

Fände es ja cool...so ist es nicht. Nur für mich ist das Theorie.

Antwort von CameraRick:

Die Frage ist ja auch viel mehr, wo der Vorteil liegen soll es vorhewr umzuwandeln und dann darauf zu arbeiten. Ist doch nur ein weiterer Kompressionsvorgang etc.

Die weitere Frage ist ja auch der Algoritmus: nicht jeder Filter (bicubig, nearest neighbour, whatever) wird das gleiche "verbessernde" Ergebnis bringen. Hat da mal wer durchgecheckt? Skalieren ist nicht gleich skalieren!

Wieso nicht in der Software herunter skalieren und im Arbeitsraum des Programms arbeiten, und das bei voller Präzision mit

allen vorhandenen Daten?

Gerade beim Keyen etc ist es so ein Murks. Jede gescheite Comp-Anwendung kann doch selbst prima skalieren, und sogar den Filter selber wählen und direkt sehen welcher Algorithmus da im Zweifel wirklich was bringt.

Alles ziemlicher Humbug, irgendwo

Antwort von Bas3008:

@paleface Rein technisch ist es so gesehen natürlich egal, ob man vor oder nach dem Graden skaliert, aber wenn man direkt in 1080p arbeitet, hat es gerade bei schwacheren Rechnern aus Sicht der Performance Vorteile.

@CameraRick

nur ein weiterer Kompressionsvorgang

Da muss ich widersprechen. Beim Konvertieren zu >300mbit/s ProRes wird marginal wenn nicht gar nicht komprimiert. Man hat eher einen Performance-Gewinn aufgrund des Intraframe-Codecs.

nicht jeder Filter (bicubig, nearest neighbour, whatever) wird das gleiche "verbessernde" Ergebnis bringen. Hat da mal wer durchgecheckt?

Ich hatte das, wie schon oben geschrieben durchgecheckt. Keine sichtbaren Unterschiede. Bicubic sorgt schon für annehmbare Ergebnisse.

Gerade beim Keyen etc ist es so ein Murks. Jede gescheite Comp-Anwendung kann doch selbst prima skalieren, und sogar den Filter selber wählen und direkt sehen welcher Algorithmus da im Zweifel wirklich was bringt.

Ich sehe nicht, wo das Murks ist. Es spart einem Zeit und Rechenleistung, wenn man eh vor hat, das ganze auf 1080p runterzurechnen. Bspw. kann man über Nacht alle Dateien konvertieren lassen und am nächsten Tag wunderbar flüssig im Schnittprogramm mit arbeiten.

Antwort von -paleface-:

@paleface Rein technisch ist es so gesehen natürlich egal, ob man vor oder nach dem Graden skaliert, aber wenn man direkt in 1080p arbeitet, hat es gerade bei schwacheren Rechnern aus Sicht der Performance Vorteile.

DAS ist ja ein ganz anderes Thema.

Proxys von seinen Datein zu machen um flüssiger zu schneiden, macht auch Sinn.

Mache ich auch des öfteres, jenachdem was ich für Material bekomme.

Aber es geht ja darum durchaus runterrechnen eine "bessere" Bildqualität bzw. mehr Spiel beim Grading zu bekommen.

Das ist ja ein ganz anderes Thema.

Antwort von Bas3008:

Wie aus 8 Bit 10 Bit wird, kann ich mir, um ehrlich zu sein auch nicht erklären. Wird aber auf jeden Fall mehrfach so angegeben, wenn man 4k/8 bit zu 2k runterskaliert.

Aber aus 4:2:0 Material beim runterskalieren 4:4:4 zu machen, hat doch keinen Nachteil, abgesehen vielleicht von der höheren Dateigröße. Wenn man es bei 4:2:0 belässt, verliert man Farbinformationen, die vielleicht für den einen oder anderen praktisch gewesen wären.

Antwort von TheBubble:

Wie aus 8 Bit 10 Bit wird, kann ich mir, um ehrlich zu sein auch nicht erklären.

Im Prinzip kann man bei einer einfachen für sich allene durchgeführten 8 Bit zu 10 Bit Wandlung keine fehlenden Bits zurückgewinnen.

Wenn die 8 Bit Aufnahmen jedoch spatiales Dithering enthalten (z.B. weil ursprüngliche 10 Bit in 8 Bit mit Dithering gewandelt wurden), dann kann man bei gleichzeitigem Subsampling (Herunterskalierung) unter bestimmten Voraussetzungen Informationen aus dem Dithering wieder in Helligkeitsabstufungen (diese dann ohne Dithering) umwandeln.

Antwort von TomStg:

Hallo Leute,von meiner Überlegung und

diesem Artikel ausgehend, dachte ich mir, ich mache mich auf die Suche nach der besten Möglichkeit, aus "Standard" 4k Material (z.B. 8-Bit 4:2:0 von einer GH4) hochwertiges 1080p (4:4:4 10-Bit) zu konvertieren.

So waren auch die Alchemisten im Mittelalter unterwegs, die aus Blei Gold machen wollten.

Was Du an Farbsamplingtiefe nicht aufgenommen hast, kann sich später nicht erzeugen lassen. Gilt auch für die Akrobaten, die mit ihrem Shogun aus Consumer-Cams 4:4:4 holen wollen. Ziemlich einfache Tatsache, aber Wundergläubige gibt es leider heutzutage immer noch reichlich.

Wenn ein Analysetool nach dem Rumfummeln tatsächlich 4:4:4 anzeigt, heißt das noch lange nicht, dass es echtes 4:4:4 ist. So wie aus Blei-Atomen keine Gold-Atome werden können, wird aus 4:2:0 auf wundersame Weise kein 4:4:4. Aber vielleicht könnte ein Wünschelrutengänger helfen? Oder Besprechen des Materials bei Vollmond an einem ungeraden Wochentag?

Antwort von Bas3008:

So waren auch die Alchemisten im Mittelalter unterwegs, die aus Blei Gold machen wollten.

Was Du an Farbsamplingtiefe nicht aufgenommen hast, kann sich später nicht erzeugen lassen. Gilt auch für die Akrobaten, die mit ihrem Shogun aus Consumer-Cams 4:4:4 holen wollen. Ziemlich einfache Tatsache, aber Wundergläubige gibt es leider heutzutage immer noch reichlich.

Wenn ein Analysetool nach dem Rumfummeln tatsächlich 4:4:4 anzeigt, heißt das noch lange nicht, dass es echtes 4:4:4 ist. So wie aus Blei-Atomen keine Gold-Atome werden können, wird aus 4:2:0 auf wundersame Weise kein 4:4:4. Aber vielleicht könnte ein Wünschelrutengänger helfen? Oder Besprechen des Materials bei Vollmond an einem ungeraden Wochentag?

Kannst du deine Ansicht nicht mit sachlichen Argumenten belegen? Was hat dieser sarkastische Mist hier zu suchen?

Lies dir den oben verlinkten Artikel durch, dann wirst du verstehen, dass es durchaus Sinn macht, beim Verkleinern ein höheres Chroma Subsampling zu erhalten.

Antwort von cantsin:

Lies dir den oben verlinkten Artikel durch, dann wirst du verstehen, dass es durchaus Sinn macht, beim Verkleinern ein höheres Chroma Subsampling zu erhalten.

Der Artikel ist von EOSHD (räusper...).

Antwort von Bas3008:

Ach Leute ... es ist doch ganz logisch, wenn man versteht, wie das Verfahren der Farbunterabtastung funktioniert.

Antwort von WoWu:

Stimmt, es ist ganz logisch, dass es nicht funktioniert, wenn man verstanden hat, wie Unterabtastung funktioniert.

Solche Artikel setzen auf IT Erkenntnissen auf, in deren Grafik Bereiche jeweils vom Scratch her neu gerendert werden und mathematisch mehr Wertebereiches benutzen können.

Das hat aber leider nichts mit Videoverarbeitung zu tun.

Und darum geht es hier wohl.

Aber das Thema ist hier schon so oft besprochen worden, dass ich die Suchfunktion empfehlen kann.

Antwort von MLJ:

"TomStg" hat das ganze hier sehr schön auf den Punkt gebracht, es bringt absolut nichts 4:2:0 nach 4:2:2 oder 4:4:4 zu wandeln. Was nicht da ist kann man auch nicht dazu rechnen oder gar "herein zaubern". Anders sieht es bei 4:4:4 nach 4:2:2 oder 4:2:0 aus, aber umgekehrt ? Reiner Unfug und Aberglaube.

Ich gebe da "WoWu" vollkommen Recht und wirklich "verlustfrei" wäre hier das komprimierte 4:2:0 Material in 4:2:0 Unkomprimiert (12 Bit) zu Wandeln um die Hardware voll zum Zug kommen zu lassen um damit zu arbeiten. Alles andere ist vergeudete Zeit und kein Codec zaubert aus 4:2:0 ein 4:4:4, pure Augenwischerei.

Weiterhin wird immer wieder gerne vergessen das man am Ende wieder meist in 4:2:0 komprimiert wenn das Projekt abgeschlossen ist. Also warum den Farbraum unnötig verlassen und immer wieder um-kodieren ? Das bringt absolut nichts und irgendwann hat man am Ende den Chroma Raum vollkommen ruiniert denn jede Wandlung kostet am Ende Qualität auch wenn sie nicht sofort sichtbar ist.

Cheers

Mickey

Antwort von Bas3008:

Das hat aber leider nichts mit Videoverarbeitung zu tun.

Wer so etwas behauptet, kann das doch sicher mit Erläuterungen oder wenigstens Links dazu untermauern, oder? Wo liegt denn der Unterschied zur Videoverarbeitung?

Antwort von Silerofilms:

Aus einem 4k 4:2:0 Material kann man schon ein HD 4:2:2 Material machen. Beim runterskalieren werden dadurch ja die Informationen von zwei Pixeln in einen Pixel gebracht. Aber aus 8bit werden keine 10bit.

Antwort von Bas3008:

Aus einem 4k 4:2:0 Material kann man schon ein HD 4:2:2 Material machen. Beim runterskalieren werden dadurch ja die Informationen von zwei Pixeln in einen Pixel gebracht. Aber aus 8bit werden keine 10bit.

Beim Runterskalieren werden aus 4 Pixeln einer gemacht. *

Antwort von WoWu:

Das ist sehr einfach...

Stell Dir einen Pixelblock in Rot und einen daneben liegenden in Grün vor.

Bei einer Unterabtastung entsteht am Übergang aus den roten und grünen Pixels ein (oder mehrere, je nach Algorithmus) gelber Bildpunkt.

Du hast also statt 2 nun drei Farben im Bild.

(hier mal nur horizontale Unterabtastung betrachtet. Für vertikal gilt gleiches)

Wandelst Du jetzt von 4K nach 2K ist so ein downscaling nichts weiter als eine weitere Unterabtastung.

Am Übergang Rot/gelb wird eine weitere Farbe erzeug und am Übergang gelb/grün noch eine Farbe. Du hast es also jetzt mit 5 Farben, statt mit 2 Farben zu tun. Weil sie aber auf weniger Bildpunkte verteilt werden (4K nach 2K) die Pixels aber nicht kleiner werden, hast Du spatial eine grössere ungenaue Fläche.

Der Bildfehler vergrössert sich also nicht nur inhaltlich sondern auch räumlich.

Nur zur Erinnerung 4:4:4 macht man ja wegen der Farbtreue und nicht wegen der Farbmenge -die ja nicht mal im Bild ist- denn die gelbe Linie war ja nicht im Bild.

Das "mehr" an Schärfe nimmst Du aus den Kantenaufstellungen wahr denn nach dem Heynacher Integral wird der Kontrast an niedrigen Ortsfrequenzen als Schärfenzugewinn wahrgenommen, obwohl es faktisch ein Verlust an Bilddetails ist.

Wer mehr Kantenkontraste mit Bildauflösung verwechselt, mag das Ergebnis als Bildverbesserung wahrnehmen.

Nur das hätte man in der Post auch leicht haben können.

Antwort von cantsin:

Gehen wir doch mal vom umgekehrten Fall aus, der Einfachheit halber mit 1bit vs. 4bit statt 8bit vs. 10bit: Wir haben 1080p in 4bit (also mit 16 Graustufen) und skalieren das auf 2160p in 1bit (also mit monochrom schwarzen oder weissen Pixeln) hoch. Für jeden Pixel haben wir jetzt 4 Pixel, und damit können wir die 4bit als 4*1bit codieren - kein Problem. Anschliessend können wir das Material auch wieder prima in 1080p 4bit zurückcodieren - ebenfalls kein Problem.

Allerdings gibt es hier schon die Einschränkung, dass wir einen mathematischen Code verwenden, in dem z.B. 1-0-1-0 etwas anderes bedeutet als 0-1-0-1. Optisch liegt das anders, und wird können mit vier diskreten Pixeln nur noch 5 statt 16 Graustufen kodieren (nämlich 0000, 0001, 0011, 0111, 1111), also nur noch 2 1/2 Bit statt 4bit. Wenn sich aber aus 2160p/1bit problemlos 1080p/2.5bit generieren lassen, müssten analog aus 2160p/8bit noch 1080p/10bit machbar sein?

Aufnahmetechnisch nein. Bleiben wir mal bei dem einfacheren Beispiel: eine Lichtmenge, die bei 4bit/1080p z.B. einen Pixel mit dem Helligkeitswert 15 erzeugt, würde bei 1bit/2160p den Wert 1 ergeben. Auch wenn das Licht auf die 4 Pixel des höherauflösenden Sensors in leicht unterschiedlicher Stärke fällt, wird der Sensor immer daraus "1" machen - also Abstufungen einfach nicht erfassen. Aus 4mal "1" bei 2160p wird beim Skalieren auf 1080p schlicht "16", also der Maximalwert. Die Wahrscheinlichkeit, dass subtilere Werte wie 13, 14, 15 erzeugt werden, ist äussert gering - denn dann müsste das Licht ja so auf den 2160p-Sensor einfallen, das es gerade zwischen 50% oberen Helligkeits- und 50% unteren Schattenwerten kippt.

Hinzu kommt noch bei einer Kamera wie der GH4, dass sie mit einem stark komprimierenden Codec arbeitet. Selbst wenn also der Sensor auf seinen 4 monochromen Pixeln z.B. "0-1-1-1" registrieren würden, würde der Codec wegen der Platzersparnis daraus "1-1-1-1" machen.

Das alles wurde so ähnlich übrigens auch im Forum von EOSHD diskutiert - interessanterweise scheint diese Diskussion aber nicht mehr auf der Website zu stehen.

Antwort von WoWu:

Für solche Erklärungen hätte ich mir nun wieder gleich "n Rüffel eingefangen :-(

Wart" mal ab, damit bist Du bald auch bei Einigen hier auf der schwarzen Liste ;-)

Antwort von Bas3008:

Das ist sehr einfach...

Stell Dir einen Pixelblock in Rot und einen daneben liegenden in Grün vor.

Meinst du mit Pixelblock 2x2? Also so?

Antwort von Bas3008:

@cantsin Wolltest du damit jetzt sagen, dass man 2k nicht wieder auf 4k verlustfrei hochskalieren kann, aufgrund der verlorengegangen Luminanz-Pixel?

EDIT: bzw. dass beim runterskalieren von 4k zu 2k die Luminanz-Pixel verloren gehen

Antwort von WoWu:

Du kannst auch nur 2 Pixels nebeneinander betrachten.

Kleine Anschauung als Anlage.

Der Unterschied zwischen Computergrafik und Video, auf die ich eingangs hingewiesen habe ist übrigens, dass Video den Fehler ins Bild "einbackt", und es so fehlerbehaftet in das NLE gibt, wo dann Fehlerfortpflanzung geschieht, im Computer aber durch Veränderungen der Eingaben ein Neutendern entsteht.

Das ist so, als würdest Du das Bild der Optik nochmal erzeugen und entlang der neuen Vorgaben, neu abtasten.

Antwort von TheBubble:

Das ist sehr einfach...

Stell Dir einen Pixelblock in Rot und einen daneben liegenden in Grün vor.

Bei einer Unterabtastung entsteht am Übergang aus den roten und grünen Pixels ein (oder mehrere, je nach Algorithmus) gelber Bildpunkt.

Du hast also statt 2 nun drei Farben im Bild.

Das beschriebene Problem tritt aber bei jeder Art von interpolierender Skalierung auf.

Ich nehme an, dass von den 4K 4:2:2 nach 2K 4:4:4 Befürwortern ein anderer Prozess gemeint ist, bei dem nur das Luma-Raster bearbeitet wird. Müsste die Software natürlich speziell untersstützen, allgemeines Skalieren - insbesondere in RGB-Darstellung - würde wohl in der Praxis vermutlich meist zu etwas anderes Ergebnissen führen.

Zur Illustration habe ich für alle Mitlesenden eben rasch eine Skizze gemacht und angehängt.

PS: Skizze aktualisiert.

Antwort von WoWu:

Nur die falsche Farbe bekommst Du damit auch nicht weg.

Und schwarz weiss machen wir ja nicht mehr. :-)

Antwort von Bas3008:

@TheBubble Super! Genau so meinte ich das.

Antwort von WoWu:

Funktioniert nur nicht, weil du 3x Luma machst und aus der ersten Unterabtastung bereits eine Fehlfarbe hast und 4:4:4 würde ja bedeuten, an der Stelle die korrekten Farben zu rekonstruier n.

Video funktioniert leider nicht so, wie die Grafik zeigt.

Antwort von TheBubble:

Nur die falsche Farbe bekommst Du damit auch nicht weg.

Welche falsche Farbe? Die Farbe soll ja schon von Beginn an praktisch komplett in Cb und Cr stecken, was unangetastet bleibt. Nur an der Helligkeit wird gearbeitet.

Antwort von WoWu:

Welche falsche Farbe?

Siehe Bild.

Ausserdem haben in der Grafik die 4 Grauwerte in Realität ja auch unterschiedliche Helligkeiten, sodass auch daraus eine Gewichtung entsteht, die man hier geflissentlich in der Grafik weglässt.

Die Grafik repräsentiert eigentlich nur einen monochromen Bildschirm.

Da funktioniert das vorzüglich ... hat aber mit Video nichts zu tun.

Nee, nee, dann wäre jede 4K Kamera in HD eine 4:4:4 Kamera ... das hätte auch schon das schwächste Marketing ausgeschlachtet.

Antwort von TheBubble:

Ausserdem haben in der Grafik die 4 Grauwerte in Realität ja auch unterschiedliche Helligkeiten, sodass auch daraus eine Gewichtung entsteht, die man hier geflissentlich in der Grafik weglässt.

Habe ich nicht weggelassen. Die dargestellte bilineare Interpolation entspricht einer Mittelwertbildung, d.h. konstanter Gewichtung von 4 Samples bei der Bildung eines Neuen.

Nee, nee, dann wäre jede 4K Kamera in HD eine 4:4:4 Kamera ... das hätte auch schon das schwächste Marketing ausgeschlachtet.

Kameras machen solche Resampling-Vorgänge - und viel mehr - doch auch intern. Was heute rauskommt ist doch alles irgendwie gefiltert und umgerechnet und dürfte kaum mehr eine nachvollziehbare Zuordnung zur einzelnen Sensor-Elementen erlauben. Von echten RAW-Ausgaben mal abgesehen.

Antwort von WoWu:

Habe ich nicht weggelassen. Die dargestellte bilineare Interpolation entspricht einer Mittelwertbildung, d.h. konstanter Gewichtung von 4 Samples bei der Bildung eines Neuen.

Klar hast Du das weggelassen, weil a) nicht alle Ausgangspixel monochrom sind und b) das Ergebnispixel in dem Fall ungleich eines jeden Ausgangspixel wäre.

Sieht man leider nicht, weil es hinter dem bunten Pixel verschwindet.

Und die Änderung der Luminanzwerte der einzelnen Farbkanäle bedeutet immer eine Farbverschiebung.

Das bedeutet aber auch, dass das Ergebnis keine Rekonstruktion des Ausgabewertes ist sondern deutlich abweicht.

Das ist zwar eine verblüffende Grafik, hat aber nur Relevanz bei monochromen Bildern.

Und auf die Kameraabweichungen würde ich gar nicht setzen.

Wenn eine Kamera 4:4:4 bei HD macht, kannst Du ein EI darauf backen, dass das in BILDZEITUNGSLETTERN auf jeder Verpackung stünde.

Aber dieses Theme ist hier schon x-mal besprochen. Ich habe eigentlich keine lust da nochmals in Medias zu gehen.

Das kann man alles mit der Suchfunktion rekonstruieren.

Und wer aus einer 4:2:0 eine 4:4:4 machen kann, sollte das zum Nobelpreis anmelden.

Aber ich befürchte, da kommt er nicht mal weiter mit bei "Jugend forscht".

Antwort von cantsin:

@cantsin Wolltest du damit jetzt sagen, dass man 2k nicht wieder auf 4k verlustfrei hochskalieren kann, aufgrund der verlorengegangen Luminanz-Pixel?

EDIT: bzw. dass beim runterskalieren von 4k zu 2k die Luminanz-Pixel verloren gehen

Nein, dass bei der 4k-Aufnahme in der geringeren Bittiefe die Wahrscheinlichkeit sehr gering ist, dass Luminanzwerte so abgestuft erfasst werden, dass sie beim Runterskalieren in eine höhere Bittiefe diese Bittiefe auch ausfüllen.

Nochmal einfach zusammengefasst: Wenn ein 1-bit Sensor ein hell abgestuftes Bild als vier weisse Pixel erfasst, wird daraus auch beim Runterskalieren in einen 4bit-Graustufen-Pixel nur ein weisser Pixel. (Hätte der Sensor in der hohen Pixelauflösung jedoch auch eine höhere Graustufenauflösung, würde er vier Pixel in unterschiedlichen Hellgrau-Werten aufzeichnen, aus denen beim Runterskalieren in 4bit auch ein hellgrauer statt weisser Pixel würde.)

Antwort von TheBubble:

@WoWu:

Ich will jetzt auch nicht in eine riesen Diskussion darüber einsteigen und will auch gar nicht abstreiten, dass die Y-Werte auch einen kleinen Beirag zur Farbe leisten, aber Du forderst letztlich Dinge, die vermutlich keine existierende Kamera oder Verarbeitungs- und Darstellkette erfüllt.

Schon die erstmalige Erzeugung von 4:2:2 ist fehlerhaft. Und auch die noch davor stattfindene Bayer-Sensor-Pattern Auswertung (bei 1-Chip-Kameras) ist ungenau.

Dann kommt Die erste verlustbehaftete Kompression.

Schnittprogramme machen häufig aus 4:2:2 einfach 4:4:4, indem sie die einzelnen Chroma-Samples vervierfachen (und diese Vorgehensweise hat sogar Vorteile), um Effekte (und auch wenn es nur Texteinblendungen sind) in RGB berechnen zu können.

Dann kommt Die zweite meist noch viel mehr verlustbehaftetere Kompression.

Und dann noch das, was nachher noch ein durchschnittlicher TV in seiner Voreinstellung macht...

Es gibt so viele Dinge, über die man sich zu Recht beschweren darf, die beschriebene Umwandlung ist da allerdings noch das allerkleinste Problem.

Antwort von Bas3008:

@cantsin Ah, das verstehe ich. Hätte aber auch keinen Nachteil, falls der unwahrscheinliche Fall doch eintritt. :P

Antwort von cantsin:

Es gibt so viele Dinge, über die man sich zu Recht beschweren darf, die beschriebene Umwandlung ist da allerdings noch das allerkleinste Problem.

Es beschwert sich ja keiner über die Umwandlung, sondern nur über den Mythos/Blogger-Hype, dass bei dieser Umwandlung eine signifikant größere Farbtiefe entsteht.

Antwort von WoWu:

Umso schlimmer .... Je ungenauer die Vorlagewerte nämlich sind umso größer ist der Fehler in der Fortpflanzung.

Aber bleiben wir bei einem Lumabeispiel, weil Du immer auf die Geringfügigkeit der Farbe abhebst.

Denk Dir ein Pepitamuster aus abwechselnd schwarzen und weißen Pixels.

Du hast Göeichgewichtung angenommen ... Das bedeutet, dass Du mit der ersten Unterabtastung ein schlicht graues Bild hast.

Das gibst Du jetzt in das NLE und fasst jeweils 4 Pixels zusammen zu einem Zielpixel .... Was meinst Du, wie das Pixel aussehen wird ?

4:4:4 würde aber die Rekonstruktion von je zwei weißen und je zwei schwarzen Pixels bedeuten .... Und dann noch an den richtigen Plätzen !!!!

Nee, nee Bubble, das ist blasse Theorie für monochrome Bilder und wenn die Kameras auch noch schlecht sind, wo ich Dir Recht gebe, dann wird so eine Aktion noch unmöglicher denn was im Idealzustand nicht mal funktioniert, funktioniert in einem Ramdomumfeld gar nicht mehr.

Antwort von TheBubble:

Aber bleiben wir bei einem Lumabeispiel, weil Du immer auf die Geringfügigkeit der Farbe abhebst.

Denk Dir ein Pepitamuster aus abwechselnd schwarzen und weißen Pixels.

Du hast Göeichgewichtung angenommen ... Das bedeutet, dass Du mit der ersten Unterabtastung ein schlicht graues Bild hast.

Ich nehme an, Du meinst eine Art Schachbrettmuster? Klar, das führt zu mittelgrauen Werten. 1,0,1,0, ... wird halt zu 0.5,0.5. 0, 1, 1, 0, ... ebenfalls.

Das ist aber aus mehreren Gründen kein neues Problem:

- Weil die Ausgangsbitmap ohnehin schon als Mindesanforderung das Abtasttheorem erfüllen muss,

- weil dieser extreme Grenzfall (kleinstes mögliches Schachbrett- oder Linienmuster) in der Praxis so gut wie nie auftritt,

- weil das Grau eine akzeptable Tiefpassfilterung eines zu hochfrequenten Musters aus schwarzen und weißen Linien oder Punkten wäre,

- weil solch ein Subsampling für die Chroma-Samples bei der Erzeugung des 4:2:0-Ausgangsformats bereits stattgefunden hat und die Luma-Samples sozusagen nur nachziehen,

- weil sowieso immer skaliert werden muss, wenn die Sensorauflösung nicht exakt zu der des Ausgabeformats passt,

- weil jedes unterabgetastete 4:2:2, 4:2:0, usw. Format in den bzw. mit seinen Chromakanälen ohnehin schon ähnliche Probleme haben kann und auch haben dürfte,

- weil Deine Wünsche nur durch eine vollständige 4:4:4 Verarbeitungskette in der Kamera zu lösen wären. Hier geht es aber darum aus vergleichweise noch bezahlbaren und vor allem verfügbaren 4K 4:2:0 Kameras ein 2K 4:4:4 zu bauen. Echte 4:4:4 3-Chip Kameras kann man AFAIK nicht zu vernünftigen Preisen kaufen.

Ich höre hier mal auf, mir fallen bestimmt noch eine ganze Reihe weiterer Argumente ein. :-)

4:4:4 würde aber die Rekonstruktion von je zwei weißen und je zwei schwarzen Pixels bedeuten .... Und dann noch an den richtigen Plätzen !!!!

Eigentlich nein, denn das Ergebnis soll ja nur die halbe Auflösung haben. Da dürfen feine Linien oder Punkte durchaus zu einem Grauwert verschmelzen.

PS: In meinem Schaubild (siehe den Beitrag weiter oben) war ein Tippfehler, dort hätte nicht 4:2:2 sondern 4:2:0 stehen müssen. Ich habe es daher aktualisiert und neu hochgeladen.

Antwort von motiongroup:

Schöne Diskussion, vielleicht gehts mal ohne Beleidigungen durch..

Wie sieht es denn aus wenn im Endeffekt in dem NLE bspw. Cadrage,Resizing und oder auch Stabilisierung zum Einsatz kommt..

In FCPx bspw. kann das Material ja als Prores HQ allerdings 10Bit 4:2:2 zwangsoptimiert werden und oder auch als Prores QuaterSize 10Bit 4:2:2 gewandelt verwendet werden.

Stellt sich die Frage ob das in fcpx bis auf den Leistungsgewinn bei schwachbrüstigen Systemen wirklich etwas bringt zumal fcpx die Backround Rederfiles so oder so via Prores HQ 10bit 4:2:2 verarbeitet und aus diesen ausgibt..

Was zu testen wäre...

4knativ->Timeline 4kProresHQ422->FullHD Export

4kProresHQ->Timeline 4kProresHQ422->FullHD Export

4knativ->Timeline4KProres-2kProxy->FullHD Export

2kProxy->Timeline FullHD Prores HQ422->FullHDExport

Danke für den Anstoß Bas3008

Antwort von Axel:

4:4:4 würde aber die Rekonstruktion von je zwei weißen und je zwei schwarzen Pixels bedeuten .... Und dann noch an den richtigen Plätzen !!!!

Eigentlich nein, denn das Ergebnis soll ja nur die halbe Auflösung haben. Da dürfen feine Linien oder Punkte durchaus zu einem Grauwert verschmelzen.

Nicht die halbe, sondern nur die viertel Auflösung.

Das eine Pixel, das aus vieren entsteht, ist natürlich ein interpoliertes, das von einem Bildpunkt in der Realität, sagen wir einem Kuchenkrümel, der in der originalen UHD-Aufnahme drei Pixel "Durchmesser" hatte, nichts zu tun hat.

In der Praxis scheint höhere spatiale Auflösung wichtiger zu sein als höhere Farbauflösung, was Keyingtests belegen. Runterskaliertes UHD 4:2:0 verhält sich in dieser Hinsicht anscheinend ungefähr wie HD 4:4:4. Das müsste auch durchaus Einfluss auf das Grading haben (eine entsprechende intelligente Skalierungsmethode vorausgesetzt), aber davon verspreche ich mir nicht viel. Denn außer für Keying, wo es um die Auswahl von Flächen geht (eigentlich deren "Kanten"), bleibt der Unterschied unsichtbar. Abgesehen davon, dass natürlich viele Techniken beim Graden ebenfalls im Endeffekt Keying beinhalten, ist die Farbtiefe hier wichtiger. Und die lässt sich leider mit Rechentricks nicht erhöhen, meines Wissens.

Antwort von TheBubble:

Eigentlich nein, denn das Ergebnis soll ja nur die halbe Auflösung haben. Da dürfen feine Linien oder Punkte durchaus zu einem Grauwert verschmelzen.

Nicht die halbe, sondern nur die viertel Auflösung.

Halbe Aufloesung ist schon richtig, das entspricht einem Viertel an Pixeln.

Antwort von Axel:

Eigentlich nein, denn das Ergebnis soll ja nur die halbe Auflösung haben. Da dürfen feine Linien oder Punkte durchaus zu einem Grauwert verschmelzen.

Nicht die halbe, sondern nur die viertel Auflösung.

Halbe Aufloesung ist schon richtig, das entspricht einem Viertel an Pixeln.

???

Wird die Auflösung nicht mehr in Pixeln angegeben?

Antwort von Bommi:

Wenn eine Kamera 4:4:4 bei HD macht, kannst Du ein EI darauf backen, dass das in BILDZEITUNGSLETTERN auf jeder Verpackung stünde.

Im Gegenteil: Jeder Hersteller, der auch 4:4:4 Kameras produziert, würde diese Info unterschlagen. Auch ist bekannt, dass bei Consumer-Geräten die Leistung künstlich beschnitten wird, um hohe Preise beim Profi-Equipment durchsetzen zu können.

Antwort von Axel:

Wenn eine Kamera 4:4:4 bei HD macht, kannst Du ein EI darauf backen, dass das in BILDZEITUNGSLETTERN auf jeder Verpackung stünde.

Im Gegenteil: Jeder Hersteller, der auch 4:4:4 Kameras produziert, würde diese Info unterschlagen. Auch ist bekannt, dass bei Consumer-Geräten die Leistung künstlich beschnitten wird, um hohe Preise beim Profi-Equipment durchsetzen zu können.

Das könnte slashCAM-Mitglied Tiefflieger nur bestätigen. Sein kleiner Panasonic-Fäustling schießt schon seit Jahren 8k-Videos, dank 3-Chip-Technologie sogar eigentlich in 444.

Antwort von WoWu:

Hallo Bubble

Eigentlich nein, denn das Ergebnis soll ja nur die halbe Auflösung haben. Da dürfen feine Linien oder Punkte durchaus zu einem Grauwert verschmelzen

Eigentlich doch, es war nur -zugegebener Massen- etwas zu verkürzt ausgedrückt.

Unterabtastung ist ja (in unserm fall) eigentlich keine spatiale Angelegenheit sondern eine Frage der Farbpräzision, also eine Frage der korrekten Farbreproduktion. Wenn aus 4 Farben eines 4:4:4 abgetasteten Bildes nur noch eine Farbe bei 4:2:2 wird, hat bereits ein nicht mehr reversibler Prozess stattgefunden, denn eine Rückführung auf 4:4:4 würde bedeuten, dass diese entstandene Fehlfarbe (denn die gibt es im Kameramild ja gar nicht) zurückverwandelt wird in ihre 4 Ausgangsfarben.

Du behauptest aber dass die Fehler einer Unterabtastung durch eine zweite Unterabtastung aufgehoben werden, also aus 4:2:2 wieder 4:4:4 wird und damit die Fehlfarbe wieder in die Ausgangsfarben reproduziert wird.

Deiner Ausführung, dass die Fehlfarbe in einer kleineren spartieren Auflösung gar nich auffällt, habe ich schon verstanden aber die Fehlfarbe bleibt erhalten und ist somit nicht 4:4:4 geworden sondern bleibt eine Fehlfarbe, also 4:2:2.

Und schlimmer noch, durch die 2. Unterabtastung (1. der Kamera und 2. im NLE) kommt ein weiterer, identischer Fehler hinzu.

Das Problem beim Keying ist ja, dass der Key auf eine Farbe eingestellt ist (im Bildbeispiel wäre das Rot oder Grün), nun aber dazwischen Gelb durch die Unterabtastung entstanden ist, auf das der Keyer nicht wirkt, weil er der eingestellten Farbe nicht entspricht.

Es entsteht also der Saum, der einen schlechten Key kennzeichnet.

Gelb ist also die Mischfarbe, die durch die Unterabtastung entsteht und es ist jetzt egal, ob Du in der zweiten Unterabtastung noch eine weitere Fehlfarbe hinzufügst oder aus dem Konglomerat aus Originalfarbe (grün) und der Fehlfarbe (Gelb) nun noch eine weitere Fehlfarbe entsteht. Der Fehler wird nur größer aber nie wirken, als sei keine Fehlfarbe entstanden, also als sei das Bild in 4:4:4 abgetastet und es gäbe nur Rot und Grün.

Ich kann auch nicht so ganz Deiner Argumentationslinie folgen, die sagt, die Kameras können das sowieso nicht und Filter hätten ohnehin eine verherende Wirkung auf das Bild ... ich geb Dir in der Sache ja Recht, zumal Unterabtastungen sowieso meistens mit einem Low-Pass daher kommen, was die Sache nur noch verschlimmert, aber hier geht es darum, das eine Unterabtastung durch eine zweite Unterabtastung eliminiert werden soll, also aus 4:4:4 wieder 4:2:2 entstehen soll.

Und das ist definitiv nicht möglich.

Unterabgetastet wird niemals mehr transparent.

Mann könnte nun trefflich darüber debattieren, ob es stört, oder nicht und ob man es mit dem blossen Auge sehen kann oder ob in Cicago 'ne Tür zufällt. Ich vermisse sowieso die Fraktion, die sagt ... "Nur der Inhalt zählt" aber 4:2:2. nach 4:4:4 geht nun mal nicht.

Antwort von mash_gh4:

Wenn aus 4 Farben eines 4:4:4 abgetasteten Bildes nur noch eine Farbe bei 4:2:2 wird, hat bereits ein nicht mehr reversibler Prozess stattgefunden, denn eine Rückführung auf 4:4:4 würde bedeuten, dass diese entstandene Fehlfarbe (denn die gibt es im Kameramild ja gar nicht) zurückverwandelt wird in ihre 4 Ausgangsfarben.

Du behauptest aber dass die Fehler einer Unterabtastung durch eine zweite Unterabtastung aufgehoben werden, also aus 4:2:2 wieder 4:4:4 wird und damit die Fehlfarbe wieder in die Ausgangsfarben reproduziert wird.

da in diesem einen pixel, von dem da nach der verkleinerung die rede ist, genau die farbinformation enthalten ist, egal ob von vier punkten mit 4:4:4 ausgangsbasis od. einer homogenen 4x4 pixelfläche im 4:2.2 material herunterskaliert wird, sind deine bedenken hinfällig. zumindest spielen sich alle damit verbundenen möglichen unterschiede in einem bereich ab, der noch vernachlässigbarer sein dürfte als jene feinen unterschiede, die auch noch einigermaßen angemesse algorithmen zur bildverkleinerung jeweils untereinader unterscheiden. die art und weise der konkret genutzetn farbkodierung und deren bezugsysteme dürfte dabei jedenfalls einen größeren unterschied ausmachen als dieser kunstgriff des 'nicht(!)-mitskalierens' (siehe: http://ninedegreesbelow.com/photography ... blend.html)

niemand hier träumt hier von irgendwelchen wunderdingen, sondern nur von technischen operationen, in denen unterschiedlich aufgelöste teile der bildinformation getrennt voneinander behandelt bzw. unterschiedlich skaliert werden, und deshalb eben, relativ betrachtet, mehr farbinformation bezogen auf die resultierende bildgröße erhalten bleibt -- letztlich also tatsächlich eine geringere farbunterabtastung daraus resultiert!

man braucht das auch nicht unbedingt im detail verstehen, wenn es einem zu viele kopfzerbrechen bereitet, aber man sollte halt nicht alles von grund auf bezweifeln, was man nicht selbst postuliert hat oder für propagierenswert erachtet.

Antwort von WoWu:

Das ist eben der Denkfehler. Es ist ein Unterschied, ob ich 4 unterschiedliche Farbinformationen habe oder nur eine farbinformation.

Bei einem 4x4 Pixelarray habe ich bei 4:4:4 auch 4 Informationen, aber bei einem gebinnten Array nur eine Farbinformation-

Es ist also ein himmelweiter Unterschied.

Und schon wieder kommt der Einwand .... es ist nicht wichtig:

zumindest spielen sich alle damit verbundenen möglichen unterschiede in einem bereich ab, der noch vernachlässigbarer sein dürfte

Es handelt sich um die falsche Farbe, die in der ersten Unterabtastung entstanden ist und das ist von hoher Relevanz beim z.B. beim Key.

Und es geht auch gar nicht darum, ob es wichtig ist oder nicht.

Die Reproduktion von 4:4:4 aus 4:2:2 ist nicht möglich, um diese Aussage geht es, nicht darum, ob man damit leben kann oder nicht.

und deshalb eben, relativ betrachtet, mehr farbinformation bezogen auf die resultierende bildgröße erhalten bleibt

Wenn Fehlfarben zu "mehr Farbinformation" führen und deswegen das Keying nicht funktioniert, kann man darüber reden ob so ein künstliches "Tintin" dazugehört. Hier reden wir aber über die Rekonstruktion der Farben, die durch das Objektiv aufgenommen wurden und nicht um die Farben, die bei Interpolationen als Mischfarben entstanden sind.

Man muss immer das Rechnerische -was übrigens auch nicht stimmt- vom Realen abziehen, denn es entstehen nicht mehr Farbinformation zur Bildgrösse, sondern nur falsche Informationen, die Menge bleibt identisch.

man braucht das auch nicht unbedingt im detail verstehen

Halbwissen also ... daraus entstehen dann solche Behauptungen, die man hinterher nicht belegen kann.

Antwort von Jott:

Mal einen so erstellten Key gesehen? Also zum Beispiel Green Screen in UHD aufnehmen (mit Unterabtastung) und in einer HD-Timeline mit ProRes HQ oder 4444 keyen? Sieht schon sehr gut aus, der Key. Sogar hervorragend.

Antwort von Jott:

... doppelt ...

Antwort von mash_gh4:

Das ist eben der Denkfehler. Es ist ein Unterschied, ob ich 4 unterschiedliche Farbinformationen habe oder nur eine farbinformation.

Bei einem 4x4 Pixelarray habe ich bei 4:4:4 auch 4 Informationen, aber bei einem gebinnten Array nur eine Farbinformation-

Es ist also ein himmelweiter Unterschied.

nein! -- es ist einfach nur so als würde ich ein schwarzweißbild so vergrößern, dass im ergebnis jeweils vier benachbarte pixel die gleiche farbe zeigen, wo ursprünglich nur ein pixel den betreffenden grauwert enthalten hat (ungefähr so ist eben auch die farbinformation in einem digitalen videobild 'unterabgetastet' in relation zur eigentlichen bildauflösung enthalten). und wenn ich dann dieses neue bild wieder auf die ausgangsgröße verkleinere, kommt im idealfall ungefähr das raus, was man am anfang schon hatte.

natürlich gibt's ein paar möglichkeiten, warum das nicht immer ganz so einfach und perfekt funktionieren muss. bei der skalierung und den dafür gegeigneten techniken setzt man gewöhnlich ganz andere prioritäten. trotzdem, im wesentlichen ist die sache so einfach! es macht keinen sinn von 'falschen' farben zu sprechen, oder von irgendeiner aura, die jene vier ursprüngliche farbpixel umgeben mag, wenn alles im endresulat zum selben ergebnis zusammenfließt...

wie gesagt, ich fürchte, dass die unterschiede, auf denen du so sehr beharrst, mehr mit anderen unzulänglichkeiten in der farbverarbeitung und -beschreibung zu tun haben, die im video-umfeld leider noch immer sehr verbreitet sind...

Antwort von TheBubble:

Halbe Aufloesung ist schon richtig, das entspricht einem Viertel an Pixeln.

???

Wird die Auflösung nicht mehr in Pixeln angegeben?

Die Auflösung entlang einer Achse wird in Pixeln angegeben, allerdings sind Bitmaps flächig, es gibt zwei Dimensionen. Daher führt eine Verdoppelung der Auflösung entlang jeder der beiden Achsen zur vierfachen Pixelmenge.

Antwort von WoWu:

Das kannst Du gern fürchten ...

Aber dein schwarz weiß Beispiel habe ich oben ja schon gebracht ... Wenn Du ein Schachbrettmuster hast, bekommst Du in der ersten Abtastung ein graues Bild und das gibst Du dann in das NLE zur nochmaligen Unterabtastung.

Wie willst Du das ursprüngliche Muster damit bitteschön wieder auflösen ?

Du hast dann zwar ein 2k Bild, aber in schlichtem Grau.

Das Proböem ist immer, ihr betrachtet eine unterabtsatung nur mathematisch und sagt 4x1/4 ist auch 1.

Ihr betrachtet aber nie, was mit dem eigentlichen Signal dabei geschieht und das es nicht gelingt, aus der gemittelten Farbe, die Originalfarben wieder zu rekonstruieren.

fArbunterabtastung ist ein verlustbehaftetes Kompressionsverfahren, durch das die Bandbreite der Farbfrequenz halbiert wird. Bei einer Unterabtastung von 4K nach 2k ist auch die Farbfrequenz nur noch 1/4 der der Ursürungsfrequenz, erforderlich wären aber für eine 4:4:4 Übertragung die 4-fache Bandbreite.

Wie ich oben schon sagte, man mag darüber debattieren, ob es reicht -und manche scheinen ja hier sogar die doppelte Unterabtastung im Key nicht zu sehen- aber es entsteht kein 4:4:4 daraus.

Das ist ziemliches Blogheschwätz.

Antwort von Jott:

Die "manchen" haben das Prozedere im Gegensatz zu dir immerhin mal ausprobiert.

Antwort von WoWu:

Ich mach das seit 40Jahren und Unterabtastung von HD nach SD funktioniert genauso und Keys ebenso.

Das hat nämlich mit 4K absolut nichts zu tun.

Du zeigst mal wieder Dein Halbwissen und hast gar nicht vor einen konstruktiven Beitrag zum Thread zu leisten.

Antwort von Bas3008:

Vielleicht kann jemand anderes, der Wowus Erläuterungen versteht, das noch etwas simpler oder anders erklären, ich verfolge das Thema nämlich immer noch interessiert, aber kann seine Logik nicht so ganz nachvollziehen ...

Antwort von WoWu:

Du musst dir nur das Kamerabild anschauen und die Wirkumg einer Unterabtastung betrachten, dann wird Dor klar, welche Auswirkung eine Unterabtastung hat.

Antwort von Jott:

Wenn wowu auf dünnes Eis gerät, merkt man das immer daran, dass er andere beleidigt. Wunderbar konstantes Schema! :-)

Antwort von WoWu:

Nicht andere ... Und damit hätten wir hier im Thread wieder das Jott'sche Niveau.

Schade eigentlich ... Ich bin jetzt raus.

Antwort von TheBubble:

Unterabtastung ist ja (in unserm fall) eigentlich keine spatiale Angelegenheit sondern eine Frage der Farbpräzision, also eine Frage der korrekten Farbreproduktion. Wenn aus 4 Farben eines 4:4:4 abgetasteten Bildes nur noch eine Farbe bei 4:2:2 wird, hat bereits ein nicht mehr reversibler Prozess stattgefunden, denn eine Rückführung auf 4:4:4 würde bedeuten, dass diese entstandene Fehlfarbe (denn die gibt es im Kameramild ja gar nicht) zurückverwandelt wird in ihre 4 Ausgangsfarben.

Der Witz ist ja, dass niemand die 4 Ausgangsfarben haben will, sondern im Grunde nur jeweils einen passenden Helligkeitswert für die bekannten in halber Auflösung vorhandenen Chroma-Werte. Es wird danach in halber Auflösung weitergearbeitet, die höhere Ausgangsauflösung ist verloren. Sie war nur ein Workaround.

Du behauptest aber dass die Fehler einer Unterabtastung durch eine zweite Unterabtastung aufgehoben werden, also aus 4:2:2 wieder 4:4:4 wird und damit die Fehlfarbe wieder in die Ausgangsfarben reproduziert wird.

Das behaupte ich so, wie Du es eben formuliert hast, nicht. Ich fordere zusätzlich eine Halbierung der Ortsauflösung der Helligkeitsinformationen. Ich rekonstruiere die in der hohen Ausgangsauflösung fehlenden Chroma-Informationen nicht und habe das auch nie behauptet.

Deiner Ausführung, dass die Fehlfarbe in einer kleineren spartieren Auflösung gar nich auffällt, habe ich schon verstanden aber die Fehlfarbe bleibt erhalten und ist somit nicht 4:4:4 geworden sondern bleibt eine Fehlfarbe, also 4:2:2.

Die "Fehlfarbe" ist schon entstanden, als die Kamera 4:2:0 abgelegt hat. Trotzdem kann man daraus ein 4:4:4 in halber räumlicher Auflösung erzeugen. Und unser Anwender will ja nur die halbe Auflösung haben, die maximale Helligkeitsauflösung seiner Kamera interessiert ihn ja nicht. Die doppelte Auflösung verwendet er nur als Hilfsmittel, da seine Kamera sie beherscht, jedoch kein 4:4:4 in der eigentlich gewünschten geringeren Auflösung.

Das Problem beim Keying ist ja, dass der Key auf eine Farbe eingestellt ist (im Bildbeispiel wäre das Rot oder Grün), nun aber dazwischen Gelb durch die Unterabtastung entstanden ist, auf das der Keyer nicht wirkt, weil er der eingestellten Farbe nicht entspricht.

Dieses Argument ist zu kurz gedacht:

Erstmal hätte die "volle" 4:2:0 Auflösung auch keine weiteren Chroma-Informationen, die der Keyer benutzen könnte, gegenüber 4:4:4 in halber Auflösung. Es wird zwar nichts gewonnen, Chromainformation geht aber nicht verloren (man verliert nur Helligkeitsauflösung). Der durch Mittelwertbildung entstehende Informationsverlust liegt im Y-Kanal, die der echte reine Chroma-Keyer ohnehin nicht auswertet.

Außerdem sind die Licht einfangenden Bereiche der Sensel auf dem Kamerachip flächig ausgedehnt und vor ihnen sitzt noch der OLPF. Am Farbsaum Rot/Grün wird daher entweder durch eine nicht perfekt zum Saum passende Ausrichtung der Sensel zum Farbsaum selbst ohne OLPF eine Mischfarbe entstehen, oder beim Einsatz des OLPF wird ebenfalls am nun etwas unscharfen Übergang eine Mischfarbe sichtbar sein. Diese Mischungen können also selbst mit "echten" 4:4:4 Geräten nicht vermieden werden.

aber hier geht es darum, das eine Unterabtastung durch eine zweite Unterabtastung eliminiert werden soll, also aus 4:4:4 wieder 4:2:2 entstehen soll.

Und das ist definitiv nicht möglich.

Du vergisst immer den Zusatz "in halber örtlicher Auflösung". Vielleicht hilft Dir eine etwas andere Betrachtungsweise: Aus 4:2:0 macht man quasi "2:2:0", was 4:4:4 auf halbem Raster entspricht.

Mann könnte nun trefflich darüber debattieren, ob es stört, oder nicht und ob man es mit dem blossen Auge sehen kann oder ob in Cicago 'ne Tür zufällt. Ich vermisse sowieso die Fraktion, die sagt ... "Nur der Inhalt zählt" aber 4:2:2. nach 4:4:4 geht nun mal nicht.

Eine Gruppe, die ab und zu auch mal eine eine "es ist nun gut genug, andere Baustellen sind wichtiger" Position vertritt, wäre manchmal wirklich nett. :-)

Antwort von CameraRick:

Ich hatte das, wie schon oben geschrieben durchgecheckt. Keine sichtbaren Unterschiede. Bicubic sorgt schon für annehmbare Ergebnisse.

Sichtbar müssen die auch nicht sein, sondern vorhanden :) nerest neigbour würde einfach gar nichts interpolieren und Du hättest original noch die gleichen Pixel wie vorher, nur eben 1/4 von denen.

Unterschiede haben die alle, aber da muss man auch auf Pixelwerte achten.

Ich sehe nicht, wo das Murks ist. Es spart einem Zeit und Rechenleistung, wenn man eh vor hat, das ganze auf 1080p runterzurechnen. Bspw. kann man über Nacht alle Dateien konvertieren lassen und am nächsten Tag wunderbar flüssig im Schnittprogramm mit arbeiten.

Weil Du eine erneut komprimierte Source nimmst (und auch Prores komprimiert nicht wenig weg), statt auf dem Originalen File zu arbeiten in der einfach noch alle Infos erhalten sind, also einfach mal mehr vier mal so viele Daten wie in Deinem 1080p File. Und Du kannst im Zweifel den Filter noch wählen (es sei denn man mag in AE arbeiten, aber wer will das schon bei Greenscreen).

Klar spart es in der Rechenleistung, 4K geht schon an den Kragen. Dass aber eine umgewandelte, kleinere Datei mit de facto weniger Information besser sein soll als eine wo ich auf alle Daten genauen Zugriff hab - na ja :)

Antwort von MLJ:

@All

Zum einen finde ich es traurig das man hier nicht sachlich bleibt und Unfug verbreitet, zum anderen sollten die, die nicht verstanden haben wie Interpolation und Unterabtastung wirklich funktionieren sich mal richtig Informieren.

"WoWu" hat Recht mit seinen Ausführungen also hört auf ihn zu beleidigen denn er versteht die Materie und wir sollten froh sein jemanden wie "WoWu" hier im Forum zu haben.

Man kann aus einem 4:2:0 unmöglich ein "echtes" 4:4:4 machen ohne das der Chroma Anteil erheblich leidet, je nach Verfahren und Codec denn es wird nie wie ECHTES 4:4:4 sein. Selbst Verlustfreie Codecs wie "MagicYUV" haben damit Probleme und es ist kein guter Workflow Material in Formate umzukodieren für den Schnitt wenn es nicht unbedingt nötig ist.

Wenn ein Material in 4:2:0 vorliegt dann sollte man es auch dort lassen oder in Unkomprimiert umwandeln für den Schnitt damit die wenigen und fragilen Informationen verlustfrei und die Farbtreue erhalten bleiben.

Bei 4:2:2 und 4:2:0 ist das um so wichtiger als bei 4:4:4 denn aus 4:4:4 kann man am Ende 4:2:2 oder 4:2:0 machen, aber Umgekehrt ? Denkt bitte mal Logisch an dieser Stelle. Was nicht da ist kann man auch nicht hinein zaubern und kann je nach Vorgehensweise richtig schief gehen.

Ich kenne niemanden in den großen Master oder Editing Studios die so vorgehen würden wie ihr, das grenzt an Dilettantismus. Ihr wollt wie die großen arbeiten aber macht euch euer Material mutwillig kaputt indem ihr etwas probiert was nicht gehen kann und auch noch daran glaubt ?

Nur weil der "neue" Codec nun statt 4:2:0 ein 4:4:4 anzeigt bedeutet das nicht das es echtes 4:4:4 ist. Der neue Codec akzeptiert 4:2:0 und reduziert die Datenrate oder schlimmer, komprimiert es erneut und gibt 4:4:4 an das NLE weiter. Nirgendwo in diesem Prozess entstehen neue Farben, eher Fehler wenn auch noch Skalierung verwendet wird. Kommt auch noch intensive Bearbeitung wie Grading und Noise Reduction dazu, dann gute Nacht.

Es muss jedem einleuchten das gerade bei der Farbkorrektur nochmals auf den Chroma Anteil Einfluss genommen wird und nicht nur auf den Luma Anteil. Wenn das NLE mit 4:2:0 nicht richtig zurecht kommt sollte man Alternativen suchen. In der professionellen Welt werden nur die Teile neu kodiert wo es unumgänglich ist, Vorspann, Abspann, PiP, Spezial FX, Untertitel, aber ansonsten bleibt man beim ursprünglichem Format.

Jede Umwandlung kostet Qualität auch wenn sie nicht sofort sichtbar ist. Dabei spielt es keine Rolle welcher Codec verwendet wird denn wirklich verlustfrei ist nur komprimiertes 4:2:0 zu Unkomprimiert 4:2:0, alles andere ist absoluter Humbug und bringt nichts, aber der Glaube versetzt ja bekanntlich Berge, nicht wahr ?

Man sollte sich mit der Materie auch richtig beschäftigen und verstehen bevor man auf eine Behauptung herein fällt die nicht stimmt. Auch das ganze mit "Schwarz/Weiß", das ist doch etwas ganz anderes denn Grau ist etwas anderes als Farbe und um die geht es hier.

Hinzu kommt, das das "neue" 4:4:4 mit größter Wahrscheinlichkeit wieder am Ende in 4:2:0 landet für H264 oder MPEG-2, je nach Medium. Damit solltet ihr euch die Frage stellen, was soll das ganze dann bringen ? Also mal logisch denken denn aus einem Gogo Mobil kann man auch keinen Formel 1 Wagen machen, egal was man für einen Motor einbauen würde.

Hier könnt ihr euch etwas genauer Informieren und möchte dazu noch anmerken das Microsoft seit Vista vieles davon erheblich abgespeckt und auf ein minimum reduziert hat was sich zwangsläufig auf die Qualität auswirkt bei neueren Windows Versionen.

Recommended YUV Formats: (Englisch)

https://msdn.microsoft.com/en-us/librar ... 85%29.aspx

Quelle: Microsoft

Kleiner Tipp:

Wer noch mehr darüber erfahren will sollte bei seinem OEM mal die White Paper zu diesem Thema von Microsoft und Intel anfordern. Dort kann man sehr schön nachlesen welche wichtige Rolle DirectX, OpenGL, GraKa Treiber und Codecs in diesem Prozess spielen, was geht, was nicht und welche Funktionen und Routinen bei den verschiedenen Windows Versionen raus genommen wurden. (Vista - 10, 32/64 Bit)

Abschließend würde ich es begrüßen euch nicht beleidigt oder angegriffen zu fühlen denn so ist dieser Beitrag absolut NICHT gemeint, also schön auf dem Teppich bleiben. Danke.

Cheers

Mickey

Antwort von Bas3008:

"WoWu" hat Recht mit seinen Ausführungen also hört auf ihn zu beleidigen denn er versteht die Materie und wir sollten froh sein jemanden wie "WoWu" hier im Forum zu haben.

Ich sehe hier keine Beleidigungen gegen WoWu.

Ich weiß im übrigen nicht, was dein Beitrag hier noch bezwecken soll. Das meiste von dem, was du vorbringst, wurde hier schon diskutiert - und das in einer (Gott sei Dank) weniger provokanten Form.

Antwort von TheBubble:

Abschließend würde ich es begrüßen euch nicht beleidigt oder angegriffen zu fühlen denn so ist dieser Beitrag absolut NICHT gemeint, also schön auf dem Teppich bleiben. Danke.

Warum ist Dein Beitrag dann so bissig? Es geht ja schon im ersten Absatz gut los, ich möchte mal ein paar Fragmente zitieren: "Unfug verbreitet", "die, die nicht verstanden haben", "sich mal richtig Informieren".

Es ist anschaulich beschrieben, unter welchen Voraussetzungen und mit welchen Abstrichen das Ziel 2K mit 4:4:4 Chroma-Sampling erreichbar ist. Ich habe gesagt, was zum Thema zu sagen war.

Antwort von mash_gh4:

Man kann aus einem 4:2:0 unmöglich ein "echtes" 4:4:4 machen...

du hast in deinen ganzen langen ausführungen offenbar übersehen, oder zumindest nicht offen angesprochen, dass in allen vernünftigen beiträge hier immer nur ganz ausdrücklich von entsprechenden chroma-informations-erhalt im zuge einer verkleinerung von 4k nach hd die rede war.

Antwort von Jott:

Genauer: von 3840x2160 zu HD. Aus einer Pixel-Vierergruppe mach eins. Das ist die Basis für die strittigen Denkmodelle. Zur Erfrischung zwischendurch kann man's auch mal praktisch durchspielen und beurteilen. Setzt natürlich den Besitz einer entsprechenden Kamera voraus.

Antwort von kundesbanzler:

Setzt natürlich den Besitz einer entsprechenden Kamera voraus.

Genauer: zwei entsprechenden Kameras.

Antwort von iasi:

Hängt es eigentlich nicht auch sehr davon ab, wie man die Pixel "zusammen fasst"?

Man verwendet schließlich auch beim Debayern ausgefeilte Algorithmen.

Ich stelle mir das so vor:

Zu Beginn hat man RBGG-Werte. Daraus wird ein Bildpunkt berechnet.

Die Informationen dieses Bildpunktes werden reduziert.

Nimmt man nun nebeneinander liegende Bildpunkte, könnte man ebenfalls Algorithmen nutzen, um anhand der verbliebenen Informationen der einzelnen 4k-Bildpunkte wieder verbesserte Annährungswerte eines zusammengefassten 2k-Bildpunktes zu erhalten.

Ich sehe nicht, wie das simple Verrechnen von 4k-Werten zu verbesserten 2k-Werten führen könnte - hierzu wäre wohl auch ein angepasster Algorithmus notwendig. Denn die eingedampften 4k-Informationen müssten vernünftig interpretiert werden, um daraus überhaupt einen Informationszugewinn bei 2k zu erreichen.

Antwort von mash_gh4:

Hängt es eigentlich nicht auch sehr davon ab, wie man die Pixel "zusammen fasst"?

die ganze entsprechende pixelzählerei wird hinfällig, wenn man das erste mal genauer beobachtet, wie die kamera intern bspw. die entzerrung der elektr. objektive ganz ungefragt in die bilddaten hineinrechnet. das wird wirklich erst spürbar, wenn man raw-photos mit den jpgs/videos vergleicht. obwohl also in der praxis überhaupt keine direkte 1:1 relation zwischen sensorpixel und bildpunkten mehr vorhanden ist, fällt das normalerweise kaum ins gewicht. (gut -- ich würde mir trotzdem manchmal den raw zugriff wünschen ;))

im übrigen muss man auch mitbedenken, dass nach der komprimierung eigentlich auch keine eigentliche pixelelinformation mehr vorhanden ist, sondern nur mehr makroblocks die grau-/farbverläufe über größere geschwungene flächen beschreiben. das ist zwar in der praxis nahe genug an dem dran, dass wir später wieder pixel herauszuklauben vermögen, zeigt aber auch wieder ganz charakteristische eigenheiten, die mit einem denken ausschließlich in pixeln nicht zu fassen sind.

Antwort von CameraRick:

Hängt es eigentlich nicht auch sehr davon ab, wie man die Pixel "zusammen fasst"?

Das hatte ich ja mal angesprochen, es hängt viel vom verwendeten Skalierungsfilter ab.

Nutzt man nur Nearest Neighbour, ändert sich rein gar nichts außer dass Du einen Teil der Information wegwirfst.

Aber was macht ein (Bi)cubic, ein Lanczos, ein Parzen mit den Pixeln? Ich meine man kann natürlich nachlesen wie solche Filter skalieren, auf das Subsampling gehen solche Filter natürlich nicht ein.

Es ist eben auch entscheidend, wo und wie skaliert wird. Die meiste Software lässt Dich ja keinen eigenen Filter wählen, oder nur zwei oder so. Oder Du skalierst mit Adobes "quality enhancing"-Zeug und weißt gar nicht mehr, was er mit den Pixeln macht.

Ein reiner Sicht-Vergleich wie er hier (lies: im ersten Post) stattgefunden hat, wenn man Subsamplings etc vergleicht kann natürlich zum Ergebnis "kein Unterschied" führen; aber im Endeffekt gilt das auch gern mal für 444 und 422/420 Material im Sichtvergleich, solang wir keine Farbtafeln haben :)

Verschiedene Filter interpolieren verschieden - mancher machts softer (auch bei Reduktion), mancher schärfer, mancher nix, mancher ganz anders. Vielleicht sollte man mal für einen echten empirischen Test auch mal mehrere Filter testen als die in Photoshop.

Antwort von WoWu:

wobei es hier eigentlich weniger um die Filtergüte geht, sondern darum, ob aus 4:2:0 wieder ein 4:4:4 -durch eine weitere Unterabtastung- werden kann.

Rechnerisch mag man Chroma- zwar auf einer identischen Frequenz wie Luma abtasten, nur der Cromafehfehler, der in der vorgelagerten Unterabtastung nach 4:2:0 im Sognal entstanden ist, ist auch bei einer höheren Abtastfrequenz noch vorhanden.

Es geht bei Unterabtastung ja um inhaltliche Bildfehler und nur in zweiter Linie um die Anzahl der übertragbaren Samples.

Da kann man die Frequenz nun so hoch wählen, wie man will ... das Ergebnis wird immer der Bildinhalt der letzten Datenreduktion sein und Unterabtastung ist nun mal eine verlustbehaftete Datenreduktion.

Und man mag nun die Filter in ihrer Güte unterscheiden, Fakt ist aber, dass sie alle Verluste in die erste Unterabtastung einbringen, die man mit einer zweiten Unterabtastung nicht wieder weg bekommt.

Antwort von mash_gh4:

Rechnerisch mag man Chroma- zwar auf einer identischen Frequenz wie Luma abtasten, nur der Cromafehfehler, der in der vorgelagerten Unterabtastung nach 4:2:0 im Sognal entstanden ist, ist auch bei einer höheren Abtastfrequenz noch vorhanden.

Es geht bei Unterabtastung ja um inhaltliche Bildfehler und nur in zweiter Linie um die Anzahl der übertragbaren Samples.

ich weiß zwar, dass du das so siehst, aber ich denke du irrst!

das FHD 4:4:4 signal wäre auf der farbebene auch nicht besser, wenn die farbkanäle ausgehend von einem UHD 4:4:4 signal in gleichem maße bzw. im selben schritt verkleiner worden wären wie die helligkeitsinformation.

mehr information lässt sich einfach a) in den entsprechenden werten nicht unterbringen und b) die fehler beim verkleinern der ursprünglichen debayerten RGB werte in der verarbeitungskette, oder von mir aus auch den rohen R'G'B' sensordaten, sind da wie dort genau die selben... sorry

Antwort von Bommi:

In diesem YouTube-Video wird das Chroma-Subsampling zu 4:4:4 schön erklärt.

Ob's die ganze Wahrheit ist, wage ich nicht zu beurteilen.

Antwort von rudi:

So, jetzt muss ich auch einmal...

Man muss, wenn man es richtig macht, überhaupt keinen Wert konvertieren, skalieren oder sonst was machen. Man fasst nur sehr sauber zusammen.

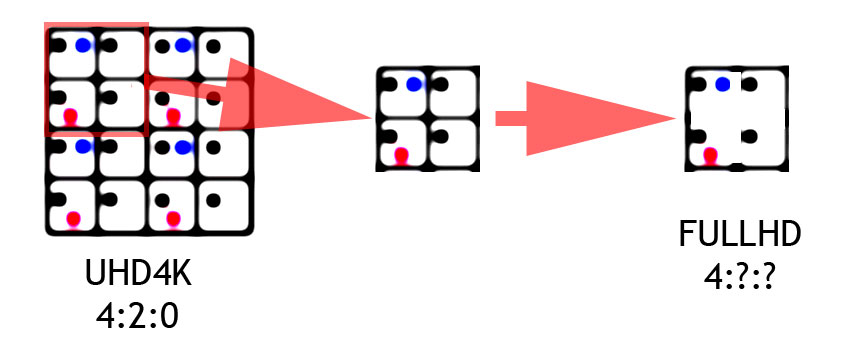

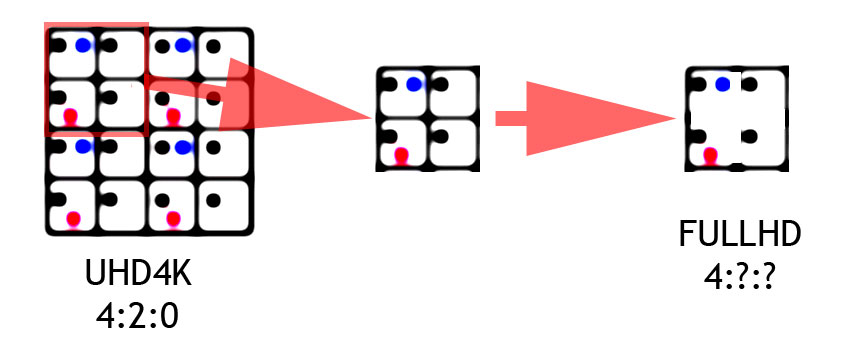

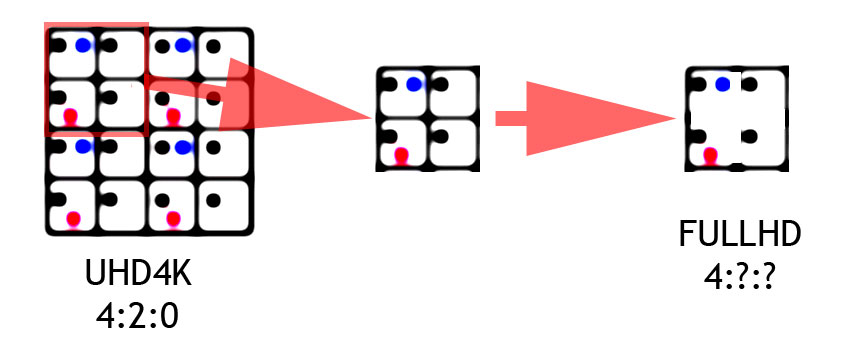

Ich habe jetzt mal ne Grafik vorbereitet.

Lasst mal Sensor und alles andere weg. Das Kind ist im Brunnen, wir haben einfach nur eine 4K H.264 Datei mit 4:2:0 vorliegen.

Dann siehts so aus, wie ganz links im Bild:

Schauen wir uns einmal 4 Pixel genauer an (Abbildung Mitte) : Es gibt für 4 Pixel je einen 8 Bit Luma Wert (Schwarz) und dazu noch 2 Chroma-Subsampling Werte U und V in 8 Bit (rot und Blau).

Und jetzt bitte den Kopf nach rechts drehen: Dort machen wir aus den 4 Pixeln einen, indem wir die Pixelwände wegnehmen.

Um dieses Pixel zu berechenen haben wir nun:

4 x 8 Bit Luma Werte.

und tata..

2 x genau die selben 8 Bit Chroma Werte von vorhin.

NOCHMAL: Wir nehmen für dieses Pixel genau die gleichen Chroma UV Werte wie vorhin (rot und blau) . Wir fassen nichts zusammen und wir bilden keinen Mittelwert. Wir nehmen die GLEICHEN Werte. Unverändert.

Und jetzt kommts: Wenn wir in 8 Bit bleiben würden, müssten wir die 4 Luma-Werte mitteln. Also einen Mittelwert aus den vier 8 Bit Luma Werten erzeugen.

Wenn wir jedoch in 10 Bit landen, dann müssen wir die 4 Luma Werte einfach nur addieren und erhalten genau eine 10 Bit Zahl. Magisch ;)

Die schon oft erwähnte Kehrseite hierbei: Die Chroma-Werte bleiben 8 Bit.

Ich glaube, das war jetzt mein letzter Versuch, das einmal klar darzustellen...

Antwort von Axel:

Bezogen auf die Praxis bestätigt das die uralte Bauernweisheit, dass 4k (in Form von UHD) das bessere HD ist.

Antwort von WoWu:

Ich versuch"s auch noch einmal, und weil Rudi da so eine schöne Zeichnung gemacht hat, aber das Wesentliche, also was mit dem Signal eigentlich im Bild passiert, weggelassen hat, würde ich das mit meiner Grafik einfach mal ergänzen wollen, denn in Bezug auf Bildfehler reichen keine mathematischen Berechnungen. Man muss sich schon einmal anschauen, wie sie sich im Bild auswirken.

Von einem 4:4:4 in der Kamera, noch RGB, wird ein YCbCr erzeugt und auf 4:2:0 unterabgetastet.

Bild B) 4K 4:2:0

Dabei entsteht ein Interpolationsfehler, indem Chroma 4x1 gesichtet wird.

An einem Chromübergang entsteht also eine Fehlfarbe (gier aus rot und grün wird am Übergang GELB).

Überträgt man nun das Chroma Raster in eine, mit Luma identische Abtastfrquent, bleibt zwar die Menge der Samples Chroma erhalten und die Menge der Luma Samples wird reduziert, aber der Abtastfehler aus der ersten Unterabtastung bleibt auch erhalten !

Die gelbe Linie verschwindet nicht.

Man hat also qualitativ eine 4:2:0 Bildqualität, egal in wievielten Übertragungswerten die steckt.

Genau diese Fehlfarben sind es nämlich, die einen Keyer ungenau arbeiten lasse, weil die Kante nicht (z.B.) Grün ist, wie der Key, sondern Gelb, sodass der Key nicht wirkt.

Was nutzen mir also mehr Chromsamples, wenn ich darin ein reduziertes Signal übertrage ?

Man darf nicht nur mit Mathematik an Bildqualität gehen sondern muss sich auch anschauen, was sie bewirkt.

Das mathematische Beispiel gilt nur für ein monochromes Bild, in dem keine Fehlfarben in der ersten Unterabtastung entstehen können.

Und @Rudi ... nochmals zu der "Magie" des 10 Bit.

Wenn Du die 8 Bit Werte nur addierst, entstehen noch keine individuellen Graustufen, die das Objektiv aufgenommen hat. Das hat nämlich im ersten Prozesstag alle Graustufen auf oder abgerundet auf 8 Bit Werte.

Du magst rechnerisch dann zwar eine 10 Bit Zelle haben, aber Du hast nur die 256 Werte darin, die die Kamera erzeugt hat.

Der Rest sind Nullen ... mal abgesehen davon, wo gibt es die Software dafür, sowohl für den ersten, als auch für den zweiten Fall ?

Antwort von iasi:

@WoWu

Danke - sehr anschaulich.

Das hatte ich mir so schon gedacht.

Jedoch stellt sich mir die Frage, ob man nicht mit einem Algorithmus ansetzen könnte, der eben auch Nachbar-Pixel berücksichtigt und solche Fehler minimiert - rein theoretisch.

In der Praxis lässt sich die aber eh nicht umsetzen - schlicht auch, weil es unsinnig wäre. Warum 4k aufnehmen, es derart eindampfen und dann am Ende gutes 2k zaubern zu wollen? Da nimmt man doch besser gleich 2k in guter Qualität auf.

Antwort von WoWu:

@Iasi

Das Problem dabei geht einher mit LowPass Filtern, die bei Unterabtastung eingesetzt werden, um Aliasing zu vermeiden.

Danach hast Du gar keine klaren Kanten mehr sondern Verläufe, die aber ebensowenig stimmen, nur in den Ausmassen grösser sind.

(Achte auch mal auf die grauen Teile zwischen den schwarzen Balken niedriger Ortsfrequenzen ... das sind nämlich die Fehlfarben der Unterabtastung. Im LUMA Signal wären das zusätzliche Kantenaufstellungen. Deswegen sehen die Bilder so scharf aus).

Dazu kommt noch, dass es einwenig davon abhängt, welche Art der Interpolation gewählt wird, ob es linear ist oder kubisch bzw. mehrfach kubisch oder ob skaliere und separierbare Polyphasefilter eingesetzt werden.

Mit andern Worten... so ein Algorithmus wird wohl nicht mal eben so sein.

Und die ursprünglichen Ausgangswerte als "Meta" mitzuschreiben, auf deren Basis eine Rückrechnung erfolgen könnte, bedeutet, dass man gleich 4:4:4 machen kann.

Antwort von mash_gh4:

An einem Chromübergang entsteht also eine Fehlfarbe (gier aus rot und grün wird am Übergang GELB).

kannst du uns jetzt auch noch eine verkleinerung auf ein viertel der bildgröße vorführen, wo an farbübergängen, die innerhalb der resultierenden pixelgröße zu liegen kommen, keine fehlfarben auftauchen?

prinzipiell möglich ist das schon -- bspw. dadurch, dass einfach nur das linkeste oberste pixel auf der eingansseite als ziel genutzt wird --, nur entspricht das halt wirklich nicht dem, was man sich von einer sauberen skalierung normalerweise erwarten würde. dieses interpolationsproblem gibt es immer. im hier diskutierten fall taucht es in der verarbeitungskette nur zu unterschiedlichen zeitpunkten -- also quasi versetzt -- auf, was das ganze so ungewöhnlich erscheinen lässt. im prinzip geht es aber immer um genau die selbe operation mit ganz den gleichen folgen...

Antwort von iasi:

Dazu kommt noch, dass es einwenig davon abhängt, welche Art der Interpolation gewählt wird, ob es linear ist oder kubisch bzw. mehrfach kubisch oder ob skaliere und separierbare Polyphasefilter eingesetzt werden.

Mit andern Worten... so ein Algorithmus wird wohl nicht mal eben so sein.

Und die ursprünglichen Ausgangswerte als "Meta" mitzuschreiben, auf deren Basis eine Rückrechnung erfolgen könnte, bedeutet, dass man gleich 4:4:4 machen kann.

ja - auch das hatte ich schon vermutet.

Es wäre ein Algorithmus notwendig, der auf die vorausgehenden "Maßnahmen" abgestimmt sein müsste.

Antwort von mash_gh4:

Es wäre ein Algorithmus notwendig, der auf die vorausgehenden "Maßnahmen" abgestimmt sein müsste.

also, wenn die behandlung, die hier gewählt wird -- das auftrennen der image planes bzw. getrennte nicht-skalieren/skalieren und wieder zusammensetzen -- nicht genau so ein spezialisierter und an die ausgangssituation angepasster algorithmus ist, weiß ich nicht, was was man noch mehr erwarten soll.

dass dabei mehr heraus kommt als bei einer guten FHD aufnahme mit gleicher sensorauflösung und gleichem unterabstatungsverhältnis auf der zielseite, hat ohnehin niemand behauptet, nur eben auch nicht weniger!

Antwort von WoWu:

Ja, nur können Unterabtastungen bis zu 16 Pixels beinhalten und daraus wird eine Approximatipn gemacht.

Das macht die Sache beliebig kompliziert, denn bös auf den Umstand, dass es 16 Pixels im Ursprung waren und der Lage in der Matrix hast Du dann nur noch das Zoelpixel als Ergebnis.

iCh wüsste im Augenblick keinen Algorithmus, der das rückzuführen vermag.

Du wirst also nicht umhin kommen, die ursprünglichen Pixelwerte zu übermitteln und dann kannst Du gleich 4:4:4 machen.

@mash gh4

Der Workflow ist doch eindeutig:

4 K Kamera, die intern auf 4:2:0 unterabtastet, unter Verwendung bekannter Verfahren, hier Gleichgewichtung vorausgesetzt,

dann irgendeine, noch nicht benannte Software, die LUMA ein weiteres Mal unterabtastet , aber die vorhandenen x:2:0 Chromawerte so wie sie vorliegen, bei gleicher Abtastfrequenz wie Luma, ummapped.

Das Ergebnis ist auch klar| Ein 2:2:0 Bild, in dem die Chroma und Luma Abtastfrequenz identisch sind und das Luma Signal zweimal unterabgetastet ist und das Chromasignal einmal und daher alle Fehler einer Unterabtastung enthält.

Wo ist das Problem ?

Antwort von CameraRick:

mal abgesehen davon, wo gibt es die Software dafür, sowohl für den ersten, als auch für den zweiten Fall ?

Hm, vielleicht baue ich mal ein Pixelraster, um das Bild in vier Teile zu teilen. Dann danach alle entsprechend auf ein anderes legen, addieren, durch vier teilen. Nach Mathematik hab ich dann die Info, aber dennoch ein zu großes Bild mit Lücken. Nearest neighbour geschickt skaliert und dann hab ich es, nach dem Mathematik weg.

Nur hat das eben keinen Bezug zu einer schönen Skalierung, dürfte auch Aliasing provozieren (Nearest neighbour halt).

Und das setzt die Abtastung bei der Aufnahme als fehlerfrei voraus

Antwort von CameraRick:

Ach das ist quatsch. Addieren und teilen gibt mir ein 8bit a erase mehr nicht.

Leider ist ein farbwert von 255 in 8bit auch dann noch komplett weiß wenn er in 10bit verarbeitung iegt, er wird ja nicht dunkler. Könnte man das übersetzen ginge das vielleicht.

Antwort von WoWu:

Es ist ziemlich egal, welche Algorithmen man nimmt. Spätestens bei der Filterung ist das vorbei.

So ein Modell funktioniert nur in monochrom und nur in der Mathematik, und selbst da nur mit vereinfachten Algorithmen denn wenn man die Fehler mitberechnen würde, auch dann nicht mehr.

Wenn das funktionieren würde, gäbe es das schon längst in den Kameras. Das würde nämlich einige Proböeme beseitigen.

Aber nun sind wieder die Verschwörungstheoretikern aufgerufen, die den Herstellern unterstellen, sie wollten das nur nicht.

😎

Antwort von iasi:

So, jetzt muss ich auch einmal...

Man muss, wenn man es richtig macht, überhaupt keinen Wert konvertieren, skalieren oder sonst was machen. Man fasst nur sehr sauber zusammen.

Ich habe jetzt mal ne Grafik vorbereitet.

Lasst mal Sensor und alles andere weg. Das Kind ist im Brunnen, wir haben einfach nur eine 4K H.264 Datei mit 4:2:0 vorliegen.

Dann siehts so aus, wie ganz links im Bild:

Schauen wir uns einmal 4 Pixel genauer an (Abbildung Mitte) : Es gibt für 4 Pixel je einen 8 Bit Luma Wert (Schwarz) und dazu noch 2 Chroma-Subsampling Werte U und V in 8 Bit (rot und Blau).

Und jetzt bitte den Kopf nach rechts drehen: Dort machen wir aus den 4 Pixeln einen, indem wir die Pixelwände wegnehmen.

Um dieses Pixel zu berechenen haben wir nun:

4 x 8 Bit Luma Werte.

und tata..

2 x genau die selben 8 Bit Chroma Werte von vorhin.

NOCHMAL: Wir nehmen für dieses Pixel genau die gleichen Chroma UV Werte wie vorhin (rot und blau) . Wir fassen nichts zusammen und wir bilden keinen Mittelwert. Wir nehmen die GLEICHEN Werte. Unverändert.

Und jetzt kommts: Wenn wir in 8 Bit bleiben würden, müssten wir die 4 Luma-Werte mitteln. Also einen Mittelwert aus den vier 8 Bit Luma Werten erzeugen.

Wenn wir jedoch in 10 Bit landen, dann müssen wir die 4 Luma Werte einfach nur addieren und erhalten genau eine 10 Bit Zahl. Magisch ;)

Die schon oft erwähnte Kehrseite hierbei: Die Chroma-Werte bleiben 8 Bit.

Ich glaube, das war jetzt mein letzter Versuch, das einmal klar darzustellen...

hmm ... die Frage ist doch aber, was mit "falschen" Werten geschieht.

Statt z.B. einen Pixel von 4 Pixeln mit einem "falschen" Wert bei 4k, erhalte ich 1 von 1 Pixel mit "falschem" Wert bei 2k - verpackt in 10 bit.

Antwort von mash_gh4:

dann irgendeine, noch nicht benannte Software, die LUMA ein weiteres Mal unterabtastet , aber die vorhandenen x:2:0 Chromawerte so wie sie vorliegen, bei gleicher Abtastfrequenz wie Luma, ummapped.

die software nennt sich in dem fall ffmpeg und macht eben wirklich genau das. es ist zimlich umständlich und wurde im grunde nur ausgeheckt, um etwas, das Karl und LPowell theoretisch klar war, auch praktisch auszuprobieren...

Das Ergebnis ist auch klar| Ein 2:2:0 Bild, in dem die Chroma und Luma Abtastfrequenz identisch sind und das Luma Signal zweimal unterabgetastet ist und das Chromasignal einmal und daher alle Fehler einer Unterabtastung enthält.

nman kann es so kompliziert umschreiben wie man will -- im wesentlichen kommt dabei immer nur heraus, dass auch eine direkte 4:4:4 aufzeichnung nicht mehr od. präzisere farbinformation enthalten würde, wenn man einmal von den begleitenden problemen des rekomprimierens absieht.

Wo ist das Problem ?

ja -- frag ich mich auch immer wieder -- außer dir haben's die meisten eh verstanden! ;)

Antwort von iasi:

Es ist ziemlich egal, welche Algorithmen man nimmt. Spätestens bei der Filterung ist das vorbei.

So ein Modell funktioniert nur in monochrom und nur in der Mathematik, und selbst da nur mit vereinfachten Algorithmen denn wenn man die Fehler mitberechnen würde, auch dann nicht mehr.

Wenn das funktionieren würde, gäbe es das schon längst in den Kameras. Das würde nämlich einige Proböeme beseitigen.

Aber nun sind wieder die Verschwörungstheoretikern aufgerufen, die den Herstellern unterstellen, sie wollten das nur nicht.

😎

na ja - der Rechenaufwand wäre wohl nicht unerheblich - und dann drängt sich die Frage auf, ob man nicht gleich ordentliches 2k speichert, statt 2k aufwändig aus eingedampftem 4k zu errechnen.

Antwort von iasi:

nman kann es so kompliziert umschreiben wie man will -- im wesentlichen kommt dabei immer nur heraus, dass auch eine direkte 4:4:4 aufzeichnung nicht mehr od. präzisere farbinformation enthalten würde, wenn man einmal von den begleitenden problemen des rekomprimierens absieht.

Wo ist das Problem ?

ja -- frag ich mich auch immer wieder -- außer dir haben's die meisten eh verstanden! ;)

4 Näherungswerte ergeben aber nun einmal nicht automatisch und zwingend 1 genauen Wert.

Und gerade vom "Eindampfen" kann man eben nicht so einfach absehen.

Antwort von mash_gh4:

na ja - der Rechenaufwand wäre wohl nicht unerheblich - und dann drängt sich die Frage auf, ob man nicht gleich ordentliches 2k speichert, statt 2k aufwändig aus eingedampftem 4k zu errechnen.

das ist ungefähr so eine frage wie: "warum nicht gleich RAW verwenden?", wäre es doch für alle beteiligten die einfachste und billigste lösung.

die GH4 liefert leider im HD modus ein verdammt unbefriedigendes bild -- auch unabhängig von all diesem eher nebensächlichen farbunterabtastungsluxus. wäre das anders, bräuchte man sich darüber nicht lange den kopf zu zerbrechen. so ist es halt ein gangbarer pragmatischer kompromiss, um doch noch ein maximum an qualität herauszuholen. mir ist es in der hier beschrieben methode allerdings in der praxis auch viel zu umständlich und langsam. ein ganz normales runterskalieren wirkt auch völlig ausreichend.

Antwort von WoWu:

@ mash_gh4

ja -- frag ich mich auch immer wieder -- außer dir haben's die meisten eh verstanden! ;)

Tja, gegen Ignoranz ist natürlich kein Kraut gewachsen, aber solange Du mir nicht nachweisen kannst, wie Du die Fehler einer Unterabtastung beseitigst, stimmt leider das Resultat meiner Theorie, und die derer, die Unterabtastung verstanden haben und sich nicht nur auf irgendwelche Blogs beziehen, in denen irgendwelche Chinesen sagen, es gibt keine Folgen von Unterabtastung.

Aber Du relativierst ja schon wieder und sagst, Dir reicht die Qualität aus.

Dagegen ist ja nichts einzuwenden.

Wie ich immer sage ... es ist alles eine Frage des Anspruchs.

Nur die Behauptung aus 4:2:0 könne man mit einer zweiten Unterabtastung die Fehler der ersten Beseitigen und ein 4:4:4 Bild daraus machen, ist einfach nur falsch und zeigt, dass man Unterabtastung noch gar nicht verstanden hat. (Und vor allem auch die Auswirkung auf das Bild noch gar nicht versteht, also nicht wirklich weiss, was sie im Bild bewirkt).

Wie nennt man das ?

Alles klar.

Antwort von TheBubble:

Überträgt man nun das Chroma Raster in eine, mit Luma identische Abtastfrquent, bleibt zwar die Menge der Samples Chroma erhalten und die Menge der Luma Samples wird reduziert, aber der Abtastfehler aus der ersten Unterabtastung bleibt auch erhalten !

Die gelbe Linie verschwindet nicht.

Etwas anderes wurde, zumindest von mir, nie behauptet.

Man hat also qualitativ eine 4:2:0 Bildqualität, egal in wievielten Übertragungswerten die steckt.

Nein, echtes 2K 4:2:0 wäre noch schlechter.

Nun zum wichtigsten Punkt: Deine Argumentationskete hat leider bereits ganz am Anfang einen kleines, aber bedeutsames, Problem: In Deinem Ausgangsbeispiel grenzt die rote Fläche sauber an die grüne Fläche, ohne Übergangsbereich (Mischfarbe).

Das ist unrealistisch und zuverlässig allenfalls mit künstlich generiertem Material schaffbar. Echte Aufnahmen ohne Aliasing werden Tiefpassgefiltert und enthalten am Übergang von Vornherein eine Mischfarbe (bei Dir Gelb). Das ist erforderlich, um das Abtasttheorem einzuhalten. (Das zumindest einige Kameras das vermutlich nur unzureichend tun und daher zu Aliasing neigen, wäre ein anderes Thema.)

Antwort von WoWu:

Bubble, das ändert nichts daran, dass dann zwischen gelb und rot sowie gelb und grün zwei weitere Fehlfarben entstehen.

Außerdem habe ich genau zu diesem Vergleich die beiden Kamerabilder eingestellt,

Ganz so unmöglich, wie Du sagst, scheint das also nicht zu sein.

Es geht aber darum, dass ein 4:2:0 Bild bereits sichtbare Atrefakte aufweist und die durch eine weitere Unterabtastung nicht wegzubekommen sind.

Sodass sich keine Bildverbesserung, wie im Titel behauptet, ergibt.