Frage von Martin:Sorry für die Dummie-Frage - aber die stelle ich mir schon lange, und aufgrund des aktuellen News-Artikels mal hier im Forum.

Mein Kenntnisstand ist, dass der 3-Chipper über "ein Prisma" die Farbtrennung macht. Nun habe ich aber im Physikunterricht gelernt, dass ein Prisma das Licht je nach Wellenlänge unterschiedlich stark beugt - damit wird dann ja die Farbtrennung erzielt. Nur: Die Natur tut uns ja nicht den Gefallen, die drei Grundfarben in jeweils exakt einer Wellenlänge bereitzustellen, sondern es gibt das Regenbogen-Kontinuum zwischen 400 und 800nm. Wenn man jetzt eine Farbe filtern möchte, wird man kaum erreichen, exakt eine Wellenlänge zu filtern, sondern es wird ein Wellenlängenbereich gefiltert. Dieser Bereich wird aber in dem Prisma unterschiedlich stark gebeugt.

So, die Frage ist jetzt: Wie wird das Bild trotzdem scharf, obwohl auf den Sensor eine - unterschiedlich stark gebeugte - Mischung aus Wellenlängen trifft? Ist das Prisma im 3-Chipper gar nicht ein Prisma, sondern eine aufwändige Konstruktion, die nach der Farbtrennung die unterschiedliche Beugung wieder genau rückgängig macht?

Gruß

MG

Antwort von tv-man_sh:

Vielleicht findet sich Deine Antwort hier:

http://de.wikipedia.org/wiki/Videokamera

Antwort von Martin:

Vielleicht findet sich Deine Antwort hier:

http://de.wikipedia.org/wiki/Videokamera

Naja, nicht so ganz. Da ist von Spiegeln die Rede - das verstehe ich, da die einfallende Energie einfach gedrittelt wird. Aber wo ist da dann der Vorteil gegemüber dem Einchipper?

Vorteil der 3-Chip-Lösung sollte doch sein, dass z.B. der Sensor für Rot eben alles Licht der "roten" Wellenlänge abbekommt, und nicht nur ein Drittel.

Im Moment gehe ich also mal einfach davon aus, dass eine 3-Chip-Lösung mit Prisma die Farben auftrennt und 3 weitere Prismen die divergierenden Farbanteile wieder vereint.

Gruß

MG

Antwort von digitalCat:

man nutzt -ähnlich wie beim Prismensucher einer Spiegelreflexcamera- jeweils die (teilweise) refektierend gemachte Rückseite einer planen Fläche, ansonsten gehen alle Wellenlängen ungebeugt gradlinig durch (meine Erklärung)

Gruss, Hans-Dieter

Antwort von TheBubble:

Vorteil der 3-Chip-Lösung sollte doch sein, dass z.B. der Sensor für Rot eben alles Licht der "roten" Wellenlänge abbekommt, und nicht nur ein Drittel.

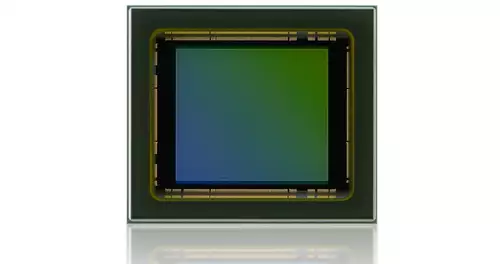

Durch den Dichroitischen Spiegel fällt z.B. der Anteil roten Lichts auf den Sensor für rotes Licht. Hier können die einzelnen Elemente nun größer ausgelegt sein und über ihre größere Fläche mehr Licht auffangen. Die anderen Wellenlängen passieren den Spiegel und gelangen zu den für sie vorgesehenden CCD Chips.

Bei 1-CCD-Kameras wird nicht mit Spiegeln, die die Wellenlängen des Lichts aufteilen, sondern mit Filtern gearbeitet. Hier sind einerseits die einzelnen lichtempfindlichen Elemente oft kleiner, andererseit verwerfen die Filter bis auf den Bereich der jeweils ausgewählten (zu erfassenden) Farbe alle anderen im einfallenden Licht enthaltenen Wellenlängen. Die gefilterten Anteile können hierbei keinem anderen lichtempfindlichen Element zugeführt werden.

Antwort von Blackeagle123:

Hey,

also wenn du dir einen einzelnen Pixel vorstellst und diesem eine Farbe gibst, dann ist das zunächst nur ein Punkt! Wenn jetzt mehrere Pixel nebeneinander jeweils Farben zugeordnet bekommen, wir daraus vielleicht ein Bild.

Aber meine Frage: Warum sollte die Kamera das Bild nicht scharfstellen können, wenn so nur "ein Pixel" nach dem anderen (und nicht ein ganzes Bild) zugeordnet wird? (Ich habe das mit dem Prisma so in Physik noch nicht gelernt und habe Physik Leistungskurs ;-) )

Viele Grüße,

Constantin

Antwort von mdb:

Aber wo ist da dann der Vorteil gegemüber dem Einchipper?Der Vorteil ist die höhere Auflösung. Für jede Grundfarbe ist die volle Chipauflösung verfügbar, beim Einchipper steht für jede Farbe nur 1/3 der Auflösung zur Verfügung.

Antwort von Martin:

Hey,

also wenn du dir einen einzelnen Pixel vorstellst und diesem eine Farbe gibst, dann ist das zunächst nur ein Punkt! Wenn jetzt mehrere Pixel nebeneinander jeweils Farben zugeordnet bekommen, wir daraus vielleicht ein Bild.

Aber meine Frage: Warum sollte die Kamera das Bild nicht scharfstellen können, wenn so nur "ein Pixel" nach dem anderen (und nicht ein ganzes Bild) zugeordnet wird? (Ich habe das mit dem Prisma so in Physik noch nicht gelernt und habe Physik Leistungskurs ;-) )

Viele Grüße,

Constantin

Anders rum wird ein Schuh draus: Die Sensor-Pixel sind monochrom, reagieren also auf hell/dunkel, nicht auf Farben, Farben werden vorher getrennt.

Jetzt setzen wir mal ein Prisma vor einen Sensor und stellen uns einen weißen Lichtstrahl vor, der normalerweise, ohne Prisma, genau einen Pixel treffen würde. Das Prisma trennt aber den Lichtstrahl in seine Farbkomponenten auf, und es entsteht als Abbild eine Linie, die einen Regenbogenverlauf nimmt. Dem Sensor ist das herzlich egal, er stellt die Linie dar, unabhängig von den Farben.

Gruß

Martin

Antwort von digitalCat:

ich kann nur von der Schemazeichnung im Panasonic Prospekt ausgehen, und da geht das Licht entweder gradlinig durch bzw. wird an der Glasrückseite (analog zum Pentaprisma in den meisten SLRs) seitlich zu den beiden zusätzlichen Sensoren rausgeführt.

Die Farbtrennung fuktioniert keinesfalls durch Zerlegung mittels eines Prismas (in alle Regenbogenfarben), -insofern ist die Bezeichnung irreführend- sondern vermutlich durch Filterung der 3 einzeln den Sensoren zugeführten gleichberechtigten Strahlengänge.

Gruss, Hans-Dieter

Antwort von Markus:

Man darf nicht von einem "simplen Prisma" ausgehen, wie es im Physikunterricht vorgeführt wird. Die in 3CCD-Camcorder verbauten Prismen haben Grenzflächen mit sehr speziellen Eigenschaften, die auf bestimmte Wellenlängen durchlässig oder totalreflektierend wirken. Auf diese Weise wird eine Trennung erzielt.