iasi hat geschrieben: ↑Fr 01 Apr, 2022 21:38

Fincher wird sicherlich bei der Komprimierungsrate kompromisslos sein und die geringsten Qualitätsverluste anstreben.

In der Tat nicht.

Mindhunter war 8:1 bei 6.5K Extraction aus dem 8K.

https://thefincheranalyst.com/2019/09/1 ... eason-two/

(Optimum wäre 5:1)

Es ist teilweise tatsächlich schwer die tatsächlichen Kompressionsraten aus Interviews rauszubekommen, aber bei Mank war es auch 6.5K aus aus 8K.

Fraser hat für Dune die Digital-Footage nach kurzem Grade noch Ausbelichten lassen, vom Film neu gescannt und dann erst in die Color gestartet:

https://postperspective.com/cinematogra ... m-process/

Letzteres ist auch eine technische Herangehensweise an Ästhetik, aber nicht aus dem Willen einer technischen Optimierung heraus. In der Praxis bedeutet das auf dem Level einfach fast immer das Gegenteil von dem, was Du machen würdest. Da geht's nicht um Bayer-Auflösung, sondern im Endeffekt um weniger nutzbare Auflösung in fast jedem Punkt der Pipeline, der kontrollierbar ist. Klar, keiner will Verlust durch schlechte Codecs, aber die Kompression wird auch so gewählt, dass das der Nutzen erfüllt ist (UND NICHT DARÜBER HINAUS!). Keiner will Verschlechterung durch verlustbehaftete Intermediate-Codecs (im Gegenteil: 32-Bit Blowup für VFX quasi Standard), aber da wo es kontrollierbar ist (Optiken, Filter(!), Digital-Film-Transfer) eher Auflösungsreduktion.

Deakins ist da tatsächlich oft eine Ausnahme, der ist auch gefühlt der einzige der ohne Filtration dreht, was aber auch daran liegen mag, dass er bisher immer Arri und "nur" 3.4K (Ausnahme 1917) gefahren ist und kein 6-8K. Die Sorge vor Upscaling kommt vermutlich aus einer Zeit, wo das tatsächlich ein No-Go gewesen wäre. Heute sind Algorithmen wirklich gut, werden immer besser und schneller, nicht umsonst würde Arri die Möglichkeit überhaupt anbieten, das ist so ziemlich die konservativste Firma im Kamerabereich (was nicht negativ gemeint ist, nur eine Haltung beschreibt, die umgekehrt extreme Verlässlichteit und Sicherheit zur Folge hat).

iasi hat geschrieben: ↑Fr 01 Apr, 2022 21:38

Bei der Red Raptor hat man diese Wahl:

REDCODE HQ, MQ and LQ at 8K 17:9 (8192 x 4320) up to 60 fps

Wofür würdest du dich entscheiden?

Aufgrund meiner Tests die Einzige meiner Meinung nach richtige Antwort: Das hängt 100% vom Projekt ab. Als Dienstleister bist Du nicht verpflichtet, die technisch-möglich beste Qualität zu liefern (wenn es für den Kunden Verzögerungen oder Mehrkosten bedeutet, und dieser nichts vom Nutzen (selbst unterbewusst) mitbekommt, sondern die richtige und angemessene Qualität und das muss nicht immer HQ sein. Wenn deine Kunden Pendler sind, wirst Du aus dem Anspruch heraus das bestmöglichste Auto über Hubraum/Leistung zu definieren nicht weit kommen. Und tatsächlich hat Red da die Hausaufgaben gemacht, meine Erfahrungen decken sich 1:1 mit der Herstellervorgabe.

("For high complexity scenes, VFX, and stills from motion workflows, RED recommends the HQ setting. For cinema (non-VFX) and high-end TV, RED recommends the MQ setting. For TV, online content, documentary and interviews, RED recommends the LQ setting.")

Ich kann in der Nutzung keinerlei Unterschiede in der Farbflexibilität gegenüber den einzelnen Stufen feststellen, das wäre tatsächlich ein KO-Kriterium. Es verbiegt aber auch niemand Sonnenlbumengelbe Pullis im Kostüm zu Navy-Blau im Grading weil man lustig ist, sowas passiert einfach am Set und dafür hat in der Post auch niemand Zeit, dafür gibt's das in camera Mantra. Und das ist auch auf keinem Level das Ziel.

Das bedeutet im Normalfall:

LQ für reinen Web-Content, der durch stärkere Kompression muss und oder extreme Drehrations oder Laufzeiten (Doku). Da ist tatsächlich als einziges ein visueller Verlust an feinsten Details (Zeichnung von Blättern auf Bäumen hinten in Totalen, Texturen, etc. zwischen LQ vs. MQ/HQ) vor Komprimierung sichtbar. Allerdings sind das Nuancen. Aber immerhin Nuancen.

MQ ist für alles gut genug was an den ORF geht und neben 20:15-Spielfilm (als Werbung) läuft bzw. im Kino vor den eigentlichen Filmen.

HQ für alles mit Keying (allerdings dann auch oft Einstellungs-Spezifisch als Ausnahme), für normales Compositing / Retusche etc.

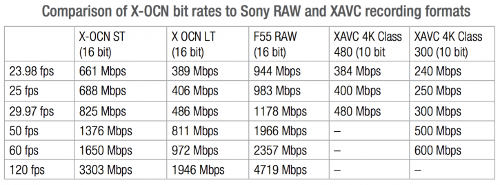

Wo man im Unterschied zum bisherigen Wavelet tatsächlich einen Unterschied merkt ist wie LQ bei Unterbelichtung eher wegbricht, das deckt sich auch mit meinen Erfahrungen zu X-OCN, bei Belichtung an der Grenze zeigen sich schon Vorteile von LQ vs ST/XT. Blöd, weil alles was dokumentarischer (ich sag nicht Doku) gedreht wird, gleichzeitig von höheren Stufen profitieren kann, aber das hilft nichts.

iasi hat geschrieben: ↑Fr 01 Apr, 2022 20:57

Das hat nichts mit "allwissend" zu tun, sondern mit "belegbar".

Zu einer Argumentation gehört dies eben dazu, denn nur behaupten genügt eben nicht.

Aber dann bring doch einmal ein paar Beispiele, sagen wir von den besten der Branche wie ich es versucht habe, wo deine Argumentation untermauert wird. Wo sind die ASC-DPs die hinsichtlich Bayer-Auflösung testen, optikseitig alles auf höchste Auflösung optimieren - sich vielleicht sogar durch algorithmusseitiges Upscaling überlegt haben mehr Details rauszukitzeln.

Mich würde das wirklich interessieren, denn bis jetzt ist alles was Du machst "eben" behaupten, alle würden das technisch-bestmögliche automatisch verwenden und ich habe schon mittlerweile genügend Beispiele gebracht, wo das von branchenweit anerkannten DPs, Academy-Award-Preisträgern anders gemacht wird.

Es wäre mal an der Zeit, statt deine Argumentationen mit "eben" zu versehen, auch mal Beispiele oder Quellen zu nennen.

iasi hat geschrieben: ↑Fr 01 Apr, 2022 21:38

Was will man eigentlich mehr?

pillepalle hat geschrieben: ↑Fr 18 Mär, 2022 14:11

Es geht ja nicht um ein Wort, sondern einfach darum um was für eine Art Daten es sich dabei handelt. Warum wird das im Filmbereich so selten klar kommuniziert?

Scheinbar eh nur klarere Kommunikation gegenüber den Benutzern. Ich glaube darüberhinaus mehr zu wollen wäre vermessen, es gab nie eine größere Zahl an quasi perfekten Kameras als zum heutigen Zeitpunkt.