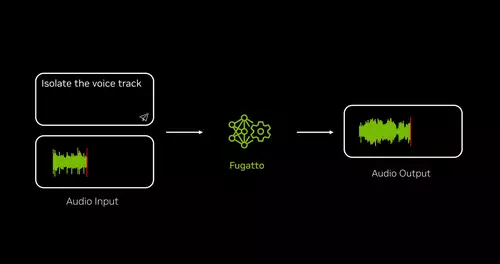

Nvidia hat im Bereich generativer Audio-KI eine Art Schweizer Taschenmesser entwickelt. Es nennt sich "Fugatto" (Foundational Generative Audio Transformer Opus 1) und generiert oder transformiert beliebige Mischungen aus Musik, Stimmen und Geräuschen, die mit Eingabeaufforderungen beschrieben werden, unter Verwendung beliebiger Kombinationen aus Text- und Audiodateien.

So kann es beispielsweise einen Musikausschnitt auf Grundlage einer Textaufforderung erstellen, Instrumente aus einem vorhandenen Lied entfernen oder hinzufügen, den Akzent oder die Emotion einer Stimme ändern – oder auch neuartige Klänge produzieren, die man noch nie zuvor hören konnte.

Im Gegensatz zu stark spezialisierten Modellen beherrscht Fugatto als Foundation-Modell zahlreiche, höchst unterschiedliche Aufgaben zur Audio-Generierung bzw. -Transformation und ist laut Nvidia das erste grundlegende Modell generativer KI, das emergente Eigenschaften aufweist. Das sind Fähigkeiten, die sich aus der Interaktion seiner verschiedenen trainierten Fähigkeiten ergeben. Und damit auch die Fähigkeit, frei formulierte Anweisungen zu kombinieren.

Musikproduzenten könnten Fugatto beispielsweise verwenden, um schnell einen Prototypen einer Songidee zu erstellen oder diese zu bearbeiten und dabei verschiedene Stile, Stimmen und Instrumente auszuprobieren. Sie könnten auch Effekte hinzufügen und die allgemeine Audioqualität eines vorhandenen Titels verbessern.

Eine Werbeagentur könnte Fugatto einsetzen, um eine bestehende Kampagne schnell auf mehrere Regionen oder Situationen auszurichten und den Voiceovers unterschiedliche Akzente und Emotionen zu verleihen.

Sprachlerntools könnten personalisiert werden, um jede vom Sprecher gewünschte Stimme zu verwenden. Videospielentwickler könnten das Modell verwenden, um vorab aufgezeichnete Assets in ihrem Titel zu ändern, damit sie der sich ändernden Handlung während des Spiels der Benutzer entsprechen. Oder sie könnten spontan neue Assets aus Textanweisungen und optionalen Audioeingaben erstellen.

// Top-News auf einen Blick:

- ByteDance Vidi2 produziert selbstständig fertige Videos aus Rohmaterial

- Blackmagic DaVinci Resolve 20.3 bringt Support für 32K-Workflows und mehr

- Bis zu 1.000 Euro sparen: Cashbacks auf Kameras von Sony, Nikon, Canon und Panasonic

- Sony und slashCam verlosen eine FX2 Cinema Line Kamera

- DJI Neo 2: Verbesserte Mini-Drohne für Solo-Creator und Einsteiger

- Blackmagic PYXIS 12K - Sensor-Test - Rolling Shutter und Dynamik

Eine der Fähigkeiten des Modells, auf die die Entwickler besonders stolz sind, ist das, was man im Bereich Generativer Bild-KI einen Avocado-Stuhl nannte. Fugatto kann zum Beispiel eine Trompete bellen oder ein Saxophon miauen lassen. Was auch immer Benutzer beschreiben können, das Modell kann es erstellen.

Durch Feintuning mit wenigen Gesangsdaten soll sogar die Erzeugung einer hochwertigen Singstimme aus einer Textaufforderung möglich sein.

Während der Inferenz verwendet das Modell eine Technik namens ComposableART, um Anweisungen zu kombinieren, die während des Trainings nur einzeln angezeigt wurden. Eine Kombination von Eingabeaufforderungen könnte beispielsweise nach einem Text fragen, der mit einem traurigen Gefühl und französischem Akzent gesprochen wird. Die Fähigkeit des Modells, zwischen Anweisungen zu interpolieren, gibt Benutzern eine fein abgestufte Kontrolle über Textanweisungen, in diesem Fall über die Stärke des Akzents oder den Grad der Trauer.

Das Modell kann auch Klänge oder Soundlandschaften erzeugen, die sich mit der Zeit verändern (zeitliche Interpolation). Und anders als die meisten Modelle, die nur die Trainingsdaten reproduzieren können, denen sie ausgesetzt waren, ermöglicht Fugatto den Benutzern damit sogar die Möglichkeit noch nie dagewesener Klanglandschaften, wie etwa ein Gewitter, das in die Morgendämmerung übergeht, begleitet vom Klang singender Vögel.

Noch gibt es zu Fugatto nur eine Github-Seite mit Demo-Ergebnissen sowie ein Paper, aber keinerlei Information, wie und ob Nvidia einen öffentlichen Zugang zu dem Modell plant. Allerdings wird das Gebiet "generative Audio" ja gerade auch von anderen KI-Größen wie Google entdeckt.